1.本发明涉及语音处理技术领域,尤其涉及一种语音合成方法、装置和用于语音合成的装置。

背景技术:

2.语音合成,又称文语转换(text to speech,tts),是一种可以将任意输入文本转换成相应语音的技术。传统的离线语音合成方法主要包括波形拼接语音合成方法和参数分析语音合成方法。

3.波形拼接语音合成方法,基本原理是根据文本分析的结果,拼接预先录制和标注好的语音库中的单元样本,得到合成语音波形。因为合成语句中的各单元均来自发音人的自然录音,所以波形拼接语音合成方法较好地保持了发音人原始录音的音质。但是该方法会受到语音库大小和单元挑选算法的影响,对硬件存储能力具有较高的要求,无法应用于低端离线设备。

4.针对波形拼接语音合成方法的不足,提出了参数分析语音合成方法。参数分析语音合成方法在训练阶段利用声码器对语料库的语音进行参数化,并对声学特征进行统计建模;在生成阶段,利用训练得到的声学模型从文本分析结果中预测出声学特征,再将声学特征送入声码器重构文本对应的语音波形。该方法相对于波形拼接语音合成方法,具有模型灵活性强、系统尺寸小等优势,可应用于低端离线设备。但是参数分析语音合成方法中的统计建模会带来声学特征参数“过平滑”的问题,以及声码器对音质的损伤,导致合成的语音的韵律和音质较差。

技术实现要素:

5.本发明实施例提供一种语音合成方法、装置和用于语音合成的装置,可以在保证模型效果的基础上,使得训练得到的目标单人声学模型可以适用于计算能力和存储空间有限的离线设备。

6.为了解决上述问题,本发明实施例公开了一种语音合成方法,所述方法包括:

7.基于多人语音训练数据训练多人声学模型,所述多人声学模型包括编码器、韵律预测网络、时长预测网络、以及解码器;所述解码器输出的声学特征中包含基频特征和梅尔谱特征;

8.基于目标说话人的单人语音训练数据对所述多人声学模型进行自适应训练,得到所述目标说话人的单人声学模型;

9.对所述单人声学模型进行参数定点化处理,得到目标单人声学模型;

10.利用所述目标单人声学模型以及待合成文本合成所述目标说话人的声学特征的音频数据。

11.可选地,所述多人语音训练数据包括每个预置说话人的训练数据,所述每个预置说话人的训练数据包括该预置说话人的语音数据和对应文本,以及根据该语音数据和对应

文本提取的声学特征、文本特征、和时长信息;所述基于多人语音训练数据训练多人声学模型,包括:

12.初始化多人声学模型的模型参数;

13.将所述文本特征输入所述多人声学模型的编码器,得到所述文本特征对应的文本编码序列;

14.将所述文本编码序列和所述时长信息输入所述多人声学模型的时长预测网络,预测所述文本编码序列中各字符/音素的时长,输出所述文本编码序列对应的时长序列;

15.将所述文本编码序列输入所述多人声学模型的韵律预测网络,预测所述文本编码序列中各字符/音素的韵律特征,输出所述文本编码序列对应的韵律特征序列;

16.将所述时长序列和所述韵律特征序列输入所述多人声学模型的解码器,输出所述文本编码序列对应的声学特征;

17.根据预测的声学特征和提取的声学特征之间的差异迭代更新所述多人声学模型的模型参数。

18.可选地,所述根据预测的声学特征和提取的声学特征之间的差异迭代更新所述多人声学模型的模型参数,包括:

19.将预测的声学特征和提取的声学特征输入生成对抗网络的判别器;

20.根据所述判别器输出的判别结果,计算所述多人声学模型的模型误差;

21.通过所述模型误差迭代更新所述多人声学模型的参数和所述判别器的参数。

22.可选地,所述根据预测的声学特征和提取的声学特征之间的差异迭代更新所述多人声学模型的模型参数,包括:

23.根据预测的声学特征和提取的声学特征之间的差异迭代更新所述编码器、和/或韵律预测网络、和/或时长预测网络、和/或解码器的参数。

24.可选地,所述输出所述文本编码序列对应的声学特征,包括:

25.所述解码器基于门控循环单元或者因果卷积输出帧级别的声学特征。

26.可选地,所述利用所述目标单人声学模型以及待合成文本合成所述目标说话人的声学特征的音频数据,包括:

27.将待合成文本输入所述目标单人声学模型,通过所述目标单人声学模型输出所述目标说话人的声学特征;

28.将所述目标说话人的声学特征输入预先训练的声码器,生成音频数据。

29.可选地,所述多人声学模型和所述单人声学模型包括压缩的神经网络参数。

30.另一方面,本发明实施例公开了一种语音合成装置,所述装置包括:

31.第一训练模块,用于基于多人语音训练数据训练多人声学模型,所述多人声学模型包括编码器、韵律预测网络、时长预测网络、以及解码器;所述解码器输出的声学特征中包含基频特征和梅尔谱特征;

32.第二训练模块,用于基于目标说话人的单人语音训练数据对所述多人声学模型进行自适应训练,得到所述目标说话人的单人声学模型;

33.定点处理模块,用于对所述单人声学模型进行参数定点化处理,得到目标单人声学模型;

34.语音合成模块,用于利用所述目标单人声学模型以及待合成文本合成所述目标说

话人的声学特征的音频数据。

35.可选地,所述多人语音训练数据包括每个预置说话人的训练数据,所述每个预置说话人的训练数据包括该预置说话人的语音数据和对应文本,以及根据该语音数据和对应文本提取的声学特征、文本特征、和时长信息;所述第一训练模块,包括:

36.初始化子模块,用于初始化多人声学模型的模型参数;

37.编码子模块,用于将所述文本特征输入所述多人声学模型的编码器,得到所述文本特征对应的文本编码序列;

38.时长预测子模块,用于将所述文本编码序列和所述时长信息输入所述多人声学模型的时长预测网络,预测所述文本编码序列中各字符/音素的时长,输出所述文本编码序列对应的时长序列;

39.韵律预测子模块,用于将所述文本编码序列输入所述多人声学模型的韵律预测网络,预测所述文本编码序列中各字符/音素的韵律特征,输出所述文本编码序列对应的韵律特征序列;

40.声学特征预测子模块,用于将所述时长序列和所述韵律特征序列输入所述多人声学模型的解码器,输出所述文本编码序列对应的声学特征;

41.参数更新子模块,用于根据预测的声学特征和提取的声学特征之间的差异迭代更新所述多人声学模型的模型参数。

42.可选地,所述参数更新子模块,包括:

43.数据输入单元,用于将预测的声学特征和提取的声学特征输入生成对抗网络的判别器;

44.误差计算单元,用于根据所述判别器输出的判别结果,计算所述多人声学模型的模型误差;

45.参数更新单元,用于通过所述模型误差迭代更新所述多人声学模型的参数和所述判别器的参数。

46.可选地,所述参数更新子模块,具体用于根据预测的声学特征和提取的声学特征之间的差异迭代更新所述编码器、和/或韵律预测网络、和/或时长预测网络、和/或解码器的参数。

47.可选地,所述声学特征预测子模块,具体用于通过所述解码器基于门控循环单元或者因果卷积输出帧级别的声学特征。

48.可选地,所述语音合成模块,包括:

49.特征预测子模块,用于将待合成文本输入所述目标单人声学模型,通过所述目标单人声学模型输出所述目标说话人的声学特征;

50.音频转换子模块,用于将所述目标说话人的声学特征输入预先训练的声码器,生成音频数据。

51.再一方面,本发明实施例公开了一种用于语音合成的装置,所述装置包括有存储器,以及一个以上的程序,其中一个以上程序存储于存储器中,且经配置以由一个以上处理器执行所述一个以上程序,所述一个以上程序包含用于进行上述任一所述的语音合成方法的指令。

52.又一方面,本发明实施例公开了一种机器可读介质,其上存储有指令,当由一个或

多个处理器执行时,使得装置执行如前述一个或多个所述的语音合成方法。

53.本发明实施例包括以下优点:

54.本发明实施例基于多人语音训练数据训练多人声学模型,并且基于目标说话人的单人语音训练数据对已训练的多人声学模型进行自适应训练,得到所述目标说话人的单人声学模型。通过目标说话人少量的单人语音数据,即可训练得到目标说话人的单人声学模型,可以提高训练单人声学模型的效率,以及降低单人语音数据的采集成本。此外,本发明实施例中的声学模型(多人声学模型/单人声学模型)包括编码器、韵律预测网络、时长预测网络、以及解码器,将韵律预测网络、时长预测网络、音色预测网络(体现在解码器中)三个模块作为三个独立的模块,进行端到端的联合训练,三个模块独立进行调参有助于提高声学模型各模块的精准度。此外,三个模块通过互相影响使得多人声学模型/单人声学模型的效果达到最佳。再者,本发明实施例在基于目标说话人的单人语音训练数据对所述多人声学模型进行自适应训练,得到所述目标说话人的单人声学模型之后,对所述单人声学模型进行参数定点化处理,得到目标单人声学模型,在不降低模型性能的基础上,可以极大减少模型的时间复杂度和空间复杂度,以及减少模型所需的存储空间,在保证模型效果的基础上,使得最终得到的目标单人声学模型可以适用于计算能力和存储空间有限的离线设备。进一步地,所述解码器输出的声学特征中包含基频特征和梅尔谱特征,通过基频特征的预测可以帮助声码器解决哑音问题,同时在音质上得到提高。

附图说明

55.为了更清楚地说明本发明实施例的技术方案,下面将对本发明实施例的描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动性的前提下,还可以根据这些附图获得其他的附图。

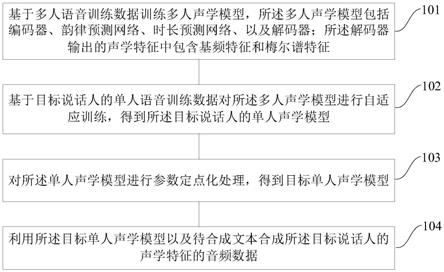

56.图1是本发明的一种语音合成方法实施例的步骤流程图;

57.图2是本发明的一种声学模型的结构示意图;

58.图3是本发明的一种训练多人声学模型的流程示意图;

59.图4是本发明的一种语音合成装置实施例的结构框图;

60.图5是本发明的一种用于语音合成的装置800的框图;

61.图6是本发明的一些实施例中服务器的结构示意图。

具体实施方式

62.下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有作出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

63.方法实施例

64.参照图1,示出了本发明的一种语音合成方法实施例的步骤流程图,所述方法具体可以包括如下步骤:

65.步骤101、基于多人语音训练数据训练多人声学模型,所述多人声学模型包括编码

器、韵律预测网络、时长预测网络、以及解码器;所述解码器输出的声学特征中包含基频特征和梅尔谱特征;

66.步骤102、基于目标说话人的单人语音训练数据对所述多人声学模型进行自适应训练,得到所述目标说话人的单人声学模型;

67.步骤103、对所述单人声学模型进行参数定点化处理,得到目标单人声学模型;

68.步骤104、利用所述目标单人声学模型以及待合成文本合成所述目标说话人的声学特征的音频数据。

69.本发明实施例采用端到端的语音合成方案,通过神经网络学习的方法,实现直接输入文本,然后输出声学特征,进而转换成音频。通过端到端的语音合成方案,使得原来复杂的语言分析部分得到了极大的简化,并且语音合成效果得到进一步的优化,声音更加贴近真人。

70.进一步地,本发明实施例首先基于多人语音训练数据训练多人声学模型,然后基于目标说话人的单人语音训练数据对已训练的多人声学模型进行自适应训练,得到所述目标说话人的单人声学模型。

71.其中,所述多人语音训练数据指多个说话人的训练集数据,多个说话人可以是预先设定的某几个说话人或者某些说话人,比如张三、李四和王五等,每个说话人在这个多人声学模型中有一个对应的说话人标识。例如,多人声学模型是根据包括说话人标识为id1、id2、id3、id4、以及id5的多人语音训练数据训练得到的,则在多人声学模型训练完成之后,输入说话人标识id1以及某个文本,即可通过该多人声学模型输出说话人标识id1对应的声学特征。同理,输入说话人标识id2以及某个文本,即可通过该多人声学模型输出说话人标识id2对应的声学特征,等等。

72.经过大规模的多人语音训练数的训练,得到多人声学模型之后,可以将该多人声学模型作为目标说话人初始的单人声学模型,利用来源于目标说话人的小规模的单人语音训练数据对上述初始的单人声学模型(已训练的多人声学模型)进行进一步的训练。对模型进行进一步训练的目的在于,对已训练的多人声学模型的传递参数进行微调,使得模型的输出参数更贴近于目标说话人的真实语音的声学参数。在进一步的训练中使用的来源于目标说话人的语料数据的数据规模相对较小。由此,通过目标说话人少量的单人语音数据,即可训练得到目标说话人的单人声学模型,可以提高训练单人声学模型的效率,以及降低单人语音数据的采集成本。

73.在本发明的一种可选实施例中,所述多人声学模型和所述单人声学模型可以包括压缩的神经网络参数。为了使得训练完成的单人声学模型可以适用于低端的离线设备,使得离线设备在无网络的环境下,自身可以运行单人声学模型进行语音合成,本发明实施例缩减所述多人声学模型和单人声学模型的神经网络参数,以简化模型结构,减小模型体积。

74.需要说明的是,本发明实施例对压缩神经网络参数的方式不做限制。一个示例中,可以将神经网络参数的参数量由256维缩减至128维。需要说明的是,本发明实施例对压缩神经网络参数的方式不做限制。在具体实施中,可以根据离线设备的计算能力以及语音合成效果确定声学模型的神经网络参数的参数量。

75.进一步地,为了在压缩模型参数的条件下可以保证声学模型预测结果的质量,本发明实施例在训练多人声学模型和训练单人声学模型的过程中,将韵律特征的预测过程和

时长信息的预测过程独立出来,作为声学模型中独立的模块,与声学模型进行端到端的联合训练。

76.在本发明实施例中,所述多人声学模型和所述单人声学模型采用相同的模型结构。参照图2,示出了本发明实施例中的一种声学模型的结构示意图。如图2所示,所述多人声学模型以及所述单人声学模型可以包括编码器201、韵律预测网络202、时长预测网络203、以及解码器204。其中,编码器201用于对输入的文本特征进行编码,得到便于模型处理的文本编码序列。韵律预测网络202用于预测每个字符或音素对应的韵律特征,韵律预测网络202作为一个独立的模块,在训练端到端的声学模型过程中进行联合训练得到。韵律特征属于语言的一种音系结构,与句法和语篇结构、信息结构等其他语言学结构密切相关。韵律特征可以分为三个主要方面:语调、时域分布和重音。时长预测网络203用于预测每个字符或音素对应的时长信息,时长预测网络203作为一个独立的模块,在训练端到端的声学模型过程中进行联合训练得到。解码器204用于基于输入的文本特征以及该文本特征对应的时长序列和韵律特征序列预测符合预置说话人音色的声学特征。进一步地,所述解码器输出的声学特征中包含符合预置说话人音色的基频特征和梅尔谱特征。

77.在本发明实施例中,在不改变解码器结构的基础上,通过解码器多输出一维的基频特征。所述解码器除了可以预测每一帧的梅尔谱特征,还可以预测每一帧的基频特征。基频特征是一种反映声带的大小、厚薄、松紧程度,声门上下之间的气压差的效应以及声调变化的声学特征。通过基频特征的预测可以帮助声码器解决哑音问题,同时在音质上得到提高。

78.本发明实施例构建韵律、时长、以及音色联合建模的声学模型,不仅可以大幅缩小模型尺寸,还可以提升模型的预测效果。

79.在本发明的一种可选实施例中,所述多人语音训练数据包括每个预置说话人的训练数据,所述每个预置说话人的训练数据包括该预置说话人的语音数据和对应文本,以及根据该语音数据和对应文本提取的声学特征、文本特征、和时长信息;所述基于多人语音训练数据训练多人声学模型,可以包括:

80.步骤s11、初始化多人声学模型的模型参数;

81.步骤s12、将所述文本特征输入所述多人声学模型的编码器,得到所述文本特征对应的文本编码序列;

82.步骤s13、将所述文本编码序列和所述时长信息输入所述多人声学模型的时长预测网络,预测所述文本编码序列中各字符/音素的时长,输出所述文本编码序列对应的时长序列;

83.步骤s14、将所述文本编码序列输入所述多人声学模型的韵律预测网络,预测所述文本编码序列中各字符/音素的韵律特征,输出所述文本编码序列对应的韵律特征序列;

84.步骤s15、将所述时长序列和所述韵律特征序列输入所述多人声学模型的解码器,输出所述文本编码序列对应的声学特征;

85.步骤s16、根据预测的声学特征和提取的声学特征之间的差异迭代更新所述多人声学模型的模型参数。

86.在本发明实施例中,所述多人语音训练数据指多说话人的训练集数据。多人语音训练数据中可以包含预先设定的每个预置说话人的训练数据,而每个预置说话人的训练数

据,可以包含该预置说话人的语音数据和对应文本,以及根据该语音数据和对应文本提取出来的声学特征、文本特征、和时长信息。

87.参照图3,示出了本发明实施例的一种训练多人声学模型的流程示意图。

88.本发明实施例训练多人声学模型可以包括两个阶段。第一阶段是数据准备,包括文本预处理、声学特征提取、时长信息提取;第二阶段是利用第一阶段得到的数据(包括文本预处理后得到的文本特征、声学特征提取得到的声学特征、以及时长信息提取得到的时长信息)训练多人声学模型。

89.为了保证模型的学习准确性,文本特征和声学特征的提取可以通过一系列的手段来实现,具体实现时也采用多种方式,例如人工标注的方式,或者计算机辅助人工标注的方式。本发明实施例对此不做限定。

90.在本发明实施例中,文本预处理可以包括对预置说话人的语音数据对应的文本滤除无用字符、格式标准化处理等,从而可以得到后续便于声学模型处理的文本输入序列(此处可以为字符序列)。然后对文本输入序列进行向量转换,得到文本特征,进而可以将该文本特征输入编码器。需要说明的是,文本输入序列的表示形式除了上述描述的字符序列外,还可以为音素(phone)序列的形式,音素是根据语音的自然属性划分出来的最小语音单位,声学模型对音素序列的处理和对字符序列的处理过程是一样的。

91.本发明实施例可以基于字符或音素进行建模,将文本输入序列进行向量转换,得到便于模型处理的文本特征序列。具体地,可以将文本输入序列中各个字符或音素转换成对应的固定维度的向量,输入的每个字符或音素均完成向量转换后即可得到文本特征的表示序列,进而可以输入编码器进行处理。

92.此外,对预置说话人的语音数据和对应文本进行自动切分,可以得到语音数据和对应文本的时长信息。

93.具体地,首先,初始化多人声学模型的模型参数。所述多人声学模型的模型参数可以为压缩后的模型参数。然后,将所述文本特征输入所述多人声学模型的编码器,得到所述文本特征对应的文本编码序列。本发明实施例对所述编码器的网络结构不做限制。一个示例中,所述编码器可以包括n个编码层,n大于或等于1。接下来,将所述文本编码序列和所述时长信息输入所述多人声学模型的时长预测网络,预测所述文本编码序列中各字符/各音素的时长,输出所述文本编码序列对应的时长序列。所述时长预测网络作为一个独立的模块,与声学模型进行端到端的联合训练,在训练过程中,时长预测网络用于预测每个字符/音素对应的时长信息,进而得到当前输入的文本编码序列对应的时长序列。同时,将所述文本编码序列输入所述多人声学模型的韵律预测网络,预测所述文本编码序列中各字符的韵律特征,输出所述文本编码序列对应的韵律特征序列。所述韵律预测网络作为一个独立的模块,与声学模型进行端到端的联合训练,在训练过程中,韵律预测网络用于预测每个字符/音素对应的韵律特征,进而得到当前输入的文本编码序列对应的韵律特征序列。最后,将所述时长序列和所述韵律特征序列输入所述多人声学模型的解码器,输出所述文本编码序列对应的声学特征,并根据预测的声学特征和提取的声学特征之间的差异更新所述声学模型的模型参数。重复上述过程,经过若干轮的迭代训练,当计算得到的预测的声学特征和提取的声学特征之间的差异小于预设值时,训练完成,得到训练完成的多人声学模型。

94.在本发明实施例中,所述声学特征可以为基于语音提取的声学上的特征,例如:线

性谱、mfcc(mel

‑

scalefrequency cepstral coefficients,梅尔倒谱系数)和fbank等。

95.进一步地,所述根据预测的声学特征和提取的声学特征之间的差异迭代更新所述多人声学模型的模型参数,可以包括:根据预测的声学特征和提取的声学特征之间的差异迭代更新所述编码器、和/或韵律预测网络、和/或时长预测网络、和/或解码器的参数。

96.在具体实施中,语音合成的过程中至少包括音色信息、韵律信息、以及时长信息这三个重要信息,其中,音色表示语音中发音人的声音特色;同一个发音人的音色相同,不同发音人的音色不同。韵律表示语音中发音人的发音节奏;时长表示每个音素的发音长度。

97.在本发明实施例中,将韵律预测网络、时长预测网络、音色预测网络(体现在解码器中)三个模块作为三个独立的模块,进行端到端的联合训练,三个模块独立进行调参有助于提高声学模型各模块的精准度。此外,三个模块通过互相影响使得多人声学模型/单人声学模型的效果达到最佳。

98.需要说明的是,训练单人声学模型的流程与图3所示的训练多人声学模型的流程相同,此处不再进行赘述。

99.在本发明的一种可选实施例中,所述根据预测的声学特征和提取的声学特征之间的差异迭代更新所述多人声学模型的模型参数,包括:

100.步骤s21、将预测的声学特征和提取的声学特征输入生成对抗网络的判别器;

101.步骤s22、根据所述判别器输出的判别结果,计算所述多人声学模型的模型误差;

102.步骤s23、通过所述模型误差迭代更新所述多人声学模型的参数和所述判别器的参数。

103.基于大规模的多人语音训练数据训练得到的多人声学模型,往往存在过平滑现象,体现在预测的频谱更趋向于均值,频谱较模糊,导致合成语音听起来比较闷。为解决该问题,本发明实施例在训练端到端的声学模型(多人声学模型/单人声学模型)的过程中,引入生成对抗网络(gan,generative adversarial networks),以增大频谱的方差,使其分布更接近真实频谱,提高合成语音的音质。

104.生成对抗网络包括生成器g和判别器d。在模型训练过程中,d会接收真数据和g产生的假数据,d的任务是判断g产生的数据是属于真数据还是假数据。根据d的判别结果,可以同时对g和d的参数进行调优。如果d判断正确,那就需要调整g的参数从而使得生成的假数据更为逼真;如果d判断错误,则需调节d的参数,避免下次类似判断出错。训练会一直持续到g和d两者进入到一个均衡和谐的状态。

105.在本发明实施例中,将声学模型(多人声学模型/单人声学模型)中的解码器作为所述生成对抗网络的生成器。在所述解码器输出预测的声学特征后,将该预测的声学特征和预先提取的声学特征输入生成对抗网络的判别器。根据判别器输出的判别结果,计算声学模型的模型误差,所述模型误差包括多人声学模型产生的误差和判别器产生的误差。多人声学模型产生的误差可用于表示预测声学特征的准确度;判别器产生的误差可用于表示判别器判别结果的准确度。在每轮训练中,分别使用梯度回传的方法根据多人声学模型产生的误差调整多人声学模型的参数,包括调整编码器、和/或韵律预测网络、和/或时长预测网络、和/或解码器的参数,以及根据判别器产生的误差调整判别器的参数,以监督声学模型生成的声学特征分布更接近真实特征。当模型误差小于预设值时,训练完成,得到训练完成的声学模型(多人声学模型/单人声学模型)。

106.在本发明的一种可选实施例中,所述输出所述文本编码序列对应的声学特征,可以包括:所述解码器基于门控循环单元或者因果卷积输出帧级别的声学特征。

107.在本发明实施例中,编码器、韵律预测网络、以及时长预测网络的处理过程是音素级别的。音素级别的处理速度较快,并且本发明实施例中的声学模型的模型参数是经过压缩的,在保证模型效果的前提下,这三个模块具有处理速度快的特点。声学模型的时间消耗主要在解码器预测声学特征的过程。

108.为了提高语音合成过程的实时性,降低延迟,本发明实施例的解码器采用流式处理方式。具体地,解码器可以基于gru(gated recurrent unit,门控循环单元)或者因果卷积(causal convolutions)输出帧级别的声学特征,以实现低延迟的流式处理方式,提高语音合成的实时性,以满足实时性要求较高的语音合成场景。

109.gru是一种常用的门控循环神经网络,是在lstm(long short

‑

term memory,长短期记忆网络)基础上进行简化而得到的。gru是一种保持了lstm效果、具有更加简单的结构、更少的参数、更好的收敛性的模型,所以整体上gru的训练速度要快于lstm。

110.在处理序列问题时,因为要考虑时间,即时刻t只能考虑t时刻及之前的输入,所以不能使用普通的cnn(convolutional neural networks,卷积神经网络),于是因果卷积随即产生。因果卷积的作用就是用cnn来模拟lstm。

111.需要说明的是,上述解码器基于gru或者因果卷积输出帧级别的声学特征,以实现低延迟的流式处理方式,仅作为一种应用示例,本发明实施例对解码器的流式处理方式不做限制。

112.在基于目标说话人的单人语音训练数据对所述多人声学模型进行自适应训练,得到所述目标说话人的单人声学模型之后,可以对所述单人声学模型进行参数定点化处理,得到目标单人声学模型。

113.其中,参数定点化处理,指将声学模型的参数由浮点类型转换为int8类型。这样,模型由原来的每个浮点数据占4个字节变为每个int8数据占1个字节,可以在不降低模型性能的基础上,极大减少模型的时间复杂度和空间复杂度,以及减少模型所需的存储空间,使得最终得到的目标单人声学模型更加适用于存储空间有限的离线设备。

114.需要说明的是,本发明实施例对训练多人声学模型和单人声学模型的电子设备不做限制。所述电子设备可以是独立的物理服务器,也可以是多个物理服务器构成的服务器集群或者分布式系统,还可以是提供云服务、云数据库、云计算、云函数、云存储、网络服务、云通信、中间件服务、域名服务、安全服务、cdn(content delivery network,内容分发网络)、以及大数据和人工智能平台等基础云计算服务的云服务器。

115.在对目标说话人的单人声学模型进行参数定点化处理,得到目标单人声学模型之后,可以将该目标单人声学模型部署到离线设备使用。

116.所述离线设备可以包括但不限于:耳机、录音笔、家居智能终端(包括:空调、冰箱、电饭煲、热水器等),商务智能终端(包括:可视电话、会议桌面智能终端等),可穿戴设备(包括智能手表、智能眼镜等),金融智能终端机,以及智能手机、平板电脑、个人数字助理(personal digital assistant,pda)、车载设备、计算机等。

117.在本发明的一种可选实施例中,所述利用所述目标单人声学模型以及待合成文本合成所述目标说话人的声学特征的音频数据,可以包括:

118.步骤s31、将待合成文本输入所述目标单人声学模型,通过所述目标单人声学模型输出所述目标说话人的声学特征;

119.步骤s32、将所述目标说话人的声学特征输入预先训练的声码器,生成音频数据。

120.在将目标单人声学模型部署到离线设备之后,可以在离线设备上实现语音合成。将待合成文本输入所述目标单人声学模型,通过所述目标单人声学模型输出所述目标说话人的声学特征;再将所述目标说话人的声学特征输入预先训练的声码器,生成音频数据。

121.其中,待合成文本可以是任意文本。待合成文本可以是获取直接输入的文本信息,也可以是通过摄像头等扫描识别得到文本信息。其中,摄像头扫描识别得到的文本信息可以包括对图像进行扫描以及文本识别处理后得到的文本信息。

122.一个示例中,通过离线设备的摄像头扫描识别得到文本信息之后,可以将该文本信息作为待合成文本输入该离线设备中已部署的目标单人声学模型,通过所述目标单人声学模型输出所述目标说话人的声学特征,并且将该目标说话人的声学特征输入预先训练的声码器,生成音频数据。

123.由此,通过本发明实施例可以实现在低端的离线设备上进行端到端的语音合成。基于输入的任意待合成文本,可以直接输出语音内容为该待合成文本且符合目标说话人的声学特征的音频数据,并且合成的音频数据。

124.综上,本发明实施例基于多人语音训练数据训练多人声学模型,并且基于目标说话人的单人语音训练数据对已训练的多人声学模型进行自适应训练,得到所述目标说话人的单人声学模型。通过目标说话人少量的单人语音数据,即可训练得到目标说话人的单人声学模型,可以提高训练单人声学模型的效率,以及降低单人语音数据的采集成本。此外,本发明实施例中的声学模型(多人声学模型/单人声学模型)包括编码器、韵律预测网络、时长预测网络、以及解码器,将韵律预测网络、时长预测网络、音色预测网络(体现在解码器中)三个模块作为三个独立的模块,进行端到端的联合训练,三个模块独立进行调参有助于提高声学模型各模块的精准度。此外,三个模块通过互相影响使得多人声学模型/单人声学模型的效果达到最佳。再者,本发明实施例在基于目标说话人的单人语音训练数据对所述多人声学模型进行自适应训练,得到所述目标说话人的单人声学模型之后,对所述单人声学模型进行参数定点化处理,得到目标单人声学模型,在不降低模型性能的基础上,可以极大减少模型的时间复杂度和空间复杂度,以及减少模型所需的存储空间,在保证模型效果的基础上,使得最终得到的目标单人声学模型可以适用于计算能力和存储空间有限的离线设备。进一步地,所述解码器输出的声学特征中包含基频特征和梅尔谱特征,通过基频特征的预测可以帮助声码器解决哑音问题,同时在音质上得到提高。

125.需要说明的是,对于方法实施例,为了简单描述,故将其都表述为一系列的动作组合,但是本领域技术人员应该知悉,本发明实施例并不受所描述的动作顺序的限制,因为依据本发明实施例,某些步骤可以采用其他顺序或者同时进行。其次,本领域技术人员也应该知悉,说明书中所描述的实施例均属于优选实施例,所涉及的动作并不一定是本发明实施例所必须的。

126.装置实施例

127.参照图4,示出了本发明的一种语音合成装置实施例的结构框图,所述装置可以包括:

128.第一训练模块401,用于基于多人语音训练数据训练多人声学模型,所述多人声学模型包括编码器、韵律预测网络、时长预测网络、以及解码器;所述解码器输出的声学特征中包含基频特征和梅尔谱特征;

129.第二训练模块402,用于基于目标说话人的单人语音训练数据对所述多人声学模型进行自适应训练,得到所述目标说话人的单人声学模型;

130.定点处理模块403,用于对所述单人声学模型进行参数定点化处理,得到目标单人声学模型;

131.语音合成模块404,用于利用所述目标单人声学模型以及待合成文本合成所述目标说话人的声学特征的音频数据。

132.可选地,所述多人语音训练数据包括每个预置说话人的训练数据,所述每个预置说话人的训练数据包括该预置说话人的语音数据和对应文本,以及根据该语音数据和对应文本提取的声学特征、文本特征、和时长信息;所述第一训练模块,包括:

133.初始化子模块,用于初始化多人声学模型的模型参数;

134.编码子模块,用于将所述文本特征输入所述多人声学模型的编码器,得到所述文本特征对应的文本编码序列;

135.时长预测子模块,用于将所述文本编码序列和所述时长信息输入所述多人声学模型的时长预测网络,预测所述文本编码序列中各字符/音素的时长,输出所述文本编码序列对应的时长序列;

136.韵律预测子模块,用于将所述文本编码序列输入所述多人声学模型的韵律预测网络,预测所述文本编码序列中各字符/音素的韵律特征,输出所述文本编码序列对应的韵律特征序列;

137.声学特征预测子模块,用于将所述时长序列和所述韵律特征序列输入所述多人声学模型的解码器,输出所述文本编码序列对应的声学特征;

138.参数更新子模块,用于根据预测的声学特征和提取的声学特征之间的差异迭代更新所述多人声学模型的模型参数。

139.可选地,所述参数更新子模块,包括:

140.数据输入单元,用于将预测的声学特征和提取的声学特征输入生成对抗网络的判别器;

141.误差计算单元,用于根据所述判别器输出的判别结果,计算所述多人声学模型的模型误差;

142.参数更新单元,用于通过所述模型误差迭代更新所述多人声学模型的参数和所述判别器的参数。

143.可选地,所述参数更新子模块,具体用于根据预测的声学特征和提取的声学特征之间的差异迭代更新所述编码器、和/或韵律预测网络、和/或时长预测网络、和/或解码器的参数。

144.可选地,所述声学特征预测子模块,具体用于通过所述解码器基于门控循环单元或者因果卷积输出帧级别的声学特征。

145.可选地,所述语音合成模块,包括:

146.特征预测子模块,用于将待合成文本输入所述目标单人声学模型,通过所述目标

单人声学模型输出所述目标说话人的声学特征;

147.音频转换子模块,用于将所述目标说话人的声学特征输入预先训练的声码器,生成音频数据。

148.可选地,所述多人声学模型和所述单人声学模型包括压缩的神经网络参数。

149.本发明实施例基于多人语音训练数据训练多人声学模型,并且基于目标说话人的单人语音训练数据对已训练的多人声学模型进行自适应训练,得到所述目标说话人的单人声学模型。通过目标说话人少量的单人语音数据,即可训练得到目标说话人的单人声学模型,可以提高训练单人声学模型的效率,以及降低单人语音数据的采集成本。此外,本发明实施例中的声学模型(多人声学模型/单人声学模型)包括编码器、韵律预测网络、时长预测网络、以及解码器,将韵律预测网络、时长预测网络、音色预测网络(体现在解码器中)三个模块作为三个独立的模块,进行端到端的联合训练,三个模块独立进行调参有助于提高声学模型各模块的精准度。此外,三个模块通过互相影响使得多人声学模型/单人声学模型的效果达到最佳。再者,本发明实施例在基于目标说话人的单人语音训练数据对所述多人声学模型进行自适应训练,得到所述目标说话人的单人声学模型之后,对所述单人声学模型进行参数定点化处理,得到目标单人声学模型,在不降低模型性能的基础上,可以极大减少模型的时间复杂度和空间复杂度,以及减少模型所需的存储空间,在保证模型效果的基础上,使得最终得到的目标单人声学模型可以适用于计算能力和存储空间有限的离线设备。进一步地,所述解码器输出的声学特征中包含基频特征和梅尔谱特征,通过基频特征的预测可以帮助声码器解决哑音问题,同时在音质上得到提高。

150.对于装置实施例而言,由于其与方法实施例基本相似,所以描述的比较简单,相关之处参见方法实施例的部分说明即可。

151.本说明书中的各个实施例均采用递进的方式描述,每个实施例重点说明的都是与其他实施例的不同之处,各个实施例之间相同相似的部分互相参见即可。

152.关于上述实施例中的装置,其中各个模块执行操作的具体方式已经在有关该方法的实施例中进行了详细描述,此处将不做详细阐述说明。

153.本发明实施例提供了一种用于语音合成的装置,所述装置包括有存储器,以及一个以上的程序,其中一个以上程序存储于存储器中,且经配置以由一个以上处理器执行所述一个以上程序包含用于进行以下操作的指令:基于多人语音训练数据训练多人声学模型,所述多人声学模型包括编码器、韵律预测网络、时长预测网络、以及解码器;所述解码器输出的声学特征中包含基频特征和梅尔谱特征;基于目标说话人的单人语音训练数据对所述多人声学模型进行自适应训练,得到所述目标说话人的单人声学模型;对所述单人声学模型进行参数定点化处理,得到目标单人声学模型;利用所述目标单人声学模型以及待合成文本合成所述目标说话人的声学特征的音频数据。

154.可选地,所述多人语音训练数据包括每个预置说话人的训练数据,所述每个预置说话人的训练数据包括该预置说话人的语音数据和对应文本,以及根据该语音数据和对应文本提取的声学特征、文本特征、和时长信息;所述基于多人语音训练数据训练多人声学模型,包括:

155.初始化多人声学模型的模型参数;

156.将所述文本特征输入所述多人声学模型的编码器,得到所述文本特征对应的文本

编码序列;

157.将所述文本编码序列和所述时长信息输入所述多人声学模型的时长预测网络,预测所述文本编码序列中各字符/音素的时长,输出所述文本编码序列对应的时长序列;

158.将所述文本编码序列输入所述多人声学模型的韵律预测网络,预测所述文本编码序列中各字符/音素的韵律特征,输出所述文本编码序列对应的韵律特征序列;

159.将所述时长序列和所述韵律特征序列输入所述多人声学模型的解码器,输出所述文本编码序列对应的声学特征;

160.根据预测的声学特征和提取的声学特征之间的差异迭代更新所述多人声学模型的模型参数。

161.可选地,所述根据预测的声学特征和提取的声学特征之间的差异迭代更新所述多人声学模型的模型参数,包括:

162.将预测的声学特征和提取的声学特征输入生成对抗网络的判别器;

163.根据所述判别器输出的判别结果,计算所述多人声学模型的模型误差;

164.通过所述模型误差迭代更新所述多人声学模型的参数和所述判别器的参数。

165.可选地,所述根据预测的声学特征和提取的声学特征之间的差异迭代更新所述多人声学模型的模型参数,包括:

166.根据预测的声学特征和提取的声学特征之间的差异迭代更新所述编码器、和/或韵律预测网络、和/或时长预测网络、和/或解码器的参数。

167.可选地,所述输出所述文本编码序列对应的声学特征,包括:

168.所述解码器基于门控循环单元或者因果卷积输出帧级别的声学特征。

169.可选地,所述利用所述目标单人声学模型以及待合成文本合成所述目标说话人的声学特征的音频数据,包括:

170.将待合成文本输入所述目标单人声学模型,通过所述目标单人声学模型输出所述目标说话人的声学特征;

171.将所述目标说话人的声学特征输入预先训练的声码器,生成音频数据。

172.可选地,所述多人声学模型和所述单人声学模型包括压缩的神经网络参数。

173.图5是根据一示例性实施例示出的一种用于语音合成的装置800的框图。例如,装置800可以是移动电话,计算机,数字广播终端,消息收发设备,游戏控制台,平板设备,医疗设备,健身设备,个人数字助理等。

174.参照图5,装置800可以包括以下一个或多个组件:处理组件802,存储器804,电源组件806,多媒体组件808,音频组件810,输入/输出(i/o)的接口812,传感器组件814,以及通信组件816。

175.处理组件802通常控制装置800的整体操作,诸如与显示,电话呼叫,数据通信,相机操作和记录操作相关联的操作。处理元件802可以包括一个或多个处理器820来执行指令,以完成上述的方法的全部或部分步骤。此外,处理组件802可以包括一个或多个模块,便于处理组件802和其他组件之间的交互。例如,处理组件802可以包括多媒体模块,以方便多媒体组件808和处理组件802之间的交互。

176.存储器804被配置为存储各种类型的数据以支持在设备800的操作。这些数据的示例包括用于在装置800上操作的任何应用程序或方法的指令,联系人数据,电话簿数据,消

息,图片,视频等。存储器804可以由任何类型的易失性或非易失性存储设备或者它们的组合实现,如静态随机存取存储器(sram),电可擦除可编程只读存储器(eeprom),可擦除可编程只读存储器(eprom),可编程只读存储器(prom),只读存储器(rom),磁存储器,快闪存储器,磁盘或光盘。

177.电源组件806为装置800的各种组件提供电力。电源组件806可以包括电源管理系统,一个或多个电源,及其他与为装置800生成、管理和分配电力相关联的组件。

178.多媒体组件808包括在所述装置800和用户之间的提供一个输出接口的屏幕。在一些实施例中,屏幕可以包括液晶显示器(lcd)和触摸面板(tp)。如果屏幕包括触摸面板,屏幕可以被实现为触摸屏,以接收来自用户的输入信号。触摸面板包括一个或多个触摸传感器以感测触摸、滑动和触摸面板上的手势。所述触摸传感器可以不仅感测触摸或滑动动作的边界,而且还检测与所述触摸或滑动操作相关的持续时间和压力。在一些实施例中,多媒体组件808包括一个前置摄像头和/或后置摄像头。当设备800处于操作模式,如拍摄模式或视频模式时,前置摄像头和/或后置摄像头可以接收外部的多媒体数据。每个前置摄像头和后置摄像头可以是一个固定的光学透镜系统或具有焦距和光学变焦能力。

179.音频组件810被配置为输出和/或输入音频信号。例如,音频组件810包括一个麦克风(mic),当装置800处于操作模式,如呼叫模式、记录模式和语音信息处理模式时,麦克风被配置为接收外部音频信号。所接收的音频信号可以被进一步存储在存储器804或经由通信组件816发送。在一些实施例中,音频组件810还包括一个扬声器,用于输出音频信号。

180.i/o接口812为处理组件802和外围接口模块之间提供接口,上述外围接口模块可以是键盘,点击轮,按钮等。这些按钮可包括但不限于:主页按钮、音量按钮、启动按钮和锁定按钮。

181.传感器组件814包括一个或多个传感器,用于为装置800提供各个方面的状态评估。例如,传感器组件814可以检测到设备800的打开/关闭状态,组件的相对定位,例如所述组件为装置800的显示器和小键盘,传感器组件814还可以语音合成装置800或装置800一个组件的位置改变,用户与装置800接触的存在或不存在,装置800方位或加速/减速和装置800的温度变化。传感器组件814可以包括接近传感器,被配置用来在没有任何的物理接触时检测附近物体的存在。传感器组件814还可以包括光传感器,如cmos或ccd图像传感器,用于在成像应用中使用。在一些实施例中,该传感器组件814还可以包括加速度传感器,陀螺仪传感器,磁传感器,压力传感器或温度传感器。

182.通信组件816被配置为便于装置800和其他设备之间有线或无线方式的通信。装置800可以接入基于通信标准的无线网络,如wifi,2g或3g,或它们的组合。在一个示例性实施例中,通信组件816经由广播信道接收来自外部广播管理系统的广播信号或广播相关信息。在一个示例性实施例中,所述通信组件816还包括近场通信(nfc)模块,以促进短程通信。例如,在nfc模块可基于射频信息处理(rfid)技术,红外数据协会(irda)技术,超宽带(uwb)技术,蓝牙(bt)技术和其他技术来实现。

183.在示例性实施例中,装置800可以被一个或多个应用专用集成电路(asic)、数字信号处理器(dsp)、数字信号处理设备(dspd)、可编程逻辑器件(pld)、现场可编程门阵列(fpga)、控制器、微控制器、微处理器或其他电子元件实现,用于执行上述方法。

184.在示例性实施例中,还提供了一种包括指令的非临时性计算机可读存储介质,例

如包括指令的存储器804,上述指令可由装置800的处理器820执行以完成上述方法。例如,所述非临时性计算机可读存储介质可以是rom、随机存取存储器(ram)、cd

‑

rom、磁带、软盘和光数据存储设备等。

185.图6是本发明的一些实施例中服务器的结构示意图。该服务器1900可因配置或性能不同而产生比较大的差异,可以包括一个或一个以上中央处理器(central processing units,cpu)1922(例如,一个或一个以上处理器)和存储器1932,一个或一个以上存储应用程序1942或数据1944的存储介质1930(例如一个或一个以上海量存储设备)。其中,存储器1932和存储介质1930可以是短暂存储或持久存储。存储在存储介质1930的程序可以包括一个或一个以上模块(图示没标出),每个模块可以包括对服务器中的一系列指令操作。更进一步地,中央处理器1922可以设置为与存储介质1930通信,在服务器1900上执行存储介质1930中的一系列指令操作。

186.服务器1900还可以包括一个或一个以上电源1926,一个或一个以上有线或无线网络接口1950,一个或一个以上输入输出接口1958,一个或一个以上键盘1956,和/或,一个或一个以上操作系统1941,例如windows servertm,mac os xtm,unixtm,linuxtm,freebsdtm等等。

187.一种非临时性计算机可读存储介质,当所述存储介质中的指令由装置(服务器或者终端)的处理器执行时,使得装置能够执行图1所示的语音合成方法。

188.一种非临时性计算机可读存储介质,当所述存储介质中的指令由装置(服务器或者终端)的处理器执行时,使得装置能够执行一种语音合成方法,所述方法包括:基于多人语音训练数据训练多人声学模型,所述多人声学模型包括编码器、韵律预测网络、时长预测网络、以及解码器;所述解码器输出的声学特征中包含基频特征和梅尔谱特征;基于目标说话人的单人语音训练数据对所述多人声学模型进行自适应训练,得到所述目标说话人的单人声学模型;对所述单人声学模型进行参数定点化处理,得到目标单人声学模型;利用所述目标单人声学模型以及待合成文本合成所述目标说话人的声学特征的音频数据。

189.本领域技术人员在考虑说明书及实践这里公开的发明后,将容易想到本发明的其它实施方案。本发明旨在涵盖本发明的任何变型、用途或者适应性变化,这些变型、用途或者适应性变化遵循本发明的一般性原理并包括本公开未公开的本技术领域中的公知常识或惯用技术手段。说明书和实施例仅被视为示例性的,本发明的真正范围和精神由下面的权利要求指出。

190.应当理解的是,本发明并不局限于上面已经描述并在附图中示出的精确结构,并且可以在不脱离其范围进行各种修改和改变。本发明的范围仅由所附的权利要求来限制。

191.以上所述仅为本发明的较佳实施例,并不用以限制本发明,凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

192.以上对本发明所提供的一种语音合成方法、一种语音合成装置和一种用于语音合成的装置,进行了详细介绍,本文中应用了具体个例对本发明的原理及实施方式进行了阐述,以上实施例的说明只是用于帮助理解本发明的方法及其核心思想;同时,对于本领域的一般技术人员,依据本发明的思想,在具体实施方式及应用范围上均会有改变之处,综上所述,本说明书内容不应理解为对本发明的限制。