1.本发明属于语音信号处理技术领域,具体涉及到一种基于多头注意力机制融合的卷积递归神经网络模型。

背景技术:

2.作为人类沟通交流最便捷的手段之一,语音在人机交互领域备受关注,然而,语音中除了内容信息外,还包含了情感信息。为使人机交互系统更加智能,开展针对语音情感识别的研究具备重大的研究意义和实用价值。

3.近些年,为构建高性能的语音情感识别系统,学者们从不同方向进行了大量的研究,例如情感模型构建、语音情感数据库录制、语音情感特征提取、特征选择及处理,语音情感分类识别等等。随着机器学习相关技术的发展,深度学习技术被广泛应用于语音情感识别领域,且取得了优异的成绩。鉴于单个网络特征提取能力有限,许多学者采用混合神经网络模型从语音中提取相关情感信息,然而现有模型多采用全连接层或简单拼接的方法实现不同网络特征的融合,但不同网络的特征空间存在较大的差异,简单的融合无法获取最优特征集,因此,针对该领域的研究仍需进一步探索。

技术实现要素:

4.针对现有语音情感识别模型所存在的问题,本发明公开了一种基于多头注意力机制融合的卷积递归神经网络模型,包括以下步骤:

5.(1)对于每一条语音数据,采用mel谱滤波器对语音进行处理,获得帧级数据frames,将每条语音的所有帧级数据拼接在一起,组成2维mel谱图像mel,计算mel谱图像的一阶、二阶导数,记为δmel,δδmel,利用mel,δmel,δδmel 构建成3维图片;

6.(2)搭建特征提取网络,该网络由一个全卷积网络和一个双向长短时记忆 (bi

‑

directional long short

‑

term memory,bilstm)网络组成,具体实现步骤如下:

7.首先,采用全卷积网络提取语音谱图情感特征,全卷积网络是在alexnet网络基础上搭建的,全卷积网络的输出由3个分支组成,如公式(1)所示:

8.output=(b1+b2+b3)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(1)

9.在alexnet网络第一、第二、第三个池化层后,添加一个分支,每个分支由 1*1的卷积层和全局平均池化层组成,全卷积网络采用步骤(1)中构建的3维图片作为全卷积网络的输入;

10.其次,采用bilstm提取语音的帧级情感特征,步骤(1)中的帧级数据frames 作为bilstm网络的输入;

11.将两个网络提取到的情感特征经批归一化后,两个网络归一化特征f1,f2 作为后面步骤的输入;

12.(3)特征融合:为了提高识别性能,构建了一种基于多头注意力的多特征融合算法,具体操作如下:

13.以多头注意力机制中的某个头算法为例,首先将两个网络输出的特征f1和 f2的维数变为[b,1,n]然后将f1和f2拼接得到特征f,f的维数为[b,2,n], 其中b表示批归一化数量的大小,2代表两个不同的特征空间,n代表特征维数的大小,采用自注意力机制算法计算注意力权重,如公式(2)、(3)所示:

[0014]

α

f

=softmax(tanh(f

×

w

f

)

×

v

f

)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(2)

[0015]

attention(f1,f2)=∑α

f

×

f

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(3)

[0016]

其中,w

f

,v

f

∈r

n

×

n

为可训练的注意力参数,注意力权重与拼接特征f加权求和即可求得输出的值,如公式(3)所示;

[0017]

多头注意力机制融合输出由每个头融合特征相加求得,如公式(4)、(5)、 (6)所示,在相加融合的过程中,每个头的输出层加入dropout,以此来提高多头输出特征的鲁棒性;

[0018]

head

i

=attention

i

(f1,f2)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(4)

[0019]

head

i

′

=dropout(head

i

)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(5)

[0020]

multihead(f1,f2)=add(head1′

,...,head

n

′

)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(6)

[0021]

为避免网络梯度发散,如公式(7)所示,将步骤(2)中不同网络的输出与公式(6)多头注意力机制融合特征通过shortcut connection连接,得到用于情感识别的特征f

fin

;

[0022]

f

fin

=add(f1,f2,multihead(f1,f2))

ꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(7)

[0023]

(4)分类识别输出:将步骤(3)得到的f

fin

特征归一化后送入softmax 层,并采用有标签的数据对整个网络进行训练,得到用于情感识别的网络模型。

附图说明:

[0024]

图1为系统流程图;

[0025]

图2为训练集识别曲线;

[0026]

图3为测试集识别曲线。

具体实施方式:

[0027]

下面结合具体实施方式对本发明做更进一步的说明。

[0028]

针对现有语音情感识别模型所存在的问题,本发明公开了一种基于多头注意力机制融合的卷积递归神经网络模型,包括以下步骤:

[0029]

(1)在语音处理预处理阶段给情感语音添加标签;

[0030]

(2)对于每一条语音数据,采用64通道的mel谱滤波器对语音进行处理,窗函数采用25ms汉明窗,10ms的帧移,最终获得帧级数据frames,将每条语音的所有帧级数据拼接在一起,组成2维mel谱图像mel,计算mel谱图像的一阶、二阶导数,记为δmel,δδmel,利用mel,δmel,δδmel构建成3维图片;

[0031]

(3)搭建特征提取网络,该网络由一个全卷积网络和一个bilstm网络组成,具体实现步骤如下:

[0032]

首先,采用全卷积网络提取语音谱图情感特征,全卷积网络是在alexnet网络基础上搭建的,全卷积网络的输出由3个分支组成,如公式(1)所示:

[0033]

output=(b1+b2+b3)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(1)

[0034]

在alexnet网络第一、第二、第三个池化层后,添加一个分支,每个分支由 1*1的卷积层和全局平均池化层组成,全卷积网络采用步骤(1)中构建的3维图片作为全卷积网络的输入,每个分支的输出b

i

(n=0,1,2)设为2048,删除了 alexnet网络的全连接层,最终通过每个分支的相加求平均获得最终特征,对于全卷积网络的初始化,仍然采用imagenet训练好的alexnet网络参数初始化全卷积网络主体部分,对于三个分支中1*1的卷积,随机生成相关参数;

[0035]

其次,采用bilstm提取语音的帧级情感特征,步骤(1)中的帧级数据frames 作为bilstm网络的输入;

[0036]

将两个网络提取到的情感特征经批归一化后,两个网络归一化特征f1,f2 作为后面步骤的输入;

[0037]

(4)特征融合:为了提高识别性能,构建了一种基于多头注意力的多特征融合算法,具体操作如下:

[0038]

以多头注意力机制中的某个头算法为例,首先将两个网络输出的特征f1和 f2的维数变为[b,1,n]然后将f1和f2拼接得到特征f,f的维数为[b,2,n], 其中b表示批归一化数量的大小,2代表两个不同的特征空间,n代表特征维数的大小,采用自注意力机制算法计算注意力权重,如公式(2)、(3)所示:

[0039]

α

f

=softmax(tanh(f

×

w

f

)

×

v

f

)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(2)

[0040]

attention(f1,f2)=∑α

f

×

f

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(3)

[0041]

其中,w

f

,v

f

∈r

n

×

n

为可训练的注意力参数,注意力权重与拼接特征f加权求和即可求得输出的值,如公式(3)所示;

[0042]

多头注意力机制融合输出由每个头融合特征相加求得,如公式(4)、(5)、 (6)所示,在相加融合的过程中,每个头的输出层加入dropout,以此来提高多头输出特征的鲁棒性;

[0043]

head

i

=attention

i

(f1,f2)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(4)

[0044]

head

i

′

=dropout(head

i

)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(5)

[0045]

multihead(f1,f2)=add(head1′

,...,head

n

′

)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(6)

[0046]

为避免网络梯度发散,如公式(7)所示,将步骤(3)中不同网络的输出与公式(6)多头注意力机制融合特征通过shortcut connection连接,得到用于情感识别的特征f

fin

;

[0047]

f

fin

=add(f1,f2,multihead(f1,f2))

ꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(7)

[0048]

(5)分类识别输出:将步骤(4)得到的f

fin

特征归一化后送入softmax 层,并采用有标签的数据对整个网络进行训练,得到用于情感识别的网络模型。

[0049]

仿真实验及具体参数

[0050]

为验证本发明所公开模型的性能,在casia数据库上进行测试,该库由中科院自动化所录制而成,是一个中文的语音情感库。该库由4名演员(2男,2女) 录制了6中不同的情感,情感类型包括:anger,fear,happy,neutral,sad,surprise。实验策略:随机选取80%的数据作为训练集,选取20%的数据作为测试集。

[0051]

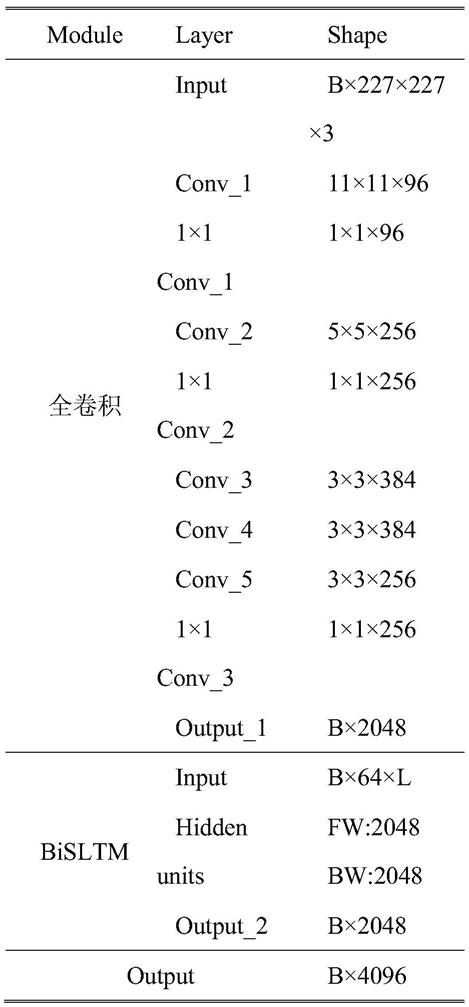

表1给出了本发明所采用的全卷积网络和bilstm网络的具体参数,本发明所采用的网络基于tensorflow框架进行搭建,采用在imagenet训练的alexnet 参数初始化全卷积网络,输出特征为2048维特征;bi

‑

lstm包含1个隐层,输出特征为2048维特征;在多头融合

中,注意力机制头数设为16,dropout参数设置为0.5;通过最小化交叉熵目标函数优化模型参数;实验中使用了adam优化器,初始学习率设置为0.00001。表1中b表示每次迭代的批大小,l表示数据集帧大小,

[0052]

图2、图3分别表示casia库上训练集和测试集的识别结果,可以看出在训练集上,约50轮后,算法就开始收敛,在测试集上最优识别率达到90%。

[0053]

表1具体参数

[0054]