1.本技术涉及音频技术领域,尤其涉及一种语音合成方法及装置。

背景技术:

2.语音合成是将文字转为语音的服务,语音合成技术赋予了机器可以发声的能力,将机器接收到的文字信息转换成为自然流畅的语音信息,反馈并传递给用户。智能时代的到来,使得越来越多的智能设备需要搭载智能语音合成技术,以提高设备的交互性和友好度。

3.然而,对于现有的语音合成模型(包括声学模型和声码器),一方面,语音合成模型的结构复杂,基于该模型进行语音合成需要消耗大量的计算资源,很难在嵌入式设备上实现实时的语音合成,也难以在低计算资源下实现离线的语音合成。另一方面,现有的语音合成模型的处理效果还有待提升。但是该优化方法会使得模型合成的音频质量产生较大损失。

技术实现要素:

4.本技术实施例提供一种语音合成的方法、装置及系统,能够提升语音合成的实时率,并且能够提升所合成的语音的音质。

5.为达到上述目的,本技术实施例采用如下技术方案:

6.第一方面,本技术提供一种语音合成方法,应用于电子设备,该方法包括:电子设备基于第一训练样本集和教师声学模型,对预设学生声学模型进行训练,得到目标学生声学模型,上述第一训练样本集包括多个文本和该多个文本对应的声学特征,上述预设学生声学模型为轻量级的声学模型;并且采用上述目标学生声学模型对目标文本进行特征提取,得到该目标文本的声学特征;以及通过声码器对该目标文本的声学特征进行处理,得到该目标文本对应的语音。其中,教师声学模型、预设学生声学模型以及目标学生声学模型均用于提取文本的声学特征。

7.本技术实施例中,一方面,根据轻量级的预设学生声学模型训练得到的目标学生声学模型也为轻量级的声学模型,由于轻量级的声学模型结构更为简单,运算复杂度较低,因此基于目标学生声学模型可以快速完成语音合成,即通过本技术实施例提供的技术方案能够提升语音合成的实时率;另一方面,根据第一训练样本集和教师声学模型对预设学生声学模型进行训练,能够将教师声学模型的知识迁移至学生声学模型,得到目标学生声学模型,该目标学生声学模型输出的声学特征更加准确,因此,基于该目标学生声学模型进行语音合成得到语音的音质较好,即通过本技术实施例提供的技术方案能够提升所合成的语音的音质。

8.在第一方面的一种实现方式中,上述基于第一训练样本集和教师声学模型,对预设学生声学模型进行训练,得到目标学生声学模型的方法包括:电子设备确定第一训练样本集中的文本经教师声学模型处理的情况下,该教师声学模型的损失;确定第一训练样本

集中的文本经预设学生声学模型处理的情况下,该预设学生声学模型的损失;根据教师声学模型的损失和预设学生声学模型的损失,确定目标损失;基于该目标损失,对预设学生声学模型进行更新,得到目标学生声学模型。

9.在第一方面的一种实现方式中,上述轻量级的声学模型包括对预设声学模型进行下述至少一种处理所得到的声学模型:

10.对上述预设声学模型进行结构裁剪;

11.增加上述预设声学模型所处理的数据帧的帧长;

12.增加上述预设声学模型单次处理的数据帧的数量。

13.在本技术中,对上述预设声学模型进行结构裁剪指的是对预设学生声学模型的解码器中的两层长短期记忆网络(long short

‑

term memory,lstm)中的神经元的数量进行裁剪,对预设声学模型进行结构裁剪得到轻量级的声学模型。

14.在第一方面的一种实现方式中,上述方法还包括:电子设备基于第二训练样本集,对预设教师声学模型进行训练,得到教师声学模型,第二训练样本集包括多个文本和该多个文本对应的声学特征。

15.在第一方面的一种实现方式中,上述方法还包括:电子设备根据第三训练样本集,确定第一训练样本集,上述第三训练样本集包括多个文本和该多个文本对应的语音。

16.在第一方面的一种实现方式中,上述根据第三训练样本集,确定第一训练样本集,包括:

17.从第三训练样本集中的多个文本对应的语音中提取该多个文本对应的声学特征;并且将第三训练样本集中的多个文本和该多个文本对应的声学特征组成的训练样本集作为第一训练样本集。

18.在第一方面的一种实现方式中,上述方法还包括:电子设备基于第四训练样本集,对预设声码器进行训练,得到声码器,第四训练样本集包括多个文本对应的声学特征和该多个文本对应的语音。

19.在第一方面的一种实现方式中,上述预设声码器为经结构裁剪的声码器。

20.第二方面,本技术提供一种语音合成装置,包括:第一训练模块、特征提取模块、语音合成模块。其中,第一训练模块用于基于第一训练样本集和教师声学模型,对预设学生声学模型进行训练,得到目标学生声学模型,该预设学生声学模型为轻量级的声学模型;特征提取模块用于采用目标学生声学模型对目标文本进行特征提取,得到目标文本的声学特征;语音合成模块用于通过声码器对所述目标文本的声学特征进行处理,得到目标文本对应的语音,其中,第一训练样本集包括多个文本和多个文本对应的声学特征,教师声学模型、预设学生声学模型以及目标学生声学模型均用于提取文本的声学特征。

21.在第二方面的一种实现方式中,上述第一训练模块具体用于确定第一训练样本集中的文本经教师声学模型处理的情况下,教师声学模型的损失;并且确定第一训练样本集中的文本经预设学生声学模型处理的情况下,预设学生声学模型的损失;以及根据教师声学模型的损失和预设学生声学模型的损失,确定目标损失;进而基于目标损失,对预设学生声学模型进行更新,得到目标学生声学模型。

22.在第二方面的一种实现方式中,上述轻量级的声学模型包括对预设声学模型进行下述至少一种处理所得到的声学模型:对预设声学模型进行结构裁剪、增加预设声学模型

所处理的数据帧的帧长、增加预设声学模型单次处理的数据帧的数量。

23.在第二方面的一种实现方式中,本技术实施例提供的语音合成装置还包括第二训练模块;该第二训练模块用于基于第二训练样本集,对预设教师声学模型进行训练,得到教师声学模型,第二训练样本集包括多个文本和该多个文本对应的声学特征。

24.在第二方面的一种实现方式中,本技术实施例提供的语音合成装置还包括确定模块,该确定模块用于根据第三训练样本集,确定第一训练样本集,第三训练样本集包括多个文本和该多个文本对应的语音。

25.在第二方面的一种实现方式中,确定模块具体用于从第三训练样本集中的多个文本对应的语音中提取该多个文本对应的声学特征;并且将第三训练样本集中的多个文本和该多个文本对应的声学特征组成的训练样本集作为所述第一训练样本集。

26.在第二方面的一种实现方式中,本技术实施例提供的语音合成装置还包括第三训练模块,该第三训练模块用于基于第四训练样本集,对预设声码器进行训练,得到声码器,第四训练样本集包括多个文本对应的声学特征和该多个文本对应的语音。

27.在第二方面的一种实现方式中,上述预设声码器为经结构裁剪的声码器。

28.第三方面,本技术提供一种电子设备,包括:处理器和与处理器耦合连接的存储器;存储器用于存储计算机指令,当电子设备运行时,处理器执行存储器存储的所述计算机指令,以使得所述电子设备执行上述第一方面及其各实现方式中所述的方法。

29.第四方面,本技术提供一种计算机可读存储介质,该计算机可读存储介质包括计算机程序,当计算机程序在计算机上运行时,以执行上述第一方面及其各实现方式中所述的方法。

30.需要说明的是,上述第二方面至第四方面的技术效果可以参考第一方面及其各种可选的实现方式的技术效果的相关描述,此处不再赘述。

附图说明

31.图1为本技术实施例提供的语音合成的过程的示意图;

32.图2为本技术实施例提供的一种语音合成方法示意图;

33.图3为本技术实施例提供的一种目标学生声学模型的训练过程示意图;

34.图4为本技术实施例提供的一种确定目标学生声学模型的方法示意图;

35.图5为本技术实施例提供的一种对预设教师声学模型进行训练得到教师声学模型的过程示意图;

36.图6为本技术实施例提供的一种确定第一训练样本集的方法示意图;

37.图7为本技术实施例提供的根据第三训练样本集确定第一训练样本集的过程示意图;

38.图8为本技术实施例提供的对预设声码器进行训练得到声码器的过程示意图;

39.图9为本技术实施例提供的一种语音合成装置的结构示意图。

具体实施方式

40.本技术的说明书和权利要求书中的术语“第一”和“第二”等是用于区别不同的对象,而不是用于描述对象的特定顺序。例如,第一训练样本集和第二训练样本集等是用于区

别不同的训练样本集,而不是用于描述训练样本集的特定顺序。

41.在本技术实施例中,“示例性的”或者“例如”等词用于表示作例子、例证或说明。本技术实施例中被描述为“示例性的”或者“例如”的任何实施例或设计方案不应被解释为比其它实施例或设计方案更优选或更具优势。确切而言,使用“示例性的”或者“例如”等词旨在以具体方式呈现相关概念。

42.在本技术的描述中,除非另有说明,“多个”的含义是指两个或两个以上。例如,多个文本是指两个或两个以上的文本。

43.下面首先对本技术实施例涉及的一些概念进行解释说明。

44.语音合成:是将文本转为语音的服务,应理解,可以基于语音合成模型实现文本转语音,语音合成模型包括声学模型和声码器。具体的,参考图1,语音合成的过程包括:用于语音合成的装置基于声学模型提取文本的声学特征,然后再通过声码器将文本的声学特征转换为语音。

45.为了解决现有技术中,由于语音合成模型结构复杂而导致计算资源的消耗量大,以及由于模型本身的缺陷而导致所合成的语音的音质较差的问题,本技术实施例提供了一种语音合成的方法及装置,电子设备基于第一训练样本集和教师声学模型,对预设学生声学模型进行训练,得到目标学生声学模型,该预设学生声学模型为轻量级的声学模型;并且采用目标学生声学模型对目标文本进行特征提取,得到目标文本的声学特征;以及通过声码器对目标文本的声学特征进行处理,得到目标文本对应的语音。通过本技术实施例提供的技术方案,能够提升语音合成的实时率,并且能够提升所合成的语音的音质。

46.本技术实施例提供的语音合成方法可以应用于具有语音合成功能的电子设备,例如智能音箱、智能对话机器人、智能手机、穿戴设备等,并且可以应用在地图语音导航,医院、机场、车站的智能服务等场景中。

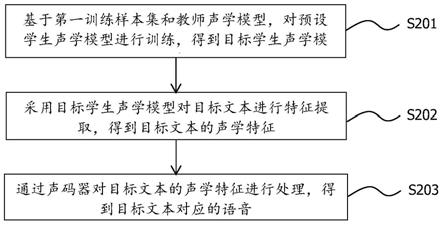

47.如图2所示,本技术实施例提供的语音合成方法,应用于电子设备,该方法包括s201

‑

s203。

48.s201、电子设备基于第一训练样本集和教师声学模型,对预设学生声学模型进行训练,得到目标学生声学模型。

49.本技术实施例中,目标学生声学模型是基于预设学生声学模型训练得到的,用于训练目标学生声学模型的第一训练样本集包括多个文本和多个文本对应的声学特征。

50.上述教师声学模型、预设学生声学模型以及目标学生声学模型均用于提取文本的声学特征,应理解,这些声学模型的输入为文本,声学模型的输出为文本的声学特征。

51.可选的,本技术实施例中的声学模型(包括上述教师声学模型、预设学生声学模型以及目标学生声学模型)可以为基于端到端的语音合成的tacotron模型 (是一种神经网络模型),例如tacotron1、tacotron2模型,声学模型也可以为fastspeech,deepvoice等,具体可以根据实际需求进行选择,本技术实施例不做限定。在本技术实施例中,以声学模型为tacotron2为例进行说明,当声学模型为tacotron2模型时,该声学模型输出的声学特征是梅尔谱特征。

52.需要说明的是,本技术实施例中的预设学生声学模型为轻量级的声学模型,那么基于该预设学生声学模型训练得到的目标学生声学模型也为轻量级的声学模型,轻量级的声学模型指的是经结构简化、模型参数优化等方式处理之后的声学模型,轻量级的声学模

型结构更为简单,运算复杂度较低。

53.本技术实施例中,轻量级的声学模型可以包括对预设声学模型(该预设声学模型是未被简化的声学模型)进行下述至少一种处理所得到的声学模型(对应处理方式1

‑

处理方式3中的至少一种)。

54.处理方式1、对预设声学模型进行结构裁剪。

55.本技术实施例中,声学模型(例如tacotron2模型)由编码器(encoder)、注意力机制(attention)和解码器(decoder)三部分构成。编码器用于对输入的文本进行编码,输出上下文向量,注意力机制用于计算解码器上一次(也可以称为上一时刻)输出的声学特征和编码器输出的上下文向量之间的权重,得到加权后的注意力向量,解码器用于根据上一次输出的声学特征和加权后的注意力向量输出当前的声学特征。可以理解的是,在声学模型中,解码器的结构较为复杂,语音合成的耗时主要取决于解码器的处理时长,因此,在本技术实施例中,对预设声学模型进行结构裁剪指的是对tacotron2模型中的解码器(decoder)中的神经元数量进行裁剪,即减少解码器中的神经元的数量。

56.具体的,对解码器(decoder)中的神经元数量进行裁剪主要是裁剪解码器 (decoder)中的两层长短期记忆网络(long short

‑

term memory,lstm)中的神经元的数量。示例性的,未裁剪的lstm中,每一个神经网络层的神经元的数量为1024,可以将每一个神经网络层的神经元数量裁剪至512、256或128 等。

57.按照处理方式1对预设声学模型进行结构裁剪,可以简化解码器(decoder) 中的lstm的结构,得到轻量级的声学模型,基于轻量级的声学模型进行语音合成能够减少计算量,以快速完成语音合成,也就是说,对预设声学模型进行结构裁剪能够提升语音合成的实时率。进一步的,对预设声学模型进行结构裁剪,能够减少语音合成过程中的计算量,从而节约计算资源。

58.处理方式2、增加预设声学模型所处理的数据帧的帧长。

59.文本数据的处理是按照数据帧的先后顺序逐帧处理的,基于声学模型对文本数据进行处理的过程中,声学模型中的解码器对数据进行解码时,解码次数等于文本数据包含的数据帧的帧数。应理解,一段本文数据的长度是该文本数据包含的数据帧的帧数与帧长的乘积,在文本数据的长度一定的情况下,对于一段文本数据,帧长越大,则文本数据所划分的帧数越少。

60.示例性的,可以将预设声学模型所处理的数据帧的帧长由5ms增加至10ms,甚至20ms等。

61.本技术实施例中,上述处理方式2中增加预设声学模型所处理的数据帧的帧长,可以得到参数优化后的轻量级的声学模型。该轻量级的声学模型对应的帧长增大,则数据帧的帧数减少,如此可以缩短数据的解码时间,以快速完成语音合成,即通过增加预设声学模型所处理的数据帧的帧长能够提升语音合成的实时率。

62.处理方式3、增加预设声学模型单次处理的数据帧的数量。

63.通常,预设声学模型中的解码器(decoder)对数据解码的过程中,解码器一次只能解码预测一帧,即根据前一帧的梅尔谱特征来预测当前帧的梅尔谱特征。

64.本技术实施例中,增加预设声学模型单次处理的数据帧的数量的一种实现方式是:将多个帧的梅尔谱特征进行拼接,一次性预测出后续的多个帧的梅尔谱特征。例如,将

第n

‑

2帧的梅尔谱特征和第n

‑

1帧的梅尔谱特征拼接之后,一次性预测出第n帧的梅尔谱特征和第n+1帧的梅尔谱特征。

65.可选的,在实际应用中,也可以将更多帧的梅尔谱特征进行拼接。

66.本技术实施例中,按照上述处理方式3增加预设声学模型单次处理的数据帧的数量,可以得到参数优化后的轻量级的声学模型。该轻量级的声学模型对应的单次处理的数据帧的数量增大,则可以实现多帧并行处理,能够快速完成语音合成,即通过增加预设声学模型单次处理的数据帧的数量能够提升语音合成的实时率。

67.可选的,结合图3所示的目标学生声学模型的训练过程示意图,如图4所示,上述s201可以通过下述s201a

‑

s201d实现。

68.s201a、电子设备确定第一训练样本集中的文本经教师声学模型处理的情况下,教师声学模型的损失。

69.具体的,将第一训练样本集中的文本输入至教师声学模型中,预测得到文本对应的梅尔谱特征,记为y

pt

,该文本的真实的梅尔谱特征记为y

r

,教师声学模型的损失l0可以用如下公式表示:

70.l0=rmse(y

r

,y

pt

)

71.其中,rmse(y

r

,y

pt

)表示的是文本的真实的梅尔谱特征与经教师声学模型预测得到的该文本的梅尔谱特征之间的均方根误差。

72.s201b、电子设备确定第一训练样本集中的文本经预设学生声学模型处理的情况下,预设学生声学模型的损失。

73.具体的,将第一训练样本集中的同一文本输入预设学生声学模型中,预测得到文本对应的梅尔谱特征,记为y

ps

,该文本的真实的梅尔谱特征记为y

r

,预设学生声学模型的损失l

k

可以用如下公式表示:

74.l

k

=rmse(y

r

,y

ps

)

75.其中,rmse(y

r

,y

ps

)表示文本的真实的梅尔谱特征与经预设学生声学模型预测得到的文本的梅尔谱特征之间的均方根误差。

76.s201c、电子设备根据教师声学模型的损失和预设学生声学模型的损失,确定目标损失。

77.本技术实施例中,目标损失为学生声学的损失与教师声学模型的损失之和,即l

f

=l

0+

l

k

,l

f

表示目标损失。

78.s201d、电子设备基于目标损失,对预设学生声学模型进行更新。

79.本技术实施例中,电子设备基于目标损失,对预设学生声学模型进行更新具体指对预设学生声学模型的参数进行更新。

80.综上所述,电子设备循环执行上述s201a

‑

s201d,执行次数达到预设的训练次数或者目标损失满足预设条件的情况下,结束模型训练,得到目标学生声学模型。

81.本技术实施例中,通过上述s201a

‑

s201d训练得到的目标声学模型的过程是一种知识蒸馏的过程,可以将教师声学模型的知识迁移至学生声学模型,得到目标学生声学模型,该目标学生声学模型输出的声学特征更加准确,因此,基于目标学生声学模型进行语音合成得到语音的音质较好。

82.s202、电子设备采用目标学生声学模型对目标文本进行特征提取,得到目标文本

的声学特征。

83.可选的,本技术实施例中,电子设备获取到目标文本之后,首先对目标文本进行预处理,然后将经预处理之后的目标文本输入至目标学生声学模型。

84.本技术实施例中,以目标文本为中文为例,对目标文本进行预处理可以包括:汉字转拼音、多音字消歧、文本正则、韵律标注等。

85.其中,韵律标注指标注句子内部的停顿位置,例如对于句子“卡尔普陪外孙玩滑梯”,可以将其标注为“卡尔普#1陪#1外孙#1玩滑梯。#3”,其中,#1 表示较短的停顿,#3在句尾表示为较长的停顿。

86.多音字消歧:在汉语中同一个字可能有不同的发音,例如目标文本为“重庆大学是重点大学”,两个“重”字的发音是不同的,因此需要对目标文本进行多音字消歧。具体的,可以对目标文本进行语义分析来准确预测目标文本中的多音字的发音,例如经过多音字消歧,上述目标文本则可被标注为“重(chong2) 庆大学是重(zhong4)点大学”,最终经预处理后的文本为“chong2 qing4 da4xue2#1 shi4#1 zhong4 dian3 da4 xue2#3”。

87.文本正则:指的是将文本中一些特殊的数字和符号转化为合理的发音,例如目标文本为“上午11:30”,可以将其转化为“上午十一点三十”,最终经预处理后的文本为“shang4 wu3#1 shi2 yi1 dian3 san1 shi2#3”。又例如,目标文本为“3kg”,可以将其转化为“三千克”,最终经预处理后的文本为“san1 qian1ke4#3”。对目标文本进行文本正则能够使得目标文本对应的语音更加合理。

88.s203、电子设备通过声码器对目标文本的声学特征进行处理,得到目标文本对应的语音。

89.可选的,本技术实施例中,声码器可以采用lpcnet、wavernn、wavenet、 waveglow等神经网络模型中的任一种。示例性的,本技术实施例以预设声码器模型为lpcnet为例,其结构公式如下:

90.s=f

l

(mel)

91.其中,f

l

是声码器模型,mel表示输入至该声码器的梅尔谱特征,s表示声码器输出的语音,即最终合成的语音。

92.综上,本技术实施例提供的语音合成方法中,电子设备可以基于第一训练样本集和教师声学模型,对预设学生声学模型进行训练,得到目标学生声学模型,该第一训练样本集包括多个文本和该多个文本对应的声学特征,该预设学生声学模型为轻量级的声学模型;并且采用目标学生声学模型对目标文本进行特征提取,得到目标文本的声学特征;以及通过声码器对目标文本的声学特征进行处理,得到目标文本对应的语音。本技术实施例中,一方面,根据轻量级的预设学生声学模型训练得到的目标学生声学模型也为轻量级的声学模型,由于轻量级的声学模型结构更为简单,运算复杂度较低,因此基于目标学生声学模型可以快速完成语音合成,即通过本技术实施例提供的技术方案能够提升语音合成的实时率;另一方面,根据第一训练样本集和教师声学模型对预设学生声学模型进行训练,能够将教师声学模型的知识迁移至学生声学模型,得到目标学生声学模型,该目标学生声学模型输出的声学特征更加准确,因此,基于该目标学生声学模型进行语音合成得到语音的音质较好,即通过本技术实施例提供的技术方案能够提升所合成的语音的音质。

93.可选地,结合图2,如图5所示,在上述s201(电子设备基于第一训练样本集和教师

声学模型,对预设学生声学模型进行训练,得到目标学生声学模型) 之前,本技术实施例提供的语音合成方法还包括s204。

94.s204、电子设备基于第二训练样本集,对预设教师声学模型进行训练,得到教师声学模型。

95.其中,第二训练样本集包括多个文本和多个文本对应的声学特征。

96.可选的,预设教师声学模型也可以为tacotron2模型。

97.可选地,结合图5,如图6所示,在上述s201(电子设备基于第一训练样本集和教师声学模型,对预设学生声学模型进行训练,得到目标学生声学模型) 之前,本技术实施例提供的语音合成方法还包括s205。

98.s205、电子设备根据第三训练样本集,确定第一训练样本集(包括多个文本和多个文本对应的声学特征)。

99.其中,第三训练样本集包括多个文本和该多个文本对应的语音。

100.可选的,结合图6,如图7所示,上述s205可以通过s2051

‑

s2052实现。

101.s2051、从第三训练样本集中的多个文本对应的语音中提取多个文本对应的声学特征。

102.本技术实施例中,可以采用python的常用音频处理工具包librosa,对预处理后的文本经过分帧、加窗、预加重等处理,从预处理后的文本中提取梅尔谱特征(该梅尔谱特征为真实的梅尔谱特征)。

103.s2052、将第三训练样本集中的多个文本和多个文本对应的声学特征组成的训练样本集作为第一训练样本集。

104.可选的,上述第二训练样本集可以按照上述确定第一训练样本集类似的方法得到,例如确定第二训练样本集的方法包括:从第五训练样本集中的多个文本对应的语音中提取多个文本对应的声学特征,将第五训练样本集中的多个文本和多个文本对应的声学特征组成的训练样本集作为第二训练样本集。

105.可选地,结合图2,如图8所示,在上述s203(通过声码器对目标文本的声学特征进行处理,得到目标文本对应的语音)之前,本技术实施例提供的语音合成方法还包括s206。

106.s206、基于第四训练样本集,对预设声码器进行训练,得到声码器。

107.第四训练样本集包括多个文本对应的声学特征和该多个文本对应的语音。

108.可选的,确定上述第四训练样本集的方法包括:从第六训练样本集中的多个文本对应的语音中提取多个文本对应的声学特征;将第六训练样本集中的多个文本对应的声学特征和该多个文本对应的语音组成的训练样本集作为第四训练样本集。

109.可选的,上述第三训练样本集、第五训练样本集、第六训练样本集所包含的样本可以相同也可以不同。

110.可选的,上述预设声码器为经结构裁剪的声码器。

111.本技术实施例中,声码器(例如lpcnet模型)由帧网络和采样点网络两部分构成,帧网络用于生成表示当前帧的特征向量,采样点网络用于循环生成一帧中的所有采样点。可以理解的是,在声码器中,采样点网络的结构较为复杂,语音合成的耗时主要取决于采样点网络的处理时长,因此,在本技术实施例中,对预设声码器进行结构裁剪的指的是对lpcnet模型中的采样点网络中的神经元数量进行裁剪,即减少编码器(encoder)中的神经

元的数量。

112.具体地,采样点网络中的神经元数量进行裁剪主要是裁剪采样点网络中的门控循环单元(gated recurrent unit,gru)神经元的数量。示例性的,未裁剪的gru中,每一个神经网络层的神经元的数量为384,可以将每一个神经网络层的神经元数量裁剪至256或192等。

113.按照上述方式对预设声码器进行结构裁剪,可以简化采样点网络中的gru 的结构,得到轻量级的声码器,基于轻量级的声码器进行语音合成能够减少计算量,以快速完成语音合成,也就是说,对声码器进行结构裁剪能够进一步提升语音合成的实时率,进一步地,对声码器进行结构裁剪,能够降低语音合成过程中的计算复杂度,从而节约计算资源。

114.可选的,采用本技术实施例的语音合成方法对不同语言的文本进行语音合成,采用主观评价(mean opinion score,mos)法对语音合成的结果进行评分(评分越高表示音质越好)以评价合成的语音的音质。

115.可选的,还可以采用客观评价法对语音合成的速度进行评价,客观评价采用的是实时率rtf(real

‑

time

‑

ratio)作为评价指标,实时率的值越小表示语音合成的速度越快,实时率的计算公式如下:

116.rtf=time

syn

/time

gt

117.其中,time

syn

指的是系统合成音频所需的时间,time

gt

指的是音频的时长。

118.相应的,本技术实施例提供一种语音合成装置,如图9所示,该语音合成装置包括第一训练模块901、特征提取模块902、语音合成模块903。其中,第一训练模块901用于基于第一训练样本集和教师声学模型,对预设学生声学模型进行训练,得到目标学生声学模型,例如执行上述方法实施例中的s201。特征提取模块902用于基于目标声学模型对目标文本进行特征提取,得到目标文本的声学特征,例如执行上述方法实施例中的s202。语音合成模块903用于基于声码器对目标文本的声学特征进行处理,得到目标文本对应的语音,例如执行上述方法实施例中的s203。

119.可选的,上述第一训练模块901具体用于确定第一训练样本集中的文本经教师声学模型处理的情况下,教师声学模型的损失;并且确定第一训练样本集中的文本经预设学生声学模型处理的情况下,预设学生声学模型的损失;以及根据教师声学模型的损失和预设学生声学模型的损失,确定目标损失;进而基于该目标损失,对上述预设学生声学模型进行更新,得到目标学生声学模型,例如执行上述方法实施例中的s201a

‑

s201d。

120.可选的,本技术实施例提供的语音合成装置还包括第二训练模块904;该第二训练模块904用于基于第二训练样本集,对预设教师声学模型进行训练,得到教师声学模型,上述第二训练样本集包括多个文本和该多个文本对应的声学特征,例如执行上述方法实施例中的s204。

121.可选的,本技术实施例提供的语音合成装置还包括确定模块905,该确定模块905用于根据第三训练样本集,确定第一训练样本集,例如执行上述方法实施例中的s205。上述第三训练样本集包括多个文本和该多个文本对应的语音。

122.可选的,所述确定模块905具体用于从第三训练样本集中的多个文本对应的语音中提取该多个文本对应的声学特征,例如执行上述方法实施例中的s2051;并且将第三训练样本集中的多个文本和该多个文本对应的声学特征组成的训练样本集作为第一训练样本

集,例如执行上述方法实施例中的s2052。

123.可选的,本技术实施例提供的语音合成装置还包括第三训练模块906,该第三训练模块906用于基于第四训练样本集,对预设声码器进行训练,得到声码器,第四训练样本集包括多个文本对应的声学特征和该多个文本对应的语音,例如执行上述方法实施例中的s206。

124.最后应说明的是:以上实施例仅用以说明本发明的技术方案,而非对其限制;尽管参照前述实施例对本发明进行了详细的说明,本领域的普通技术人员应当理解:其依然可以对前述实施例所记载的技术方案进行修改,或者对其中部分技术特征进行等同替换;而这些修改或者替换,并不使相应技术方案的本质脱离本发明实施例技术方案的精神和范围。