1.本发明涉及语音技术领域,更具体地,涉及一种声纹识别方法和声纹识别装置。

背景技术:

2.随着各种电子设备的普及,对电子设备的安全保护变得尤为重要。尤其是,期望电子设备仅在被注册的用户使用时才会被认证和/或解锁,从而防止电子设备被其他不被允许的人使用。

3.为了实现电子设备的安全保护,声音可作为用户的独特的信息而被使用。更具体地讲,声纹识别(voiceprint identification)技术(又称,说话人识别(speaker verification)技术)可被使用。通过声纹识别技术,可从说话人的语音中提取语音特征,并对语音特征进行身份验证。通常声纹识别分为注册和验证两个过程。在注册过程中,用户存储自身声纹信息作为注册用户;在验证过程中,将从说话人的语音中提取到的声纹特征与预先注册的声纹特征进行对比,得到特征的相似度得分,将该得分与阈值进行对比,若此得分大于阈值,判断为验证与注册为同一用户,若此得分小于或等于阈值,判断为验证与注册为不同用户。

4.然而,在实际应用场景中,用户的声音环境比较复杂。现有的声纹识别技术往往只能应对相对单一的应用的场景,而无法有效地满足用户的需要。

技术实现要素:

5.本发明的目的在于提供一种端到端的声纹识别方法和声纹识别装置。

6.在本公开的一方面,提供一种端到端的声纹识别方法,所述声纹识别方法包括:基于接收的输入语音,使用端到端深度学习网络的说话人语音提取模块执行说话人语音提取任务,以提取目标说话人的语音特征;基于目标说话人的语音特征,使用端到端深度学习网络的说话人识别模块执行说话人识别任务,以在接收的输入语音中识别目标说话人。

7.所述声纹识别方法还可包括:基于接收的输入语音,提取输入语音的原始语音特征;其中,执行说话人语音提取任务的步骤包括:基于原始语音特征和预先保存的注册人中间嵌入语音特征,执行说话人语音提取任务。

8.所述声纹识别方法还可包括:基于目标说话人的语音特征和原始语音特征,确定输入语音的说话场景,说话场景包括单人场景和多人场景,其中,执行说话人识别任务的步骤包括:基于输入语音的说话场景来执行说话人识别任务。

9.确定输入语音的说话场景是单人场景还是多人场景的步骤可包括:当目标说话人的语音特征与原始语音特征之间的均方误差小于阈值时,将输入语音的说话场景确定为单说话人场景;当目标说话人的语音特征与原始语音特征之间的均方误差大于或等于阈值时,将输入语音的说话场景确定为多说话人场景,其中,执行说话人识别任务的步骤包括:当输入语音的说话场景为单说话人场景时,将原始语音特征输入到说话人识别模块,利用预先保存的注册人最终语音特征在接收的输入语音中识别目标说话人;当输入语音的说话

场景为多说话人场景时,将目标说话人的语音特征输入到说话人识别模块,利用注册人最终语音特征在接收的输入语音中识别目标说话人。

10.在注册人的声纹注册阶段,所述声纹识别方法还可包括:基于接收的注册人语音,提取注册人语音的原始语音特征;基于注册人语音的原始语音特征,利用说话人识别模块提取注册人中间嵌入语音特征并保存;基于注册人中间嵌入语音特征,利用说话人识别模块提取注册人最终语音特征并保存。

11.执行说话人语音提取任务的步骤可包括:利用第一卷积层,从原始语音特征提取目标说话人中间嵌入语音特征;利用拼接层,将目标说话人中间嵌入语音特征和注册人中间嵌入语音特征拼接为拼接特征;利用全卷积层将输入的拼接特征生成掩膜;利用乘法器将掩膜与目标说话人中间嵌入语音特征相乘得到目标说话人的语音特征。

12.在端到端深度学习网络训练阶段,端到端深度学习网络还可包括:说话人一致性模块,被配置为对基于说话人识别模块输出的中间嵌入语音特征执行语音转换任务。

13.可通过监督学习训练说话人语音提取模块和说话人识别模块,通过自监督学习来训练说话人一致性模块,以获得加权和最小化的第一损失值、第二损失值和第三损失值,其中,第一损失值是说话人语音提取模块的损失值,第二损失值是说话人识别模块的损失值,第三损失值是说话人一致性模块的损失值。

14.在本公开的一方面,提供一种端到端的声纹识别装置,所述声纹识别装置包括:端到端深度学习网络的说话人语音提取模块,基于接收的输入语音,执行说话人语音提取任务,以提取目标说话人的语音特征;端到端深度学习网络的说话人识别模块,基于目标说话人的语音特征,执行说话人识别任务,以在接收的输入语音中识别目标说话人。

15.所述声纹识别装置还可包括:特征提取模块,基于接收的输入语音,提取输入语音的原始语音特征,其中,说话人语音提取模块被配置为:基于原始语音特征和预先保存的注册人中间嵌入语音特征,执行说话人语音提取任务。

16.所述声纹识别装置还可包括:说话场景确定模块,基于目标说话人的语音特征和原始语音特征,确定输入语音的说话场景,所述说话场景包括单人场景和多人场景,其中,说话人识别模块被配置为基于输入语音的说话场景来执行说话人识别任务。

17.说话场景确定模块可被配置为:当目标说话人的语音特征与原始语音特征之间的均方误差小于阈值时,将输入语音的说话场景确定为单说话人场景;当目标说话人的语音特征与原始语音特征之间的均方误差大于或等于阈值时,将输入语音的说话场景确定为多说话人场景,其中,说话人识别模块被配置为:当输入语音的说话场景为单说话人场景时,将原始语音特征输入到说话人识别模块,利用预先保存的注册人最终语音特征在接收的输入语音中识别目标说话人;当输入语音的说话场景为多说话人场景时,将目标说话人的语音特征输入到说话人识别模块,利用注册人最终语音特征在接收的输入语音中识别目标说话人。

18.在注册人的声纹注册阶段,所述声纹识别装置还可被配置为:基于接收的注册人语音,提取注册人语音的原始语音特征;基于注册人语音的原始语音特征,利用说话人识别模块提取注册人中间嵌入语音特征并保存;基于注册人中间嵌入语音特征,利用说话人识别模块提取注册人最终语音特征并保存。

19.说话人语音提取模块可被配置为:利用第一卷积层,从原始语音特征提取目标说

话人中间嵌入语音特征;利用拼接层,将目标说话人中间嵌入语音特征和注册人中间嵌入语音特征拼接为拼接特征;利用全卷积层将输入的拼接特征生成掩膜;利用乘法器将掩膜与目标说话人中间嵌入语音特征相乘得到目标说话人的语音特征。

20.在端到端深度学习网络训练阶段,端到端深度学习网络还可包括:说话人一致性模块,被配置为对基于说话人识别模块输出的中间嵌入语音特征执行语音转换任务。

21.可通过监督学习训练说话人语音提取模块和说话人识别模块,通过自监督学习来训练说话人一致性模块,以获得加权和最小化的第一损失值、第二损失值和第三损失值,其中,第一损失值是说话人语音提取模块的损失值,第二损失值是说话人识别模块的损失值,第三损失值是说话人一致性模块的损失值。

22.根据本公开的一方面,提供一种存储有计算机程序的计算机可读存储介质,其中,当所述计算机程序被处理器执行时,实现任一声纹识别方法。

23.根据本发明的示例实施例,可通过使用目标说话人的语音特征将说话人语音提取模块和说话人识别模块链接起来的端到端深度学习网络,来实现端到端的声纹识别,因此,即使面对复杂场景下的语音,本发明的端到端的声纹识别方法也可实现高识别性能和/或泛化性能。

24.根据本发明的示例实施例,可根据基于说话人语音提取模块的目标说话人的语音特征来确定输入语音的说话场景,并基于输入语音的说话场景来使用说话人识别模块执行说话人识别任务,从而通过使用相关联的说话人语音提取模块和说话人识别模块,可以满足单说话人场景的识别需要,也可以满足多说话人场景的需要。

25.根据本发明的示例实施例,由于可基于目标说话人的语音特征与原始语音特征之间的差异来确定输入语音的说话场景,因此,可以容易地确定输入语音的说话场景。

26.根据本发明的示例实施例,可通过确定输入语音的说话场景是单说话人场景还是多说话人场景,选择与说话人场景对应的适合于说话人识别模块的输入,因此,既能保证多说话人场景下的声纹识别的性能,也能保证单说话人场景下的声纹识别的性能,从而可以向用户提供更高性能的声纹识别服务。

27.根据本发明的示例实施例,可使用监督学习与自监督学习联合训练端到端深度学习网络,使得端到端深度学习网络通过使用说话人中间嵌入语音特征将说话人语音提取模块、说话人识别模块和说话人一致性模块相互链接来学习到三个任务(即,说话人语音提取任务、说话人识别任务和说话人一致性任务)之间的联系和差异,从而可以得到具有高性能(例如,高识别率和高泛化能力)的端到端深度学习网络。

28.根据本发明的示例实施例,可通过将原数据集中的语音数据进行融合来生成自监督学习训练样本集,因此能够在不增加数据量与标注的条件下,进行端到端深度学习网络的学习。

29.根据本发明的示例实施例,由于在训练的过程中考虑了说话人语音提取模块的第一损失、说话人识别模块的第二损失和说话人一致性模块的第三损失而更新端到端深度学习网络,因此,训练的端到端深度学习网络可以具有高识别性能和泛化性能。

附图说明

30.通过下面结合示例性地示出一例的附图进行的描述,本发明的上述和其他目的和

特点将会变得更加清楚,其中:

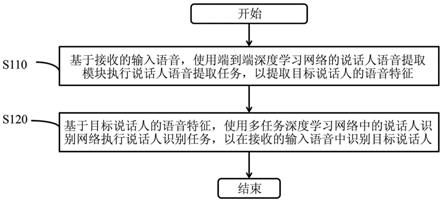

31.图1示出根据示例实施例的端到端的声纹识别方法的流程图。

32.图2示出根据示例实施例的说话人语音提取模块的示意图。

33.图3示出根据示例实施例的说话人识别模块的示意图。

34.图4示出根据示例实施例的训练说话人语音提取模块和说话人识别模块的示意图。

35.图5示出根据示例实施例的训练说话人语音提取模块和说话人识别模块的示意图。

36.图6示出根据示例实施例的端到端的声纹识别装置的框图。

37.图7示出根据示例实施例的计算装置的框图。

38.图8示出根据示例实施例的执行声纹识别任务的方法的流程图。

具体实施方式

39.提供下面的具体实施方式以帮助读者获得对在此描述的方法、设备和/或系统的全面了解。然而,在了解本技术的公开之后,在此描述的方法、设备和/或系统的各种改变、修改和等同物将是清楚的。例如,在此描述的操作的顺序仅是示例,并且不限于在此阐述的那些顺序,而是除了必须以特定的顺序发生的操作之外,可如在了解本技术的公开之后将是清楚的那样被改变。此外,为了更加清楚和简明,本领域已知的特征的描述可被省略。

40.在此描述的特征可以以不同的形式来实现,而不应被解释为限于在此描述的示例。相反,已提供在此描述的示例,以仅示出实现在此描述的方法、设备和/或系统的许多可行方式中的一些可行方式,所述许多可行方式在了解本技术的公开之后将是清楚的。

41.如在此使用的,术语“和/或”包括相关联的所列项中的任何一个以及任何两个或更多个的任何组合。

42.尽管在此可使用诸如“第一”、“第二”和“第三”的术语来描述各种构件、组件、区域、层或部分,但是这些构件、组件、区域、层或部分不应被这些术语所限制。相反,这些术语仅用于将一个构件、组件、区域、层或部分与另一构件、组件、区域、层或部分进行区分。因此,在不脱离示例的教导的情况下,在此描述的示例中所称的第一构件、第一组件、第一区域、第一层或第一部分也可被称为第二构件、第二组件、第二区域、第二层或第二部分。

43.在说明书中,当元件(诸如,层、区域或基底)被描述为“在”另一元件上、“连接到”或“结合到”另一元件时,该元件可直接“在”另一元件上、直接“连接到”或“结合到”另一元件,或者可存在介于其间的一个或多个其他元件。相反,当元件被描述为“直接在”另一元件上、“直接连接到”或“直接结合到”另一元件时,可不存在介于其间的其他元件。

44.在此使用的术语仅用于描述各种示例,并不将用于限制公开。除非上下文另外清楚地指示,否则单数形式也意在包括复数形式。术语“包含”、“包括”和“具有”说明存在叙述的特征、数量、操作、构件、元件和/或它们的组合,但不排除存在或添加一个或多个其他特征、数量、操作、构件、元件和/或它们的组合。

45.除非另有定义,否则在此使用的所有术语(包括技术术语和科学术语)具有与由本公开所属领域的普通技术人员在了解本公开之后通常了解的含义相同的含义。除非在此明确地如此定义,否则术语(诸如,在通用词典中定义的术语)应被解释为具有与它们在相关

领域的上下文和本公开中的含义一致的含义,并且不应被理想化或过于形式化地解释。

46.此外,在示例的描述中,当认为公知的相关结构或功能的详细描述将引起对本公开的模糊解释时,将省略这样的详细描述。

47.在下文中,将参照附图详细描述实施例。然而,实施例可以以各种形式实现,并且不限于在此描述的实施例。

48.图1示出根据示例实施例的端到端的声纹识别方法的流程图。

49.参照图1,在操作s110中,基于接收的输入语音,使用端到端深度学习网络的说话人语音提取模块执行说话人语音提取任务,以提取目标说话人的语音特征。

50.这里,输入语音可以是为了使用电子设备而输入的待识别的语音。输入语音可以在不同的场景下被生成和输入。在一个示例中,输入语音可以是在单人场景下由单人输入的语音。在另一个示例中,输入语音可以是在多人场景下由多人(例如,两人或更多人)输入的语音。

51.目标说话人可以是输入语音中的待识别和/或验证的说话人。例如,在单人场景下,目标说话人可以是该单个人。又例如,在多人场景下,目标说话人可以是多个人中的任意一个人或者指定的一个人。

52.在一个实施例中,说话人语音提取模块可利用第一卷积层,从原始语音特征提取目标说话人中间嵌入语音特征。说话人语音提取模块可利用拼接层,将目标说话人中间嵌入语音特征和注册人中间嵌入语音特征拼接为拼接特征。说话人语音提取模块可利用全卷积层将输入的拼接特征生成掩膜。说话人语音提取模块可利用乘法器将掩膜与目标说话人中间嵌入语音特征相乘得到目标说话人的语音特征。后面将结合图2对说话人语音提取模块进行更具体地描述。

53.在操作s120中,基于目标说话人的语音特征,使用端到端深度学习网络的说话人识别模块执行说话人识别任务,以在接收的输入语音中识别目标说话人。

54.也就是说,在本发明的端到端的声纹识别方法中,可通过使用目标说话人的语音特征将说话人语音提取模块和说话人识别模块链接起来的端到端深度学习网络,来实现端到端的声纹识别。因此,即使面对复杂场景下的语音,本发明的端到端的声纹识别方法也可实现高识别性能和/或泛化性能。

55.相比之下,在现有技术中,通常使用两个模型相互独立的两阶段声纹识别方法来执行声纹识别。更具体地讲,两阶段声纹识别方法首先使用一个模型提取目标说话人的语音,再将提取到的语音输入声纹识别模型,获得说话人相似性得分。由于两阶段声纹识别方法使用相互独立的两个模型,因此,得到的两个模型未能利用其执行的两个任务之间的直接的联系进行调优,所得到的模型仅为次优,而无法得到最优的模型。

56.后面将结合图3对说话人识别模块进行更具体地描述。

57.此外,可选地,基于接收的输入语音,提取输入语音的原始语音特征。原始语音特征可以是基于接收的输入语音而使用特征提取模块提取的特征。在一个示例中,原始语音特征可以是梅尔倒谱系数(mel

‑

scale frequency cepstral coefficients,mfcc)。在另一个示例中,原始语音特征可以是滤波器组(filterbank)特征。然而,上述示例仅是示例性的,本发明不限于此。原始语音特征也可以是其他常用的语音特征。

58.原始语音特征可用于说话人语音提取任务。更具体地讲,说话人语音提取模块可

基于原始语音特征和预先保存的注册人中间嵌入语音特征,执行说话人语音提取任务。

59.另外,在一个实施例中,目标说话人的语音特征还可用于确定输入语音的说话场景。之后,可基于输入语音的说话场景来执行说话人识别任务。更具体地讲,可基于目标说话人的语音特征和原始语音特征,确定输入语音的说话场景。这里,说话场景包括单人场景和多人场景。

60.换言之,在该实施例中,可根据基于说话人语音提取模块的目标说话人的语音特征来确定输入语音的说话场景,并基于输入语音的说话场景来使用说话人识别模块执行说话人识别任务,从而通过使用相关联的说话人语音提取模块和说话人识别模块,可以满足单说话人场景的识别需要,也可以满足多说话人场景的需要。

61.根据本发明的一个示例实施例,可基于目标说话人的语音特征与原始语音特征之间的差异,确定输入语音的说话场景(即,确定输入语音的说话场景是单人场景还是多人场景)。

62.另外,说话人语音提取模块可基于原始语音特征执行说话人语音提取任务,以提取目标说话人的语音特征。换言之,说话人语音提取模块可通过从特征提取模块接收原始语音特征作为输入来执行说话人语音提取任务,以提取目标说话人的语音特征。这里,原始语音特征可以是与目标说话人的语音特征相同类型的特征。

63.由于可基于目标说话人的语音特征与原始语音特征之间的差异来确定输入语音的说话场景,因此,可以容易地确定输入语音的说话场景。

64.例如,当目标说话人的语音特征与原始语音特征之间的差异较大时,可将输入语音的说话场景确定为多说话人场景。当目标说话人的语音特征与原始语音特征之间的差异较小时,可将输入语音的说话场景确定为单说话人场景。

65.在一个实施例中,当目标说话人的语音特征与原始语音特征之间的均方误差小于阈值时,可将输入语音的说话场景确定为单说话人场景。另外,当目标说话人的语音特征与原始语音特征之间的均方误差大于或等于阈值时,将输入语音的说话场景确定为多说话人场景。

66.当输入语音的说话场景为单说话人场景时,可将原始语音特征输入到说话人识别模块,利用预先保存的注册人最终语音特征在接收的输入语音中识别目标说话人。当输入语音的说话场景为多说话人场景时,可将目标说话人的语音特征输入到说话人识别模块,利用注册人最终语音特征在接收的输入语音中识别目标说话人。注册人最终语音特征可在注册人声纹注册阶段被生成。更具体地讲,在注册人的声纹注册阶段,可基于接收的注册人语音,提取注册人语音的原始语音特征。之后,可基于注册人语音的原始语音特征,利用说话人识别模块提取注册人中间嵌入语音特征并保存。接下来,可基于注册人中间嵌入语音特征,利用说话人识别模块提取注册人最终语音特征并保存。

67.换言之,可通过确定输入语音的说话场景是单说话人场景还是多说话人场景来选择与说话人场景对应的适合于说话人识别模块的输入。因此,根据本发明的端到端的声纹识别方法既能保证多说话人场景下的声纹识别的性能,也能保证单说话人场景下的声纹识别的性能,从而可以向用户提供更高性能的声纹识别服务。

68.相比之下,在现有技术中,通常使用两个模型相互独立的两阶段声纹识别方法来执行多说话人场景下的声纹识别。在该两阶段声纹识别方法中,默认的说话人场景是多说

embedder)310和注意力统计池层320。

84.在注册阶段,在通过特征提取模块提取注册人语音的原始语音特征后,将原始语音特征输入到说话人嵌入器310,生成注册人中间嵌入语音特征并保存;然后将注册人中间嵌入语音特征输入至注意力统计池层320,生成注册人最终语音特征并保存。

85.在需要区分语音场景的识别阶段,当输入语音的说话场景为单说话人场景时,说话人识别模块可接收原始语音特征,并基于接收的原始语音特征生成说话人中间嵌入语音特征,即说话人嵌入器310的输入为接收语音的原始语音特征。当输入语音的说话场景为多说话人场景时,说话人识别模块可接收目标说话人的语音特征,并基于接收的目标说话人的语音特征生成中间嵌入语音特征,即说话人嵌入器310的输入为目标说话人的语音特征。

86.在一个示例中,说话人嵌入器310可采用se块(sequeze and excitation block)构成。在另一个示例中,说话人嵌入器310可采用冗余神经网络块(resnet block)构成。在又一示例中,说话人嵌入器310可采用时延神经网络(tdnn)构成。然而,上述示例仅是示例性的,本发明不限于此。说话人嵌入器310也可以是其他常用的神经网络或者它们的组合来构成。

87.注意力统计池层320可基于说话人中间嵌入语音特征生成说话人最终语音特征。说话人最终语音特征也可以被称为说话人嵌入(speaker embedding)。在一个示例中,说话人最终语音特征可以是一维向量。仅作为示例,说话人最终语音特征的大小可被设置为1x128、1x256或者1x512。

88.之后,说话人识别模块300可基于说话人最终语音特征与预先保存的注册人最终语音特征之间的相似度,在接收的输入语音中识别目标说话人。当相似度(例如,余弦相似度)大于阈值时,目标说话人可被识别为与注册的说话人一致。当相似度小于或等于阈值时,目标说话人可被识别为与注册的说话人不一致。

89.图4示出根据示例实施例的训练说话人语音提取模块和说话人识别模块的示意图。

90.参照图4,可通过监督学习训练说话人语音提取模块和说话人识别模块,通过自监督学习来训练说话人一致性模块,以获得加权和最小化的第一损失值、第二损失值和第三损失值。第一损失值是说话人语音提取模块的损失值,第二损失值是说话人识别模块的损失值,第三损失值是说话人一致性模块的损失值。因此,根据本发明的示例实施例,可使用监督学习与自监督学习联合训练说话人语音提取模块、说话人识别模块和说话人一致性模块,使得端到端深度学习网络通过使用说话人中间嵌入语音特征将说话人语音提取模块、说话人识别模块和说话人一致性模块相互链接来学习到三个任务(即,说话人语音提取任务、说话人识别任务和说话人一致性任务)之间的联系和差异,从而可以得到具有高性能(例如,高识别率和高泛化能力)的网络。

91.在图4中,原数据集包括多条语音和对应的说话人标签。该多条语音中的每条语音可包括单个说话人的语音。换言之,原数据集中的各条语音可对应于单说话人场景下的语音。

92.自监督学习训练样本集模块可通过将原数据集中的语音数据进行融合来生成自监督学习训练样本集。更具体地讲,自监督学习训练样本集模块可选择2个或多个不同说话人的语音进行融合。例如,以选择组合两个说话人为例,自监督学习训练样本集模块可在原

数据集中选取说话人1的一条语音c与说话人2的一条语音d,将两条语音合并得到语音m。例如,语音m可以是语音c和语音d的直接相加,语音c可作为语音m的标签。这个过程无需人工对语音逐一进行标注,实现了自监督学习中样本的自动生成。因此,根据实施例,能够在不增加数据量与标注的条件下,进行网络的学习。

93.可选地,可对对融合后的语音可进行语音增强预处理(例如,随机裁剪、加噪、加混响、音量增强等)。例如,仅作为示例,随机裁剪的时间可被设置为2秒。在本发明中,说话人语音提取任务可被理解为输入语音m,输出语音c,而说话人一致性任务可被理解为:输入语音c,输出语音c。

94.可选地,说话人语音提取模块和说话人识别模块可从特征提取模块接收数据。例如,特征提取模块可基于原数据集提取原数据集的原始语音特征,并将原数据集的原始语音特征输入到说话人识别模块。另外,特征提取模块可基于自监督学习训练样本集提取自监督学习训练样本集的原始语音特征,并将自监督学习训练样本集的原始语音特征输入到说话人语音提取模块。这里,特征提取模块可以预先训练好的模块。

95.在一个实施例中,说话人语音提取模块、说话人识别模块和说话人一致性模块可被训练,使得说话人语音提取模块的第一损失、说话人识别模块的第二损失和说话人一致性模块的第三损失的加权和最小化。由于在训练的过程中考虑了说话人语音提取模块的第一损失、说话人识别模块的第二损失和说话人一致性模块的第三损失而更新端到端深度学习网络,因此,训练的说话人语音提取模块和说话人识别模块可以具有高识别性能和泛化性能。应理解,虽然在训练的过程中使用了说话人一致性模块来提升说话人语音提取模块和说话人识别模块的性能,但是在识别的过程中,说话人一致性模块并不被使用。

96.下面将结合示例对说话人语音提取模块、说话人识别模块和说话人一致性网的训练进行描述,然而端到端深度学习网络的训练进不限于下面的示例。

97.在该示例中,对于说话人识别任务,训练数据来自原数据集,每个最小批次(min

‑

batch)选取预定数量(例如,200人)的说话人,每个说话人选多条不同的语音(例如,两句不同的语音a和b),并随机选择其他说话人的语音(例如,一条语音f),得到的输出为说话人语音的嵌入(embedding)表示。说话人识别损失函数可使用度量学习损失(metric learning loss)减小类内间距,增大类间间距,并计算误差(即,说话人识别模块的第二损失),以更新说话人识别模块(sv)。对于说话人语音提取任务,可将说话人1与其他说话人语音合成后的语音输入说话人语音提取模块(se),同时,说话人识别模块(sv)会生成说话人1的说话人表征向量,将说话人1的表征向量输入说话人语音提取模块,得到提取后的预测说话人1语音说话人语音提取损失函数根据标签语音y

s

和预测语音计算出误差(即,说话人语音提取模块的第一损失),该误差通过反向传播对说话人识别模块(sv)与说话人语音提取模块(se)的参数进行更新。对于说话人一致性模块,将说话人1的语音c输入说话人一致性模块(sc),同时,说话人识别模块(sv)会生成说话人1的说话人中间嵌入语音特征,将说话人1的说话人中间嵌入语音特征输入说话人一致性模块(sc),得到合成后的说话人1语音说话人一致性模块损失函数根据标签语音y

s

和预测语音计算出误差(即,说话人一致性模块的第三损失),该误差通过反向传播对说话人识别模块(sv)与说话人一致性模块(sc)的参数进行更新。

98.图5示出根据示例实施例的训练说话人语音提取模块和说话人识别模块的示意图。

99.参照图4描述的各个网络可与图5中的各个网络基本类似。换言之,参照图4的各个网络的描述也可应用于图5的各个网络。因此,为了避免冗余,将省略重复的描述。

100.另外,图5的实施例与图4的实施例的主要区别在于,说话人一致性模块的一个输入并非来自说话人提取模块,而是来自特征提取模块。

101.这里,可将图5的网络结构称为并联形式的网络结构,并可将图4的网络结构称为串联形式的网络结构。

102.虽然图4和图5示出了说话人识别模块(sv)、说话人语音提取模块(se)和说话人一致性模块(sc)的示例组成方式(即,串联和并联),然而,本发明不限于此,说话人识别模块(sv)、说话人语音提取模块(se)和说话人一致性模块(sc)也可以以其他方式进行连接和/或组成。

103.图6示出根据示例实施例的端到端的声纹识别装置的框图。

104.参照图6,声纹识别装置600可包括端到端深度学习网络的说话人语音提取模块610和端到端深度学习网络的说话人识别模块620。

105.换言之,端到端深度学习网络可包括说话人语音提取模块610和说话人识别模块620。说话人语音提取模块610可以是如参照图1至图5中的至少一个描述的说话人语音提取模块。换言之,说话人语音提取模块610可基于接收的输入语音,执行说话人语音提取任务,以提取目标说话人的语音特征。

106.说话人识别模块620还可以是如参照图1至图5中的至少一个描述的说话人识别模块。换言之,说话人识别模块620可基于输入语音的说话场景,执行说话人识别任务,以在接收的输入语音中识别目标说话人。

107.可选地,声纹识别装置600还可包括说话场景确定模块(未示出)。说话场景确定模块可如参照图1所述的基于目标说话人的语音特征确定输入语音的说话场景。

108.可选地,声纹识别装置600还可包括特征提取模块(未示出)。特征提取模块可如参照图1所述的基于接收的语音来提取接收的语音的原始语音特征。

109.上面已经结合图1至图5中的至少一个描述了由说话人语音提取网610络执行的说话人语音提取任务、由说话人识别模块620执行的说话人识别任务、由说话人一致性模块在训练期间执行的说话人一致性任务、提取原始语音特征的方法和确定输入语音的说话场景的方法。因此,为了简明和不必要的冗余描述,将省略对说话人语音提取模块610和说话人识别模块620所执行的方法的具体描述。

110.图7示出根据示例实施例的电子装置的框图。

111.参照图7,根据本发明的实施例的电子装置700可包括处理器710和存储器720。这里,存储器720存储有计算机程序,其中,该计算机程序在被处理器710执行时实现参照图1至图5描述的任意声纹识别方法。为了简明,这里不再重复描述由处理器710执行的参照图1至图5描述的任意声纹识别方法。

112.此外,根据本发明示例性实施例的方法可以被实现为计算机可读记录介质中的计算机程序。本领域技术人员可以根据对上述方法的描述来实现所述计算机程序。当所述计算机程序在计算机中被执行时实现本发明的端到端声纹识别方法。

113.根据本发明的示例性实施例,可提供一种计算机可读存储介质,所述计算机可读存储介质上存储有计算机程序,所述计算机程序在被处理器执行时使得处理器实现本技术中所公开的任一方法。例如,在所述计算机程序被处理器执行时使得处理器执行以下步骤:基于接收的输入语音,使用端到端深度学习网络的说话人语音提取模块执行说话人语音提取任务,以提取目标说话人的语音特征;基于目标说话人的语音特征,使用端到端深度学习网络的说话人识别模块执行说话人识别任务,以在接收的输入语音中识别目标说话人。

114.图8示出根据示例实施例的执行声纹识别任务的方法的流程图。

115.参照图8,在步骤

①

中,可通过特征提取模块来接收输入语音。在步骤

②

中,可由特征提取模块基于输入语音来提取输入语音的原始语音特征。

116.在步骤

③

中,可由说话人语音提取模块接收输入语音的原始语音特征。更具体地讲,可由说话人语音提取模块的第一卷积层接收输入语音的原始语音特征。第一卷积层可基于原始语音特征生成说话人提取编码器嵌入特征(即,说话人中间嵌入语音特征)并将说话人中间嵌入语音特征输入到拼接层。另外,第一卷积层还可将说话人中间嵌入语音特征输入到说话人语音提取模块的乘法器

117.在步骤

④

中,可从存储装置获取注册的注册人中间嵌入语音特征,并且在步骤

⑤

中,可将注册人中间嵌入语音特征输入到说话人语音提取模块的拼接层。拼接层可将说话人提取编码器嵌入特征和注册的注册人中间嵌入语音特征拼接为拼接特征。之后,可将拼接特征输入到可包括多个1d膨胀卷积层(1

‑

d conv)的全卷积层。可选地,可在拼接层和全卷积层之间添加归一化层(layernorm),以对拼接特征进行归一化处理。全卷积层可基于拼接特征生成掩膜(mask)并将掩膜输出到乘法器乘法器可将掩膜与说话人中间嵌入语音特征相乘来得到目标说话人的语音特征。在步骤

⑥

中,乘法器可输出目标说话人的语音特征。

118.在步骤

⑦

中,可由说话场景确定模块来对原始语音特征和目标说话人的语音特征进行比较。例如,说话场景确定模块可比较原始语音特征和目标说话人的语音特征之间的均方差(mse)。

119.在步骤

⑧

,当原始语音特征和目标说话人之间的均方差小于阈值时,可将原始语音特征输入到说话人识别模块;当原始语音特征和目标说话人之间的均方差大于或等于阈值时,可将目标说话人的语音特征输入到说话人识别模块。

120.说话人识别模块可根据接收的输入来执行说话人识别任务。更具体地讲,说话人识别模块的说话人嵌入器可接收相应的输入,并基于输入来生成说话人中间嵌入语音特征。说话人嵌入器可将说话人中间嵌入语音特征输入到说话人识别模块的注意力统计池层。在步骤

⑨

中,注意力统计池层可基于说话人中间嵌入语音特征生成说话人最终语音特征。

121.在步骤

⑩

中,可从存储装置获取注册的注册人最终语音特征。在步骤中,可基于注册人最终语音特征与说话人最终语音特征之间的相似度来确定相似度分数,以在接收的输入语音中识别目标说话人。当相似度(例如,余弦相似度)大于阈值时,目标说话人可被识别为与注册的说话人一致。当相似度小于或等于阈值时,目标说话人可被识别为与注册的说话人不一致。

122.请注意,在图8中的描述的至少一个步骤和/或模块可对应于参照图1至图7描述的

至少一个步骤和/或模块。因此,图1至图7中的至少一个步骤和/或模块的描述也可以应用于图8中的至少一个步骤和/或模块。

123.此外,应该理解,根据本发明示例性实施例的设备中的各个单元可被实现硬件组件和/或软件组件。本领域技术人员根据限定的各个单元所执行的处理,可以例如使用现场可编程门阵列(fpga)或专用集成电路(asic)来实现各个单元。

124.根据本发明的示例实施例,可通过使用目标说话人的语音特征将说话人语音提取模块和说话人识别模块链接起来的端到端深度学习网络,来实现端到端的声纹识别,因此,即使面对复杂场景下的语音,本发明的端到端的声纹识别方法也可实现高识别性能和/或泛化性能。

125.根据本发明的示例实施例,可根据基于说话人语音提取模块的目标说话人的语音特征来确定输入语音的说话场景,并基于输入语音的说话场景来使用说话人识别模块执行说话人识别任务,从而通过使用相关联的说话人语音提取模块和说话人识别模块,可以满足单说话人场景的识别需要,也可以满足多说话人场景的需要。

126.根据本发明的示例实施例,由于可基于目标说话人的语音特征与原始语音特征之间的差异来确定输入语音的说话场景,因此,可以容易地确定输入语音的说话场景。

127.根据本发明的示例实施例,可通过确定输入语音的说话场景是单说话人场景还是多说话人场景来选择与说话人场景对应的适合于说话人识别模块的输入,因此,既能保证多说话人场景下的声纹识别的性能,也能保证单说话人场景下的声纹识别的性能,从而可以向用户提供更高性能的声纹识别服务。

128.根据本发明的示例实施例,可使用监督学习与自监督学习联合训练端到端深度学习网络,使得端到端深度学习网络通过使用说话人中间嵌入语音特征将说话人语音提取模块、说话人识别模块和说话人一致性模块相互链接来学习到三个任务(即,说话人语音提取任务、说话人识别任务和说话人一致性任务)之间的联系和差异,从而可以得到具有高性能(例如,高识别率和高泛化能力)的端到端深度学习网络。

129.根据本发明的示例实施例,可通过将原数据集中的语音数据进行融合来生成自监督学习训练样本集,因此能够在不增加数据量与标注的条件下,进行端到端深度学习网络的学习。

130.根据本发明的示例实施例,由于在训练的过程中考虑了说话人语音提取模块的第一损失、说话人识别模块的第二损失和说话人一致性模块的第三损失而更新端到端深度学习网络,因此,训练的端到端深度学习网络可以具有高识别性能和泛化性能。

131.虽然本公开包括特定的示例,但是对于本领域普通技术人员来说将清楚,在不脱离权利要求和它们的等同物的精神和范围的情况下,可在这些示例中进行形式和细节上的各种改变。在此描述的示例应仅被认为是描述性的,而不是出于限制的目的。每个示例中的特征或方面的描述应被认为可适用于其他示例中的类似特征或方面。如果描述的技术以不同的顺序被执行,和/或如果描述的系统、架构、装置或电路中的组件以不同的方式被组合,和/或由其他组件或它们的等同物替换或补充,则可实现合适的结果。因此,公开的范围不是由具体实施方式限定,而是由权利要求及它们的等同物限定,并且在权利要求及它们的等同物的范围内的所有变化应被解释为包括在公开中。