1.本技术涉及语音合成技术领域,具体涉及语音合成方法和装置,在线文本语音合成系统、方法和装置,语音交互系统、方法和装置,新闻播报系统、方法和装置,以及电子设备。

背景技术:

2.随着语音合成技术的快速发展和应用的日益普及,语音合成业务正快速扩大并越来越多地被用户接受和使用。随着用户的教育程度提高,越来越多的应用场景涉及到多语种内容,尤其以中英混读较为普遍。因此产生了多语种语音合成业务的需求,并带动了相关技术的发展。

3.一种典型的多语种语音合成系统采用如下处理方式:首先,分别基于不同语言,使用不同说话人数据建模的方式,建立多套语音合成器;然后,根据文本中的不同语言文字,进行对应合成器的切换使用,来完成合成任务。另一种典型的多语种语音合成系统所采用的方案是,直接将非母语音标映射到母语音标体系中,然后使用母语语音合成器合成语音。目前比较流行的解决方案是,采集目标发音人多语言数据进行建模的处理方式。

4.然而,在实现本发明过程中,发明人发现该技术方案至少存在如下问题:1)上述第一种方式通常造成合成音色和韵律不统一的问题,以至于影响语音合成的自然度和用户体验;2)上述第二种方式中,由于音标的映射关系仅仅是基于简单的发音相似性,因此合成的非母语语音会出现明显的发音不准确甚至错误,从而带来整体效果不自然;3)上述第三种方式中,大多数发音人除母语外的语言并不地道,带有较重的口音,采用这样的数据训练的模型在合成非说话人母语的语音上,发音均不够标准,降低用户体验;而聘请专业的多语发音人,数据采集成本又较高。此外,某些受欢迎的说话人未必精通双语或多语,这使得目前获得特定目标说话人的高质量多语言语音合成器变得非常困难。

5.综上所述,如何提升多语种语音合成的质量,以将多种语言文本合成自然的、准确的、音色统一的多语种语音,仍是亟待解决的问题。

技术实现要素:

6.本技术提供语音合成方法,以解决现有技术存在的多语种文本的语音合成质量较低的问题。本技术另外提供语音合成装置,在线文本语音合成系统、方法和装置,语音交互系统、方法和装置,新闻播报系统、方法和装置,以及电子设备。

7.本技术提供一种语音交互系统,包括:

8.智能音箱,用于采集用户语音数据,向服务端发送用户语音数据;以及,播放服务端回送的应答语音数据;

9.服务端,用于通过跨语言语音转换算法,根据至少一种第一语言的第一语音数据集,生成具有目标用户音色的目标用户的第一语言的第二语音数据集;根据所述第二语音数据集、和目标用户的第二语言的第三语音数据集,生成目标用户的具有多语言能力的语

音合成器;以及,确定与用户语音数据对应的相同语言的应答文本;通过所述语音合成器,生成与应答文本对应的应答语音数据。

10.本技术还提供一种在线文本语音合成系统,包括:

11.终端设备,用于向服务端发送针对目标多语言混合文本的第一用户语音合成请求;

12.服务端,用于通过跨语言语音转换算法,根据第二用户的第一语言的第一语音数据集,生成具有第一用户音色的第一用户的第一语言的第二语音数据集;根据所述第二语音数据集、和第一用户的第二语言的第三语音数据集,生成第一用户的具有多语言能力的语音合成器;以及,通过所述语音合成器,生成与所述混合文本对应的语音合成数据。

13.本技术还提供一种新闻播报系统,包括:

14.终端设备,用于向服务端发送用多语种播报文本的请求;播放服务端回送的由目标用户播报的与待播报文本对应的多语种语音数据;

15.服务端,用于通过跨语言语音转换算法,根据至少一个第一语言的第一语音数据集,生成具有目标用户音色的至少一个第一语言的第二语音数据集;根据所述第二语音数据集、和目标用户的第二语言的第三语音数据集,生成目标用户的具有多语言能力的语音合成器;以及,通过所述语音合成器,生成由目标用户播报的与待播报文本对应的多语种语音数据。

16.本技术还提供一种语音合成方法,包括:

17.通过跨语言语音转换算法,根据第二用户的第一语言的第一语音数据集,生成具有第一用户音色的第一用户的第一语言的第二语音数据集;

18.根据所述第二语音数据集、和第一用户的第二语言的第三语音数据集,生成第一用户的具有多语言能力的语音合成器;

19.通过所述语音合成器,生成与第一多语言混合文本对应的第一用户的语音合成数据。

20.可选的,所述通过所述语音合成器,生成与第一多语言混合文本对应的第一用户的语音合成数据,包括:

21.通过所述语音合成器包括的文本输入模块,确定所述第一多语言混合文本的发音单元序列,其中不同语言的文本片段的发音单元为相应语言的发音单元;

22.通过所述语音合成器包括的声学特征合成网络,根据所述发音单元序列,确定具有第一用户音色的声学特征序列;

23.通过所述语音合成器包括的声码器,根据声学特征序列,生成所述语音合成数据。

24.可选的,中文发音单元包括:汉语拼音的声母和韵母,以及声调;

25.英文发音单元包括:英文音素和轻重音;

26.可选的,所述英文发音单元序列采用如下方式确定:

27.在发音单元之间插入空格,并根据单词间语音停顿长度,插入标点符号。

28.可选的,所述根据所述第二语音数据集、和第一用户的第二语言的第三语音数据集,生成第一用户的具有多语言能力的语音合成器,包括:

29.根据所述第二语音数据集、和所述第三语音数据集,生成第一用户的混合语言的第四语音数据集;

30.根据所述第二语音数据集、所述第三语音数据集和所述第四语音数据集,生成所述语音合成器。

31.可选的,所述根据所述第二语音数据集、和第一用户的第二语言的第三语音数据集,生成第一用户的混合语言的第四语音数据集,包括:

32.根据所述第二语音数据集、和所述第三语音数据集,生成第一用户的语音合成器;

33.确定第二多语言混合文本集;

34.针对各个第二多语言混合文本,通过第一用户的语音合成器包括的文本输入模块,确定所述第二多语言混合文本的发音单元序列,其中不同语言的文本片段的发音单元为相应语言的发音单元;

35.通过第一用户的语音合成器包括的声学特征合成网络,根据所述发音单元序列,确定具有第一用户音色的声学特征序列;

36.通过第一用户的语音合成器包括的声码器,根据声学特征序列,生成与所述第二多语言混合文本对应的第一用户的语音合成数据;

37.根据与所述第二多语言混合文本对应的第一用户的语音合成数据,确定所述第四语音数据集。

38.可选的,所述第一用户的语音合成器包括:基于transformer模型的语音合成器;

39.所述根据所述第二语音数据集、所述第三语音数据集和所述第四语音数据集,生成所述语音合成器,包括:

40.生成所述声学特征合成网络;

41.所述生成所述声学特征合成网络,包括:

42.根据所述第四语音数据集,优化基于transformer模型的声学特征合成网络。

43.可选的,所述根据所述第二语音数据集、所述第三语音数据集和所述第四语音数据集,生成所述语音合成器,包括:

44.生成所述声学特征合成网络;

45.所述生成所述声学特征合成网络,包括:

46.根据所述第二语音数据集、第三语音数据集和所述第四语音数据集,生成基于tacotron2模型或者fastspeech模型的声学特征合成网络。

47.可选的,所述根据所述第二语音数据集、和第一用户的第二语言的第三语音数据集,生成第一用户的具有多语言能力的语音合成器,包括:

48.根据所述第三语音数据集,生成所述声码器。

49.可选的,所述跨语言语音转换算法包括:基于语音后验概率图谱ppg的跨语言语音转换算法。

50.本技术还提供一种语音交互方法,包括:

51.通过跨语言语音转换算法,根据至少一种第一语言的第一语音数据集,生成具有目标用户音色的目标用户的第一语言的第二语音数据集;

52.根据所述第二语音数据集、和目标用户的第二语言的第三语音数据集,生成目标用户的具有多语言能力的语音合成器;

53.针对客户端发送的用户语音数据,确定与用户语音数据对应的相同语言的应答文本;

54.通过所述语音合成器,生成与应答文本对应的应答语音数据。

55.本技术还提供一种语音交互方法,包括:

56.采集用户语音数据,向服务端发送用户语音数据;

57.播放服务端回送的应答语音数据;所述应答语音数据采用如下方式确定:服务端通过跨语言语音转换算法,根据至少一种第一语言的第一语音数据集,生成具有目标用户音色的目标用户的第一语言的第二语音数据集;根据所述第二语音数据集、和目标用户的第二语言的第三语音数据集,生成目标用户的具有多语言能力的语音合成器;以及,确定与用户语音数据对应的相同语言的应答文本;通过所述语音合成器,生成与应答文本对应的应答语音数据。

58.本技术还提供一种在线文本语音合成方法,包括:

59.向服务端发送针对目标多语言混合文本的第一用户语音合成请求,以使得服务端通过跨语言语音转换算法,根据第二用户的第一语言的第一语音数据集,生成具有第一用户音色的第一用户的第一语言的第二语音数据集;根据所述第二语音数据集、和第一用户的第二语言的第三语音数据集,生成第一用户的具有多语言能力的语音合成器;以及,通过所述语音合成器,生成与所述混合文本对应的语音合成数据。

60.本技术还提供一种新闻播报方法,包括:

61.通过跨语言语音转换算法,根据至少一个第一语言的第一语音数据集,生成具有目标用户音色的至少一个第一语言的第二语音数据集;

62.根据所述第二语音数据集、和目标用户的第二语言的第三语音数据集,生成目标用户的具有多语言能力的语音合成器;

63.针对客户端发送的用多语种播报文本的请求,通过所述语音合成器,生成由目标用户播报的与待播报文本对应的多语种语音数据。

64.本技术还提供一种新闻播报方法,包括:

65.向服务端发送用多语种播报文本的请求;

66.播放服务端回送的由目标用户播报的与待播报文本对应的多语种语音数据;所述多语种语音数据采用如下方式生成:服务端通过跨语言语音转换算法,根据至少一个第一语言的第一语音数据集,生成具有目标用户音色的至少一个第一语言的第二语音数据集;根据所述第二语音数据集、和目标用户的第二语言的第三语音数据集,生成目标用户的具有多语言能力的语音合成器;以及,通过所述语音合成器,生成由目标用户播报的与待播报文本对应的多语种语音数据。

67.本技术还提供一种语音合成器构建方法,包括:

68.通过跨语言语音转换算法,根据至少一个第二用户的至少一种第一语言的第一语音数据集,生成具有第一用户音色的第一语言的第二语音数据集;

69.根据所述第二语音数据集、和第一用户的第二语言的第三语音数据集,生成第一用户的具有多语言能力的语音合成器。

70.本技术还提供一种跨语言语音生成方法,包括:

71.确定待处理文本,向服务端发送由第一用户朗读所述文本的语音生成请求;

72.播放服务端回送的第一用户朗读所述文本的语音数据;所述待处理文本包括第一语言的文本、或者第一语言和第二语言混合的文本,所述第一用户的母语为第二语言。

73.本技术还提供一种跨方言语音生成系统,包括:

74.终端设备,用于确定待处理文本,向服务端发送由第一用户用第一方言朗读所述文本的语音生成请求;以及,播放服务端回送的第一用户用第一方言朗读所述文本的第一语音数据;

75.服务端,用于通过跨方言语音转换算法,根据第二用户的第一方言的第二语音数据集,生成具有第一用户音色的第一方言的第三语音数据集;根据所述第三语音数据集、和第一用户的第二方言的第四语音数据集,生成第一用户的具有多方言能力的语音合成器;以及,针对所述请求,通过所述语音合成器,生成第一语音数据。

76.本技术还提供一种跨方言语音生成方法,包括:

77.确定待处理文本,向服务端发送由第一用户用第一方言朗读所述文本的语音生成请求;

78.播放服务端回送的第一用户用第一方言朗读所述文本的第一语音数据。

79.本技术还提供一种跨方言语音生成方法,包括:

80.通过跨方言语音转换算法,根据第二用户的第一方言的第二语音数据集,生成具有第一用户音色的第一方言的第三语音数据集;

81.根据所述第三语音数据集、和第一用户的第二方言的第四语音数据集,生成第一用户的具有多方言能力的语音合成器;

82.针对客户端发送的由第一用户用第一方言朗读所述文本的语音生成请求,通过所述语音合成器,生成第一语音数据。

83.本技术还提供一种语音合成器构建方法,包括:

84.通过跨方言语音转换算法,根据第二用户的第一方言的第二语音数据集,生成具有第一用户音色的第一方言的第三语音数据集;

85.根据所述第三语音数据集、和第一用户的第二方言的第四语音数据集,生成第一用户的具有多方言能力的语音合成器。

86.本技术还提供一种语音合成装置,包括:

87.训练数据生成单元,用于通过跨语言语音转换算法,根据第二用户的第一语言的第一语音数据集,生成具有第一用户音色的第一用户的第一语言的第二语音数据集;

88.语音合成器训练单元,用于根据所述第二语音数据集、和第一用户的第二语言的第三语音数据集,生成第一用户的具有多语言能力的语音合成器;

89.语音合成单元,用于通过所述语音合成器,生成与第一多语言混合文本对应的第一用户的语音合成数据。

90.本技术还提供一种电子设备,包括:

91.处理器;以及

92.存储器,用于存储实现语音合成方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:通过跨语言语音转换算法,根据第二用户的第一语言的第一语音数据集,生成具有第一用户音色的第一用户的第一语言的第二语音数据集;根据所述第二语音数据集、和第一用户的第二语言的第三语音数据集,生成第一用户的具有多语言能力的语音合成器;通过所述语音合成器,生成与第一多语言混合文本对应的第一用户的语音合成数据。

93.本技术还提供一种语音合成器构建装置,包括:

94.训练数据生成单元,用于通过跨语言语音转换算法,根据至少一个第二用户的至少一种第一语言的第一语音数据集,生成具有第一用户音色的第一语言的第二语音数据集;

95.语音合成器训练单元,用于根据所述第二语音数据集、和第一用户的第二语言的第三语音数据集,生成第一用户的具有多语言能力的语音合成器。

96.本技术还提供一种电子设备,包括:

97.处理器;以及

98.存储器,用于存储实现语音合成器构建方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:通过跨语言语音转换算法,根据至少一个第二用户的至少一种第一语言的第一语音数据集,生成具有第一用户音色的第一语言的第二语音数据集;根据所述第二语音数据集、和第一用户的第二语言的第三语音数据集,生成第一用户的具有多语言能力的语音合成器。

99.本技术还提供一种语音合成器构建装置,包括:

100.训练数据生成单元,用于通过跨方言语音转换算法,根据第二用户的第二方言的第二语音数据集,生成具有第一用户音色的第一方言的第三语音数据集;

101.语音合成器训练单元,用于根据所述第三语音数据集、和第一用户的第二方言的第四语音数据集,生成第一用户的具有多方言能力的语音合成器。

102.本技术还提供一种电子设备,包括:

103.处理器;以及

104.存储器,用于存储实现语音合成器构建方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:通过跨方言语音转换算法,根据第二用户的第二方言的第二语音数据集,生成具有第一用户音色的第一方言的第三语音数据集;根据所述第三语音数据集、和第一用户的第二方言的第四语音数据集,生成第一用户的具有多方言能力的语音合成器。

105.本技术还提供一种计算机可读存储介质,所述计算机可读存储介质中存储有指令,当其在计算机上运行时,使得计算机执行上述各种方法。

106.本技术还提供一种包括指令的计算机程序产品,当其在计算机上运行时,使得计算机执行上述各种方法。

107.与现有技术相比,本技术具有以下优点:

108.本技术实施例提供的语音合成方法,通过第一用户的跨语言语音转换算法,根据第二用户的第一语言的第一语音数据集,生成具有第一用户音色的第一用户的第一语言的第二语音数据集;根据所述第二语音数据集、和第一用户的第二语言的第三语音数据集,生成第一用户的具有多语言能力的语音合成器;通过所述语音合成器,生成与第一多语言混合文本对应的第一用户的语音合成数据;这种处理方式,使得采用跨语言语音转换技术,生成高质量的具有目标发音人音色的非母语和混合语言数据,与其原本的母语录音数据合并,一同作为训练数据,得到了一个具有双语/多语/混合语言能力的目标说话人音色的语音合成器,避免跨语言及混合语言语音合成中,使用不同语言各自的合成器时相互切换造成的音色不一致,效果不自然的问题;因此,可以有效提升多语种文本的语音合成质量,从

而提升用户体验。此外,该系统使得不再局限于发音人的母语限制,而只关注发音人的音色,只要选定发音人的音色和录制发音人母语录音,就可以把音色扩展到其它语言,对其它语言的任何文本进行语音合成处理。同时,这种处理方式还无需使用音标映射之类的方法来进行语言跨越,避免了音标映射带来的发音不准确甚至错误的问题。此外,这种处理方式还使得仅仅使用不同说话人的单语数据库即可进行系统建设,节省了聘请专业多语发音人带来的高额成本。再者,这种处理方式还使得在不影响本身母语表现的基础上,外语部分的合成效果可以达到逼近外语母语者的发音水平,同时合成的不同语言的语音都很好的保持了目标说话人的音色,因此可以是赋予任何(单语)音色优秀的多语能力。

109.本技术提供的跨方言语音生成系统,通过终端设备用于确定待处理文本,向服务端发送由第一用户用第一方言朗读所述文本的语音生成请求;以及,播放服务端回送的第一用户用第一方言朗读所述文本的第一语音数据;服务端,用于通过跨方言语音转换算法,根据第二用户的第一方言的第二语音数据集,生成具有第一用户音色的第一方言的第三语音数据集;根据所述第三语音数据集、和第一用户的第二方言的第四语音数据集,生成第一用户的具有多方言能力的语音合成器;以及,针对所述请求,通过所述语音合成器,生成第一语音数据;这种处理方式,使得采用跨方言语音转换技术,生成高质量的具有目标发音人音色的某种方言或多种方言混合的语言数据,与其原本的母语方言录音数据合并,一同作为训练数据,得到了一个具有双方言/多方言/混合方言语言能力的目标说话人音色的语音合成器,避免跨方言及混合方言语音合成中,使用不同方言各自的合成器时相互切换造成的音色不一致,效果不自然的问题;因此,可以有效提升多方言文本的语音合成质量,从而提升用户体验。此外,该系统使得不再局限于发音人的母语方言限制,而只关注发音人的音色,只要选定发音人的音色和录制发音人母语方言录音,就可以把音色扩展到其它方言,对其它方言的任何文本进行语音合成处理。此外,这种处理方式还使得仅仅使用不同说话人的单方言数据库即可进行系统建设,节省了聘请专业多方言发音人带来的高额成本。再者,这种处理方式还使得在不影响本身母语方言表现的基础上,其他方言部分的合成效果可以达到逼近方言母语者的发音水平,同时合成的不同方言的语音都很好的保持了目标说话人的音色,因此可以是赋予任何(单方言)音色优秀的多方言能力。

附图说明

110.图1本技术提供的一种语音交互系统的实施例的结构示意图;

111.图2本技术提供的一种语音交互系统的实施例的场景示意图;

112.图3本技术提供的一种语音交互系统的实施例的设备交互示意图;

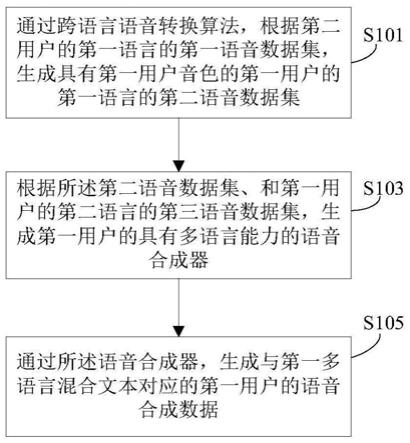

113.图4本技术提供的一种语音合成方法的实施例的流程示意图。

具体实施方式

114.在下面的描述中阐述了很多具体细节以便于充分理解本技术。但是本技术能够以很多不同于在此描述的其它方式来实施,本领域技术人员可以在不违背本技术内涵的情况下做类似推广,因此本技术不受下面公开的具体实施的限制。

115.在本技术中,提供了语音合成方法和装置,在线文本语音合成系统、方法和装置,语音交互系统、方法和装置,新闻播报系统、方法和装置,智能音箱,以及电子设备。在下面

的实施例中逐一对各种方案进行详细说明。

116.第一实施例

117.请参考图1,其为本技术的语音交互系统的实施例的示意图。本实施例提供的语音交互系统包括:服务器1和智能音箱2。

118.服务器1,可以是部署在云端服务器上的服务端,也可以是专用于实现语音交互系统的服务器,可部署在数据中心。

119.智能音箱2,可以是家庭消费者用语音进行上网的一个工具,比如点播歌曲、上网购物,或是了解天气预报,它也可以对智能家居设备进行控制,比如打开窗帘、设置冰箱温度、提前让热水器升温等。

120.请参考图2,其为本技术的语音交互系统的场景示意图。服务端1和智能音箱2间可通过网络连接,如智能音箱2可通过wi fi等方式联网,等等。用户与智能音箱之间通过语音方式进行交互。智能音箱带有对话系统,会面对来自不同地方或者国家的用户,在对话时可以支持用户的语言,如果用户说中文,智能音箱可以用中文对话,如果用户说英文,智能音箱可以用英文对话。用户向智能音箱2下达语音指令数据,服务端可确定与用户语音数据对应的相同语言的应答文本,并通过智能音箱的具有多语言能力的语音合成器,生成与应答文本对应的应答语音数据,该应答语音与音箱用户具有相同的语言。

121.请参考图3,其为本技术的语音交互系统的设备示意图。在本实施例中,智能音箱,用于采集用户语音数据,向服务端发送用户语音数据;以及,播放服务端回送的应答语音数据;服务端,用于通过跨语言语音转换算法,根据至少一种第一语言的第一语音数据集,生成具有目标用户音色的目标用户的第一语言的第二语音数据集;根据所述第二语音数据集、和目标用户的第二语言的第三语音数据集,生成目标用户的具有多语言能力的语音合成器;以及,确定与用户语音数据对应的相同语言的应答文本;通过所述语音合成器,生成与应答文本对应的应答语音数据。

122.例如,智能音箱系统的服务端可先根据目标用户的中文语音数据,生成具有中文语音合成能力的语音合成器,使得该服务端具有中文应答能力,可以用中文与音箱端的用户a进行语音交互;此后,另一个音箱的用户b使用英文与音箱进行语音交互,为了使得服务端具有英文应答能力,可通过跨语言语音转换算法,根据其他用户的英文语音数据(第一语音数据集),生成具有目标用户音色的英文语音数据(第二语音数据集);根据所述第二语音数据集、和目标用户的中文语音数据(第三语音数据集),生成目标用户的具有中英文两种语音合成能力的语音合成器;并在确定与用户b的英文语音数据对应的英文应答文本之后,通过所述语音合成器,生成与英文应答文本对应的英文应答语音数据;此后,又一个音箱的用户c使用法文与音箱进行语音交互,为了使得服务端具有法文应答能力,可通过跨语言语音转换算法,根据其他用户的法文语音数据(第一语音数据集),生成具有目标用户音色的法文语音数据(第二语音数据集);根据目标用户的法文语音数据集、英文语音数据集、和中文语音数据,生成目标用户的具有中、英、法文三种语音合成能力的语音合成器;并在确定与用户c的法文语音数据对应的法文应答文本之后,通过所述语音合成器,生成与法文应答文本对应的法文应答语音数据。

123.服务端具体处理过程详见第二实施例的说明,此处不再赘述。

124.从上述实施例可见,本技术实施例提供的语音交互系统,通过智能音箱采集用户

语音数据,向服务端发送用户语音数据;以及,播放服务端回送的应答语音数据;服务端通过跨语言语音转换算法,根据第一语言的第一语音数据集,生成具有目标用户音色的目标用户的第一语言的第二语音数据集;根据所述第二语音数据集、和目标用户的第二语言的第三语音数据集,生成目标用户的具有多语言能力的语音合成器;以及,确定与用户语音数据对应的相同语言的应答文本;通过所述语音合成器,生成与应答文本对应的应答语音数据;这种处理方式,使得采用跨语言语音转换技术,生成高质量的具有目标发音人音色的非母语和混合语言数据,与其原本的母语录音数据合并,一同作为训练数据,得到了一个具有双语/多语/混合语言能力的目标说话人音色的语音合成器,避免跨语言及混合语言语音合成中,使用不同语言各自的合成器时相互切换造成的音色不一致,效果不自然的问题;因此,可以有效提升多语种文本的语音合成质量,从而提升用户体验。此外,该系统使得不再局限于发音人的母语限制,而只关注发音人的音色,只要选定发音人的音色和录制发音人母语录音,就可以把音色扩展到其它语言,对其它语言的任何文本进行语音合成处理。同时,这种处理方式还无需使用音标映射之类的方法来进行语言跨越,避免了音标映射带来的发音问题。此外,这种处理方式还使得仅仅使用不同说话人的单语数据库即可进行系统建设,节省了聘请专业多语发音人带来的高额成本。再者,这种处理方式还使得在不影响本身母语表现的基础上,外语部分的合成效果可以达到逼近外语母语者的发音水平,同时合成的不同语言的语音都很好的保持了目标说话人的音色,因此可以是赋予任何(单语)音色优秀的多语能力。

125.第二实施例

126.在上述的实施例中,提供了一种语音交互系统,与之相对应的,本技术还提供一种语音合成方法,该方法的执行主体可以是服务器等设备。该方法是与上述系统的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

127.请参考图4,其为本技术的语音合成方法的实施例的流程示意图。在本实施例中,所述方法包括如下步骤:

128.步骤s101:通过第一用户的跨语言语音转换算法,根据第二用户的第一语言的第一语音数据集,生成具有第一用户音色的第一用户的第一语言的第二语音数据集。

129.所述第二用户,可以是第一用户以外的其他多个第二用户,即:第一语音数据集可包括多个第二用户的第一语音数据。

130.所述方法采用跨语言语音转换技术,生成具有目标发音人音色的非母语、混合语言数据,与该用户原本的母语录音数据合并,一同作为训练数据,得到一个具有双语或多语、及混合语言能力的目标说话人音色的语音合成器。

131.在本实施例中,使用两个不同母语的说话人(以一个中文母语者和一个英文母语者为例)的单语言录音,建设每个说话人的中英双语和混合语言的语音合成系统,这样就可以针对上述两个说话人中的任一说话人进行中英双语和混合语言的语音合成任务,也就是可以输入含有中文和英文的文本来合成同一个说话人的对应语音。

132.所述跨语言语音转换算法,包括但不限于:基于语音后验概率图谱ppg的跨语言语音转换算法。具体实施时,也可以采用其它传统的跨语言语音转换算法,如先将源说话人的语音信号转化为相应的文字信息,然后将文字信息结合目标说话人的语音特征信息进行合成,生成具有目标说话人音色的语音信号。由于所述跨语言语音转换算法属于较为成熟的

现有技术,因此此处不再赘述。

133.在本实施例中,采用基于ppg的跨语言语音转换算法,可以生成高质量的具有目标发音人音色的非母语和混合语言数据。该算法可包括如下步骤:1)构建语音后验概率图谱ppg特征提取器、和第一用户的语音合成模型;2)通过所述ppg特征提取器,根据所述第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;所述第一声学特征数据包括第二用户声纹信息和语音内容信息;3)通过第一用户的语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成与第一语音数据对应的第一用户的第一语言的第二语音数据;所述第二声学特征数据包括韵律信息。

134.具体实施时,可以分别使用中英文录音数据,训练出中文说话人和英文说话人各自的跨语言语音转换系统;然后使用中文说话人的跨语言语音转换系统,将英文录音转换获得中文说话人的英文语音;同时,使用英文说话人的跨语言语音转换系统,将中文录音转换获得英文说话人的中文语音。

135.通过步骤s101使用跨语言语音转换技术,生成目标说话人(第一用户)母语以外其它语言的tts训练语料,即第二语音数据集。

136.步骤s103:根据所述第二语音数据集、和第一用户的第二语言的第三语音数据集,生成第一用户的具有多语言能力的语音合成器。

137.本技术实施例提供的所述方法包括训练和语音合成两个阶段,步骤s103为训练阶段,步骤s101为训练数据准备阶段。在训练阶段,可进行中英跨语言语音转换系统(跨语言语音转换算法)的模型训练、和中英双语和混合语言的语音合成系统(语音合成器)中的声学特征合成模块和声码器的训练。

138.在本实施例中,使用中文说话人(第一用户)的中文录音(第三语音数据集),以及通过步骤s101转换获得的其英文语音(第二语音数据集),进行中文说话人的中英双语和混合语言的语音合成器的建设。

139.具体实施时,该语音合成器可包括三个主要模块:文本输入模块(i nput representat ion),声学特征合成网络(synthes i s network),声码器。下面分别对这三个模块进行说明。

140.所述文本输入模块,用于将普通文本转换成以发音单元为单位的序列,如中文发音单元为汉语拼音的声母和韵母,以及声调。英文发音单元为英文音素和轻重音,每个单元以空格分开。另外,可根据单词间语音停顿的长度加入特殊符号表示。模型训练时,文本输入可以是以句子形式进行。

141.所述声码器,用于将声学特征合成模块合成的lpcnet声学特征序列合成waveform形式的语音。声码器,可以是lpcnet声码器,也可以是其它网络的声码器。具体实施时,可根据所述第三语音数据集,生成所述声码器。也就是说,声码器的训练使用目标说话人的原始录音集(母语录音集)即可。

142.所述声学特征合成网络,用于将文本输入模块处理后的发音序列合成lpcnet声学特征序列,该模块可以基于已有的语音合成模型结构,也可以使用其它模型结构设计,如tacotron2、transformer和fastspeech等语音合成模型结构。

143.在一个示例中,根据不包含中英混合文本的训练数据,也即根据第二语音数据集和第三语音数据集,生成第一用户的具有多语言能力的语音合成器。然而,经过实验发现,

仅使用不包含中英混合文本的训练数据,以上三种语音合成模型结构都无法达到非常理想的效果。

144.在另一个示例中,步骤s103可包括如下子步骤:

145.步骤s1031:根据所述第二语音数据集、和所述第三语音数据集,生成第一用户的混合语言的第四语音数据集。

146.所述第四语音数据可包括多种语言的语音,所述第二语音数据和第三语音数据包括单种语言的语音。

147.具体实施时,步骤s1031可包括如下子步骤:

148.步骤s10311:根据所述第二语音数据集、和所述第三语音数据集,生成第一用户的语音合成器。

149.所述语音合成器,可以是基于transformer模型的语音合成器,即:通过transformer系统合成中英混合语音。具体实施时,也可以是基于tacotron2模型或者fastspeech模型的语音合成器。

150.步骤s10313:确定第二多语言混合文本集;

151.步骤s10315:针对各个第二多语言混合文本,通过第一用户的语音合成器包括的文本输入模块,确定所述第二多语言混合文本的发音单元序列,其中不同语言的文本片段的发音单元为相应语言的发音单元;

152.步骤s10317:通过第一用户的语音合成器包括的声学特征合成网络,根据所述发音单元序列,确定具有第一用户音色的声学特征序列;

153.步骤s10319:通过第一用户的语音合成器包括的声码器,根据声学特征序列,生成与所述第二多语言混合文本对应的第一用户的语音合成数据;

154.步骤s10310:根据与所述第二多语言混合文本对应的第一用户的语音合成数据,确定所述第四语音数据集。

155.在本实施例中,基于中文说话人的中文录音和通过转换获得的英文语音,以及基于transformer模型的语音合成系统(语音合成器),对训练数据进行了扩充。首先,使用中文说话人的中文录音和通过转换获得的英文语音的训练集,训练了基于transformer模型的语音合成系统;然后,准备了1万句以上的中英混合文本(第二多语言混合文本集),使用上述过程和基于transformer模型的语音合成系统,把中英混合文本合成中英混合语音;然后,从合成的中英混合语音通过人工筛检,选出准确的语音结果(第四语音数据集)作为新的训练集,把筛检出的新的中英混合训练集加入到中文说话人的中文录音和通过转换获得的英文语音的训练集。

156.通过步骤s1031生成第四语音数据集后,就可以进入步骤s1033,使用该扩充后的训练集训练语音合成器。

157.步骤s1033:根据所述第二语音数据集、所述第三语音数据集和所述第四语音数据集,生成所述语音合成器。

158.采用这种处理方式,声学特征合成网络的训练需要三部分的数据集:1)目标说话人的原始录音(第三语音数据集);2)通过跨语言语音转换获得的语音(第二语音数据集);3)中英混合语音(第四语音数据集)。

159.具体实施时,步骤s1033可包括如下子步骤:生成所述声学特征合成网络;所述生

成所述声学特征合成网络,可采用如下方式实现:根据所述第二语音数据集、第三语音数据集和所述第四语音数据集,生成基于transformer模型、tacotron2模型或者fastspeech等模型的声学特征合成网络。

160.在本实施例中,步骤s1033中所述生成所述声学特征合成网络,包括:根据所述第四语音数据集,优化步骤s1031中训练得到的基于transformer模型的声学特征合成网络。采用这种transformer系统,可首先基于第一二部分的训练集(所述第二语音数据集和第三语音数据集)进行第一遍训练,然后加入第三部分的训练集(所述第四语音数据集)进行优化训练,因此可以有效提升语音合成器的构建效率。

161.具体实施时,诸如tacotron2和fastspeech系统可使用第一二三部分的训练集一次性进行训练。在本实施例中,分别使用了基于tacotron2,transformer和fastspeech三种语音合成模型结构,都取得了理想的效果。

162.在本实施例中,还可使用英文说话人的英文录音、及通过转换获得的其中文语音,进行英文说话人的中英双语和混合语言的语音合成系统建设,该过程和上述进行中文说话人的中英双语和混合语言的语音合成系统建设所述的过程相同,因此不再赘述。

163.通过步骤s103完成训练阶段后,该系统可以被用来进行第二阶段的合成任务。

164.步骤s105:通过所述语音合成器,生成与第一多语言混合文本对应的第一用户的语音合成数据。

165.在一个示例中,步骤s105可包括如下子步骤:通过所述语音合成器包括的文本输入模块,确定所述第一多语言混合文本的发音单元序列,其中不同语言的文本片段(如“我很happy”包括一个中文片段“我很”和一个英文片段“happy”)的发音单元为相应语言的发音单元;通过所述语音合成器包括的声学特征合成网络,根据所述发音单元序列,确定具有第一用户音色的声学特征序列;通过所述语音合成器包括的声码器,根据声学特征序列,生成所述语音合成数据。其中,所述语音合成器中各模块的处理方式详见步骤s103,此处不再赘述。

166.例如,给定一段纯中文,纯英文或者中英混文本,输入到文本输入模块,生成声学特征合成网络的输入序列,然后声学特征合成网络生成lpcnet声学特征序列,lpcnet声码器将lpcnet声学特征序列合成waveform语音(所述语音合成数据)进行播放。

167.所述中文发音单元,包括但不限于:汉语拼音的声母和韵母,以及声调;所述英文发音单元,包括但不限于:英文音素和轻重音。其中,英文发音单元序列可采用如下方式确定:在发音单元之间插入空格,并根据单词间语音停顿长度,插入标点符号。

168.需要说明的是,所述方法中的三个模块:文本输入模块,声学特征合成网络,lpcnet声码器均可以使用其他解决方案。文本输入模块可以选用输出其他的发音序列,如使用byte序列或者i pa序列,声学特征合成网络可以使用其它模型结构,lpcnet的替代方案包括wavenet、wavernn等。

169.从上述实施例可见,本技术实施例提供的语音合成方法,通过第一用户的跨语言语音转换算法,根据第二用户的第一语言的第一语音数据集,生成具有第一用户音色的第一用户的第一语言的第二语音数据集;根据所述第二语音数据集、和第一用户的第二语言的第三语音数据集,生成第一用户的具有多语言能力的语音合成器;通过所述语音合成器,生成与第一多语言混合文本对应的第一用户的语音合成数据;这种处理方式,使得采用跨

语言语音转换技术,生成高质量的具有目标发音人音色的非母语和混合语言数据,与其原本的母语录音数据合并,一同作为训练数据,得到了一个具有双语/多语/混合语言能力的目标说话人音色的语音合成器,避免跨语言及混合语言语音合成中,使用不同语言各自的合成器时相互切换造成的音色不一致,效果不自然的问题;因此,可以有效提升多语种文本的语音合成质量,从而提升用户体验。此外,该系统使得不再局限于发音人的母语限制,而只关注发音人的音色,只要选定发音人的音色和录制发音人母语录音,就可以把音色扩展到其它语言,对其它语言的任何文本进行语音合成处理。同时,这种处理方式还无需使用音标映射之类的方法来进行语言跨越,避免了音标映射带来的发音问题。此外,这种处理方式还使得仅仅使用不同说话人的单语数据库即可进行系统建设,节省了聘请专业多语发音人带来的高额成本。再者,这种处理方式还使得在不影响本身母语表现的基础上,外语部分的合成效果可以达到逼近外语母语者的发音水平,同时合成的不同语言的语音都很好的保持了目标说话人的音色,因此可以是赋予任何(单语)音色优秀的多语能力。

170.第三实施例

171.在上述的实施例中,提供了一种语音合成方法,与之相对应的,本技术还提供一种语音合成装置。该装置是与上述方法的实施例相对应。本实施例与第二实施例内容相同的部分不再赘述,请参见实施例二中的相应部分。

172.本技术提供的一种语音合成装置包括:

173.训练数据生成单元,用于通过跨语言语音转换算法,根据第二用户的第一语言的第一语音数据集,生成具有第一用户音色的第一用户的第一语言的第二语音数据集;

174.语音合成器训练单元,用于根据所述第二语音数据集、和第一用户的第二语言的第三语音数据集,生成第一用户的具有多语言能力的语音合成器;

175.语音合成单元,用于通过所述语音合成器,生成与第一多语言混合文本对应的第一用户的语音合成数据。

176.第四实施例

177.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

178.本实施例的一种电子设备,该电子设备包括:传声器,处理器和存储器;存储器,用于存储实现语音合成方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:通过跨语言语音转换算法,根据第二用户的第一语言的第一语音数据集,生成具有第一用户音色的第一用户的第一语言的第二语音数据集;根据所述第二语音数据集、和第一用户的第二语言的第三语音数据集,生成第一用户的具有多语言能力的语音合成器;通过所述语音合成器,生成与第一多语言混合文本对应的第一用户的语音合成数据。

179.所述电子设备,可以是智能音箱,点餐机,售卖机,售票机,聊天机器人,等等。

180.第五实施例

181.在上述的实施例中,提供了一种语音交互系统,与之相对应的,本技术还提供一种语音交互方法,该方法的执行主体可以是服务端等等。该方法是与上述系统的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

182.本技术提供的一种语音交互方法,可包括如下步骤:

183.步骤1:通过跨语言语音转换算法,根据至少一种第一语言的第一语音数据集,生成具有目标用户音色的目标用户的第一语言的第二语音数据集;

184.步骤2:根据所述第二语音数据集、和目标用户的第二语言的第三语音数据集,生成目标用户的具有多语言能力的语音合成器;

185.步骤3:针对客户端发送的用户语音数据,确定与用户语音数据对应的相同语言的应答文本;

186.步骤4:通过所述语音合成器,生成与应答文本对应的应答语音数据。

187.第六实施例

188.在上述的实施例中,提供了一种语音交互方法,与之相对应的,本技术还提供一种语音交互装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

189.本技术提供的一种语音交互装置包括:

190.训练数据生成单元,用于通过跨语言语音转换算法,根据至少一种第一语言的第一语音数据集,生成具有目标用户音色的目标用户的第一语言的第二语音数据集;

191.语音合成器训练单元,用于根据所述第二语音数据集、和目标用户的第二语言的第三语音数据集,生成目标用户的具有多语言能力的语音合成器;

192.应答文本确定单元,用于针对客户端发送的用户语音数据,确定与用户语音数据对应的相同语言的应答文本;

193.语音合成单元,用于通过所述语音合成器,生成与应答文本对应的应答语音数据。

194.第七实施例

195.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

196.本实施例的一种电子设备,该电子设备包括:处理器和存储器;存储器,用于存储实现语音交互方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:通过跨语言语音转换算法,根据至少一种第一语言的第一语音数据集,生成具有目标用户音色的目标用户的第一语言的第二语音数据集;

197.根据所述第二语音数据集、和目标用户的第二语言的第三语音数据集,生成目标用户的具有多语言能力的语音合成器;

198.针对客户端发送的用户语音数据,确定与用户语音数据对应的相同语言的应答文本;

199.通过所述语音合成器,生成与应答文本对应的应答语音数据。

200.第八实施例

201.在上述的实施例中,提供了一种语音交互系统,与之相对应的,本技术还提供一种语音交互方法,该方法的执行主体可以是终端设备等。该方法是与上述系统的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

202.本技术提供的一种语音交互方法,可包括如下步骤:

203.步骤1:采集用户语音数据,向服务端发送用户语音数据;

204.步骤2:播放服务端回送的应答语音数据;所述应答语音数据采用如下方式确定:

服务端通过跨语言语音转换算法,根据至少一种第一语言的第一语音数据集,生成具有目标用户音色的目标用户的第一语言的第二语音数据集;根据所述第二语音数据集、和目标用户的第二语言的第三语音数据集,生成目标用户的具有多语言能力的语音合成器;以及,确定与用户语音数据对应的相同语言的应答文本;通过所述语音合成器,生成与应答文本对应的应答语音数据。

205.第九实施例

206.在上述的实施例中,提供了一种语音交互方法,与之相对应的,本技术还提供一种语音交互装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

207.本技术提供的一种语音交互装置包括:

208.语音采集单元,用于采集用户语音数据,向服务端发送用户语音数据;

209.语音播放单元,用于播放服务端回送的应答语音数据;所述应答语音数据采用如下方式确定:服务端通过跨语言语音转换算法,根据至少一种第一语言的第一语音数据集,生成具有目标用户音色的目标用户的第一语言的第二语音数据集;根据所述第二语音数据集、和目标用户的第二语言的第三语音数据集,生成目标用户的具有多语言能力的语音合成器;以及,确定与用户语音数据对应的相同语言的应答文本;通过所述语音合成器,生成与应答文本对应的应答语音数据。

210.第十实施例

211.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

212.本实施例的一种电子设备,该电子设备包括:传声器,处理器和存储器;存储器,用于存储实现语音交互方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:采集用户语音数据,向服务端发送用户语音数据;播放服务端回送的应答语音数据;所述应答语音数据采用如下方式确定:服务端通过跨语言语音转换算法,根据至少一种第一语言的第一语音数据集,生成具有目标用户音色的目标用户的第一语言的第二语音数据集;根据所述第二语音数据集、和目标用户的第二语言的第三语音数据集,生成目标用户的具有多语言能力的语音合成器;以及,确定与用户语音数据对应的相同语言的应答文本;通过所述语音合成器,生成与应答文本对应的应答语音数据。

213.所述电子设备,包括但不限于:智能音箱,智能手机,自动售货机,自动点餐机,等等。

214.第十一实施例

215.在上述的实施例中,提供了一种语音交互系统,与之相对应的,本技术还提供一种在线文本语音合成交互系统。该交互系统是与上述系统的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

216.本技术提供的一种在线文本语音合成交互系统,包括:终端设备和服务端。

217.其中,终端设备用于向服务端发送针对目标多语言混合文本的第一用户语音合成请求;服务端用于通过跨语言语音转换算法,根据第二用户的第一语言的第一语音数据集,生成具有第一用户音色的第一用户的第一语言的第二语音数据集;根据所述第二语音数据

集、和第一用户的第二语言的第三语音数据集,生成第一用户的具有多语言能力的语音合成器;以及,通过所述语音合成器,生成与所述混合文本对应的语音合成数据。

218.例如,第一用户的母语为中文,该用户并不会说英语,因此无法直接获得该用户的英语语音数据集,也就无法直接生成该用户的具有中英文双语语音合成能力的语音合成器;而采用本技术实施例提供的所述系统,可根据第二用户的英语语音数据集,通过跨语言语音转换算法,自动生成第一用户的英语语音数据集,并根据中、英文语音数据集,生成第一用户的具有中英文混合语音合成能力的语音合成器;然后,针对终端设备的对多语种混合文本进行语音合成的需求,可通过该语音合成器,生成对应的中英文混合语音数据。

219.从上述实施例可见,本技术提供的在线文本语音合成交互系统,通过终端设备向服务端发送针对目标多语言混合文本的第一用户语音合成请求;服务端用于通过跨语言语音转换算法,根据第二用户的第一语言的第一语音数据集,生成具有第一用户音色的第一用户的第一语言的第二语音数据集;根据所述第二语音数据集、和第一用户的第二语言的第三语音数据集,生成第一用户的具有多语言能力的语音合成器;以及,通过所述语音合成器,生成与所述混合文本对应的语音合成数据;这种处理方式,使得采用跨语言语音转换技术,生成高质量的具有目标发音人音色的非母语和混合语言数据,与其原本的母语录音数据合并,一同作为训练数据,得到了一个具有双语/多语/混合语言能力的目标说话人音色的语音合成器,避免跨语言及混合语言语音合成中,使用不同语言各自的合成器时相互切换造成的音色不一致,效果不自然的问题;因此,可以有效提升多语种文本的语音合成质量,从而提升用户体验。此外,该系统使得不再局限于发音人的母语限制,而只关注发音人的音色,只要选定发音人的音色和录制发音人母语录音,就可以把音色扩展到其它语言,对其它语言的任何文本进行语音合成处理。同时,这种处理方式还无需使用音标映射之类的方法来进行语言跨越,避免了音标映射带来的发音不准确甚至错误的问题。此外,这种处理方式还使得仅仅使用不同说话人的单语数据库即可进行系统建设,节省了聘请专业多语发音人带来的高额成本。再者,这种处理方式还使得在不影响本身母语表现的基础上,外语部分的合成效果可以达到逼近外语母语者的发音水平,同时合成的不同语言的语音都很好的保持了目标说话人的音色,因此可以是赋予任何(单语)音色优秀的多语能力。

220.第十二实施例

221.在上述的实施例中,提供了一种在线文本语音合成交互系统,与之相对应的,本技术还提供一种在线文本语音合成交互方法,该方法的执行主体可以是服务端等等。该方法是与上述系统的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

222.本技术提供的一种在线文本语音合成交互方法,可包括如下步骤:向服务端发送针对目标多语言混合文本的第一用户语音合成请求,以使得服务端通过跨语言语音转换算法,根据第二用户的第一语言的第一语音数据集,生成具有第一用户音色的第一用户的第一语言的第二语音数据集;根据所述第二语音数据集、和第一用户的第二语言的第三语音数据集,生成第一用户的具有多语言能力的语音合成器;以及,通过所述语音合成器,生成与所述混合文本对应的语音合成数据。

223.第十三实施例

224.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述

得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

225.本实施例的一种电子设备,该电子设备包括:传声器,处理器和存储器;存储器,用于存储实现在线文本语音合成交互方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:向服务端发送针对目标多语言混合文本的第一用户语音合成请求,以使得服务端通过跨语言语音转换算法,根据第二用户的第一语言的第一语音数据集,生成具有第一用户音色的第一用户的第一语言的第二语音数据集;根据所述第二语音数据集、和第一用户的第二语言的第三语音数据集,生成第一用户的具有多语言能力的语音合成器;以及,通过所述语音合成器,生成与所述混合文本对应的语音合成数据。

226.第十四实施例

227.在上述的实施例中,提供了一种语音交互系统,与之相对应的,本技术还提供一种新闻播报系统。该交互系统是与上述系统的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

228.本技术提供的一种新闻播报系统,包括:终端设备和服务端。

229.其中,终端设备用于向服务端发送用多语种播报文本的请求;播放服务端回送的由目标用户播报的与待播报文本对应的多语种语音数据;服务端,用于通过跨语言语音转换算法,根据至少一个第一语言的第一语音数据集,生成具有目标用户音色的至少一个第一语言的第二语音数据集;根据所述第二语音数据集、和目标用户的第二语言的第三语音数据集,生成目标用户的具有多语言能力的语音合成器;以及,通过所述语音合成器,生成由目标用户播报的与待播报文本对应的多语种语音数据。

230.所述待播报文本,可以是多个语种混合的文本,即一段文本内包括多个语言的文字,如“我很happy”;相应的,多语种语音数据为混合语种的语音数据。所述待播报文本,也可以是一个文本的多个语种版本,如英文版、法文本等,如“我很高兴”、“i’m very happy”;相应的,多语种语音数据为多个语种的语音数据。

231.例如,某个主持人要播报一条新闻的多个语言版本,包括中文、英文、德文、越南语等,但该主持人只会说中文和英文,现有技术仅根据该主持人自身的中、英文语音数据,训练生成中文语音合成器和英文语音合成器,却无法生成一个中、英、德、越南语多语种混合的语音合成器;而通过本技术实施例提供的所述系统,可搜集其他用户的其它各语种的语音数据,通过跨语言语音转换算法,根据其他用户的中、英文以外其它各语种的语音数据集,生成具有该主持人音色的其它各语种的语音数据集;根据该主持人音色的其它各语种的语音数据集、和该主持人的中文语音数据集和英文语音数据集,生成该主持人的具有多语言能力的语音合成器,这是一个不同语种通用的语音合成器,通过该语音合成器,可生成由该主持人播报的与待播报新闻对应的多语种语音数据,如生成该新闻的中文语音、英文语音、德语音文、越南语音等。

232.再例如,某个主持人要播报一条包括中文、英文、德文三种文字的新闻,但该主持人只会说中文和英文,不会读或读不好其中的德文,现有技术仅根据该主持人自身的中、英文语音数据,训练生成中文语音合成器和英文语音合成器,却无法生成一个中、英、德多语种混合的语音合成器;而通过本技术实施例提供的所述系统,可搜集其他用户的德语语音数据,通过跨语言语音转换算法,根据其他用户的德语语音数据集,生成具有该主持人音色

的德语语音数据集;根据该主持人音色的德语语音数据集、和该主持人的中文语音数据集和英文语音数据集,生成该主持人的具有中、英、德混合语言能力的语音合成器,该语音合成器即可以合成中文语音数据,也可以合成英文语音数据,还可以合成德文语音数据,又可以合成这三种语言混合的语音数据;通过该语音合成器,可生成由该主持人播报的与该条包括中文、英文、德文三种文字的新闻对应的混合语言的语音数据。

233.从上述实施例可见,本技术提供的新闻播报系统,通过终端设备向服务端发送用多语种播报文本的请求;播放服务端回送的由目标用户播报的与待播报文本对应的多语种语音数据;服务端通过跨语言语音转换算法,根据至少一个第一语言的第一语音数据集,生成具有目标用户音色的至少一个第一语言的第二语音数据集;根据所述第二语音数据集、和目标用户的第二语言的第三语音数据集,生成目标用户的具有多语言能力的语音合成器;以及,通过所述语音合成器,生成由目标用户播报的与待播报文本对应的多语种语音数据;这种处理方式,使得采用跨语言语音转换技术,生成高质量的具有目标发音人音色的非母语和混合语言数据,与其原本的母语录音数据合并,一同作为训练数据,得到了一个具有双语/多语/混合语言能力的目标说话人音色的语音合成器,避免跨语言及混合语言语音合成中,使用不同语言各自的合成器时相互切换造成的音色不一致,效果不自然的问题;因此,可以有效提升多语种文本的语音合成质量,从而提升用户体验。此外,该系统使得不再局限于发音人的母语限制,而只关注发音人的音色,只要选定发音人的音色和录制发音人母语录音,就可以把音色扩展到其它语言,对其它语言的任何文本进行语音合成处理。同时,这种处理方式还无需使用音标映射之类的方法来进行语言跨越,避免了音标映射带来的发音不准确甚至错误的问题。此外,这种处理方式还使得仅仅使用不同说话人的单语数据库即可进行系统建设,节省了聘请专业多语发音人带来的高额成本。再者,这种处理方式还使得在不影响本身母语表现的基础上,外语部分的合成效果可以达到逼近外语母语者的发音水平,同时合成的不同语言的语音都很好的保持了目标说话人的音色,因此可以是赋予任何(单语)音色优秀的多语能力。

234.第十五实施例

235.在上述的实施例中,提供了一种新闻播报系统,与之相对应的,本技术还提供一种新闻播报方法,该方法的执行主体可以是服务端等等。该方法是与上述系统的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

236.本技术提供的一种新闻播报方法,可包括如下步骤:

237.步骤1:通过跨语言语音转换算法,根据至少一个第一语言的第一语音数据集,生成具有目标用户音色的至少一个第一语言的第二语音数据集;

238.步骤2:根据所述第二语音数据集、和目标用户的第二语言的第三语音数据集,生成目标用户的具有多语言能力的语音合成器;

239.步骤3:针对客户端发送的用多语种播报文本的请求,通过所述语音合成器,生成由目标用户播报的与待播报文本对应的多语种语音数据。

240.第十六实施例

241.在上述的实施例中,提供了一种新闻播报方法,与之相对应的,本技术还提供一种新闻播报装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

242.本技术提供的一种新闻播报装置包括:

243.训练数据生成单元,用于通过跨语言语音转换算法,根据至少一个第一语言的第一语音数据集,生成具有目标用户音色的至少一个第一语言的第二语音数据集;

244.语音合成器训练单元,用于根据所述第二语音数据集、和目标用户的第二语言的第三语音数据集,生成目标用户的具有多语言能力的语音合成器;

245.语音合成单元,用于针对客户端发送的用多语种播报文本的请求,通过所述语音合成器,生成由目标用户播报的与待播报文本对应的多语种语音数据。

246.第十七实施例

247.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

248.本实施例的一种电子设备,该电子设备包括:传声器,处理器和存储器;存储器,用于存储实现新闻播报方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:通过跨语言语音转换算法,根据至少一个第一语言的第一语音数据集,生成具有目标用户音色的至少一个第一语言的第二语音数据集;根据所述第二语音数据集、和目标用户的第二语言的第三语音数据集,生成目标用户的具有多语言能力的语音合成器;针对客户端发送的用多语种播报文本的请求,通过所述语音合成器,生成由目标用户播报的与待播报文本对应的多语种语音数据。

249.第十八实施例

250.在上述的实施例中,提供了一种新闻播报系统,与之相对应的,本技术还提供一种新闻播报方法,该方法的执行主体可以终端设备等等。该方法是与上述系统的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

251.本技术提供的一种新闻播报方法,可包括如下步骤:

252.步骤1:向服务端发送用多语种播报文本的请求;

253.步骤2:播放服务端回送的由目标用户播报的与待播报文本对应的多语种语音数据;所述多语种语音数据采用如下方式生成:服务端通过跨语言语音转换算法,根据至少一个第一语言的第一语音数据集,生成具有目标用户音色的至少一个第一语言的第二语音数据集;根据所述第二语音数据集、和目标用户的第二语言的第三语音数据集,生成目标用户的具有多语言能力的语音合成器;以及,通过所述语音合成器,生成由目标用户播报的与待播报文本对应的多语种语音数据。

254.第十九实施例

255.在上述的实施例中,提供了一种新闻播报方法,与之相对应的,本技术还提供一种新闻播报装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

256.本技术提供的一种新闻播报装置包括:

257.请求发送单元,用于向服务端发送用多语种播报文本的请求;

258.语音播放单元,用于播放服务端回送的由目标用户播报的与待播报文本对应的多语种语音数据;所述多语种语音数据采用如下方式生成:服务端通过跨语言语音转换算法,根据至少一个第一语言的第一语音数据集,生成具有目标用户音色的至少一个第一语言的

第二语音数据集;根据所述第二语音数据集、和目标用户的第二语言的第三语音数据集,生成目标用户的具有多语言能力的语音合成器;以及,通过所述语音合成器,生成由目标用户播报的与待播报文本对应的多语种语音数据。

259.第二十实施例

260.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

261.本实施例的一种电子设备,该电子设备包括:传声器,处理器和存储器;存储器,用于存储实现新闻播报方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:向服务端发送用多语种播报文本的请求;播放服务端回送的由目标用户播报的与待播报文本对应的多语种语音数据;所述多语种语音数据采用如下方式生成:服务端通过跨语言语音转换算法,根据至少一个第一语言的第一语音数据集,生成具有目标用户音色的至少一个第一语言的第二语音数据集;根据所述第二语音数据集、和目标用户的第二语言的第三语音数据集,生成目标用户的具有多语言能力的语音合成器;以及,通过所述语音合成器,生成由目标用户播报的与待播报文本对应的多语种语音数据。

262.第二十一实施例

263.在上述的实施例中,提供了一种语音合成方法,与之相对应的,本技术还提供一种语音合成器构建方法,该方法的执行主体可以终端设备等等。该方法是与上述系统的实施例相对应。本实施例与第二实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

264.本技术提供的一种语音合成器构建方法,可包括如下步骤:

265.步骤1:通过跨语言语音转换算法,根据至少一个第二用户的至少一种第一语言的第一语音数据集,生成具有第一用户音色的第一语言的第二语音数据集;

266.步骤2:根据所述第二语音数据集、和第一用户的第二语言的第三语音数据集,生成第一用户的具有多语言能力的语音合成器。

267.第二十二实施例

268.在上述的实施例中,提供了一种语音合成器构建方法,与之相对应的,本技术还提供一种语音合成器构建装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

269.本技术提供的一种语音合成器构建装置包括:

270.训练数据生成单元,用于通过跨语言语音转换算法,根据至少一个第二用户的至少一种第一语言的第一语音数据集,生成具有第一用户音色的第一语言的第二语音数据集;

271.语音合成器训练单元,用于根据所述第二语音数据集、和第一用户的第二语言的第三语音数据集,生成第一用户的具有多语言能力的语音合成器。

272.第二十三实施例

273.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

274.本实施例的一种电子设备,该电子设备包括:传声器,处理器和存储器;存储器,用于存储实现语音合成器构建方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:通过跨语言语音转换算法,根据至少一个第二用户的至少一种第一语言的第一语音数据集,生成具有第一用户音色的第一语言的第二语音数据集;根据所述第二语音数据集、和第一用户的第二语言的第三语音数据集,生成第一用户的具有多语言能力的语音合成器。

275.第二十四实施例

276.在上述的实施例中,提供了一种语音合成方法,与之相对应的,本技术还提供一种跨语言语音生成方法,该方法的执行主体可以终端设备等等。该方法是与上述系统的实施例相对应。本实施例与第二实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

277.本技术提供的一种跨语言语音生成方法,可包括如下步骤:

278.步骤1:确定待处理文本,向服务端发送由第一用户朗读所述文本的语音生成请求。

279.步骤2:播放服务端回送的第一用户朗读所述文本的第一语音数据;所述待处理文本包括第一语言的文本、或者第一语言和第二语言混合的文本,所述第一用户的母语为第二语言。

280.例如,第一用户要读一段英文文本,但该用户是一个不会说英语或英语说的不好的中国人,为了达到该第一用户流利说英文的效果,第一用户可通过终端设备确定待朗读的英文文本,向服务端发送由第一用户朗读该英文文本的语音生成请求;服务端可通过上述实施例二提供的语音合成方法,生成第一用户朗读该英文文本的语音数据,好像该第一用户具有较好的英语水平。

281.从上述实施例可见,本技术实施例提供的跨语言语音生成方法,通过终端设备确定待处理文本,向服务端发送由第一用户朗读所述文本的语音生成请求;播放服务端回送的第一用户朗读所述文本的语音数据;所述待处理文本包括第一语言的文本、或者第一语言和第二语言混合的文本,所述第一用户的母语为第二语言;这种处理方式,使得即使第一用户不具有某语种的文本阅读能力,也能够生成第一用户朗读该语种文本的语音数据,实现跨语言的文本朗读。

282.第二十五实施例

283.在上述的实施例中,提供了一种跨语言语音生成方法,与之相对应的,本技术还提供一种跨语言语音生成装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

284.本技术提供的一种跨语言语音生成装置包括:

285.文本确定单元,用于确定待处理文本,向服务端发送由第一用户朗读所述文本的语音生成请求;

286.语音播放单元,用于播放服务端回送的第一用户朗读所述文本的语音数据;所述待处理文本包括第一语言的文本、或者第一语言和第二语言混合的文本,所述第一用户的母语为第二语言。

287.第二十六实施例

288.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

289.本实施例的一种电子设备,该电子设备包括:传声器,处理器和存储器;存储器,用于存储实现跨语言语音生成方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:确定待处理文本,向服务端发送由第一用户朗读所述文本的语音生成请求;播放服务端回送的第一用户朗读所述文本的语音数据;所述待处理文本包括第一语言的文本、或者第一语言和第二语言混合的文本,所述第一用户的母语为第二语言。

290.第二十七实施例

291.在上述的实施例中,提供了一种语音交互系统,与之相对应的,本技术还提供一种跨方言语音生成系统。该交互系统是与上述系统的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

292.本技术提供的一种跨方言语音生成系统,包括:终端设备和服务端。

293.其中,终端设备用于确定待处理文本,向服务端发送由第一用户用第一方言朗读所述文本的语音生成请求;以及,播放服务端回送的第一用户用第一方言朗读所述文本的第一语音数据;服务端,用于通过跨方言语音转换算法,根据第二用户的第一方言的第二语音数据集,生成具有第一用户音色的第一方言的第三语音数据集;根据所述第三语音数据集、和第一用户的第二方言的第四语音数据集,生成第一用户的具有多方言能力的语音合成器;以及,针对所述请求,通过所述语音合成器,生成第一语音数据。

294.例如,一个说普通话的第一用户要用粤语(第一方言)说一段话,但该用户不会说粤语或粤语说的不好,为了达到该第一用户流利说粤语的效果,服务端可先通过跨方言语音转换算法,根据其他说粤语的第二用户的粤语语音数据(第二语音数据集),生成具有第一用户音色的粤语语音数据(第三语音数据集);根据所述第三语音数据集、和第一用户的普通话(第二方言)的第四语音数据集,生成第一用户的具有普通话和粤语能力的语音合成器;针对第一用户通过终端设备确定的待朗读文本,通过所述语音合成器,生成由第一用户用粤语朗读该文本的语音数据(第一语音数据),好像该第一用户具有较好的英语水平。

295.所述跨方言语音转换算法,可以生成高质量的具有目标发音人音色的某种方言或多种方言混合的语言数据。该算法可包括如下步骤:1)构建语音后验概率图谱ppg特征提取器、和第一用户的语音合成模型;2)通过所述ppg特征提取器,根据第二用户的第一方言的第二语音数据的第一声学特征数据,确定第二语音数据的ppg特征数据;所述第一声学特征数据包括第二用户声纹信息和语音内容信息;3)通过第一用户的语音合成模型,根据所述ppg特征数据、和第二语音数据的第二声学特征数据,生成与第二语音数据对应的第一用户的第一方言的第三语音数据;所述第二声学特征数据包括韵律信息。由于所述跨方言语音转换算法与上述跨语言语音转换算法的处理过程相似,因此此处不再赘述。

296.从上述实施例可见,本技术提供的跨方言语音生成系统,通过终端设备用于确定待处理文本,向服务端发送由第一用户用第一方言朗读所述文本的语音生成请求;以及,播放服务端回送的第一用户用第一方言朗读所述文本的第一语音数据;服务端,用于通过跨方言语音转换算法,根据第二用户的第一方言的第二语音数据集,生成具有第一用户音色的第一方言的第三语音数据集;根据所述第三语音数据集、和第一用户的第二方言的第四

语音数据集,生成第一用户的具有多方言能力的语音合成器;以及,针对所述请求,通过所述语音合成器,生成第一语音数据;这种处理方式,使得采用跨方言语音转换技术,生成高质量的具有目标发音人音色的某种方言或多种方言混合的语言数据,与其原本的母语方言录音数据合并,一同作为训练数据,得到了一个具有双方言/多方言/混合方言语言能力的目标说话人音色的语音合成器,避免跨方言及混合方言语音合成中,使用不同方言各自的合成器时相互切换造成的音色不一致,效果不自然的问题;因此,可以有效提升多方言文本的语音合成质量,从而提升用户体验。此外,该系统使得不再局限于发音人的母语方言限制,而只关注发音人的音色,只要选定发音人的音色和录制发音人母语方言录音,就可以把音色扩展到其它方言,对其它方言的任何文本进行语音合成处理。此外,这种处理方式还使得仅仅使用不同说话人的单方言数据库即可进行系统建设,节省了聘请专业多方言发音人带来的高额成本。再者,这种处理方式还使得在不影响本身母语方言表现的基础上,其他方言部分的合成效果可以达到逼近方言母语者的发音水平,同时合成的不同方言的语音都很好的保持了目标说话人的音色,因此可以是赋予任何(单方言)音色优秀的多方言能力。

297.第二十八实施例

298.在上述的实施例中,提供了一种跨方言语音生成系统,与之相对应的,本技术还提供一种跨方言语音生成方法,该方法的执行主体可以是服务端等等。该方法是与上述系统的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

299.本技术提供的一种跨方言语音生成方法,可包括如下步骤:

300.步骤1:通过跨方言语音转换算法,根据第二用户的第一方言的第二语音数据集,生成具有第一用户音色的第一方言的第三语音数据集;

301.步骤2:根据所述第三语音数据集、和第一用户的第二方言的第四语音数据集,生成第一用户的具有多方言能力的语音合成器;

302.步骤3:针对客户端发送的由第一用户用第一方言朗读所述文本的语音生成请求,通过所述语音合成器,生成第一语音数据。

303.第二十九实施例

304.在上述的实施例中,提供了一种跨方言语音生成方法,与之相对应的,本技术还提供一种跨方言语音生成装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

305.本技术提供的一种跨方言语音生成装置包括:

306.训练数据生成单元,用于通过跨方言语音转换算法,根据第二用户的第一方言的第二语音数据集,生成具有第一用户音色的第一方言的第三语音数据集;

307.语音合成器训练单元,用于根据所述第三语音数据集、和第一用户的第二方言的第四语音数据集,生成第一用户的具有多方言能力的语音合成器;

308.语音合成单元,用于针对客户端发送的由第一用户用第一方言朗读所述文本的语音生成请求,通过所述语音合成器,生成第一语音数据。

309.第三十实施例

310.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示

意性的。

311.本实施例的一种电子设备,该电子设备包括:传声器,处理器和存储器;存储器,用于存储实现跨方言语音生成方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:通过跨方言语音转换算法,根据第二用户的第一方言的第二语音数据集,生成具有第一用户音色的第一方言的第三语音数据集;根据所述第三语音数据集、和第一用户的第二方言的第四语音数据集,生成第一用户的具有多方言能力的语音合成器;针对客户端发送的由第一用户用第一方言朗读所述文本的语音生成请求,通过所述语音合成器,生成第一语音数据。

312.第三十一实施例

313.在上述的实施例中,提供了一种跨方言语音生成系统,与之相对应的,本技术还提供一种跨方言语音生成方法,该方法的执行主体可以终端设备等等。该方法是与上述系统的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

314.本技术提供的一种跨方言语音生成方法,可包括如下步骤:

315.步骤1:确定待处理文本,向服务端发送由第一用户用第一方言朗读所述文本的语音生成请求;

316.步骤2:播放服务端回送的第一用户用第一方言朗读所述文本的第一语音数据。

317.第三十二实施例

318.在上述的实施例中,提供了一种跨方言语音生成方法,与之相对应的,本技术还提供一种跨方言语音生成装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

319.本技术提供的一种跨方言语音生成装置包括:

320.请求发送单元,用于确定待处理文本,向服务端发送由第一用户用第一方言朗读所述文本的语音生成请求;

321.语音播放单元,用于播放服务端回送的第一用户用第一方言朗读所述文本的第一语音数据。

322.第三十三实施例

323.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

324.本实施例的一种电子设备,该电子设备包括:传声器,处理器和存储器;存储器,用于存储实现跨方言语音生成方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:确定待处理文本,向服务端发送由第一用户用第一方言朗读所述文本的语音生成请求;播放服务端回送的第一用户用第一方言朗读所述文本的第一语音数据。

325.第三十四实施例

326.在上述的实施例中,提供了一种跨方言语音生成方法,与之相对应的,本技术还提供一种语音合成器构建方法,该方法的执行主体可以服务端等等。该方法是与上述系统的实施例相对应。本实施例与第二实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

327.本技术提供的一种语音合成器构建方法,可包括如下步骤:

328.步骤1:通过跨方言语音转换算法,根据第二用户的第一方言的第二语音数据集,生成具有第一用户音色的第一方言的第三语音数据集;

329.步骤2:根据所述第三语音数据集、和第一用户的第二方言的第四语音数据集,生成第一用户的具有多方言能力的语音合成器。

330.第三十五实施例

331.在上述的实施例中,提供了一种语音合成器构建方法,与之相对应的,本技术还提供一种语音合成器构建装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

332.本技术提供的一种语音合成器构建装置包括:

333.训练数据生成单元,用于通过跨方言语音转换算法,根据第二用户的第一方言的第二语音数据集,生成具有第一用户音色的第一方言的第三语音数据集;

334.语音合成器训练单元,用于根据所述第三语音数据集、和第一用户的第二方言的第四语音数据集,生成第一用户的具有多方言能力的语音合成器。

335.第三十六实施例

336.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

337.本实施例的一种电子设备,该电子设备包括:传声器,处理器和存储器;存储器,用于存储实现语音合成器构建方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:通过跨方言语音转换算法,根据第二用户的第一方言的第二语音数据集,生成具有第一用户音色的第一方言的第三语音数据集;根据所述第三语音数据集、和第一用户的第二方言的第四语音数据集,生成第一用户的具有多方言能力的语音合成器。

338.本技术虽然以较佳实施例公开如上,但其并不是用来限定本技术,任何本领域技术人员在不脱离本技术的精神和范围内,都可以做出可能的变动和修改,因此本技术的保护范围应当以本技术权利要求所界定的范围为准。

339.在一个典型的配置中,计算设备包括一个或多个处理器(cpu)、输入/输出接口、网络接口和内存。

340.内存可能包括计算机可读介质中的非永久性存储器,随机存取存储器(ram)和/或非易失性内存等形式,如只读存储器(rom)或闪存(f l ash ram)。内存是计算机可读介质的示例。

341.1、计算机可读介质包括永久性和非永久性、可移动和非可移动媒体可以由任何方法或技术来实现信息存储。信息可以是计算机可读指令、数据结构、程序的模块或其他数据。计算机的存储介质的例子包括,但不限于相变内存(pram)、静态随机存取存储器(sram)、动态随机存取存储器(dram)、其他类型的随机存取存储器(ram)、只读存储器(rom)、电可擦除可编程只读存储器(eeprom)、快闪记忆体或其他内存技术、只读光盘只读存储器(cd-rom)、数字多功能光盘(dvd)或其他光学存储、磁盒式磁带,磁带磁磁盘存储或其他磁性存储设备或任何其他非传输介质,可用于存储可以被计算设备访问的信息。按照本文中的界定,计算机可读介质不包括非暂存电脑可读媒体(trans itory med i a),如调

制的数据信号和载波。

342.2、本领域技术人员应明白,本技术的实施例可提供为方法、系统或计算机程序产品。因此,本技术可采用完全硬件实施例、完全软件实施例或结合软件和硬件方面的实施例的形式。而且,本技术可采用在一个或多个其中包含有计算机可用程序代码的计算机可用存储介质(包括但不限于磁盘存储器、cd-rom、光学存储器等)上实施的计算机程序产品的形式。