1.本技术涉及语音转换技术领域,具体涉及语音转换方法和装置,语音消息发送系统、方法和装置,影视配音系统、方法和装置,新闻播报系统、方法和装置,语音交互系统、方法和装置,语音库构建方法和装置,语音翻译系统、方法和装置,跨语言朗读系统、方法和装置,跨方言朗读系统、方法和装置,语音变声系统,问答系统、方法和装置,以及电子设备。

背景技术:

2.语音转换的基本任务是在保持说话内容的基础上,改变源说话人的声音特征,使之听起来像目标说话人的音色,满足在语音交互应用中对用户个性化的需求。其中,跨语言语音转换在语音交互中有更丰富的应用。

3.一种典型的跨语言语音转换系统所采用的技术方案是,首先将源说话人的语音信号转化为相应的文字信息,然后将文字信息结合目标说话人的语音特征信息进行合成,生成具有目标说话人音色的语音信号。然而,由于该方案在语音合成前需要从语音提取文字信息,其文字信息是语言相关的,并且不同语言间文本信息无法通用,其依赖于文字信息的语音合成模块也是语言相关的,该方案在把不同语言的目标说话人放在统一框架下进行模型训练存在困难,由此限制了其跨语言语音转换的功能。

4.另一种典型的跨语言语音转换系统所采用的技术方案是,使用语音表征学习技术和风格迁移技术,首先将源说话人的语音进行编码,提取文本内容和韵律特征,然后使用编码器提取目标说话人的声纹特征,通过注意力机制和解码器将上述特征转换成带有目标说话人音色的声学特征,最终通过wavernn声码器将声学特征合成语音。然而,该方案的语音特征编码尽管可以同时对多种语言语音进行编码,但编码质量相对不稳定,很难保证在不同语言上获得同等的编码质量,由此限制了其在跨语言语音转换上的应用。

5.然而,在实现本发明过程中,发明人发现该技术方案至少存在如下问题:跨语言语音转换质量较低的问题。综上所述,如何提升跨语言语音转换质量,成为本领域技术人员急需解决的问题。

技术实现要素:

6.本技术提供跨语言语音转换方法,以解决现有技术存在的跨语言语音转换质量较低的问题。本技术另外提供语音消息发送系统、方法和装置,影视配音系统、方法和装置,新闻播报系统、方法和装置,跨语言语音转换装置,以及电子设备。

7.本技术提供一种语音消息发送系统,包括:

8.第一终端设备,用于采集第一用户的第一语音数据,向服务端发送将所述第一语音数据变声为第二用户声音的请求;

9.服务端,用于构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音

合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据;向第二终端设备发送第二语音数据;

10.第二终端设备,用于播放第二语音数据。

11.本技术还提供一种影视配音系统,包括:

12.终端设备,用于采集第一用户针对影视台词文本的第一语音数据,向服务端发送将所述第一语音数据转换为第二用户配音的请求;

13.服务端,用于构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成第二用户针对所述影视台词文本的第二语音数据。

14.本技术还提供一种新闻播报系统,包括:

15.终端设备,用于采集待播报新闻文本的多种语言版本的第一用户的第一语音数据,向服务端发送由第二用户声音播报多种语言的待播报新闻文本的请求;

16.服务端,用于构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;针对各个语言的第一语音数据,通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成由第二用户播报的多种语言的第二语音数据。

17.本技术还提供一种语音转换方法,包括:

18.构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;

19.通过所述ppg特征提取器,根据第一用户的第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;所述第一声学特征数据包括第一用户声纹信息和语音内容信息;

20.通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据;所述第二声学特征数据包括韵律信息。

21.可选的,所述通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据,包括:

22.通过所述语音合成模型包括的特征合成网络,根据所述ppg特征数据和所述第二声学特征数据,确定具有第二用户音色的第三声学特征数据;

23.通过所述语音合成模型包括的声码器,根据第三声学特征数据,生成所述第二语音数据。

24.可选的,还包括:

25.确定ppg特征数据的采样率,作为特征合成网络的ppg特征采样率;

26.通过特征合成网络,根据所述ppg特征数据和所述第二声学特征数据,确定具有第二用户音色的与采样的ppg特征数据对应的第三声学特征数据;

27.通过所述语音合成模型包括的声码器,根据第三声学特征数据,生成与所述采样率对应的语音播放速度的所述第二语音数据。

28.可选的,所述确定ppg特征数据的采样率,包括:

29.确定第二语音数据的播放速度;

30.根据所述播放速度,确定所述采样率。

31.可选的,所述特征合成网络的结构包括:fastspeech模型。

32.可选的,所述fastspeech模型不包括:预测器和长度调节器。

33.可选的,还包括:

34.针对各个用户,从所述用户的语音数据的pps特征数据、第二声学特征数据与第三声学特征数据间的对应关系集中,学习得到所述特征合成网络。

35.可选的,还包括:

36.针对各个用户,从所述用户的语音数据的第三声学特征数据与语音合成数据间的对应关系集中,学习得到所述声码器。

37.可选的,所述各个用户的语音合成模型采用如下方式构建:

38.针对各个用户,根据用户的语音数据的pps特征数据、第二声学特征数据与语音合成数据间的对应关系集中,学习得到所述用户的语音合成模型。

39.可选的,所述语音后验概率图谱ppg特征提取器采用如下方式构建:

40.从多个用户的语音数据的第一声学特征数据、与发音标注信息间的对应关系中学习得到所述提取器。

41.本技术还提供一种语音消息发送方法,包括:

42.采集第一用户的第一语音数据;

43.向服务端发送将所述第一语音数据变声为第二用户声音的请求,以使得服务端构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;通过所述ppg特征提取器,根据第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据;向第二终端设备发送第二语音数据。

44.本技术还提供一种影视配音方法,包括:

45.采集第一用户针对第一语言的影视台词文本的第一语音数据;

46.向服务端发送将所述第一语音数据转换为第二用户配音的请求,以使得服务端构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;通过所述ppg特征提取器,根据第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成第二用户针对所述影视台词文本的第二语音数据。

47.本技术还提供一种新闻播报方法,包括:

48.采集待播报新闻文本的多种语言版本的第一用户的第一语音数据;

49.向服务端发送由第二用户声音播报所述多种语言版本的待播报新闻文本的请求,以使得服务端构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;针对各个语言的第一语音数据,通过所述ppg特征提取器,根据第一语音数据的第一声学特征数

据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成由第二用户播报的多种语言的第二语音数据。

50.本技术还提供一种语音交互方法,包括:

51.第一终端设备,用于确定第一用户对第二用户的交互信息,向服务端发送所述交互信息;

52.服务端,用于构建第一用户的多种说话方式的语音合成模型;确定与所述交互信息对应的第一用户的目标说话方式信息;通过第一用户的目标说话方式的语音合成模型,生成所述交互信息的具有目标说话方式的语音数据,将语音数据发送至第二用户的第二终端设备;

53.第二终端设备,用于播放所述语音数据。

54.本技术还提供一种语音交互方法,包括:

55.构建第一用户的多种说话方式的语音合成模型;

56.针对第一用户对第二用户的交互信息,确定第一用户的目标说话方式信息;

57.通过第一用户的目标说话方式的语音合成模型,生成所述交互信息的具有目标说话方式的语音数据,将语音数据发送至第二用户的终端设备。

58.可选的,所述确定第一用户的目标说话方式信息,包括:

59.根据第二用户与第一用户的关系信息,确定所述目标说话方式信息。

60.可选的,所述确定第一用户的目标说话方式信息,包括:

61.确定所述交互信息所属领域;

62.根据第一用户和第二用户各自的领域信息和所属领域,确定所述目标说话方式信息。

63.可选的,所述交互信息包括:语音交互信息;

64.所述方法还包括:

65.构建语音后验概率图谱ppg特征提取器;

66.通过所述ppg特征提取器,确定所述语音交互信息的ppg特征数据;

67.通过所述目标说话方式的语音合成模型,根据所述ppg特征数据,生成所述语音数据。

68.本技术还提供一种语音交互方法,包括:

69.确定第一用户对第二用户的交互信息;

70.向服务端发送所述交互信息,以便于服务端确定与所述交互信息对应的第一用户的目标说话方式信息;通过第一用户的目标说话方式的语音合成模型,生成所述交互信息的具有目标说话方式的语音数据,将语音数据发送至第二用户的终端设备。

71.本技术还提供一种语音交互方法,包括:

72.接收服务端发送的第一用户的具有目标说话方式的语音数据;

73.播放所述语音数据。

74.本技术还提供一种语音交互系统,包括:

75.第一终端设备,用于根据第二用户对第一用户的交互信息,向服务端发送针对所述交互信息的请求帮助回复请求;

76.服务端,用于构建各个用户的语音库;确定与所述交互信息对应的目标领域,并根据与所述目标领域对应的第三用户的语音库,生成具有第一用户音色的源于第三用户在所述目标领域的知识的语音数据,将语音数据发送至第二用户的终端设备。

77.本技术还提供一种语音交互方法,包括:

78.构建各个用户的语音库;

79.针对第一终端设备发送的针对第二用户对第一用户的交互信息的请求帮助回复请求,确定与所述交互信息对应的目标领域;

80.根据与所述目标领域对应的第三用户的语音库,生成具有第一用户音色的源于第三用户在所述目标领域的知识的语音数据,将语音数据发送至第二用户的终端设备。

81.本技术还提供一种语音交互方法,包括:

82.接收第二用户对第一用户的交互信息;

83.向服务端发送针对所述交互信息的请求帮助回复请求。

84.本技术还提供一种语音交互方法,包括:

85.向服务端发送第二用户对第一用户的交互信息;

86.接收服务端发送的针对所述交互信息的具有第一用户音色的源于第三用户在目标领域的知识的语音回复数据;

87.播放所述语音回复数据。

88.本技术还提供一种语音库构建方法,包括:

89.采集用户的多个语音数据;

90.确定各个语音数据的说话方式信息;

91.根据所述用户、所述语音数据与所述说话方式间的对应关系,生成语音库。

92.本技术还提供一种语音库构建方法,包括:

93.采集用户的多个语音数据;

94.确定各个语音数据的领域信息;

95.根据所述用户、所述语音数据与所述领域间的对应关系,生成语音库。

96.本技术还提供一种语音翻译系统,包括:

97.终端设备,用于采集第一用户的源语言的第一语音数据,向服务端发送针对所述第一语音数据的由第二用户进行翻译的请求;以及,播放服务端回送的与第一语音数据对应的具有第二用户音色的目标语言的第二语音数据;

98.服务端,用于构建第二用户的语音转换模型;针对所述请求,生成与第一语音数据对应的第三用户的目标语言的第三语音数据;通过第二用户的语音转换模型,生成与第三语音数据对应的具有第二用户音色的目标语言的第二语音数据,作为所述第二语音数据。

99.本技术还提供一种语音翻译方法,包括:

100.采集第一用户的源语言的第一语音数据;

101.向服务端发送针对所述第一语音数据的由第二用户进行翻译的请求;

102.播放服务端回送的与第一语音数据对应的具有第二用户音色的目标语言的第二语音数据。

103.本技术还提供一种语音翻译方法,包括:

104.构建第二用户的语音转换模型;

105.针对客户端发送的针对第一用户的源语言的第一语音数据的由第二用户进行翻译的请求,生成与所述第一语音数据对应的第三用户的目标语言的第三语音数据;

106.通过第二用户的语音转换模型,生成与第三语音数据对应的具有第二用户音色的目标语言的第二语音数据,作为所述第二语音数据发送至客户端。

107.本技术还提供一种跨语言语音生成系统,包括:

108.终端设备,用于确定第一语言的文本,向服务端发送由第一用户朗读所述文本的语音生成请求;以及,播放服务端回送的第一用户朗读所述文本的第一语音数据;所述第一用户的母语为第二语言;

109.服务端,用于构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;以及,针对所述请求,确定第二用户朗读所述文本的第二语音数据,并通过所述ppg特征提取器,根据第二语音数据的包括第二用户声纹信息和语音内容信息的第一声学特征数据,确定第二语音数据的ppg特征数据;通过第一用户的所述语音合成模型,根据所述ppg特征数据、和第二语音数据的包括韵律信息的第二声学特征数据,生成所述第一语音数据。

110.本技术还提供一种跨语言语音生成方法,包括:

111.确定第一语言的文本;

112.向服务端发送由第一用户朗读所述文本的语音生成请求。

113.本技术还提供一种跨语言语音生成方法,包括:

114.针对客户端发送的由第一用户朗读第一语言的文本的语音生成请求,确定第二用户朗读所述文本的第二语音数据;

115.通过第一用户的语音转换模型,将第二语音数据转换为第一用户朗读所述文本的第一语音数据。

116.可选的,所述第一用户的母语为第二语言,所述第二用户的母语为第一语言。

117.可选的,所述请求包括:第二用户标识或者第一语言方言信息。

118.本技术还提供一种跨语言语音生成方法,包括:

119.确定第一语言的文本;

120.确定第二用户朗读所述文本的第二语音数据;

121.通过第一用户的语音转换模型,将第二语音数据转换为第一用户朗读所述文本的第一语音数据。

122.本技术还提供一种跨方言语音生成系统,包括:

123.终端设备,用于确定目标文本和目标方言,向服务端发送由第一用户用目标方言朗读所述文本的请求;以及,播放服务端回送的由第一用户用目标方言朗读所述文本的第一语音数据;

124.服务端,用于构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;以及,针对所述请求,确定第二用户用目标方言朗读所述文本的第二语音数据,并通过所述ppg特征提取器,根据第二语音数据的包括第二用户声纹信息和语音内容信息的第一声学特征数据,确定第二语音数据的ppg特征数据;通过第一用户的所述语音合成模型,根据所述ppg特征数据、和第二语音数据的包括韵律信息的第二声学特征数据,生成所述第一语音数据。

125.本技术还提供一种跨方言语音生成方法,包括:

126.确定目标文本和目标方言;

127.向服务端发送由第一用户用目标方言朗读所述文本的第一语音数据。

128.本技术还提供一种跨方言语音生成方法,包括:

129.针对由第一用户用目标方言朗读目标文本的请求,确定第二用户用目标方言朗读目标文本的第二语音数据;

130.通过第一用户的语音转换模型,将第二语音数据转换为第一用户用目标方言朗读所述文本的第一语音数据。

131.本技术还提供一种跨方言语音生成方法,包括:

132.确定目标文本和目标方言;

133.确定第二用户用目标方言朗读目标文本的第二语音数据;

134.通过第一用户的语音转换模型,将第二语音数据转换为第一用户用目标方言朗读所述文本的第一语音数据。

135.本技术还提供一种语音变声系统,包括:

136.终端设备,用于确定第一用户的第一语音数据,向服务端发送将所述第一语音数据变声为第二用户声音的请求;

137.服务端,用于构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据。

138.本技术还提供一种语音变声方法,包括:

139.确定第一用户的第一语音数据;

140.向服务端发送将所述第一语音数据变声为第二用户声音的请求。

141.本技术还提供一种语音变声方法,包括:

142.构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;

143.针对将第一用户的第一语音数据变声为第二用户声音的请求,通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;

144.通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据。

145.本技术还提供一种语音变声方法,包括:

146.确定第一用户的第一语音数据;

147.通过语音后验概率图谱ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;

148.通过第二用户的语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据。

149.本技术还提供一种跨语言语音交互系统,包括:

150.第一终端设备,用于采集第一用户的源语言的第一语音数据,向服务端发送所述第一语音数据;

151.服务端,用于确定与第一语音数据对应的目标语言文本;根据第二用户的目标语言语音库,生成与所述目标语言文本对应的第二用户的目标语言的第二语音数据;通过第一用户的语音转换模型,生成与第二语音数据对应的具有第一用户音色的目标语言的第三语音数据;向第二终端设备发送第三语音数据;

152.第二终端设备,用于播放第三语音数据。

153.本技术还提供一种跨语言语音交互方法,包括:

154.采集第一用户的源语言的第一语音数据;

155.向服务端发送所述第一语音数据,以使得服务端确定与第一语音数据对应的目标语言文本;根据第二用户的目标语言语音库,生成与所述目标语言文本对应的第二用户的目标语言的第二语音数据;通过第一用户的语音转换模型,生成与第二语音数据对应的具有第一用户音色的目标语言的第三语音数据;向第二终端设备发送第三语音数据;第二终端设备播放第三语音数据。

156.可选的,还包括:

157.接收服务端发送的第三用户的源语言的第六语音数据;服务端采用如下步骤生成第六语音数据:针对第二终端设备发送的第三用户的目标语言的第四语音数据,确定与第四语音数据对应的源语言文本;根据第四用户的源语言语音库,生成与所述源语言文本对应的第四用户的源语言的第五语音数据;通过第三用户的语音转换模型,生成与第五语音数据对应的具有第三用户音色的源语言的第六语音数据;

158.播放所述第六语音数据。

159.本技术还提供一种跨语言语音交互方法,包括:

160.针对第一终端设备发送的第一用户的源语言的第一语音数据,确定与第一语音数据对应的目标语言文本;

161.根据第二用户的目标语言语音库,生成与所述目标语言文本对应的第二用户的目标语言的第二语音数据;

162.通过第一用户的语音转换模型,生成与第二语音数据对应的具有第一用户音色的目标语言的第三语音数据,向第二终端设备发送第三语音数据。

163.可选的,还包括:

164.针对第二终端设备发送的第三用户的目标语言的第四语音数据,确定与第四语音数据对应的源语言文本;

165.根据第四用户的源语言语音库,生成与所述源语言文本对应的第四用户的源语言的第五语音数据;

166.通过第三用户的语音转换模型,生成与第五语音数据对应的具有第三用户音色的源语言的第六语音数据,向第一终端设备发送第六语音数据。

167.本技术还提供一种跨语言语音交互方法,包括:

168.接收服务端发送的第一用户的目标语言的第三语音数据;

169.播放第三语音数据。

170.可选的,还包括:

171.采集第三用户的目标语言的第四语音数据;

172.向服务端发送所述第四语音数据,以使得服务端确定与第四语音数据对应的源语

言文本;根据第四用户的源语言语音库,生成与所述源语言文本对应的第四用户的源语言的第五语音数据;通过第三用户的语音转换模型,生成与第五语音数据对应的具有第三用户音色的源语言的第六语音数据,向第一终端设备发送第六语音数据;第一终端设备播放第六语音数据。

173.本技术还提供一种问答系统,包括:

174.终端设备,用于采集第一用户的第一语音数据,并确定目标说话方式,将所述第一语音数据转换为目标说话方式的第二语音数据,向服务端发送第二语音数据;

175.服务端,用于根据第二语音数据,确定回复信息,向终端设备回送回复信息。

176.本技术还提供一种问答方法,包括:

177.采集第一用户的第一语音数据,并确定目标说话方式;

178.将所述第一语音数据转换为目标说话方式的第二语音数据;

179.向服务端发送第二语音数据,以使得服务端根据第二语音数据,确定回复信息,向终端设备回送回复信息。

180.本技术还提供一种问答方法,包括:

181.接收第一用户的目标说话方式的第二语音数据;

182.根据第二语音数据,确定回复信息;

183.向终端设备回送回复信息。

184.可选的,所述根据第二语音数据,确定回复信息,包括:

185.确定第二语音数据的说话方式信息和文本信息;

186.根据说话方式信息和文本信息,确定回复信息。

187.本技术还提供一种语音交互系统,包括:

188.第一终端设备,用于采集第一用户的第一语音数据,并确定目标说话方式,向服务端发送第一语音数据发送请求;以及,播放第二终端设备通过服务端回送的第二用户的第二语音数据;

189.服务端,用于针对第一语音数据发送请求,将所述第一语音数据转换为第一用户的目标说话方式的第三语音数据,向第二终端设备发送第三语音数据;以及,将第二终端设备发送的第二语音数据发送至第一终端设备;

190.第二终端设备,用于播放第三语音数据;以及,采集第二语音数据,向服务端发送第二语音数据发送请求。

191.本技术还提供一种语音交互方法,包括:

192.采集第一用户的第一语音数据,并确定目标说话方式,向服务端发送第一语音数据发送请求,以使得服务端将所述第一语音数据转换为第一用户的目标说话方式的第三语音数据,向第二终端设备发送第三语音数据;第二终端设备播放第三语音数据;

193.播放第二终端设备通过服务端回送的第二用户的第二语音数据。

194.本技术还提供一种语音交互方法,包括:

195.针对第一终端设备发送的第一语音数据发送请求,将第一用户的第一语音数据转换为第一用户的目标说话方式的第三语音数据,向第二终端设备发送第三语音数据;

196.针对第二终端设备发送的第二语音数据发送请求,将第二终端设备发送的第二语音数据发送至第一终端设备。

197.本技术还提供一种语音交互方法,包括:

198.播放服务端发送的第一用户的目标说话方式的第三语音数据;

199.采集第二语音数据;

200.向服务端发送第二语音数据发送请求。

201.本技术还提供一种语音语音转换模型构建方法,包括:

202.构建各个用户的语音合成模型、和语音后验概率图谱ppg特征提取器,形成语音转换模型;其中,所述ppg特征提取器用于根据第一用户的第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;所述第一声学特征数据包括第一用户声纹信息和语音内容信息;所述语音合成模型用于根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据;所述第二声学特征数据包括韵律信息。

203.可选的,所述构建各个用户的语音合成模型,包括:

204.针对各个用户,根据用户的语音数据的pps特征数据、第二声学特征数据与语音合成数据间的对应关系集中,学习得到所述用户的语音合成模型。

205.可选的,所述语音合成模型包括:特征合成网络和声码器;其中,所述特征合成网络用于根据所述ppg特征数据和所述第二声学特征数据,确定具有第二用户音色的第三声学特征数据;所述声码器用于根据第三声学特征数据,生成所述第二语音数据;

206.所述方法还包括:

207.针对各个用户,从所述用户的语音数据的pps特征数据、第二声学特征数据与第三声学特征数据间的对应关系集中,学习得到所述特征合成网络;

208.针对各个用户,从所述用户的语音数据的第三声学特征数据与语音合成数据间的对应关系集中,学习得到所述声码器。

209.可选的,所述ppg特征提取器采用如下方式构建:

210.从多个用户的语音数据的第一声学特征数据、与发音标注信息间的对应关系中学习得到所述提取器。

211.本技术还提供一种语音转换装置,包括:

212.模型构建单元,用于构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;

213.ppg特征提取单元,用于通过所述ppg特征提取器,根据第一用户的第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;所述第一声学特征数据包括第一用户声纹信息和语音内容信息;

214.语音合成单元,用于通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据;所述第二声学特征数据包括韵律信息。

215.本技术还提供一种电子设备,包括:

216.处理器;以及

217.存储器,用于存储实现语音转换方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;通过所述ppg特征提取器,根据第一用户的第一语音数据的第一声学

特征数据,确定第一语音数据的ppg特征数据;所述第一声学特征数据包括第一用户声纹信息和语音内容信息;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据;所述第二声学特征数据包括韵律信息。

218.本技术还提供一种语音消息发送装置,包括:

219.语音数据采集单元,用于采集第一用户的第一语音数据;

220.请求发送单元,用于向服务端发送将所述第一语音数据变声为第二用户声音的请求,以使得服务端构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;通过所述ppg特征提取器,根据第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据;向第二终端设备发送第二语音数据。

221.本技术还提供一种电子设备,包括:

222.处理器;以及

223.存储器,用于存储实现语音消息发送方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:采集第一用户的第一语音数据;向服务端发送将所述第一语音数据变声为第二用户声音的请求,以使得服务端构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;通过所述ppg特征提取器,根据第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据;向第二终端设备发送第二语音数据。

224.本技术还提供一种语音消息发送装置,包括:

225.语音数据接收单元,用于接收服务端发送的第二语音数据;所述第二语音数据采用如下方式生成:构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;针对第一终端设备发送的将第一用户的第一语音数据变声为第二用户声音的请求,通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据;

226.语音播放单元,用于播放所述第二语音数据。

227.本技术还提供一种电子设备,包括:

228.处理器;以及

229.存储器,用于存储实现语音消息发送方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:接收服务端发送的第二语音数据;所述第二语音数据采用如下方式生成:构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;针对第一终端设备发送的将第一用户的第一语音数据变声为第二用户声音的请求,通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成与第一语音

数据对应的第二用户的第二语音数据;播放所述第二语音数据。

230.本技术还提供一种影视配音装置,包括:

231.语音数据采集单元,用于采集第一用户针对第一语言的影视台词文本的第一语音数据;

232.请求发送单元,用于向服务端发送将所述第一语音数据转换为第二用户配音的请求,以使得服务端构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;通过所述ppg特征提取器,根据第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成第二用户针对所述影视台词文本的第二语音数据。

233.本技术还提供一种电子设备,包括:

234.处理器;以及

235.存储器,用于存储实现影视配音方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:采集第一用户针对第一语言的影视台词文本的第一语音数据;向服务端发送将所述第一语音数据转换为第二用户配音的请求,以使得服务端构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;通过所述ppg特征提取器,根据第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成第二用户针对所述影视台词文本的第二语音数据。

236.本技术还提供一种新闻播报装置,包括:

237.语音数据采集单元,用于采集待播报新闻文本的多种语言版本的第一用户的第一语音数据;

238.请求发送单元,用于向服务端发送由第二用户声音播报所述多种语言版本的待播报新闻文本的请求,以使得服务端构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;针对各个语言的第一语音数据,通过所述ppg特征提取器,根据第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成由第二用户播报的多种语言的第二语音数据。

239.本技术还提供一种电子设备,包括:

240.处理器;以及

241.存储器,用于存储实现新闻播报方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:采集待播报新闻文本的多种语言版本的第一用户的第一语音数据;向服务端发送由第二用户声音播报所述多种语言版本的待播报新闻文本的请求,以使得服务端构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;针对各个语言的第一语音数据,通过所述ppg特征提取器,根据第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成由第二用户播报的多种语言的第二语音数据。

242.本技术还提供一种语音交互装置,包括:

243.模型构建单元,用于构建第一用户的多种说话方式的语音合成模型;

244.说话方式确定单元,用于针对第一用户对第二用户的交互信息,确定第一用户的目标说话方式信息;

245.语音合成单元,用于通过第一用户的目标说话方式的语音合成模型,生成所述交互信息的具有目标说话方式的语音数据,将语音数据发送至第二用户的终端设备。

246.本技术还提供一种电子设备,包括:

247.处理器;以及

248.存储器,用于存储实现语音交互方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:构建第一用户的多种说话方式的语音合成模型;针对第一用户对第二用户的交互信息,确定第一用户的目标说话方式信息;通过第一用户的目标说话方式的语音合成模型,生成所述交互信息的具有目标说话方式的语音数据,将语音数据发送至第二用户的终端设备。

249.本技术还提供一种语音交互装置,包括:

250.信息确定单元,用于确定第一用户对第二用户的交互信息;

251.信息发送单元,用于向服务端发送所述交互信息,以便于服务端确定与所述交互信息对应的第一用户的目标说话方式信息;通过第一用户的目标说话方式的语音合成模型,生成所述交互信息的具有目标说话方式的语音数据,将语音数据发送至第二用户的终端设备。

252.本技术还提供一种电子设备,包括:

253.处理器;以及

254.存储器,用于存储实现语音交互方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:确定第一用户对第二用户的交互信息;向服务端发送所述交互信息,以便于服务端确定与所述交互信息对应的第一用户的目标说话方式信息;通过第一用户的目标说话方式的语音合成模型,生成所述交互信息的具有目标说话方式的语音数据,将语音数据发送至第二用户的终端设备。

255.本技术还提供一种语音交互装置,包括:

256.数据接收单元,用于接收服务端发送的第一用户的具有目标说话方式的语音数据;

257.语音播放单元,用于播放所述语音数据。

258.本技术还提供一种电子设备,包括:

259.处理器;以及

260.存储器,用于存储实现语音交互方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:接收服务端发送的第一用户的具有目标说话方式的语音数据;播放所述语音数据。

261.本技术还提供一种语音交互装置,包括:

262.语音库构建单元,用于构建各个用户的语音库;

263.领域确定单元,用于针对第一终端设备发送的针对第二用户对第一用户的交互信息的请求帮助回复请求,确定与所述交互信息对应的目标领域;

264.语音数据发送单元,用于通过与所述目标领域对应的第三用户的语音库,生成具有第一用户音色的源于第三用户在所述目标领域的知识的语音数据,将语音数据发送至第

二用户的终端设备。

265.本技术还提供一种电子设备,包括:

266.处理器;以及

267.存储器,用于存储实现语音交互方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:构建各个用户的语音库;针对第一终端设备发送的针对第二用户对第一用户的交互信息的请求帮助回复请求,确定与所述交互信息对应的目标领域;通过与所述目标领域对应的第三用户的语音库,生成具有第一用户音色的源于第三用户在所述目标领域的知识的语音数据,将语音数据发送至第二用户的终端设备。

268.本技术还提供一种语音交互装置,包括:

269.信息接收单元,用于接收第二用户对第一用户的交互信息;

270.请求发送单元,用于向服务端发送针对所述交互信息的请求帮助回复请求。

271.本技术还提供一种电子设备,包括:

272.处理器;以及

273.存储器,用于存储实现语音交互方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:接收第二用户对第一用户的交互信息;向服务端发送针对所述交互信息的请求帮助回复请求。

274.本技术还提供一种语音交互装置,包括:

275.数据发送单元,用于向服务端发送第二用户对第一用户的交互信息;

276.数据接收单元,用于接收服务端发送的针对所述交互信息的具有第一用户音色的源于第三用户在目标领域的知识的语音回复数据;

277.语音播放单元,用于播放所述语音回复数据。

278.本技术还提供一种电子设备,包括:

279.处理器;以及

280.存储器,用于存储实现语音交互方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:向服务端发送第二用户对第一用户的交互信息;接收服务端发送的针对所述交互信息的具有第一用户音色的源于第三用户在目标领域的知识的语音回复数据;播放所述语音回复数据。

281.本技术还提供一种语音库构建装置,包括:

282.语音数据采集单元,用于采集用户的多个语音数据;

283.说话方式确定单元,用于确定各个语音数据的说话方式信息;

284.语音库生成单元,用于根据所述用户、所述语音数据与所述说话方式间的对应关系,生成语音库。

285.本技术还提供一种电子设备,包括:

286.处理器;以及

287.存储器,用于存储实现语音库构建方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:采集用户的多个语音数据;确定各个语音数据的说话方式信息;根据所述用户、所述语音数据与所述说话方式间的对应关系,生成语音库。

288.本技术还提供一种语音库构建装置,包括:

289.语音数据采集单元,用于采集用户的多个语音数据;

290.领域确定单元,用于确定各个语音数据的领域信息;

291.语音库生成单元,用于根据所述用户、所述语音数据与所述领域间的对应关系,生成语音库。

292.本技术还提供一种电子设备,包括:

293.处理器;以及

294.存储器,用于存储实现语音库构建方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:采集用户的多个语音数据;确定各个语音数据的领域信息;根据所述用户、所述语音数据与所述领域间的对应关系,生成语音库。

295.本技术还提供一种语音翻译装置,包括:

296.模型构建单元,用于构建第二用户的语音转换模型;

297.第一语音生成单元,用于针对客户端发送的针对第一用户的源语言的第一语音数据的由第二用户进行翻译的请求,生成与所述第一语音数据对应的第三用户的目标语言的第三语音数据;

298.第二语音生成单元,用于通过第二用户的语音转换模型,生成与第三语音数据对应的具有第二用户音色的目标语言的第二语音数据,作为所述第二语音数据发送至客户端。

299.本技术还提供一种电子设备,包括:

300.处理器;以及

301.存储器,用于存储实现语音翻译方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:构建第二用户的语音转换模型;针对客户端发送的针对第一用户的源语言的第一语音数据的由第二用户进行翻译的请求,生成与所述第一语音数据对应的第三用户的目标语言的第三语音数据;通过第二用户的语音转换模型,生成与第三语音数据对应的具有第二用户音色的目标语言的第二语音数据,作为所述第二语音数据发送至客户端。

302.本技术还提供一种语音翻译装置,包括:

303.语音数据采集单元,用于采集第一用户的源语言的第一语音数据;

304.请求发送单元,用于向服务端发送针对所述第一语音数据的由第二用户进行翻译的请求;

305.语音播放单元,用于播放服务端回送的与第一语音数据对应的具有第二用户音色的目标语言的第二语音数据。

306.本技术还提供一种电子设备,包括:

307.处理器;以及

308.存储器,用于存储实现语音翻译方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:采集第一用户的源语言的第一语音数据;向服务端发送针对所述第一语音数据的由第二用户进行翻译的请求;播放服务端回送的与第一语音数据对应的具有第二用户音色的目标语言的第二语音数据。

309.本技术还提供一种跨语言语音生成装置,包括:

310.语音生成单元,用于针对客户端发送的由第一用户朗读第一语言的文本的语音生成请求,确定第二用户朗读所述文本的第二语音数据;

311.语音转换单元,用于通过第一用户的语音转换模型,将第二语音数据转换为第一用户朗读所述文本的第一语音数据。

312.本技术还提供一种电子设备,包括:

313.处理器;以及

314.存储器,用于存储实现跨语言语音生成方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:针对由第一用户朗读第一语言的文本的语音生成请求,确定第二用户朗读所述文本的第二语音数据;通过第一用户的语音转换模型,将第二语音数据转换为第一用户朗读所述文本的第一语音数据。

315.本技术还提供一种跨语言语音生成装置,包括:

316.文本确定单元,用于确定第一语言的文本;

317.请求发送单元,用于向服务端发送由第一用户朗读所述文本的语音生成请求。

318.本技术还提供一种电子设备,包括:

319.处理器;以及

320.存储器,用于存储实现跨语言语音生成方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:确定第一语言的文本;向服务端发送由第一用户朗读所述文本的语音生成请求。

321.本技术还提供一种跨语言语音生成装置,包括:

322.文本确定单元,用于确定第一语言的文本;

323.语音确定单元,用于确定第二用户朗读所述文本的第二语音数据;

324.语音转换单元,用于通过第一用户的语音转换模型,将第二语音数据转换为第一用户朗读所述文本的第一语音数据。

325.本技术还提供一种电子设备,包括:

326.处理器;以及

327.存储器,用于存储实现跨语言语音生成方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:定第一语言的文本;确定第二用户朗读所述文本的第二语音数据;通过第一用户的语音转换模型,将第二语音数据转换为第一用户朗读所述文本的第一语音数据。

328.本技术还提供一种跨方言语音生成装置,包括:

329.语音生成单元,用于针对由第一用户用目标方言朗读目标文本的请求,确定第二用户用目标方言朗读目标文本的第二语音数据;

330.语音转换单元,用于通过第一用户的语音转换模型,将第二语音数据转换为第一用户用目标方言朗读所述文本的第一语音数据。

331.本技术还提供一种电子设备,包括:

332.处理器;以及

333.存储器,用于存储实现跨方言语音生成方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:针对由第一用户用目标方言朗读目标文本的请求,确定第二用户用目标方言朗读目标文本的第二语音数据;通过第一用户的语音转换模型,将第二语音数据转换为第一用户用目标方言朗读所述文本的第一语音数据。

334.本技术还提供一种跨方言语音生成装置,包括:

335.文本确定单元,用于确定目标文本和目标方言;

336.请求发送单元,用于向服务端发送由第一用户用目标方言朗读所述文本的第一语音数据。

337.本技术还提供一种电子设备,包括:

338.处理器;以及

339.存储器,用于存储实现跨方言语音生成方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:确定目标文本和目标方言;向服务端发送由第一用户用目标方言朗读所述文本的第一语音数据。

340.本技术还提供一种跨方言语音生成装置,包括:

341.文本确定单元,用于确定目标文本和目标方言;

342.语音确定单元,用于确定第二用户用目标方言朗读目标文本的第二语音数据;

343.语音转换单元,用于通过第一用户的语音转换模型,将第二语音数据转换为第一用户用目标方言朗读所述文本的第一语音数据。

344.本技术还提供一种电子设备,包括:

345.处理器;以及

346.存储器,用于存储实现跨方言语音生成方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:确定目标文本和目标方言;确定第二用户用目标方言朗读目标文本的第二语音数据;通过第一用户的语音转换模型,将第二语音数据转换为第一用户用目标方言朗读所述文本的第一语音数据。

347.本技术还提供一种语音变声装置,包括:

348.模型构建单元,用于构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;

349.特征提取单元,用于针对将第一用户的第一语音数据变声为第二用户声音的请求,通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;

350.语音生成单元,用于通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据。

351.本技术还提供一种电子设备,包括:

352.处理器;以及

353.存储器,用于存储实现跨方言语音生成方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;针对将第一用户的第一语音数据变声为第二用户声音的请求,通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据。

354.本技术还提供一种语音变声装置,包括:

355.语音确定单元,用于确定第一用户的第一语音数据;

356.请求发送单元,用于向服务端发送将所述第一语音数据变声为第二用户声音的请求。

357.本技术还提供一种电子设备,包括:

358.处理器;以及

359.存储器,用于存储实现跨方言语音生成方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:确定第一用户的第一语音数据;向服务端发送将所述第一语音数据变声为第二用户声音的请求。

360.本技术还提供一种语音变声装置,包括:

361.语音确定单元,用于确定第一用户的第一语音数据;

362.特征提取单元,用于通过语音后验概率图谱ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;

363.语音生成单元,用于通过第二用户的语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据。

364.本技术还提供一种电子设备,包括:

365.处理器;以及

366.存储器,用于存储实现跨方言语音生成方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:确定第一用户的第一语音数据;通过语音后验概率图谱ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据。

367.本技术还提供一种跨语言语音交互装置,包括:

368.目标语言文本确定单元,用于针对第一终端设备发送的第一用户的源语言的第一语音数据,确定与第一语音数据对应的目标语言文本;

369.第二语音数据生成单元,用于根据第二用户的目标语言语音库,生成与所述目标语言文本对应的第二用户的目标语言的第二语音数据;

370.第三语音数据生成单元,用于通过第一用户的语音转换模型,生成与第二语音数据对应的具有第一用户音色的目标语言的第三语音数据,向第二终端设备发送第三语音数据。

371.本技术还提供一种电子设备,包括:

372.处理器;以及

373.存储器,用于存储实现跨语言语音交互方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:针对第一终端设备发送的第一用户的源语言的第一语音数据,确定与第一语音数据对应的目标语言文本;根据第二用户的目标语言语音库,生成与所述目标语言文本对应的第二用户的目标语言的第二语音数据;通过第一用户的语音转换模型,生成与第二语音数据对应的具有第一用户音色的目标语言的第三语音数据,向第二终端设备发送第三语音数据。

374.本技术还提供一种跨语言语音交互装置,包括:

375.语音采集单元,用于采集第一用户的源语言的第一语音数据;

376.请求发送单元,用于向服务端发送所述第一语音数据,以使得服务端确定与第一语音数据对应的目标语言文本;根据第二用户的目标语言语音库,生成与所述目标语言文本对应的第二用户的目标语言的第二语音数据;通过第一用户的语音转换模型,生成与第二语音数据对应的具有第一用户音色的目标语言的第三语音数据;向第二终端设备发送第三语音数据;第二终端设备播放第三语音数据。

377.本技术还提供一种电子设备,包括:

378.处理器;以及

379.存储器,用于存储实现跨语言语音交互方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:采集第一用户的源语言的第一语音数据;向服务端发送所述第一语音数据,以使得服务端确定与第一语音数据对应的目标语言文本;根据第二用户的目标语言语音库,生成与所述目标语言文本对应的第二用户的目标语言的第二语音数据;通过第一用户的语音转换模型,生成与第二语音数据对应的具有第一用户音色的目标语言的第三语音数据;向第二终端设备发送第三语音数据;第二终端设备播放第三语音数据。

380.本技术还提供一种跨语言语音交互装置,包括:

381.语音接收单元,用于接收服务端发送的第一用户的目标语言的第三语音数据;

382.语音播放单元,用于播放第三语音数据。

383.本技术还提供一种电子设备,包括:

384.处理器;以及

385.存储器,用于存储实现跨语言语音交互方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:接收服务端发送的第一用户的目标语言的第三语音数据;播放第三语音数据。

386.本技术还提供一种问答装置,包括:

387.语音接收单元,用于接收第一用户的目标说话方式的第二语音数据;

388.信息确定单元,用于根据第二语音数据,确定回复信息;

389.信息发送单元,用于向终端设备回送回复信息。

390.本技术还提供一种电子设备,包括:

391.处理器;以及

392.存储器,用于存储实现问答方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:接收第一用户的目标说话方式的第二语音数据;根据第二语音数据,确定回复信息;向终端设备回送回复信息。

393.本技术还提供一种问答装置,包括:

394.语音采集单元,用于采集第一用户的第一语音数据,并确定目标说话方式;

395.语音数据单元,用于将所述第一语音数据转换为目标说话方式的第二语音数据;

396.语音发送单元,用于向服务端发送第二语音数据,以使得服务端根据第二语音数据,确定回复信息,向终端设备回送回复信息。

397.本技术还提供一种电子设备,包括:

398.处理器;以及

399.存储器,用于存储实现问答方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:采集第一用户的第一语音数据,并确定目标说话方式;将所述第一语音数据转换为目标说话方式的第二语音数据;向服务端发送第二语音数据,以使得服务端根据第二语音数据,确定回复信息,向终端设备回送回复信息。

400.本技术还提供一种语音交互装置,包括:

401.第一请求处理单元,用于针对第一终端设备发送的第一语音数据发送请求,将第一用户的第一语音数据转换为第一用户的目标说话方式的第三语音数据,向第二终端设备发送第三语音数据;

402.第二请求处理单元,用于针对第二终端设备发送的第二语音数据发送请求,将第二终端设备发送的第二语音数据发送至第一终端设备。

403.本技术还提供一种电子设备,包括:

404.处理器;以及

405.存储器,用于存储实现语音交互方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:针对第一终端设备发送的第一语音数据发送请求,将第一用户的第一语音数据转换为第一用户的目标说话方式的第三语音数据,向第二终端设备发送第三语音数据;针对第二终端设备发送的第二语音数据发送请求,将第二终端设备发送的第二语音数据发送至第一终端设备。

406.本技术还提供一种语音交互装置,包括:

407.语音采集单元,用于采集第一用户的第一语音数据;

408.说话方式确定单元,用于确定目标说话方式;

409.请求发送单元,用于向服务端发送第一语音数据发送请求,以使得服务端将所述第一语音数据转换为第一用户的目标说话方式的第三语音数据,向第二终端设备发送第三语音数据;第二终端设备播放第三语音数据;

410.语音播放单元,用于播放第二终端设备通过服务端回送的第二用户的第二语音数据。

411.本技术还提供一种电子设备,包括:

412.处理器;以及

413.存储器,用于存储实现语音交互方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:采集第一用户的第一语音数据,并确定目标说话方式,向服务端发送第一语音数据发送请求,以使得服务端将所述第一语音数据转换为第一用户的目标说话方式的第三语音数据,向第二终端设备发送第三语音数据;第二终端设备播放第三语音数据;播放第二终端设备通过服务端回送的第二用户的第二语音数据。

414.本技术还提供一种语音交互装置,包括:

415.语音播放单元,用于播放服务端发送的第一用户的目标说话方式的第三语音数据;

416.语音采集单元,用于单元,用于采集第二语音数据;

417.请求发送单元,用于单元,用于向服务端发送第二语音数据发送请求。

418.本技术还提供一种电子设备,包括:

419.处理器;以及

420.存储器,用于存储实现语音交互方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:播放服务端发送的第一用户的目标说话方式的第三语音数据;采集第二语音数据;向服务端发送第二语音数据发送请求。

421.本技术还提供一种计算机可读存储介质,所述计算机可读存储介质中存储有指令,当其在计算机上运行时,使得计算机执行上述各种方法。

422.本技术还提供一种包括指令的计算机程序产品,当其在计算机上运行时,使得计算机执行上述各种方法。

423.与现有技术相比,本技术具有以下优点:

424.本技术实施例提供的语音转换方法,通过构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;通过所述ppg特征提取器,根据第一用户的第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据;这种处理方式,使得使用ppg特征作为语音合成模块的输入,该ppg特征保留了声学信息(如韵律和发音信息),每一帧的ppg特征可以在不同说话人和不同语言之间通用,因而可以实现跨语言、跨方言、同语言的语音转换。此外,这种处理方式还使得仅使用一种语言的语音进行模型训练和系统建设,就可以支持不同语言的输入语音进行语音转换,且可以在不同语言上获得同等的语音转换质量。再者,通过模型自适应训练,可以减少对目标说话人语音数量的要求,使用较少的语料即可达到较高的语音合成质量。

425.本技术实施例提供的语音消息发送系统,通过第一终端设备采集第一用户的第一语音数据,向服务端发送将所述第一语音数据变声为第二用户声音的请求,所述第一用户与第二用户的母语不同;服务端构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息是第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据;向第二终端设备发送第二语音数据;第一终端设备播放第二语音数据;这种处理方式,使得使用ppg特征作为语音合成模块的输入,该ppg特征保留了声学信息(如韵律和发音信息),每一帧的ppg特征可以在不同说话人和不同语言之间通用,因而可以实现跨语言、跨方言、同语言的语音转换。此外,这种处理方式还使得仅使用一种语言的语音进行模型训练和系统建设,就可以支持不同语言的输入语音进行语音转换,且可以在不同语言上获得同等的语音转换质量。再者,通过模型自适应训练,可以减少对目标说话人语音数量的要求,使用较少的语料即可达到较高的语音合成质量。

426.本技术实施例提供的影视配音系统,通过终端设备采集第一用户针对影视台词文本的第一语音数据,向服务端发送将所述第一语音数据转换为第二用户配音的请求;服务端构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所

述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成第二用户针对所述影视台词文本的第二语音数据;这种处理方式,使得使用ppg特征作为语音合成模块的输入,该ppg特征保留了声学信息(如韵律和发音信息),每一帧的ppg特征可以在不同说话人和不同语言之间通用,因而可以实现跨语言、跨方言、同语言的影视配音。此外,这种处理方式还使得仅使用一种语言的语音进行模型训练和系统建设,就可以支持不同语言的输入语音进行影视配音,且可以在不同语言上获得同等的影视配音质量。再者,通过模型自适应训练,可以减少对目标说话人语音数量的要求,使用较少的语料即可达到较高的语音合成质量。

427.本技术实施例提供的新闻播报系统,通过终端设备采集待播报新闻文本的多种语言版本的第一用户的第一语音数据,向服务端发送由第二用户声音播报多种语言的待播报新闻文本的请求;服务端构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;针对各个语言的第一语音数据,通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成由第二用户播报的多种语言的第二语音数据;这种处理方式,使得使用ppg特征作为语音合成模块的输入,该ppg特征保留了声学信息(如韵律和发音信息),每一帧的ppg特征可以在不同说话人和不同语言之间通用,因而可以实现跨语言、跨方言、同语言的新闻播报。此外,这种处理方式还使得仅使用一种语言的语音进行模型训练和系统建设,就可以支持不同语言的输入语音进行新闻播报,且可以在不同语言上获得同等的新闻播报质量。再者,通过模型自适应训练,可以减少对目标说话人语音数量的要求,使用较少的语料即可达到较高的语音合成质量。

428.本技术实施例提供的语音交互系统,通过第一终端设备确定第一用户对第二用户的交互信息,向服务端发送所述交互信息;服务端构建第一用户的多种说话方式的语音合成模型;确定与所述交互信息对应的第一用户的目标说话方式信息;通过第一用户的目标说话方式的语音合成模型,生成所述交互信息的具有目标说话方式的语音数据,将语音数据发送至第二用户的第二终端设备;第二终端设备播放语音数据;这种处理方式,使得根据不同环境下的特性,生成合适说话方式的语音数据;因此,可以有效提升语音调性的准确度,从而提升用户体验。

429.本技术实施例提供的语音交互系统,通过第一终端设备根据第二用户对第一用户的交互信息,向服务端发送针对所述交互信息的请求帮助回复请求;服务端构建各个用户的语音库;确定与所述交互信息对应的目标领域,并根据与所述目标领域对应的第三用户的语音库,生成具有第一用户音色的源于第三用户在所述目标领域的知识的语音数据,将语音数据发送至第二用户的终端设备;这种处理方式,使得当交互信息涉及第一用户不熟悉的领域时,第一用户可借鉴其他用户在该领域的语音数据,确定第一用户向第二用户的语音回复信息;因此,可以有效提升语音回复的准确度,从而提升用户体验。

430.本技术实施例提供的语音库构建方法,通过采集用户的多个语音数据;确定各个语音数据的说话方式信息;根据所述用户、所述语音数据与所述说话方式间的对应关系,生成语音库;这种处理方式,使得构建不同人的语音特质(说话方式)场景库,可结合不同场景调用该语音库,以解决不同场景中的问题;因此,可以为相关语音处理提供数据基础。

431.本技术实施例提供的语音库构建方法,通过采集用户的多个语音数据;确定各个语音数据的领域信息;根据所述用户、所述语音数据与所述领域间的对应关系,生成语音库;这种处理方式,使得构建不同人的领域知识场景库,可结合不同场景调用该语音库,以解决不同场景中的问题;因此,可以为相关语音处理提供数据基础。

432.本技术实施例提供的语音翻译系统,通过终端设备用于采集第一用户的源语言的第一语音数据,向服务端发送针对所述第一语音数据的由第二用户进行翻译的请求;以及,播放服务端回送的与第一语音数据对应的具有第二用户音色的目标语言的第二语音数据;服务端用于构建第二用户的语音转换模型;针对所述请求,生成与第一语音数据对应的第三用户的目标语言的第三语音数据;通过第二用户的语音转换模型,生成与第三语音数据对应的具有第二用户音色的目标语言的语音数据,作为所述第二语音数据;这种处理方式,使得即使第二用户不具有将源语言语音翻译成目标语言语音的能力,也能够生成第二用户将源语言语音翻译成目标语言的语音数据,即实现个性化的翻译,达到“说的跟真的一样”的翻译效果。

433.本技术实施例提供的跨语言语音生成系统,通过终端设备确定第一语言的文本,向服务端发送由第一用户朗读所述文本的语音生成请求;以及,播放服务端回送的第一用户朗读所述文本的第一语音数据;所述第一用户的母语为第二语言;服务端构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;以及,针对所述请求,确定第二用户朗读所述文本的第二语音数据,并通过所述ppg特征提取器,根据第二语音数据的包括第二用户声纹信息和语音内容信息的第一声学特征数据,确定第二语音数据的ppg特征数据;通过第一用户的所述语音合成模型,根据所述ppg特征数据、和第二语音数据的包括韵律信息的第二声学特征数据,生成所述第一语音数据;这种处理方式,使得即使第一用户不具有某语种的文本阅读能力,也能够生成第一用户朗读该语种文本的语音数据,实现跨语言的文本朗读。本技术实施例提供的跨方言语音生成系统,通过终端设备确定目标文本和目标方言,向服务端发送由第一用户用目标方言朗读所述文本的请求;以及,播放服务端回送的由第一用户用目标方言朗读所述文本的第一语音数据;服务端构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;以及,针对所述请求,确定第二用户用目标方言朗读所述文本的第二语音数据,并通过所述ppg特征提取器,根据第二语音数据的包括第二用户声纹信息和语音内容信息的第一声学特征数据,确定第二语音数据的ppg特征数据;通过第一用户的所述语音合成模型(第一语音合成模型),根据所述ppg特征数据、和第二语音数据的包括韵律信息的第二声学特征数据,生成所述第一语音数据;这种处理方式,使得即使第一用户不具有较好的方言听说能力,也能够生成第一用户用目标方言朗读文本的语音数据,实现跨方言的文本朗读。

434.本技术实施例提供的语音变声系统,通过终端设备确定第一用户的第一语音数据,向服务端发送将所述第一语音数据变声为第二用户声音的请求;服务端构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据;这种处理方式,使得使用ppg特征作为语音合成模块的输入,该ppg特征保

留了声学信息(如韵律和发音信息),每一帧的ppg特征可以在不同说话人之间通用,由此实现将第一用户的语音变声为第二用户的声音;因此,可以有效提升语音变声的准确度。同时,由于所述系统无需识别第一语音数据的文字信息,因此可以有效提升语音变声效率。

435.本技术实施例提供的跨语言语音交互系统,通过第一终端设备采集第一用户的源语言的第一语音数据,向服务端发送所述第一语音数据;服务端确定与第一语音数据对应的目标语言文本;根据第二用户的目标语言语音库,生成与所述目标语言文本对应的第二用户的目标语言的第二语音数据;通过第一用户的语音转换模型,生成与第二语音数据对应的具有第一用户音色的目标语言的第三语音数据;向第二终端设备发送第三语音数据;第二终端设备用于播放第三语音数据;这种处理方式,使得不同语言的用户相互之间可直接使用各自的母语进行语音交互;因此,可以有效提升跨语言的语音交互效率。

436.本技术实施例提供的语音交互系统,通过终端设备用于采集第一用户的第一语音数据,并确定目标说话方式,将所述第一语音数据转换为目标说话方式的第二语音数据,向服务端发送第二语音数据;服务端用于根据第二语音数据,确定回复信息,向终端设备回送回复信息;这种处理方式,使得终端设备向服务端发送的是用户指定的说话方式的语音数据,而非实际采集到的用户真实说话方式的语音数据,用户可通过指定说话方式,掩盖其真实情绪,服务端可根据改变说话方式后的语音数据,确定回复信息,这样即使对于相同的语音内容,如果说话方式不同,则服务端回复信息不同;因此,可以有效提升问答回复信息的准确度,从而提升用户体验。

437.本技术实施例提供的语音交互系统,通过第一终端设备用于采集第一用户的第一语音数据,并确定目标说话方式,向服务端发送第一语音数据发送请求;以及,播放第二终端设备通过服务端回送的第二用户的第二语音数据;服务端用于针对第一语音数据发送请求,将所述第一语音数据转换为第一用户的目标说话方式的第三语音数据,向第二终端设备发送第三语音数据;以及,将第二终端设备发送的第二语音数据发送至第一终端设备;第二终端设备用于播放第三语音数据;以及,采集第二语音数据,向服务端发送第二语音数据发送请求;这种处理方式,使得第一用户在与第二用户进行语音通讯时,第二终端设备播放的是第一用户指定说话方式的语音数据,而非实际采集到的第一用户真实说话方式的语音数据,第一用户可通过指定说话方式,向第二用户掩盖其真实情绪;因此,可以有效提升语音交互质量,从而提升用户体验。

438.本技术实施例提供的语音转换模型构建方法,通过构建各个用户的语音合成模型、和语音后验概率图谱ppg特征提取器,形成语音转换模型;其中,所述ppg特征提取器用于根据第一用户的第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;所述第一声学特征数据包括第一用户声纹信息和语音内容信息;所述语音合成模型用于根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据;所述第二声学特征数据包括韵律信息;这种处理方式,使得可使用ppg特征作为模型训练数据,构建支持跨语言、跨方言、同语言的语音转换的模型。此外,这种处理方式还使得仅使用一种语言的语音进行模型训练,就可以支持不同语言的输入语音进行语音转换,且可以在不同语言上获得同等的语音转换质量。再者,通过模型自适应训练,可以减少对目标说话人语音数量的要求,使用较少的语料即可达到较高的语音合成质量。

附图说明

439.图1本技术提供的一种语音消息发送系统的实施例的结构示意图;

440.图2本技术提供的一种语音消息发送系统的实施例的场景示意图;

441.图3本技术提供的一种语音消息发送系统的实施例的设备交互示意图;

442.图4本技术提供的一种语音转换方法的实施例的流程示意图;

443.图5本技术提供的一种语音转换方法的实施例的模型示意图;

444.图6本技术提供的一种语音转换方法的实施例的基于tacotron2模型结构的特征合成模块示意图;

445.图7本技术提供的一种语音转换方法的实施例的基于transformer模型结构的特征合成模块示意图;

446.图8申请提供的一种跨语言语音转换方法的实施例的基于fastspeech模型结构的特征合成模块示意图。

具体实施方式

447.在下面的描述中阐述了很多具体细节以便于充分理解本技术。但是本技术能够以很多不同于在此描述的其它方式来实施,本领域技术人员可以在不违背本技术内涵的情况下做类似推广,因此本技术不受下面公开的具体实施的限制。

448.在本技术中,提供了语音消息发送系统、方法和装置,影视配音系统、方法和装置,新闻播报系统、方法和装置,跨语言语音转换方法和装置,以及电子设备。在下面的实施例中逐一对各种方案进行详细说明。

449.第一实施例

450.请参考图1,其为本技术的语音消息发送系统的实施例的示意图。本实施例提供的语音消息发送系统包括:服务器1,第一终端设备2,第二终端设备3。

451.服务器,可以是部署在云端服务器上的服务端,也可以是专用于实现语音消息发送系统的服务器,可部署在数据中心。

452.所述第一终端设备和第二终端设备,包括但不限于移动通讯设备,即:通常所说的手机或者智能手机,还包括个人电脑、pad、ipad等终端设备。

453.请参考图2,其为本技术的语音消息发送系统的场景示意图。服务端、第一终端设备和第二终端设备间可通过网络连接,如第一终端设备和第二终端设备可通过wifi等方式联网,等等。语音信息发音方(第一用户)说一句具有第一用户音色的第一语音,并指定将该语音数据转换为第二用户的声音,第一语音数据上传至服务端,服务端将第一语音数据转换为具有第二用户声音的第二语音数据,将第二语音数据发送到第三用户的设备上播放。

454.例如,第一终端设备上安装输入法工具,在输入法工具中提供变声功能,第一用户在发送语音消息时,可以任意选择一个其他人的声音,另一端收到语音消息的人在播放语音消息时实际听到的是被选择的那个人的声音。

455.请参考图3,其为本技术的语音消息发送系统的设备示意图。在本实施例中,第一终端设备,用于采集第一用户的第一语音数据,向服务端发送将所述第一语音数据变声为第二用户声音的请求,所述第一用户与第二用户的母语不同;服务端,用于构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;通过所述ppg特征提取器,根

据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息是第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据;向第二终端设备发送第二语音数据;第一终端设备,用于播放第二语音数据。

456.所述第一用户与第二用户可以有相同母语,也可以具有不同母语。如果两个用户有相同母语,则通过所述系统实现同一语言不同用户音色的语音转换;如果两个用户有不同母语,则通过所述系统实现跨语言的语音转换。

457.服务端具体处理过程详见第二实施例的说明,此处不再赘述。

458.具体实施时,第一用户可通过第一终端设备指定第二用户,所述请求包括第二用户标识;服务端可预先构建并存储第二用户的语音合成模型,可根据第二用户标识,检索第二用户的语音合成模型参数,通过第二用户的语音合成模型,将第一用户的第一语音数据转换为具有第二用户音色的第二语音数据。当然,也可以是服务端存储与第一用户固定对应的第二用户,这样第一用户就无需通过第一终端设备指定第二用户,服务端只将第一用户的第一语音数据固定转换为具有第二用户音色的第二语音数据。

459.从上述实施例可见,本技术实施例提供的语音消息发送系统,通过第一终端设备采集第一用户的第一语音数据,向服务端发送将所述第一语音数据变声为第二用户声音的请求,所述第一用户与第二用户的母语不同;服务端构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息是第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据;向第二终端设备发送第二语音数据;第一终端设备播放第二语音数据;这种处理方式,使得使用ppg特征作为语音合成模块的输入,该ppg特征保留了声学信息(如韵律和发音信息),每一帧的ppg特征可以在不同说话人和不同语言之间通用,因而可以实现跨语言、跨方言、同语言的语音转换。此外,这种处理方式还使得仅使用一种语言的语音进行模型训练和系统建设,就可以支持不同语言的输入语音进行语音转换,且可以在不同语言上获得同等的语音转换质量。再者,通过模型自适应训练,可以减少对目标说话人语音数量的要求,使用较少的语料即可达到较高的语音合成质量。

460.第二实施例

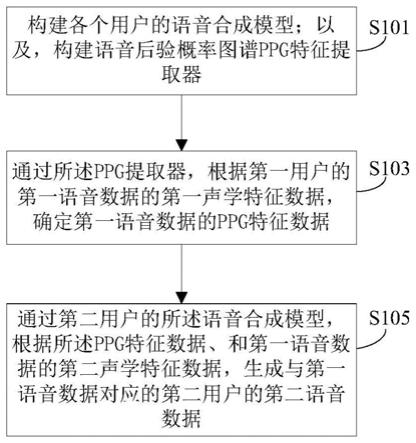

461.请参考图4,其为本技术的跨语言语音转换方法的实施例的流程图。本实施例提供的跨语言语音转换方法的执行主体可以是服务器等等。所述方法包括:

462.步骤s101:构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器。

463.语音后验概率(phonetic posterior gram,ppg)是一个时间对类别的矩阵,其表示对于一个话语的每个特定时间帧,每个语音类别的后验概率。语音类别可以指词、音素或音素状态(senone)。

464.一段语音可包括三方面信息:语音内容(说话内容),说话人音色(声纹),说话方式。其中,说话方式可以包括说话语气、韵律等。ppg特征可包括语音发音信息(如文本内容

的发音信息),还可包括部分说话方式信息。

465.所述ppg特征提取器,把说话人相关的每一帧声学特征提取成说话人不相关的语音后验图谱,该后验图谱保留了声学信息,如韵律和发音信息,每一帧的后验图谱可以在不同说话人之间通用,甚至可以在不同语言(如不同母语)、不同方言的说话人之间通用。

466.具体实施时,可使用语音识别系统里面的基于深度神经网络dnn的声学模型作为ppg提取器。本实施例选用5层gru的网络结构和488维的ppg向量,提取dnn声学模型输出层的前一层的输出用作ppg特征,然后对ppg特征实行对数刻度(logarithm scale)。

467.在一个示例中,从多个用户的语音数据的第一声学特征数据、与发音标注信息间的对应关系中学习得到所述提取器。所述第一声学特征数据,包括但不限于:梅尔频谱系数(mfcc)声学特征。mfcc是一种声学特征,包含声纹信息和语音内容信息。

468.所述ppg特征提取器为多个用户通用,所述语音合成模型为各个用户专用,也就是说,各个用户具有各自的语音合成模型。

469.在一个示例中,所述构建各个用户的语音合成模型,可采用如下方式实现:针对各个用户,根据该用户的语音数据的pps特征数据、第二声学特征数据与语音合成数据(waveform)间的对应关系集中,学习得到所述用户的语音合成模型。

470.所述第二声学特征数据,可包含韵律信息,具体实施时可以是log-f0特征等。mfcc可包含声纹信息和语音内容信息,log-f0可包含韵律信息。在本实施例中,ppg特征包含的韵律信息不充分,使用log-f0来补充ppg丢失的韵律信息。

471.如图5所示,在一个示例中,所述语音合成模型包括:特征合成网络模块(synthesizer network),和声码器(vocoder)。特征合成网络,用于根据所述ppg特征数据和所述第二声学特征数据(如log-f0),确定具有第二用户音色的第三声学特征数据(如lpcnet声学特征);声码器,用于根据第三声学特征数据,生成所述第二语音数据(waveform)。

472.所述第三声学特征数据,可包括:第一用户说话内容信息,第二用户的音色(声纹),第一用户说话方式(如语气、口音)。

473.具体实施时,特征合成网络模块可将ppg提取器提取出的ppg特征和从第一语音数据中提取出的log-f0,合成目标说话人的20维lpcnet声学特征。此模块的设计是基于已有的语音合成模型,如tacotron2,transformer,和fastspeech进行改进的,图6至图8示出了改进后tacotron2,transformer,和fastspeech。本实施例替换了语音合成模块的嵌入层embedding和输出层。语音合成模块的原输入层数据是字符(characters)或者音素(phonemes)嵌入(embedding),输出层数据是80维的语谱图spectrogram向量。

474.需要说明的是,训练上述三种特征合成网络所使用的ppg输入特征可以是跨语言的特征数据,也就是说在ppg级别上没有语言/语种的区分,因而使用ppg特征作为输入训练的特征合成网络模型可以应用在其它语言上。采用这种处理方式,使得仅使用一种语言的语音进行模型训练和系统建设,就可以支持不同语言的输入语音进行语音转换,且可以在不同语言上获得同等的语音转换质量。

475.所述声码器,可以采用lpcnet声码器,也可以采用wavernn声码器,等等。由于wavernn声码器在合成质量和实时性上存在局限,仍然落后于基于lpcnet的声码器,因此本实施例采用lpcnet声码器。lpcnet声码器将特征合成模块输出的声学特征合成音频文件,

如lpcnet声码器使用20维的声学特征作为输入数据,直接输出语音的waveform。

476.在本实施例中,单独训练三个模块:ppg提取器,特征合成模块,和lpcnet声码器。ppg提取器的训练可使用语音识别系统的语音训练库,可以选用公开的语音库,也可以使用不公开的语音库。具体实施时,可首先从语音库提取梅尔频谱系数(mfcc)声学特征和对齐的发音标注,然后可使用交叉熵损失(cross-entropy loss)进行训练,ppg提取器和说话人不相关。

477.在一个示例中,针对各个用户,从所述用户的语音数据的pps特征数据、第二声学特征数据与第三声学特征数据间的对应关系集中,学习得到所述特征合成网络。

478.具体实施时,特征合成模块的训练使用选定的目标说话人的语音库,首先从语音库中提取log-f0特征和lpcnet声学特征,以及通过ppg提取器提取后验图谱特征。后验图谱特征和log-f0特征为网络的输入特征,lpcnet声学特征为网络的输出特征,可使用mse loss进行网络训练。

479.在一个示例中,所述特征合成网络的结构包括fastspeech模型;所述fastspeech模型不包括:预测器和长度调节器。如图8所示,该改进的fastspeech模型去除了持续时间(duration)预测器(predictor)、和长度调节器(length regulator)自动调节器两个模块,还改进了fastspeech模型训练步骤,不用依赖于teacher模型的duration输出。采用基于该改进的fastspeech模型的特征合成网络,使得在语音转换阶段可调整合成语音的语速,从而提升语音合成的灵活性。

480.在图5中,encoder编码器是对ppg特征输入进行编码,生成更高级的信息表示,并有利于后面decoder解码器对输入信息的解码,解码器利用编码器的输出信息和log-f0生成目标lpcnet特征。

481.在一个示例中,针对各个用户,从所述用户的语音数据的第三声学特征数据与语音合成数据间的对应关系集中,学习得到所述声码器。

482.具体实施时,可采用lpcnet声码器,该声码器的训练使用同一目标说话人的语音库,lpcnet声学特征作为输入,语音的waveform作为输出,可使用mseloss进行训练。需要注意的是,特征合成模块和lpcnet声码器是说话人相关的。

483.步骤s101为模型构建阶段(模型训练阶段),在所有模块(pps特征提取器、特征合成网络和声码器)训练完成后,把所有模块联通,便可以进行语音转换。具体实施时,只需把上个模块的输出衔接到下个模块的输入即可,无需做特别处理。

484.步骤s103:通过所述ppg特征提取器,根据第一用户的第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据。

485.在一个示例中,第一用户为英国人,用地道的英语发音读了一段英文文本,可通过现有技术从该段语音中提取第一声学特征数据,如mfc特征等。

486.在另一个示例中,首先从第一用户(如说英语的人)的语音库中学习得到该用户朗读第一语言文字的方式,形成一个第一用户的语音合成模型;然后,对于第二用户(如说中文的人,但不会说英语或英语说的不好)要说的一段第一语言的文字,通过第一用户的语音合成模型,生成该段文字的具有第一用户音色的语音文件;然后,通过本实施例提供的所述方法,将该段语音转换为同样朗读方式的但具有第二用户音色的语音文件,由此实现一个说不好英语甚至不会说英语的人,也能说出地道的英语。

487.步骤s105:通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据。

488.步骤s103和步骤s105为语音转换阶段。

489.在本实施例中,步骤s103可包括如下子步骤:1)通过所述语音合成模型包括的特征合成网络,根据所述ppg特征数据和所述第二声学特征数据,确定具有第二用户音色的第三声学特征数据;2)通过所述语音合成模型包括的声码器,根据第三声学特征数据,生成所述第二语音数据。

490.对于给定需要转换的一句语音,选定目标说话人的特征合成网络和声码器,可从给定的一句语音提取出梅尔频谱系数特征(mfcc)和归一化后的log-f0特征,使用ppg提取器从梅尔频谱系数特征提取出ppg特征,然后把ppg特征和log-f0特征串联起来一起输入到特征合成模块,生成lpcnet声学特征,最后,由lpcnet声码器把lpcnet声学特征合成目标说话人的语音文件。

491.在一个示例中,所述特征合成网络的结构包括上述改进的fastspeech模型;所述fastspeech模型不包括:预测器和长度调节器;相应的,所述方法还可包括如下步骤:确定ppg特征数据的采样率,作为基于fastspeech模型的特征合成网络的ppg特征采样率;相应的,通过基于fastspeech模型的特征合成网络,根据所述ppg特征数据和所述第二声学特征数据,确定具有第二用户音色的与采样的ppg特征数据对应的第三声学特征数据;通过所述语音合成模型包括的声码器,根据第三声学特征数据,生成与所述采样率对应的语音播放速度的所述第二语音数据。

492.在fastspeech模型里,一帧ppg特征数据对应一帧第三声学特征数据,即一帧ppg特征对应一帧语音的输出。用户可以通过调节ppg特征的采样率进行语速的控制。进行加速设置时,ppt特征进行降低采样率处理,也就是根据一定间隔去除一帧ppg特征,相应的去除同一帧的合成语音,最终结果是合成的语音帧数减少,使用相同的播放速度,用户就会感觉到语音快速播放。在进行降速设置时,提升ppg特征的采样率,用户可感知到语音慢速播放。采用这种处理方式,使得可以调整合成语音的语速;因此,可以有效提升语音合成的灵活性。

493.具体实施时,要所述确定ppg特征数据的采样率,可采用如下子步骤:确定第二语音数据的播放速度;根据所述播放速度,确定所述采样率。采用这种处理方式,变速功能可以使用户在进行语音转换时控制变声后语音的播放速度,尤其在需要播放较长的语音时,快速播放可以节省时间,而慢速播放可以让用户听的更清楚。这里的变速功能没有改变语音的声调,因而感觉到仍是常规的语音。具体实施时,用户可以调整语音播放速度,所述方法可根据用户指定的速度,确定pps特征采样率,实现语音实时变速功能。

494.在一个示例中,所述第一用户与第二用户可以是具有不同的母语的两个用户,通过所述方法可实现跨语言的语音转换。例如,第二用户要读一段英文文本,但该用户是一个不会说英语或英语说的不好的中国人,为了达到该第二用户流利说英文的效果,可指定一个英国人作为第一用户,可先由该第一用户用地道的英语读该段英文文本,作为第一语音数据,然后通过本技术实施例提供的所述方法,生成与该第一语音数据对应的具有第二用户音色的第二语音数据,好像该第二用户具有较好的英语水平。

495.在另一个示例中,所述第一用户与第二用户可以是具有不同的方言,通过所述方

法可实现跨方言的语音转换。例如,第二用户要用粤语说一段话,但该用户不会说粤语或粤语说的不好,为了达到该第二用户流利说粤语的效果,可指定一个广东人作为第一用户,可先由该第一用户用流利的粤语说这段话,作为第一语音数据,然后通过本技术实施例提供的所述方法,生成与该第一语音数据对应的具有第二用户音色的第二语音数据,好像该第二用户具有较好的粤语水平。

496.在又一个示例中,采用本技术实施例提供的方法,也可对相同语言的第一用户与第二用户进行语音转换处理,实现音色的改变。例如,第二用户想像主持人一样字正腔圆的说一段话,但该用户的语言水平一般,为了达到该第二用户像主持人一样的播音效果,可指定一个主持人作为第一用户,可先由该主持人说这段话,作为第一语音数据,然后通过本技术实施例提供的所述方法,生成与该第一语音数据对应的具有第二用户音色的第二语音数据,好像该第二用户具有较好的语言水平。

497.具体实施时,可以通过模型自适应训练,减少对目标说话人语音数量的要求。经实验表明,可以仅使用500句目标说话人语音,合成的语音质量相比使用超过10000句语音训练的结果没有明显降低。自适应训练方法的原理是使用其它数据源先完成模型训练,然后在使用较少的目标数据进行优化迭代,因为模型执行的任务基本一致,模型参数只需要进行少量调整便可以适应到目标数据上,因而不需要太多目标数据进行迭代。

498.从上述实施例可见,本技术实施例提供的语音转换方法,通过构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;通过所述ppg特征提取器,根据第一用户的第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据。;根据实体信息,执行语音交互处理;这种处理方式,使得使用ppg特征作为语音合成模块的输入,该ppg特征保留了声学信息(如韵律和发音信息),每一帧的ppg特征可以在不同说话人和不同语言之间通用,因而可以实现跨语言、跨方言、同语言的语音转换。此外,这种处理方式还使得仅使用一种语言的语音进行模型训练和系统建设,就可以支持不同语言的输入语音进行语音转换,且可以在不同语言上获得同等的语音转换质量。再者,通过模型自适应训练,可以减少对目标说话人语音数量的要求,使用较少的语料即可达到较高的语音合成质量。

499.第三实施例

500.在上述的实施例中,提供了一种语音转换方法,与之相对应的,本技术还提供一种语音转换装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

501.本技术提供的一种语音转换装置包括:

502.模型构建单元,用于构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;

503.ppg特征提取单元,用于通过所述ppg特征提取器,根据第一用户的第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;所述第一声学特征数据包括第一用户声纹信息和语音内容信息;

504.语音合成单元,用于通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数

据;所述第二声学特征数据包括韵律信息。

505.第四实施例

506.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

507.本实施例的一种电子设备,该电子设备包括:处理器和存储器;存储器,用于存储实现语音转换方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;通过所述ppg特征提取器,根据第一用户的第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;所述第一声学特征数据包括第一用户声纹信息和语音内容信息;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据;所述第二声学特征数据包括韵律信息。

508.所述电子设备,可以是智能移动设备,个人电脑,智能音箱,聊天机器人,等等。

509.第五实施例

510.在上述的实施例中,提供了一种语音消息发送系统,与之相对应的,本技术还提供一种语音消息发送方法,该方法的执行主体可以是第一终端设备。该方法是与上述系统的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

511.本技术提供的一种语音消息发送方法,可包括如下步骤:

512.步骤1:采集第一用户的第一语音数据;

513.步骤2:向服务端发送将所述第一语音数据变声为第二用户声音的请求,以使得服务端构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;通过所述ppg特征提取器,根据第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据;向第二终端设备发送第二语音数据。

514.在一个示例中,第一终端设备装载输入法装置,该装置用于执行所述方法。

515.在另一个示例中,第一终端设备装载即时通讯装置,该装置用于执行所述方法。

516.第六实施例

517.在上述的实施例中,提供了一种语音消息发送方法,与之相对应的,本技术还提供一种语音消息发送装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

518.本技术提供的一种语音消息发送装置包括:

519.语音数据采集单元,用于采集第一用户的第一语音数据;

520.请求发送单元,用于向服务端发送将所述第一语音数据变声为第二用户声音的请求,以使得服务端构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;通过所述ppg特征提取器,根据第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的

第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据;向第二终端设备发送第二语音数据。

521.第七实施例

522.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

523.本实施例的一种电子设备,该电子设备包括:处理器和存储器;存储器,用于存储实现语音消息发送方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:采集第一用户的第一语音数据;向服务端发送将所述第一语音数据变声为第二用户声音的请求,以使得服务端构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;通过所述ppg特征提取器,根据第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据;向第二终端设备发送第二语音数据。

524.第八实施例

525.在上述的实施例中,提供了一种语音消息发送系统,与之相对应的,本技术还提供一种语音消息发送方法,该方法的执行主体可以是第二终端设备等。该方法是与上述系统的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

526.本技术提供的一种语音消息发送方法,可包括如下步骤:

527.步骤1:接收服务端发送的第二语音数据;所述第二语音数据采用如下方式生成:构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;针对第一终端设备发送的将第一用户的第一语音数据变声为第二用户声音的请求,通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据;

528.步骤2:播放所述第二语音数据。

529.第九实施例

530.在上述的实施例中,提供了一种语音消息发送方法,与之相对应的,本技术还提供一种语音消息发送装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

531.本技术提供的一种语音消息发送装置包括:

532.语音数据接收单元,用于接收服务端发送的第二语音数据;所述第二语音数据采用如下方式生成:构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;针对第一终端设备发送的将第一用户的第一语音数据变声为第二用户声音的请求,通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成与第一语音数

据对应的第二用户的第二语音数据;

533.语音播放单元,用于播放所述第二语音数据。

534.第十实施例

535.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

536.本实施例的一种电子设备,该电子设备包括:处理器和存储器;存储器,用于存储实现语音消息发送方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:接收服务端发送的第二语音数据;所述第二语音数据采用如下方式生成:构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;针对第一终端设备发送的将第一用户的第一语音数据变声为第二用户声音的请求,通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据;播放所述第二语音数据。

537.第十一实施例

538.在上述的实施例中,提供了一种语音转换方法,与之相对应的,本技术还提供一种影视配音系统。该系统是与上述方法的实施例相对应。本实施例中服务端的处理过程与第二实施例内容相同的部分不再赘述,请参见实施例二中的相应部分。

539.本技术提供的一种影视配音系统包括:终端设备和服务端。

540.其中,终端设备,用于采集第一用户针对影视台词文本的第一语音数据,向服务端发送将所述第一语音数据转换为第二用户配音的请求;服务端,用于构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成第二用户针对所述影视台词文本的第二语音数据。

541.所述第一用户与第二用户可以有相同母语,也可以具有不同母语。如果两个用户有相同母语,则通过所述系统实现同一语言的影视配音;如果两个用户有不同母语,则通过所述系统实现跨语言的影视配音。

542.在一个示例中,终端设备采集第一用户针对第一语言的影视台词文本的第一语音数据,第二用户的母语为第二语言。例如,在电影配音场景中,如演员a(第二用户)本人的母语为中文,但当电影需要该演员a说英文时,跨语言语音转换可以将一句英文演员b(第一用户)说的话(第一语音数据)替换成演员a的声音,从而产生演员a的说英文的声音(第二语音数据)。

543.在另一个示例中,终端设备采集第一用户针对第一语言的影视台词文本的第一语音数据,第二用户的母语也为第一语言,如两个用户的母语都是中文。例如,在电影配音场景中,如演员a(第二用户)本人的母语为中文、且为标准普通话,但当电影需要该演员a说广东话时,跨语言语音转换可以将一句广东话演员b(第一用户)说的话(第一语音数据)替换

成演员a的声音,从而产生演员a的说广东话的声音(第二语音数据)。

544.从上述实施例可见,本技术实施例提供的影视配音系统,通过终端设备采集第一用户针对影视台词文本的第一语音数据,向服务端发送将所述第一语音数据转换为第二用户配音的请求;服务端构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成第二用户针对所述影视台词文本的第二语音数据;这种处理方式,使得使用ppg特征作为语音合成模块的输入,该ppg特征保留了声学信息(如韵律和发音信息),每一帧的ppg特征可以在不同说话人和不同语言之间通用,因而可以实现跨语言、跨方言、同语言的影视配音。此外,这种处理方式还使得仅使用一种语言的语音进行模型训练和系统建设,就可以支持不同语言的输入语音进行影视配音,且可以在不同语言上获得同等的影视配音质量。再者,通过模型自适应训练,可以减少对目标说话人语音数量的要求,使用较少的语料即可达到较高的语音合成质量。

545.第十二实施例

546.在上述的实施例中,提供了一种影视配音系统,与之相对应的,本技术还提供一种影视配音方法,该方法的执行主体可以是终端设备等。该方法是与上述系统的实施例相对应。本实施例与第十一实施例内容相同的部分不再赘述,请参见实施例十一中的相应部分。

547.本技术提供的一种影视配音方法,可包括如下步骤:

548.步骤1:采集第一用户针对第一语言的影视台词文本的第一语音数据;

549.步骤2:向服务端发送将所述第一语音数据转换为第二用户配音的请求,以使得服务端构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;通过所述ppg特征提取器,根据第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成第二用户针对所述影视台词文本的第二语音数据,所述第二用户的母语可以为第二语言。

550.第十三实施例

551.在上述的实施例中,提供了一种影视配音方法,与之相对应的,本技术还提供一种影视配音装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

552.本技术提供的一种影视配音装置包括:

553.语音数据采集单元,用于采集第一用户针对第一语言的影视台词文本的第一语音数据;

554.请求发送单元,用于向服务端发送将所述第一语音数据转换为第二用户配音的请求,以使得服务端构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;通过所述ppg特征提取器,根据第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成第二用户针对所述影视台词文本的第二语音数据。

555.第十四实施例

556.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

557.本实施例的一种电子设备,该电子设备包括:处理器和存储器;存储器,用于存储实现影视配音方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:采集第一用户针对第一语言的影视台词文本的第一语音数据;向服务端发送将所述第一语音数据转换为第二用户配音的请求,以使得服务端构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;通过所述ppg特征提取器,根据第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成第二用户针对所述影视台词文本的第二语音数据。

558.第十五实施例

559.在上述的实施例中,提供了一种语音转换方法,与之相对应的,本技术还提供一种新闻播报系统。该系统是与上述方法的实施例相对应。本实施例中服务端的处理过程与第二实施例内容相同的部分不再赘述,请参见实施例二中的相应部分。

560.本技术提供的一种新闻播报系统包括:终端设备和服务端。

561.其中,终端设备用于采集待播报新闻文本的多种语言版本的第一用户的第一语音数据,向服务端发送由第二用户声音播报多种语言的待播报新闻文本的请求,所述第二用户的母语可以为多种语言以外的语言;服务端用于构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;针对各个语言的第一语音数据,通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成由第二用户播报的多种语言的第二语音数据。

562.在新闻播报场景中,希望使用一个人声音可以合成多种语言的声音(如用某个著名播音员的声音播放多种语言的新闻),但通常情况下,一个人不太可能同时精通多种语言,这时可以通过跨语言语音转换,使用这个人的声音,生成不同语言的声音,使用这些声音,可以建设多语言语音合成系统(tts)。

563.在一个示例中,要由一个中文播音员播报一条新闻的中文、英文、日文、法文等多个语言版本,而该播音员的播音水平仅限于中文和英文,通过跨语言语音转换可以将日文播音员播报的日语版新闻替换成该中文播音员的声音,将法文播音员播报的法文版新闻替换成该中文播音员的声音,从而产生该中文播音员的说法文和日文的声音。

564.在另一个示例中,要由一个中文标准话播音员播报一条新闻的粤语版、东北话版、闽南话版等多个语言版本,而该播音员的播音水平仅限于中文标准话,通过跨语言语音转换可以将粤语播音员播报的粤语版新闻替换成该标准话播音员的声音,将闽南话播音员播报的闽南话版新闻替换成该标准话播音员的声音,从而产生该中文播音员的说粤语版、东北话版、闽南话的声音。

565.具体实施时,不同语言版本的第一语音数据,可由不同第一用户播报,如由一个英国人说英文版的新闻,由一个法国人说法语版的新闻,有一个广东人说粤语版的新闻,等

等。

566.从上述实施例可见,本技术实施例提供的新闻播报系统,通过终端设备采集待播报新闻文本的多种语言版本的第一用户的第一语音数据,向服务端发送由第二用户声音播报多种语言的待播报新闻文本的请求;服务端构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;针对各个语言的第一语音数据,通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成由第二用户播报的多种语言的第二语音数据;这种处理方式,使得使用ppg特征作为语音合成模块的输入,该ppg特征保留了声学信息(如韵律和发音信息),每一帧的ppg特征可以在不同说话人和不同语言之间通用,因而可以实现跨语言、跨方言、同语言的新闻播报。此外,这种处理方式还使得仅使用一种语言的语音进行模型训练和系统建设,就可以支持不同语言的输入语音进行新闻播报,且可以在不同语言上获得同等的新闻播报质量。再者,通过模型自适应训练,可以减少对目标说话人语音数量的要求,使用较少的语料即可达到较高的语音合成质量。

567.第十六实施例

568.在上述的实施例中,提供了一种新闻播报系统,与之相对应的,本技术还提供一种新闻播报方法,该方法的执行主体可以是终端设备等。该方法是与上述系统的实施例相对应。本实施例与第十五实施例内容相同的部分不再赘述,请参见实施例十五中的相应部分。

569.本技术提供的一种新闻播报方法,可包括如下步骤:

570.步骤1:采集待播报新闻文本的多种语言版本的第一用户的第一语音数据;

571.步骤2:向服务端发送由第二用户声音播报所述多种语言版本的待播报新闻文本的请求,以使得服务端构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;针对各个语言的第一语音数据,通过所述ppg特征提取器,根据第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成由第二用户播报的多种语言的第二语音数据。

572.第十七实施例

573.在上述的实施例中,提供了一种新闻播报方法,与之相对应的,本技术还提供一种新闻播报装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

574.本技术提供的一种新闻播报装置包括:

575.语音数据采集单元,用于采集待播报新闻文本的多种语言版本的第一用户的第一语音数据;

576.请求发送单元,用于向服务端发送由第二用户声音播报所述多种语言版本的待播报新闻文本的请求,以使得服务端构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;针对各个语言的第一语音数据,通过所述ppg特征提取器,根据第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成由第二用户播报的多种语言的第二语音数据。

577.第十八实施例

578.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

579.本实施例的一种电子设备,该电子设备包括:处理器和存储器;存储器,用于存储实现新闻播报方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:采集待播报新闻文本的多种语言版本的第一用户的第一语音数据;向服务端发送由第二用户声音播报所述多种语言版本的待播报新闻文本的请求,以使得服务端构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;针对各个语言的第一语音数据,通过所述ppg特征提取器,根据第一语音数据的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的第二声学特征数据,生成由第二用户播报的多种语言的第二语音数据。

580.第十九实施例

581.在上述的实施例中,提供了一种语音转换方法,与之相对应的,本技术还提供一种语音交互系统。该系统是与上述方法的实施例相对应。本实施例中服务端的处理过程与第二实施例内容相同的部分不再赘述,请参见实施例二中的相应部分。

582.本技术提供的一种语音交互系统包括:第一终端设备、服务端和第二终端设备。

583.其中,第一终端设备用于确定第一用户对第二用户的交互信息,向服务端发送所述交互信息;服务端用于构建第一用户的多种说话方式的语音合成模型;确定与所述交互信息对应的第一用户的目标说话方式信息;通过第一用户的目标说话方式的语音合成模型,生成所述交互信息的具有目标说话方式的语音数据,将语音数据发送至第二用户的第二终端设备;第二终端设备用于播放所述语音数据。

584.在一个示例中,第一终端设备和第二终端设备均装载即时通讯工具(如钉钉),第一用户通过即时通讯工具与第二用户间进行通讯,如发语音消息等;第一用户可输入文本式的交互信息,也可输入语音式的交互信息;服务端可将该交互信息合成为第一用户的目标说话方式的语音数据,第二用户的第二终端设备通过即时通讯工具接收并播放该语音数据。

585.所述说话方式,可以是温柔式、铿锵有力式等。下表1示出了本实施例中服务端存储的用户关系与说话方式间的对应关系,表2示出了本实施例中服务端存储的用户间的关系。

586.用户关系第一用户的说话方式第二用户是第一用户的客户真诚、专业、尊重第一用户是第二用户的客户存在感第一用户是第二用户的领导权威、严肃第一用户是第二用户的下属尊重、谦恭第一用户和第二用户为同事关系友好第一用户是第二用户的父母关爱第一用户是第二用户的孩子尊重

587.表1、用户关系与说话方式间的对应关系

588.第一用户标识第二用户标识用户关系用户a用户b第二用户是第一用户的客户用户a用户c第一用户是第二用户的客户

…ꢀ…

589.表2、用户间的关系

590.服务端根据表1所示的用户关系与说话方式间的对应关系、和表2所示的用户间的关系即可确定第一用户的目标说话方式。

591.所述语音合成模型,可以是一个不同说话方式通用的模型,模型输入数据包括交互信息和说话方式信息,输出数据包括目标说话方式的语音数据。所述交互信息如果是文字信息,则模型输入数据为相应的词嵌入数据;所述交互信息如果是语音信息,则模型输入数据为相应的声学特征数据。

592.所述语音合成模型,也可以是包括不同说话方式分别对应的不同的模型,模型输入数据包括交互信息。所述服务端要构建第一用户的多种说话方式的语音合成模型,可采用如下方式:针对各种说话方式,从第一用户的该说话方式的语音数据中学习得到相应的语音合成模型,该模型可包括该说话方式的语音调性等信息。

593.具体实施时,可先对各条语音数据的说话方式进行标注,将语音数据与说话方式的标注信息作为训练数据,然后可构建语音合成模型的网络结构,根据训练数据对网络进行训练,训练结果包括网络参数。所述网络结构,可以是神经网络结构,包括dnn、cnn等结构。

594.在一个示例中,第一用户通过第一终端设备指定目标说话方式信息,并将该信息发送至服务端。

595.在一个示例中,服务端要确定第一用户的目标说话方式信息,可具体采用如下方式:根据第二用户与第一用户的关系信息,确定所述目标说话方式信息。例如,第二用户是第一用户的客户,则目标说话方式包括真诚、专业、尊重等;第一用户是第二用户的客户,则目标说话方式可包括存在感等,这样可以让消费者对商家说话时更具有存在感;第一用户是第二用户的领导,则目标说话方式可包括权威、严肃等,这样可以让领导对下属说话时更偏向严肃;第一用户是第二用户的下属,则目标说话方式可包括尊重、谦恭等,这样使得下属对领导说话偏向谦恭;第一用户和第二用户为同事关系,则目标说话方式可包括友好等,这样使得平级同事间说话方式偏向友好;父母对孩子说话偏向关爱,孩子对父母说话偏向尊重,等等。采用这种处理方式,使得根据与对话对象之间的关系,生成合适说话方式的语音数据;因此,可以有效提升语音/语言调性的准确度,从而提升用户体验。

596.在一个示例中,服务端要确定第一用户的目标说话方式信息,可具体采用如下方式:确定所述交互信息所属领域;根据第一用户和第二用户各自的领域信息和所属领域,确定所述目标说话方式信息。所述领域,包括但不限于:电商运营领域、法律领域、生物制药领域等。例如,第二用户为儿童教育专家,第一用户为家长,交互内容为孩子教育问题,则第一用户说话方式应更为尊重,目标说话方式包括尊重、客气等。

597.在一个示例中,所述交互信息包括:语音交互信息;所述服务端还用于构建语音后验概率图谱ppg特征提取器;通过所述ppg特征提取器,确定所述语音交互信息的ppg特征数据;通过所述目标说话方式的语音合成模型,根据所述ppg特征数据,生成所述语音数据。采

用这种处理方式,使得ppg特征不包括原有语音的说话方式信息,而是包括语音内容信息,然后通过语音合成模型重新合成第一用户的目标说话方式的语音数据,第一用户可直接通过语音方式与第二用户进行交互;因此,可以有效提升用户体验。

598.从上述实施例可见,本技术实施例提供的语音交互系统,通过第一终端设备确定第一用户对第二用户的交互信息,向服务端发送所述交互信息;服务端构建第一用户的多种说话方式的语音合成模型;确定与所述交互信息对应的第一用户的目标说话方式信息;通过第一用户的目标说话方式的语音合成模型,生成所述交互信息的具有目标说话方式的语音数据,将语音数据发送至第二用户的第二终端设备;第二终端设备播放语音数据;这种处理方式,使得根据不同环境下的特性,生成合适说话方式的语音数据;因此,可以有效提升语音调性的准确度,从而提升用户体验。

599.第二十实施例

600.在上述的实施例中,提供了一种语音交互系统,与之相对应的,本技术还提供一种语音交互方法,该方法的执行主体可以是服务端等。该方法是与上述系统的实施例相对应。本实施例与第十九实施例内容相同的部分不再赘述,请参见实施例十九中的相应部分。

601.本技术提供的一种语音交互方法,可包括如下步骤:

602.步骤1:构建第一用户的多种说话方式的语音合成模型;

603.步骤2:针对第一用户对第二用户的交互信息,确定第一用户的目标说话方式信息;

604.步骤3:通过第一用户的目标说话方式的语音合成模型,生成所述交互信息的具有目标说话方式的语音数据,将语音数据发送至第二用户的终端设备。

605.在一个示例中,所述确定第一用户的目标说话方式信息,可采用如下方式:根据第二用户与第一用户的关系信息,确定所述目标说话方式信息。

606.在一个示例中,所述确定第一用户的目标说话方式信息,可采用如下方式:确定所述交互信息所属领域;根据第一用户和第二用户各自的领域信息和所属领域,确定所述目标说话方式信息。

607.在一个示例中,所述交互信息包括:语音交互信息;所述方法还包括如下步骤:构建语音后验概率图谱ppg特征提取器;通过所述ppg特征提取器,确定所述语音交互信息的ppg特征数据;通过所述目标说话方式的语音合成模型,根据所述ppg特征数据,生成所述语音数据。

608.第二十一实施例

609.在上述的实施例中,提供了一种语音交互方法,与之相对应的,本技术还提供一种语音交互装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

610.本技术提供的一种语音交互装置包括:

611.模型构建单元,用于构建第一用户的多种说话方式的语音合成模型;

612.说话方式确定单元,用于针对第一用户对第二用户的交互信息,确定第一用户的目标说话方式信息;

613.语音合成单元,用于通过第一用户的目标说话方式的语音合成模型,生成所述交互信息的具有目标说话方式的语音数据,将语音数据发送至第二用户的终端设备。

614.第二十二实施例

615.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

616.本实施例的一种电子设备,该电子设备包括:处理器和存储器;存储器,用于存储实现语音交互方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:构建第一用户的多种说话方式的语音合成模型;针对第一用户对第二用户的交互信息,确定第一用户的目标说话方式信息;通过第一用户的目标说话方式的语音合成模型,生成所述交互信息的具有目标说话方式的语音数据,将语音数据发送至第二用户的终端设备。

617.第二十三实施例

618.在上述的实施例中,提供了一种语音交互系统,与之相对应的,本技术还提供一种语音交互方法,该方法的执行主体可以是第一终端设备等。该方法是与上述系统的实施例相对应。本实施例与第十九实施例内容相同的部分不再赘述,请参见实施例十九中的相应部分。

619.本技术提供的一种语音交互方法,可包括如下步骤:

620.步骤1:确定第一用户对第二用户的交互信息;

621.步骤2:向服务端发送所述交互信息,以便于服务端确定与所述交互信息对应的第一用户的目标说话方式信息;通过第一用户的目标说话方式的语音合成模型,生成所述交互信息的具有目标说话方式的语音数据,将语音数据发送至第二用户的终端设备。

622.第二十四实施例

623.在上述的实施例中,提供了一种语音交互方法,与之相对应的,本技术还提供一种语音交互装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

624.本技术提供的一种语音交互装置包括:

625.信息确定单元,用于确定第一用户对第二用户的交互信息;

626.信息发送单元,用于向服务端发送所述交互信息,以便于服务端确定与所述交互信息对应的第一用户的目标说话方式信息;通过第一用户的目标说话方式的语音合成模型,生成所述交互信息的具有目标说话方式的语音数据,将语音数据发送至第二用户的终端设备。

627.第二十五实施例

628.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

629.本实施例的一种电子设备,该电子设备包括:处理器和存储器;存储器,用于存储实现语音交互方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:确定第一用户对第二用户的交互信息;向服务端发送所述交互信息,以便于服务端确定与所述交互信息对应的第一用户的目标说话方式信息;通过第一用户的目标说话方式的语音合成模型,生成所述交互信息的具有目标说话方式的语音数据,将语音数据发送至第

二用户的终端设备。

630.第二十六实施例

631.在上述的实施例中,提供了一种语音交互系统,与之相对应的,本技术还提供一种语音交互方法,该方法的执行主体可以是第二终端设备等。该方法是与上述系统的实施例相对应。本实施例与第十九实施例内容相同的部分不再赘述,请参见实施例十九中的相应部分。

632.本技术提供的一种语音交互方法,可包括如下步骤:

633.步骤1:接收服务端发送的第一用户的具有目标说话方式的语音数据;

634.步骤2:播放所述语音数据。

635.第二十七实施例

636.在上述的实施例中,提供了一种语音交互方法,与之相对应的,本技术还提供一种语音交互装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

637.本技术提供的一种语音交互装置包括:

638.数据接收单元,用于接收服务端发送的第一用户的具有目标说话方式的语音数据;

639.语音播放单元,用于播放所述语音数据。

640.第二十八实施例

641.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

642.本实施例的一种电子设备,该电子设备包括:处理器和存储器;存储器,用于存储实现语音交互方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:接收服务端发送的第一用户的具有目标说话方式的语音数据;播放所述语音数据。

643.第二十九实施例

644.在上述的实施例中,提供了一种语音转换方法,与之相对应的,本技术还提供一种语音交互系统。该系统是与上述方法的实施例相对应。本实施例中服务端的处理过程与第二实施例内容相同的部分不再赘述,请参见实施例二中的相应部分。

645.本技术提供的一种语音交互系统包括:第一终端设备、服务端和第二终端设备。

646.其中,第一终端设备用于根据第二用户对第一用户的交互信息,向服务端发送针对所述交互信息的请求帮助回复请求;服务端用于构建各个用户的语音库;确定与所述交互信息对应的目标领域,并根据与所述目标领域对应的第三用户的语音库,生成具有第一用户音色的源于第三用户在所述目标领域的知识的语音数据,将语音数据发送至第二用户的终端设备;第二终端设备用于播放所述语音数据。

647.服务端建立各个用户的语音库,如果第二用户对第一用户的交互信息涉及第一用户不熟悉的领域,可以通过第一终端设备向服务端发送请求帮助回复请求,由服务端根据其它用户在该领域的语音数据,确定第一用户向第二用户的语音回复信息。所述领域,包括但不限于:计算机技术领域、法律领域、电商领域、专利领域等。采用这种处理方式,使得一个用户对于自己不熟悉的领域,可从他人的语音库中得到帮助。例如,用户a和用户b交流儿

童教育领域的问题,用户b虽然比较熟悉该领域,但对其中某个细分领域并不熟悉,此时用户b可借鉴该细分领域的专家用户c的语音库中的相关知识,回复用户a提出的该细分领域内的一些问题。

648.第二用户对第一用户的交互信息可以是文本式的交互信息,也可以是语音式的交互信息。在本实施例中,第一终端设备和第二终端设备均装载即时通讯工具(如钉钉),第一用户通过即时通讯工具与第二用户间进行通讯,如发语音消息等,第二用户的第二终端设备可通过即时通讯工具接收并播放服务端生成的语音数据。具体实施时,第一用户与第二用户也可通过其它语音交互工具进行通讯。

649.在本实施例中,服务端存储用户与语音数据间的对应记录,形成各个用户的语音库;并可根据语音数据的具体内容,确定各条语音数据所关联的领域。所述领域可以包括一级领域(如专利领域)和二级领域(如侵权判定子领域、专利运营子领域)等。

650.具体实施时,服务端针对第一终端设备发送的所述请求,可先通过语音识别技术确定所述交互信息的文字内容;然后根据所述文字内容,确定关联的目标领域。此外,也可以是由第一用户在所述请求中指定目标领域,也可以是第二用户向第一用户发送所述交互信息时指定目标领域。

651.服务端在确定目标领域后,可根据该领域涉及的第三用户(一个用户或多个用户)的语音库,确定第一用户向第二用户回复的源于第三用户在所述目标领域的知识的信息,并通过第一用户的语音合成模型,生成具有第一用户音色的语音回复数据。

652.在一个示例中,第一用户可指定第三用户,这样可以只是借鉴该第三用户的语音库的相关领域知识,与第二用户进行交流。采用这种处理方式,使得可借鉴专业程度较高的某个专家的领域知识,而非一般从业人员的专业程度较低的领域知识;因此,可以有效提升回复信息的准确度,从而提升用户体验。

653.在另一个示例中,服务端根据多个第三用户的语音数据,为第一用户提供帮助,这样可以借鉴更多用户的语音库的相关领域知识,与第二用户进行交流。采用这种处理方式,使得可借鉴更多相关人员的领域知识,而非只借鉴某个专家的领域知识;因此,可以有效提升回复信息的准确度,从而提升用户体验。

654.在又一个示例中,服务端可根据第二用户的属性信息(如性别、年龄段等)和/或偏好信息,确定第三用户,并根据该自动确定的第三用户的语音库,为第一用户提供帮助,这样可以生成适合于第二用户的回复信息。采用这种处理方式,使得生成更适于第二用户的回复信息,该信息对其他第二用户可能并不适用;因此,可以有效提升回复信息的精准度,从而提升用户体验。

655.在一个示例中,服务端可根据用户的语音库,预先将语音数据转换为相关领域的知识,可以是为每个用户生成知识库,也可以是根据所有用户的语音库,生成通用知识库,然后根据这些知识,确定与所述交互信息对应的回复信息。所述第一用户的语音合成模型,可根据第一用户的语音数据训练得到,此处不再赘述。

656.服务端生成第一用户的语音回复数据后,将该数据发送至第二用户的第二终端设备播放,以供第二用户查看。

657.从上述实施例可见,本技术实施例提供的语音交互系统,通过第一终端设备根据第二用户对第一用户的交互信息,向服务端发送针对所述交互信息的请求帮助回复请求;

服务端构建各个用户的语音库;确定与所述交互信息对应的目标领域,并根据与所述目标领域对应的第三用户的语音库,生成具有第一用户音色的源于第三用户在所述目标领域的知识的语音数据,将语音数据发送至第二用户的终端设备;这种处理方式,使得在第二用户对第一用户的交互信息涉及第一用户不熟悉的领域,第一用户可借鉴其他用户在该领域的语音数据,确定第一用户向第二用户的语音回复信息;因此,可以有效提升语音回复的准确度,从而提升用户体验。

658.第三十实施例

659.在上述的实施例中,提供了一种语音交互系统,与之相对应的,本技术还提供一种语音交互方法,该方法的执行主体可以是服务端等。该方法是与上述系统的实施例相对应。本实施例与第二十九实施例内容相同的部分不再赘述,请参见实施例二十九中的相应部分。

660.本技术提供的一种语音交互方法,可包括如下步骤:

661.步骤1:构建各个用户的语音库;

662.步骤2:针对第一终端设备发送的针对第二用户对第一用户的交互信息的请求帮助回复的请求,确定与所述交互信息对应的目标领域;

663.步骤3:通过与所述目标领域对应的第三用户的语音库,生成具有第一用户音色的源于第三用户在所述目标领域的知识的语音数据,将语音数据发送至第二用户的终端设备。

664.第三十一实施例

665.在上述的实施例中,提供了一种语音交互方法,与之相对应的,本技术还提供一种语音交互装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

666.本技术提供的一种语音交互装置包括:

667.语音库构建单元,用于构建各个用户的语音库;

668.领域确定单元,用于针对第一终端设备发送的针对第二用户对第一用户的交互信息的请求帮助回复请求,确定与所述交互信息对应的目标领域;

669.语音数据发送单元,用于通过与所述目标领域对应的第三用户的语音库,生成具有第一用户音色的源于第三用户在所述目标领域的知识的语音数据,将语音数据发送至第二用户的终端设备。

670.第三十二实施例

671.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

672.本实施例的一种电子设备,该电子设备包括:处理器和存储器;存储器,用于存储实现语音交互方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:构建各个用户的语音库;针对第一终端设备发送的针对第二用户对第一用户的交互信息的请求帮助回复请求,确定与所述交互信息对应的目标领域;通过与所述目标领域对应的第三用户的语音库,生成具有第一用户音色的源于第三用户在所述目标领域的知识的语音数据,将语音数据发送至第二用户的终端设备。

673.第三十三实施例

674.在上述的实施例中,提供了一种语音交互系统,与之相对应的,本技术还提供一种语音交互方法,该方法的执行主体可以是第一终端设备等。该方法是与上述系统的实施例相对应。本实施例与第二十九实施例内容相同的部分不再赘述,请参见实施例二十九中的相应部分。

675.本技术提供的一种语音交互方法,可包括如下步骤:

676.步骤1:接收第二用户对第一用户的交互信息;

677.步骤2:向服务端发送针对所述交互信息的请求帮助回复请求。

678.第三十四实施例

679.在上述的实施例中,提供了一种语音交互方法,与之相对应的,本技术还提供一种语音交互装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

680.本技术提供的一种语音交互装置包括:

681.信息接收单元,用于接收第二用户对第一用户的交互信息;

682.请求发送单元,用于向服务端发送针对所述交互信息的请求帮助回复请求。

683.第三十五实施例

684.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

685.本实施例的一种电子设备,该电子设备包括:处理器和存储器;存储器,用于存储实现语音交互方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:接收第二用户对第一用户的交互信息;向服务端发送针对所述交互信息的请求帮助回复请求。

686.第三十六实施例

687.在上述的实施例中,提供了一种语音交互系统,与之相对应的,本技术还提供一种语音交互方法,该方法的执行主体可以是第二终端设备等。该方法是与上述系统的实施例相对应。本实施例与第十九实施例内容相同的部分不再赘述,请参见实施例十九中的相应部分。

688.本技术提供的一种语音交互方法,可包括如下步骤:

689.步骤1:向服务端发送第二用户对第一用户的交互信息;

690.步骤2:接收服务端发送的针对所述交互信息的具有第一用户音色的源于第三用户在目标领域的知识的语音回复数据;

691.步骤3:播放所述语音回复数据。

692.第三十七实施例

693.在上述的实施例中,提供了一种语音交互方法,与之相对应的,本技术还提供一种语音交互装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

694.本技术提供的一种语音交互装置包括:

695.数据发送单元,用于向服务端发送第二用户对第一用户的交互信息;

696.数据接收单元,用于接收服务端发送的针对所述交互信息的具有第一用户音色的源于第三用户在目标领域的知识的语音回复数据;

697.语音播放单元,用于播放所述语音回复数据。

698.第三十八实施例

699.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

700.本实施例的一种电子设备,该电子设备包括:处理器和存储器;存储器,用于存储实现语音交互方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:向服务端发送第二用户对第一用户的交互信息;接收服务端发送的针对所述交互信息的具有第一用户音色的源于第三用户在目标领域的知识的语音回复数据;播放所述语音回复数据。

701.第三十九实施例

702.在上述的实施例中,提供了一种语音交互系统,与之相对应的,本技术还提供一种语音交互方法,该方法的执行主体可以是服务端等。该方法是与上述系统的实施例相对应。本实施例与系统实施例内容相同的部分不再赘述,请参见系统实施例中的相应部分。

703.本技术提供的一种语音库构建方法,可包括如下步骤:

704.步骤1:采集用户的多个语音数据;

705.步骤2:确定各个语音数据的说话方式信息;

706.步骤3:根据所述用户、所述语音数据与所述说话方式间的对应关系,生成语音库。

707.在一个示例中,所述方法还可包括如下步骤:根据所述语音库,构建用户的多种说话方式的语音合成模型。

708.所述语音合成模型,可以是一个不同说话方式通用的模型,模型输入数据可包括交互信息和说话方式信息,输出数据包括目标说话方式的语音数据。所述交互信息如果是文字信息,则模型输入数据为相应的词嵌入数据;所述交互信息如果是语音信息,则模型输入数据可包括相应的声学特征数据。

709.所述语音合成模型,也可以是不同说话方式分别对应不同的语音合成模型,模型输入数据可包括交互信息。要构建用户的多种说话方式的语音合成模型,可采用如下方式:针对各种说话方式,从用户的该说话方式的语音数据中学习得到相应的语音合成模型,该模型可包括该说话方式的语音调性等信息。

710.从上述实施例可见,本技术实施例提供的语音库构建方法,通过采集用户的多个语音数据;确定各个语音数据的说话方式信息;根据所述用户、所述语音数据与所述说话方式间的对应关系,生成语音库;这种处理方式,使得构建不同人的语音特质(说话方式)场景库,可结合不同场景调用该语音库,以解决不同场景中的问题;因此,可以为相关语音处理提供数据基础。

711.第四十实施例

712.在上述的实施例中,提供了一种语音库构建方法,与之相对应的,本技术还提供一种语音库构建装置。该装置是与上述方法的实施例相对应。本实施例与第三十九实施例内容相同的部分不再赘述,请参见实施例三十九中的相应部分。

713.本技术提供的一种语音库构建装置包括:

714.语音数据采集单元,用于采集用户的多个语音数据;

715.说话方式确定单元,用于确定各个语音数据的说话方式信息;

716.语音库生成单元,用于根据所述用户、所述语音数据与所述说话方式间的对应关系,生成语音库。

717.第四十一实施例

718.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

719.本实施例的一种电子设备,该电子设备包括:处理器和存储器;存储器,用于存储实现语音交互方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:采集用户的多个语音数据;确定各个语音数据的说话方式信息;根据所述用户、所述语音数据与所述说话方式间的对应关系,生成语音库。

720.第四十二实施例

721.在上述的实施例中,提供了一种语音交互系统,与之相对应的,本技术还提供一种语音库构建方法,该方法的执行主体可以是服务端等。该方法是与上述系统的实施例相对应。本实施例与系统实施例内容相同的部分不再赘述,请参见系统实施例中的相应部分。

722.本技术提供的一种语音库构建方法,可包括如下步骤:

723.步骤1:采集用户的多个语音数据。

724.步骤2:确定各个语音数据的领域信息。

725.所述领域,可以包括一级领域(如专利领域、生物制药领域)和二级领域(如侵权判定子领域、专利运营子领域)等。

726.步骤3:根据所述用户、所述语音数据与所述领域间的对应关系,生成语音库。

727.从上述实施例可见,本技术实施例提供的语音库构建方法,通过采集用户的多个语音数据;确定各个语音数据的领域信息;根据所述用户、所述语音数据与所述领域间的对应关系,生成语音库;这种处理方式,使得构建不同人的领域知识场景库,可结合不同场景调用该语音库,以解决不同场景中的问题;因此,可以为相关语音处理提供数据基础。

728.第四十三实施例

729.在上述的实施例中,提供了一种语音库构建方法,与之相对应的,本技术还提供一种语音库构建装置。该装置是与上述方法的实施例相对应。本实施例与第三十九实施例内容相同的部分不再赘述,请参见实施例三十九中的相应部分。

730.本技术提供的一种语音库构建装置包括:

731.语音数据采集单元,用于采集用户的多个语音数据;

732.领域确定单元,用于确定各个语音数据的领域信息;

733.语音库生成单元,用于根据所述用户、所述语音数据与所述领域间的对应关系,生成语音库。

734.第四十四实施例

735.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示

意性的。

736.本实施例的一种电子设备,该电子设备包括:处理器和存储器;存储器,用于存储实现语音库构建方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:采集用户的多个语音数据;确定各个语音数据的领域信息;根据所述用户、所述语音数据与所述领域间的对应关系,生成语音库。

737.第四十五实施例

738.在上述的实施例中,提供了一种语音转换方法,与之相对应的,本技术还提供一种语音翻译系统。该系统是与上述方法的实施例相对应。本实施例中服务端的处理过程与第二实施例内容相同的部分不再赘述,请参见实施例二中的相应部分。

739.本技术提供的一种语音翻译系统包括:终端设备和服务端。

740.其中,终端设备用于采集第一用户的源语言的第一语音数据,向服务端发送针对所述第一语音数据的由第二用户进行翻译的请求;以及,播放服务端回送的与第一语音数据对应的具有第二用户音色的目标语言的第二语音数据;服务端用于构建第二用户的语音转换模型;针对所述请求,生成与第一语音数据对应的第三用户的目标语言的第三语音数据;通过第二用户的语音转换模型,生成与第三语音数据对应的具有第二用户音色的目标语言的语音数据,作为所述第二语音数据。

741.在一个示例中,服务端具体用于通过语音识别算法,确定第一语音数据的源语言文本;通过语音翻译算法,确定与源语言文本对应的目标语言文本;通过第三用户的语音合成模型,生成与第一语音数据对应的第三用户的目标语言的第三语音数据。其中,第三用户的语音合成模型可从第三用户的语音数据库中学习得到,该模型的输入数据可以是目标语言文本,输出数据可以是第三用户朗读方式的目标语言文本的语音数据。

742.例如,第二用户在会议现场,通过终端设备采集会议主讲人(第一用户)的英文发言(源语言)的语音数据(第一语音数据),将该英文语音数据发送至服务端;服务端可先通过语音识别算法、语音翻译算法,确定该英文语音的中文译文(目标语言文本);然后,可根据第三用户的中文语音库、或者第三用户的中文语音合成模型,生成该第三用户朗读该中文译文的中文语音数据(第三语音数据);通过第二用户的语音转换模型(该模型可执行实施例二的语音转换方法),生成具有第二用户音色的中文语音数据,并可在会议现场或其它场所播放第二用户的中文翻译语音数据,由此可实现用第二用户的声音实现同声传译的效果。

743.在一个示例中,第二用户的语音转换模型可包括实施例二中的pps特征提取器和第二用户的语音合成模型,该语音转换模型执行实施例二的语音转换方法。相关说明请参考实施例二部分,此处不再赘述。

744.具体实施时,第二用户可指定第三用户,如指定自己喜欢的某个英文播音员,使用该播音员的播音方式朗读译文;也可以是,服务端确定一个第三用户,通过该第三用户的播音方式,为多个第一用户提供译文播音服务。

745.从上述实施例可见,本技术实施例提供的语音翻译系统,通过终端设备用于采集第一用户的源语言的第一语音数据,向服务端发送针对所述第一语音数据的由第二用户进行翻译的请求;以及,播放服务端回送的与第一语音数据对应的具有第二用户音色的目标语言的第二语音数据;服务端用于构建第二用户的语音转换模型;针对所述请求,生成与第

一语音数据对应的第三用户的目标语言的第三语音数据;通过第二用户的语音转换模型,生成与第三语音数据对应的具有第二用户音色的目标语言的语音数据,作为所述第二语音数据;这种处理方式,使得即使第二用户不具有将源语言语音翻译成目标语言语音的能力,也能够生成第二用户将源语言语音翻译成目标语言的语音数据,即实现个性化的翻译,达到“说的跟真的一样”的翻译效果。

746.第四十六实施例

747.在上述的实施例中,提供了一种语音翻译系统,与之相对应的,本技术还提供一种语音翻译方法,该方法的执行主体可以是服务端等。该方法是与上述系统的实施例相对应。本实施例与第四十五实施例内容相同的部分不再赘述,请参见实施例四十五中的相应部分。

748.本技术提供的一种语音翻译方法,可包括如下步骤:

749.步骤1:构建第二用户的语音转换模型;

750.步骤2:针对客户端发送的针对第一用户的源语言的第一语音数据的由第二用户进行翻译的请求,生成与所述第一语音数据对应的第三用户的目标语言的第三语音数据;

751.步骤3:通过第二用户的语音转换模型,生成与第三语音数据对应的具有第二用户音色的目标语言的第二语音数据,作为所述第二语音数据发送至客户端。

752.在一个示例中,所述方法还包括:构建第二用户的语音转换模型;所述第二用户的语音转换模型,可采用如下方式:构建第二用户的语音合成模型、及语音后验概率图谱ppg特征提取器;相应的,步骤3可包括如下子步骤:1)通过所述语音转换模型包括的ppg特征提取器,根据第三语音数据的第一声学特征数据,确定第三语音数据的ppg特征数据;2)通过所述语音转换模型包括的第二用户的语音合成模型,根据所述ppg特征数据、和第三语音数据的第二声学特征数据,生成所述第二语音数据;所述第二声学特征数据包括韵律信息。

753.第四十七实施例

754.在上述的实施例中,提供了一种语音翻译方法,与之相对应的,本技术还提供一种语音翻译装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

755.本技术提供的一种语音翻译装置包括:

756.模型构建单元,用于构建第二用户的语音转换模型;

757.第一语音生成单元,用于针对客户端发送的针对第一用户的源语言的第一语音数据的由第二用户进行翻译的请求,生成与所述第一语音数据对应的第三用户的目标语言的第三语音数据;

758.第二语音生成单元,用于通过第二用户的语音转换模型,生成与第三语音数据对应的具有第二用户音色的目标语言的第二语音数据,作为所述第二语音数据发送至客户端。

759.第四十八实施例

760.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

761.本实施例的一种电子设备,该电子设备包括:处理器和存储器;存储器,用于存储

实现语音翻译方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:构建第二用户的语音转换模型;针对客户端发送的针对第一用户的源语言的第一语音数据的由第二用户进行翻译的请求,生成与所述第一语音数据对应的第三用户的目标语言的第三语音数据;通过第二用户的语音转换模型,生成与第三语音数据对应的具有第二用户音色的目标语言的第二语音数据,作为所述第二语音数据发送至客户端。

762.第四十九实施例

763.在上述的实施例中,提供了一种语音翻译系统,与之相对应的,本技术还提供一种语音翻译方法,该方法的执行主体可以是终端设备等。该方法是与上述系统的实施例相对应。本实施例与第四十五实施例内容相同的部分不再赘述,请参见实施例四十五中的相应部分。

764.本技术提供的一种语音翻译方法,可包括如下步骤:

765.步骤1:采集第一用户的源语言的第一语音数据;

766.步骤2:向服务端发送针对所述第一语音数据的由第二用户进行翻译的请求;

767.步骤3:播放服务端回送的与第一语音数据对应的具有第二用户音色的目标语言的第二语音数据。

768.第五十实施例

769.在上述的实施例中,提供了一种语音翻译方法,与之相对应的,本技术还提供一种语音翻译装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

770.本技术提供的一种语音翻译装置包括:

771.语音数据采集单元,用于采集第一用户的源语言的第一语音数据;

772.请求发送单元,用于向服务端发送针对所述第一语音数据的由第二用户进行翻译的请求;

773.语音播放单元,用于播放服务端回送的与第一语音数据对应的具有第二用户音色的目标语言的第二语音数据。

774.第五十一实施例

775.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

776.本实施例的一种电子设备,该电子设备包括:处理器和存储器;存储器,用于存储实现语音翻译方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:采集第一用户的源语言的第一语音数据;向服务端发送针对所述第一语音数据的由第二用户进行翻译的请求;播放服务端回送的与第一语音数据对应的具有第二用户音色的目标语言的第二语音数据。

777.第五十二实施例

778.在上述的实施例中,提供了一种语音转换方法,与之相对应的,本技术还提供一种跨语言语音生成系统。该系统是与上述方法的实施例相对应。本实施例中服务端的处理过程与第二实施例内容相同的部分不再赘述,请参见实施例二中的相应部分。

779.本技术提供的一种跨语言语音生成系统包括:终端设备和服务端。

780.其中,终端设备用于确定第一语言的文本,向服务端发送由第一用户朗读所述文本的语音生成请求;以及,播放服务端回送的第一用户朗读所述文本的第一语音数据;所述第一用户的母语为第二语言;服务端用于构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型(第一语音合成模型);以及,针对所述请求,确定第二用户朗读所述文本的第二语音数据,并通过所述ppg特征提取器,根据第二语音数据的包括第二用户声纹信息和语音内容信息的第一声学特征数据,确定第二语音数据的ppg特征数据;通过第一用户的所述语音合成模型,根据所述ppg特征数据、和第二语音数据的包括韵律信息的第二声学特征数据,生成所述第一语音数据。

781.所述第一用户的母语为第二语言,所述第二用户的母语为第一语言。例如,第一用户要读一段英文文本,但该用户是一个不会说英语或英语说的不好的中国人,为了达到该第一用户流利说英文的效果,可指定一个英国人作为第二用户,可先由该第二用户用地道的英语朗读该段英文文本,作为第二语音数据,然后生成与该第二语音数据对应的具有第一用户音色的第一语音数据,好像该第一用户具有较好的英语水平。

782.在一个示例中,服务端将所述文本作为第二用户的第二语音合成模型的输入数据,该模型可生成具有第二用户朗读方式的所述文本的朗读语音数据,该语音数据不仅具有第二用户的音色,还具有第二用户的朗读语调等特点。该第二语音合成模型可从第二用户的语音库中学习得到。

783.需要说明的是,该第二用户的语音合成模型与服务端构建的各个用户的第一语音合成模型不同,不同之处包括:

784.1)输入数据不同:第一语音合成模型的输入数据包括pps特征数据,而第二用户的语音合成模型包括文本;

785.2)模型作用不同:第一语音合成模型是根据pps特征数据生成具有对应用户音色的语音数据,而第二语音合成模型是根据输入文本生成对应用户音色、用户朗读方式的相应语音数据;

786.3)输出数据不同:第一语音合成模型输出的语音数据与该模型对应的用户的说话方式无关,而与其他用户的说话方式有关;第二语音合成模型输出的语音数据与其它用户的语音数据无关。

787.在一个示例中,第一用户可通过终端设备指定第二用户,如指定某个英语播音员作为第二用户;第一用户也可通过终端设备指定第一语言方言信息,如第一语言为英语,指定的第一语言方言为美音或英音,或者,比如第一语言为中文,指定的第一语言方言为标准话或上海话;也可以是由服务端任意确定一个第一语言的用户作为第二用户。

788.从上述实施例可见,本技术实施例提供的跨语言语音生成系统,通过终端设备确定第一语言的文本,向服务端发送由第一用户朗读所述文本的语音生成请求;以及,播放服务端回送的第一用户朗读所述文本的第一语音数据;所述第一用户的母语为第二语言;服务端构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;以及,针对所述请求,确定第二用户朗读所述文本的第二语音数据,并通过所述ppg特征提取器,根据第二语音数据的包括第二用户声纹信息和语音内容信息的第一声学特征数据,确定第二语音数据的ppg特征数据;通过第一用户的所述语音合成模型,根据所述ppg特征数据、和第二语音数据的包括韵律信息的第二声学特征数据,生成所述第一语音数据;这种处理方式,使得即

使第一用户不具有某语种的文本阅读能力,也能够生成第一用户朗读该语种文本的语音数据,实现跨语言的文本朗读。

789.第五十三实施例

790.在上述的实施例中,提供了一种跨语言语音生成系统,与之相对应的,本技术还提供一种跨语言语音生成方法,该方法的执行主体可以是服务端等。该方法是与上述系统的实施例相对应。本实施例与第五十二实施例内容相同的部分不再赘述,请参见实施例五十二中的相应部分。

791.本技术提供的一种跨语言语音生成方法,可包括如下步骤:

792.步骤1:针对由第一用户朗读第一语言的文本的语音生成请求,确定第二用户朗读所述文本的第二语音数据;

793.步骤2:通过第一用户的语音转换模型,将第二语音数据转换为第一用户朗读所述文本的第一语音数据。

794.在一个示例中,所述方法还可包括如下步骤:构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;相应的,步骤2可包括如下子步骤:通过所述ppg特征提取器,根据第二语音数据的包括第二用户声纹信息和语音内容信息的第一声学特征数据,确定第二语音数据的ppg特征数据;通过第一用户的所述语音合成模型,根据所述ppg特征数据、和第二语音数据的包括韵律信息的第二声学特征数据,生成第一用户朗读所述文本的第一语音数据。

795.具体实施时,步骤2也可采用其它语音转换模型,所述方法并不限定语音转换模型的具体实现方式。

796.第五十四实施例

797.在上述的实施例中,提供了一种跨语言语音生成方法,与之相对应的,本技术还提供一种跨语言语音生成装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

798.本技术提供的一种跨语言语音生成装置包括:

799.语音生成单元,用于针对客户端发送的由第一用户朗读第一语言的文本的语音生成请求,确定第二用户朗读所述文本的第二语音数据;

800.语音转换单元,用于通过第一用户的语音转换模型,将第二语音数据转换为第一用户朗读所述文本的第一语音数据。

801.在一个示例中,所述装置还包括:

802.模型构建单元,用于构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;

803.所述语音转换单元包括ppg特征提取子单元和第二语音生成子单元;

804.ppg特征提取子单元,用于通过所述ppg特征提取器,根据第二语音数据的包括第二用户声纹信息和语音内容信息的第一声学特征数据,确定第二语音数据的ppg特征数据;

805.第二语音生成子单元,用于通过第一用户的所述语音合成模型,根据所述ppg特征数据、和第二语音数据的包括韵律信息的第二声学特征数据,生成第一用户朗读所述文本的第一语音数据。

806.第五十五实施例

807.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

808.本实施例的一种电子设备,该电子设备包括:处理器和存储器;存储器,用于存储实现跨语言语音生成方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:针对由第一用户朗读第一语言的文本的语音生成请求,确定第二用户朗读所述文本的第二语音数据;通过第一用户的语音转换模型,将第二语音数据转换为第一用户朗读所述文本的第一语音数据。

809.第五十六实施例

810.在上述的实施例中,提供了一种跨语言语音生成系统,与之相对应的,本技术还提供一种跨语言语音生成方法,该方法的执行主体可以是终端设备等。该方法是与上述系统的实施例相对应。本实施例与第五十二实施例内容相同的部分不再赘述,请参见实施例五十二中的相应部分。

811.本技术提供的一种跨语言语音生成方法,可包括如下步骤:

812.步骤1:确定第一语言的文本;

813.步骤2:向服务端发送由第一用户朗读所述文本的语音生成请求。

814.第五十七实施例

815.在上述的实施例中,提供了一种跨语言语音生成方法,与之相对应的,本技术还提供一种跨语言语音生成装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

816.本技术提供的一种跨语言语音生成装置包括:

817.文本确定单元,用于确定第一语言的文本;

818.请求发送单元,用于向服务端发送由第一用户朗读所述文本的语音生成请求。

819.第五十八实施例

820.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

821.本实施例的一种电子设备,该电子设备包括:处理器和存储器;存储器,用于存储实现跨语言语音生成方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:确定第一语言的文本;向服务端发送由第一用户朗读所述文本的语音生成请求。

822.第五十九实施例

823.在上述的实施例中,提供了一种跨语言语音生成系统,与之相对应的,本技术还提供一种跨语言语音生成方法,该方法的执行主体可以是终端设备等。该方法是与上述系统的实施例相对应。本实施例与第五十二实施例内容相同的部分不再赘述,请参见实施例五十二中的相应部分。

824.本技术提供的一种跨语言语音生成方法,可包括如下步骤:

825.步骤1:确定第一语言的文本;

826.步骤2:确定第二用户朗读所述文本的第二语音数据;

827.步骤3:通过第一用户的语音转换模型,将第二语音数据转换为第一用户朗读所述文本的第一语音数据。

828.在一个示例中,步骤3可包括如下子步骤:3.1)通过语音后验概率图谱ppg特征提取器,根据第二语音数据的包括第二用户声纹信息和语音内容信息的第一声学特征数据,确定第二语音数据的ppg特征数据;3.2)通过第一用户的语音合成模型,根据所述ppg特征数据、和第二语音数据的包括韵律信息的第二声学特征数据,生成第一用户朗读所述文本的第一语音数据。

829.第六十实施例

830.在上述的实施例中,提供了一种跨语言语音生成方法,与之相对应的,本技术还提供一种跨语言语音生成装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

831.本技术提供的一种跨语言语音生成装置包括:

832.文本确定单元,用于确定第一语言的文本;

833.语音确定单元,用于确定第二用户朗读所述文本的第二语音数据;

834.语音转换单元,用于通过第一用户的语音转换模型,将第二语音数据转换为第一用户朗读所述文本的第一语音数据。

835.第六十一实施例

836.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

837.本实施例的一种电子设备,该电子设备包括:处理器和存储器;存储器,用于存储实现跨语言语音生成方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:确定第一语言的文本;确定第二用户朗读所述文本的第二语音数据;通过第一用户的语音转换模型,将第二语音数据转换为第一用户朗读所述文本的第一语音数据。

838.第六十二实施例

839.在上述的实施例中,提供了一种语音转换方法,与之相对应的,本技术还提供一种跨方言语音生成系统。该系统是与上述方法的实施例相对应。本实施例中服务端的处理过程与第二实施例内容相同的部分不再赘述,请参见实施例二中的相应部分。

840.本技术提供的一种跨方言语音生成系统包括:终端设备和服务端。

841.其中,终端设备用于确定目标文本和目标方言,向服务端发送由第一用户用目标方言朗读所述文本的请求;以及,播放服务端回送的由第一用户用目标方言朗读所述文本的第一语音数据;服务端用于构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;以及,针对所述请求,确定第二用户用目标方言朗读所述文本的第二语音数据,并通过所述ppg特征提取器,根据第二语音数据的包括第二用户声纹信息和语音内容信息的第一声学特征数据,确定第二语音数据的ppg特征数据;通过第一用户的所述语音合成模型(第一语音合成模型),根据所述ppg特征数据、和第二语音数据的包括韵律信息的第二声学特征数据,生成所述第一语音数据。

842.所述第一用户和第二用户的母语可为同一语种,但第一用户和第二用户可在不同的地域,讲不同的方言。例如,第一用户要用粤语读一段文字,但该用户不会说粤语或粤语

说的不好,为了达到该第一用户流利说粤语的效果,可指定一个广东人作为第二用户,可先由该第二用户用流利的粤语说这段话,作为第二语音数据,然后生成与该第二语音数据对应的具有第一用户音色的第一语音数据,好像该第一用户具有较好的粤语水平。

843.在一个示例中,服务端将所述文本作为第二用户的第二语音合成模型的输入数据,该模型可生成具有第二用户朗读方式的所述文本的朗读语音数据,该语音数据不仅具有第二用户的音色,还具有第二用户的朗读语调等特点。该第二语音合成模型可从第二用户的语音库中学习得到。

844.需要说明的是,该第二用户的语音合成模型与服务端构建的各个用户的第一语音合成模型不同,不同之处包括:

845.1)输入数据不同:第一语音合成模型的输入数据包括pps特征数据,而第二用户的语音合成模型包括文本;

846.2)模型作用不同:第一语音合成模型是根据pps特征数据生成具有对应用户音色的语音数据,而第二语音合成模型是根据输入文本生成对应用户音色、用户朗读方式的相应语音数据;

847.3)输出数据不同:第一语音合成模型输出的语音数据与该模型对应的用户的说话方式无关,而与其他用户的说话方式有关;第二语音合成模型输出的语音数据与其它用户的语音数据无关。

848.具体实施时,第一用户可通过终端设备指定第二用户,也可以是由服务端任意确定一个目标方言的用户作为第二用户。

849.在一个示例中,第一用户通过其使用的终端设备指定第二用户,服务端向被指定的第二用户的终端设备发送目标文本,通过第二用户的终端设备采集第二用户用目标方言朗读的目标文本的第二语音数据,服务端通过所述ppg特征提取器,根据第二语音数据的包括第二用户声纹信息和语音内容信息的第一声学特征数据,确定第二语音数据的ppg特征数据;通过第一用户的所述语音合成模型,根据所述ppg特征数据、和第二语音数据的包括韵律信息的第二声学特征数据,生成所述第一语音数据。

850.从上述实施例可见,本技术实施例提供的跨方言语音生成系统,通过终端设备确定目标文本和目标方言,向服务端发送由第一用户用目标方言朗读所述文本的请求;以及,播放服务端回送的由第一用户用目标方言朗读所述文本的第一语音数据;服务端构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;以及,针对所述请求,确定第二用户用目标方言朗读所述文本的第二语音数据,并通过所述ppg特征提取器,根据第二语音数据的包括第二用户声纹信息和语音内容信息的第一声学特征数据,确定第二语音数据的ppg特征数据;通过第一用户的所述语音合成模型(第一语音合成模型),根据所述ppg特征数据、和第二语音数据的包括韵律信息的第二声学特征数据,生成所述第一语音数据;这种处理方式,使得即使第一用户不具有较好的方言听说能力,也能够生成第一用户用目标方言朗读文本的语音数据,实现跨方言的文本朗读。

851.第六十三实施例

852.在上述的实施例中,提供了一种跨方言语音生成系统,与之相对应的,本技术还提供一种跨方言语音生成方法,该方法的执行主体可以是服务端等。该方法是与上述系统的实施例相对应。本实施例与第六十二实施例内容相同的部分不再赘述,请参见实施例六十

二中的相应部分。

853.本技术提供的一种跨方言语音生成方法,可包括如下步骤:

854.步骤1:针对由第一用户用目标方言朗读目标文本的请求,确定第二用户用目标方言朗读目标文本的第二语音数据;

855.步骤2:通过第一用户的语音转换模型,将第二语音数据转换为第一用户用目标方言朗读所述文本的第一语音数据。

856.在一个示例中,所述方法还可包括如下步骤:构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;相应的,步骤2可包括如下子步骤:通过所述ppg特征提取器,根据第二语音数据的包括第二用户声纹信息和语音内容信息的第一声学特征数据,确定第二语音数据的ppg特征数据;通过第一用户的所述语音合成模型,根据所述ppg特征数据、和第二语音数据的包括韵律信息的第二声学特征数据,生成所述第一语音数据。

857.具体实施时,步骤2也可采用其它语音转换模型,所述方法并不限定语音转换模型的具体实现方式。

858.第六十四实施例

859.在上述的实施例中,提供了一种跨方言语音生成方法,与之相对应的,本技术还提供一种跨方言语音生成装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

860.本技术提供的一种跨方言语音生成装置包括:

861.语音生成单元,用于针对由第一用户用目标方言朗读目标文本的请求,确定第二用户用目标方言朗读目标文本的第二语音数据;

862.语音转换单元,用于通过第一用户的语音转换模型,将第二语音数据转换为第一用户用目标方言朗读所述文本的第一语音数据。

863.在一个示例中,所述装置还包括:

864.模型构建单元,用于构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;

865.所述语音转换单元包括ppg特征提取子单元和第二语音生成子单元;

866.ppg特征提取子单元,用于通过所述ppg特征提取器,根据第二语音数据的包括第二用户声纹信息和语音内容信息的第一声学特征数据,确定第二语音数据的ppg特征数据;

867.第二语音生成子单元,用于通过第一用户的所述语音合成模型,根据所述ppg特征数据、和第二语音数据的包括韵律信息的第二声学特征数据,生成所述第一语音数据。

868.第六十五实施例

869.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

870.本实施例的一种电子设备,该电子设备包括:处理器和存储器;存储器,用于存储实现跨方言语音生成方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:针对由第一用户用目标方言朗读目标文本的请求,确定第二用户用目标方言朗读目标文本的第二语音数据;通过第一用户的语音转换模型,将第二语音数据转换为第一用户用目标方言朗读所述文本的第一语音数据。

871.第六十六实施例

872.在上述的实施例中,提供了一种跨方言语音生成系统,与之相对应的,本技术还提供一种跨语言语音生成方法,该方法的执行主体可以是终端设备等。该方法是与上述系统的实施例相对应。本实施例与第六十二实施例内容相同的部分不再赘述,请参见实施例六十二中的相应部分。

873.本技术提供的一种跨方言语音生成方法,可包括如下步骤:

874.步骤1:确定目标文本和目标方言;

875.步骤2:向服务端发送由第一用户用目标方言朗读所述文本的第一语音数据。

876.第六十七实施例

877.在上述的实施例中,提供了一种跨方言语音生成方法,与之相对应的,本技术还提供一种跨方言语音生成装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

878.本技术提供的一种跨方言语音生成装置包括:

879.文本确定单元,用于确定目标文本和目标方言;

880.请求发送单元,用于向服务端发送由第一用户用目标方言朗读所述文本的第一语音数据。

881.第六十八实施例

882.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

883.本实施例的一种电子设备,该电子设备包括:处理器和存储器;存储器,用于存储实现跨方言语音生成方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:确定目标文本和目标方言;向服务端发送由第一用户用目标方言朗读所述文本的第一语音数据。

884.第六十九实施例

885.在上述的实施例中,提供了一种跨方言语音生成系统,与之相对应的,本技术还提供一种跨方言语音生成方法,该方法的执行主体可以是终端设备等。该方法是与上述系统的实施例相对应。本实施例与第六十二实施例内容相同的部分不再赘述,请参见实施例六十二中的相应部分。

886.本技术提供的一种跨方言语音生成方法,可包括如下步骤:

887.步骤1:确定目标文本和目标方言;

888.步骤2:确定第二用户用目标方言朗读目标文本的第二语音数据;

889.步骤3:通过第一用户的语音转换模型,将第二语音数据转换为第一用户用目标方言朗读所述文本的第一语音数据。

890.在一个示例中,步骤3可包括如下子步骤:3.1)通过语音后验概率图谱ppg特征提取器,根据第二语音数据的包括第二用户声纹信息和语音内容信息的第一声学特征数据,确定第二语音数据的ppg特征数据;3.2)通过第一用户的语音合成模型,根据所述ppg特征数据、和第二语音数据的包括韵律信息的第二声学特征数据,生成所述第一语音数据。

891.第七十实施例

892.在上述的实施例中,提供了一种跨方言语音生成方法,与之相对应的,本技术还提供一种跨方言语音生成装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

893.本技术提供的一种跨方言语音生成装置包括:

894.文本确定单元,用于确定目标文本和目标方言;

895.语音确定单元,用于确定第二用户用目标方言朗读目标文本的第二语音数据;

896.语音转换单元,用于通过第一用户的语音转换模型,将第二语音数据转换为第一用户用目标方言朗读所述文本的第一语音数据。

897.第七十一实施例

898.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

899.本实施例的一种电子设备,该电子设备包括:处理器和存储器;存储器,用于存储实现跨方言语音生成方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:确定目标文本和目标方言;确定第二用户用目标方言朗读目标文本的第二语音数据;通过第一用户的语音转换模型,将第二语音数据转换为第一用户用目标方言朗读所述文本的第一语音数据。

900.第七十二实施例

901.在上述的实施例中,提供了一种语音转换方法,与之相对应的,本技术还提供一种语音变声系统。该系统是与上述方法的实施例相对应。本实施例中服务端的处理过程与第二实施例内容相同的部分不再赘述,请参见实施例二中的相应部分。

902.本技术提供的一种语音变声系统包括:终端设备和服务端。

903.其中,终端设备用于确定第一用户的第一语音数据,向服务端发送将所述第一语音数据变声为第二用户声音的请求;服务端构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据。

904.所述第一用户和第二用户的母语可为同一语种、同一方言。例如,第二用户想模仿第一用户的某段语音,则将该段语音数据作为第一语音数据,通过所述方法,可生成与该段语音对应的具有第二用户音色的第二语音数据。

905.从上述实施例可见,本技术实施例提供的语音变声系统,通过终端设备确定第一用户的第一语音数据,向服务端发送将所述第一语音数据变声为第二用户声音的请求;服务端构建各个用户的语音合成模型;以及,构建语音后验概率图谱ppg特征提取器;通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据;这种处理方式,使得使用ppg特征作为语音合成模块的输入,该ppg特征保留了声学信息(如韵律和发音信息),每一帧的ppg特征可以在不同说

话人之间通用,由此实现将第一用户的语音变声为第二用户的声音;因此,可以有效提升语音变声的准确度。同时,由于所述系统无需识别第一语音数据的文字信息,因此可以有效提升语音变声效率。

906.第七十三实施例

907.在上述的实施例中,提供了一种语音变声系统,与之相对应的,本技术还提供一种语音变声方法,该方法的执行主体可以是服务端等。该方法是与上述系统的实施例相对应。本实施例与第七十二实施例内容相同的部分不再赘述,请参见实施例七十二中的相应部分。

908.本技术提供的一种语音变声方法,可包括如下步骤:

909.步骤1:构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;

910.步骤2:针对将第一用户的第一语音数据变声为第二用户声音的请求,通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;

911.步骤3:通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据。

912.第七十四实施例

913.在上述的实施例中,提供了一种语音变声方法,与之相对应的,本技术还提供一种语音变声装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

914.本技术提供的一种语音变声装置包括:

915.模型构建单元,用于构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;

916.特征提取单元,用于针对将第一用户的第一语音数据变声为第二用户声音的请求,通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;

917.语音生成单元,用于通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据。

918.第七十五实施例

919.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

920.本实施例的一种电子设备,该电子设备包括:处理器和存储器;存储器,用于存储实现语音变声方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:构建语音后验概率图谱ppg特征提取器、和各个用户的语音合成模型;针对将第一用户的第一语音数据变声为第二用户声音的请求,通过所述ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的所述语音合成模型,根据所述ppg特征数据、和第一语音数据

的包括韵律信息的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据。

921.第七十六实施例

922.在上述的实施例中,提供了一种语音变声系统,与之相对应的,本技术还提供一种语音变声方法,该方法的执行主体可以是终端设备等。该方法是与上述系统的实施例相对应。本实施例与第七十二实施例内容相同的部分不再赘述,请参见实施例七十二中的相应部分。

923.本技术提供的一种语音变声方法,可包括如下步骤:

924.步骤1:确定第一用户的第一语音数据;

925.步骤2:向服务端发送将所述第一语音数据变声为第二用户声音的请求。

926.第七十七实施例

927.在上述的实施例中,提供了一种语音变声方法,与之相对应的,本技术还提供一种语音变声装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

928.本技术提供的一种语音变声装置包括:

929.语音确定单元,用于确定第一用户的第一语音数据;

930.请求发送单元,用于向服务端发送将所述第一语音数据变声为第二用户声音的请求。

931.第七十八实施例

932.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

933.本实施例的一种电子设备,该电子设备包括:处理器和存储器;存储器,用于存储实现语音变声方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:确定第一用户的第一语音数据;向服务端发送将所述第一语音数据变声为第二用户声音的请求。

934.第七十九实施例

935.在上述的实施例中,提供了一种语音变声系统,与之相对应的,本技术还提供一种语音变声方法,该方法的执行主体可以是终端设备等。该方法是与上述系统的实施例相对应。本实施例与第七十二实施例内容相同的部分不再赘述,请参见实施例七十二中的相应部分。

936.本技术提供的一种语音变声方法,可包括如下步骤:

937.步骤1:确定第一用户的第一语音数据;

938.步骤2:通过语音后验概率图谱ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;

939.步骤3:通过第二用户的语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据。

940.第八十实施例

941.在上述的实施例中,提供了一种语音变声方法,与之相对应的,本技术还提供一种语音变声装置。该装置是与上述方法的实施例相对应。本实施例与第一实施例内容相同的部分不再赘述,请参见实施例一中的相应部分。

942.本技术提供的一种语音变声装置包括:

943.语音确定单元,用于确定第一用户的第一语音数据;

944.特征提取单元,用于通过语音后验概率图谱ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;

945.语音生成单元,用于通过第二用户的语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据。

946.第八十一实施例

947.本技术还提供一种电子设备。由于设备实施例基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。下述描述的设备实施例仅仅是示意性的。

948.本实施例的一种电子设备,该电子设备包括:处理器和存储器;存储器,用于存储实现语音变声方法的程序,该设备通电并通过所述处理器运行该方法的程序后,执行下述步骤:确定第一用户的第一语音数据;通过语音后验概率图谱ppg特征提取器,根据第一语音数据的包括第一用户声纹信息和语音内容信息的第一声学特征数据,确定第一语音数据的ppg特征数据;通过第二用户的语音合成模型,根据所述ppg特征数据、和第一语音数据的包括韵律信息的第二声学特征数据,生成与第一语音数据对应的第二用户的第二语音数据。

949.第八十二实施例

950.在上述的实施例中,提供了一种语音转换方法,与之相对应的,本技术还提供一种跨语言语音交互系统。该系统是与上述方法的实施例相对应。本实施例中服务端的处理过程与第二实施例内容相同的部分不再赘述,请参见实施例二中的相应部分。

951.本技术提供的一种跨语言语音交互系统包括:第一终端设备、第二终端设备和服务端。

952.第一终端设备和第二终端设备包括但不限于移动通讯设备,即:通常所说的手机或者智能手机,还包括个人电脑、pad、ipad等终端设备。

953.其中,第一终端设备用于采集第一用户的源语言的第一语音数据,向服务端发送所述第一语音数据;服务端用于确定与第一语音数据对应的目标语言文本;根据第二用户的目标语言语音库,生成与所述目标语言文本对应的第二用户的目标语言的第二语音数据;通过第一用户的语音转换模型,生成与第二语音数据对应的具有第一用户音色的目标语言的第三语音数据;向第二终端设备发送第三语音数据;第二终端设备用于播放第三语音数据。

954.例如,母语为中文的用户a(第一用户)使用第一终端设备、与使用第二终端设备的母语为英语的用户b(第三用户)进行语音通话,两个用户可使用各自的母语直接与对方聊天,服务端执行语音翻译等处理。