1.本技术涉及数据处理技术领域,尤其涉及一种曲调生成方法、装置、设备及计算机可读存储介质。

背景技术:

2.随着人们生活水平的提高,越来越多的用户收听音乐。然而,由于人的情绪会受到外界因素的影响,在人们情绪不同的时候通常希望听到不同情绪的歌曲。其中,歌曲大多由谱曲家进行谱曲,然后通过录音棚进行歌曲录制,或者根据歌词的含义使用机器学习的方式自动为歌曲谱曲。然而,在用户收听歌曲时,存在当前播放歌曲的曲调与用户当前心情不匹配的问题。

技术实现要素:

3.本技术的主要目的在于提供一种曲调生成方法、装置、设备及计算机可读存储介质,旨在解决当前播放歌曲的曲调与用户当前心情不匹配的技术问题。

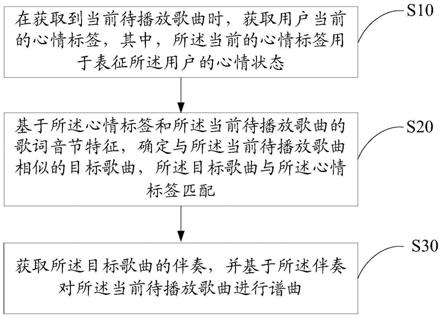

4.为实现上述目的,本技术提供一种曲调生成方法,所述曲调生成方法包括:

5.在获取到当前待播放歌曲时,获取用户当前的心情标签,其中,所述当前的心情标签用于表征所述用户的心情状态;

6.基于所述心情标签和所述当前待播放歌曲的歌词音节特征,确定与所述当前待播放歌曲相似的目标歌曲,所述目标歌曲与所述心情标签匹配;

7.获取所述目标歌曲的伴奏,并基于所述伴奏对所述当前待播放歌曲进行谱曲。

8.此外,为实现上述目的,本技术还提供一种曲调生成装置,所述曲调生成装置包括:

9.获取模块,用于在获取到当前待播放歌曲时,获取用户当前的心情标签,其中,所述当前的心情标签用于表征所述用户的心情状态;

10.确定模块,用于基于所述心情标签和所述当前待播放歌曲的歌词音节特征,确定与所述当前待播放歌曲相似的目标歌曲,所述目标歌曲与所述心情标签匹配;

11.谱曲模块,用于获取所述目标歌曲的伴奏,并基于所述伴奏对所述当前待播放歌曲进行谱曲。

12.此外,为实现上述目的,本技术还提供一种曲调生成设备,所述曲调生成设备包括:存储器、处理器及存储在所述存储器上并可在所述处理器上运行的曲调生成程序,所述曲调生成程序被所述处理器执行时实现如上所述的曲调生成方法的步骤。

13.此外,为实现上述目的,本技术还提供一种计算机可读存储介质,所述计算机可读存储介质上存储有曲调生成程序,所述曲调生成程序被处理器执行时实现如上所述的曲调生成方法的步骤。

14.此外,为实现上述目的,本技术还提供一种计算机程序产品,所述计算机程序产品包括计算机程序,所述计算机程序被处理器执行时实现如上所述的曲调生成方法的步骤。

15.本技术提供一种曲调生成方法、装置、设备及计算机可读存储介质,在获取到当前待播放歌曲时,获取用户当前的心情标签,其中,当前的心情标签用于表征用户的心情状态;基于心情标签和当前待播放歌曲的歌词音节特征,确定与当前待播放歌曲相似的目标歌曲,该目标歌曲的心情标签与用户当前心情状态对应的心情标签匹配,以从心情状态匹配的歌曲中筛选歌词音节特征也匹配的目标歌曲,从而提高目标歌曲的伴奏与当前待播放歌曲的匹配度;获取目标歌曲的伴奏,并基于伴奏对当前待播放歌曲进行谱曲。通过上述方式,基于用户当前的心情标签得到目标歌曲,以使目标歌曲与用户当前心情状态对应的心情标签匹配,然后,通过目标歌曲的伴奏生成该当前待播放歌曲的曲调,从而确保当前待播放歌曲的曲调与用户当前心情匹配,以使当前待播放歌曲切合用户心情,进而提升用户的收听体验。同时,从心情状态匹配的歌曲中筛选歌词音节特征也匹配的目标歌曲,以提高目标歌曲的伴奏与当前待播放歌曲的匹配度,以使通过目标歌曲的伴奏生成的曲调与当前待播放歌曲更加匹配,从而进一步提升用户的收听体验。

附图说明

16.图1为本技术实施例方案涉及的硬件运行环境的终端结构示意图;

17.图2为本技术曲调生成方法第一实施例的流程示意图;

18.图3为本技术曲调生成方法第二实施例的流程示意图;

19.图4为本技术曲调生成装置第一实施例的功能模块示意图。

20.本技术目的的实现、功能特点及优点将结合实施例,参照附图做进一步说明。

具体实施方式

21.应当理解,此处所描述的具体实施例仅仅用以解释本技术,并不用于限定本技术。

22.参照图1,图1为本技术实施例方案涉及的硬件运行环境的终端结构示意图。

23.本技术实施例终端为曲调生成设备,该曲调生成设备可以为手机、平板电脑、智能可穿戴设备、个人计算机、音乐播放器等终端设备。

24.如图1所示,该终端可以包括:处理器1001,例如cpu(central processing unit,中央处理器),通信总线1002,用户接口1003,网络接口1004,存储器1005。其中,通信总线1002用于实现这些组件之间的连接通信。用户接口1003可以包括显示屏(display)、输入单元比如键盘(keyboard),可选用户接口1003还可以包括标准的有线接口、无线接口。网络接口1004可选的可以包括标准的有线接口、无线接口(如wi-fi接口)。存储器1005可以是高速ram存储器,也可以是稳定的存储器(non-volatile memory),例如磁盘存储器。存储器1005可选的还可以是独立于前述处理器1001的存储装置。

25.本领域技术人员可以理解,图1中示出的终端结构并不构成对终端的限定,可以包括比图示更多或更少的部件,或者组合某些部件,或者不同的部件布置。

26.如图1所示,作为一种计算机存储介质的存储器1005中可以包括操作系统、网络通信模块、用户接口模块以及曲调生成程序。

27.在图1所示的终端中,处理器1001可以用于调用存储器1005中存储的曲调生成程序,并执行本技术以下实施例提供的曲调生成方法中的步骤。

28.基于上述硬件结构,提出本技术曲调生成方法的各个实施例。

29.本技术提供一种曲调生成方法。

30.参照图2,图2为本技术曲调生成方法第一实施例的流程示意图。

31.在本实施例中,该曲调生成方法包括:

32.步骤s10,在获取到当前待播放歌曲时,获取用户当前的心情标签,其中,所述当前的心情标签用于表征所述用户的心情状态;

33.在本实施例中,曲调生成方法可以应用于音乐播放终端,该音乐播放终端可以为手机、平板电脑、智能可穿戴设备、个人计算机等终端设备;也可以应用于服务器端,以通过服务器端生成曲调并对歌曲进行谱曲,然后,基于服务器端与音乐播放终端的通信连接,服务器端向音乐播放终端传输音频流和操作指令流,音乐播放终端向服务器端传输操作指令流;还可以应用于由该服务器端和该音乐播放终端构成的曲调生成系统,该曲调生成系统从属于上述曲调生成设备。

34.在本实施例中,在上述步骤s10之前,首先,检测情绪歌曲播放模式是否启动,若所述情绪歌曲播放模式启动,则执行上述步骤s10,若所述情绪歌曲播放模式未启动,则按照其他播放模式播放歌曲即可。其中,情绪歌曲播放模式用于匹配当前待播放歌曲的曲调与用户当前心情状态,该情绪歌曲播放模式可以由用户通过音乐播放终端进行触发,以使用户自行决定是否启动情绪歌曲播放模式,进而提高用户的收听体验。

35.在本实施例中,在获取到当前待播放歌曲时,获取用户当前的心情标签,其中,用户当前的心情标签用于表征用户当前的心情状态。其中,心情标签包括以下至少一种:雀跃、振奋、发怒、不满、开心、悲伤等,心情标签的种类可以通过心理专家进行确定,并根据实际需要进行设定,此处不作具体限定。

36.在本实施例中,获取用户当前的心情标签的方式可以是:

37.方式一:获取用户当前的心情状态,基于该心情状态生成对应的心情标签,将该心情标签设定为用户当前的心情标签;

38.在方式一中,获取用户当前的心情状态的方式可以包括以下三种方式:第一种,通过用户当前所处的环境属性信息确定用户当前的心情状态;第二种,通过用户当前的体表特征确定用户当前的心情状态;第三种,将用户当前所处的环境属性信息和用户当前的体表特征进行聚合处理得到聚合特征,通过该聚合特征确定用户当前的心情状态。该方式一的具体执行流程可以参照下述第二实施例,此处不再一一赘述。

39.方式二:获取上一播放歌曲的心情标签,若该上一播放歌曲与当前待播放歌曲的播放时间间隔小于预设时间间隔时,则将上一播放歌曲的心情标签作为该当前待播放歌曲的心情标签。

40.在方式二中,由于用户在短时间内心情状态的变化较小,因此,可获取时间间隔小于预设时间间隔的上一播放歌曲的心情标签,该上一播放歌曲的心情标签同样可基于方式一或方式二进行设定,所以,当前待播放歌曲的心情标签可以与上一播放歌曲的心情标签一致。

41.需要说明的是,若用户当前所处的环境属性信息或用户当前的体表特征发生较大变化时,则采用方式一,以确保当前待播放歌曲的心情标签的准确性。

42.在本实施例中,在上述步骤s10之后,判断该当前待播放歌曲的心情标签是否属于该用户当前的心情标签,若属于则直接播放该当前待播放歌曲,若不属于则执行下述步骤

s20,以使当前待播放歌曲与该用户当前的心情标签进行匹配。其中,当前待播放歌曲的心情标签为当前待播放歌曲原本携带的曲调对应的心情标签,而用户当前的心情标签为用户当前的心情状态对应的心情标签。

43.步骤s20,基于所述心情标签和所述当前待播放歌曲的歌词音节特征,确定与所述当前待播放歌曲相似的目标歌曲,所述目标歌曲与所述心情标签匹配;

44.在本实施例中,基于用户当前的心情标签和当前待播放歌曲的歌词音节特征,确定与当前待播放歌曲相似的目标歌曲,该目标歌曲与用户当前的心情标签匹配。具体的,基于用户当前的心情标签从预设歌曲集中筛选得到与该心情标签匹配的目标歌曲集,然后,从目标歌曲集中筛选得到与当前待播放歌曲的歌词音节特征相匹配的目标歌曲。

45.其中,歌词音节特征为歌曲文字对应的语调特征,而歌词的文本特征包括语调特征和语义特征。其中,目标歌曲通常为与当前待播放歌曲的歌词音节特征最相似的歌曲。

46.需要说明的是,音节是歌词中音位组合构成的最小语音结构单位。歌词音节特征的具体内容可以根据歌曲的语言类型进行确定,例如,对于中文歌来说,歌词音节特征包括声母特征、韵母特征和声调特征;对于英文歌来说,歌词音节特征包括元音特征和辅音特征;对于日文歌来说,歌词音节特征包括五十音的清音特征、浊音特征、半浊音特征、促音特征、拨音特征和长音特征。此外,对于其它语言的歌曲此处不再一一赘述。

47.此外,还需要说明的是,预设歌曲集可以根据实际需要进行设定,例如,音乐播放终端对应的服务器端存储的所有歌曲、该曲库生成方法执行终端的本地所有歌曲或用户当前喜欢列表中的歌曲等。该歌曲集可以以曲库的形式进行存储,具体的执行过程可以参照下述第三实施例,当然,也可以以其他形式进行存储。

48.具体的,将当前待播放歌曲的第一歌词音节特征分别与目标歌曲集中各个歌曲的第二歌词音节特征进行相似度计算,然后,基于相似度计算结果,从目标歌曲集中筛选得到相似度值最大的目标歌曲,以使目标歌曲中各个歌词的音节特征与当前待播放歌曲的各个歌词的音节特征最相似,从而提高目标歌曲的伴奏与当前待播放歌曲的匹配度,以便后续更容易基于目标歌曲的伴奏对当前待播放歌曲进行谱曲,进而提高当前待播放歌曲的曲调匹配度。其中,对歌词音节特征进行相似度计算,可以分别对歌词音节特征中的各个特征分别进行相似度计算,对于中文歌曲来说,具体的执行过程可以参照下述第三实施例,此处不再一一赘述。此外,对于其它语言歌曲来说,具体的执行过程与中文歌曲的执行过程基本相同,此处不再一一赘述。

49.在一实施例中,所述待播放歌曲为中文歌曲,上述步骤s20之前,所述曲调生成方法还包括:基于所述当前待播放歌曲的句子数、所述当前待播放歌曲中各个句子的字数及所述当前待播放歌曲中每个歌词的声母、韵母、声调,确定所述当前待播放歌曲的歌词音节特征。其中,歌词音节特征包括声母特征、韵母特征、声调特征。具体的,基于所述当前待播放歌曲的句子数、所述当前待播放歌曲中各个句子的最大字数及所述当前待播放歌曲中每个字的声母、韵母、声调,分别构建声母特征矩阵、韵母特征矩阵和声调特征矩阵。

50.步骤s30,获取所述目标歌曲的伴奏,并基于所述伴奏对所述当前待播放歌曲进行谱曲。

51.在本实施例中,获取目标歌曲的伴奏,并基于该目标歌曲的伴奏对该当前待播放歌曲进行谱曲。具体的,获取目标歌曲的伴奏以及当前待播放歌曲的歌词,然后,根据已有

的自动填词技术,将当前待播放歌曲的歌词填充至伴奏中,以实现对当前待播放歌曲的谱曲。

52.在本实施例中,获取目标歌曲的伴奏的方式可以是:

53.方式一:提取目标歌曲的歌曲名,根据该歌曲名搜索音乐伴奏曲库,以搜索该歌曲名对应的伴奏,若音乐伴奏曲库中搜索不到该歌曲名对应的伴奏,则通过伴奏提取技术提取目标歌曲的伴奏。

54.在方式一中,音乐伴奏曲库可以根据实际需要进行设定,例如,音乐播放终端对应的服务器端存储的伴奏曲库、该曲库生成方法执行终端的本地伴奏曲库、用户当前喜欢列表中的伴奏曲库等。其中,伴奏提取技术可以根据实际需要从已有技术中进行选择,此处不作具体限定。

55.方式二:通过伴奏提取技术直接提取目标歌曲的伴奏。

56.本技术实施例提供一种曲调生成方法,在获取到当前待播放歌曲时,在获取到当前待播放歌曲时,获取用户当前的心情标签,其中,当前的心情标签用于表征用户的心情状态;基于心情标签和当前待播放歌曲的歌词音节特征,确定与当前待播放歌曲相似的目标歌曲,该目标歌曲的心情标签与用户当前心情状态对应的心情标签匹配,以从心情状态匹配的歌曲中筛选歌词音节特征也匹配的目标歌曲,从而提高目标歌曲的伴奏与当前待播放歌曲的匹配度;获取目标歌曲的伴奏,并基于伴奏对当前待播放歌曲进行谱曲。通过上述方式,基于用户当前的心情标签得到目标歌曲,以使目标歌曲与用户当前心情状态对应的心情标签匹配,然后,通过目标歌曲的伴奏生成该当前待播放歌曲的曲调,从而确保当前待播放歌曲的曲调与用户当前心情匹配,以使当前待播放歌曲切合用户心情,进而提升用户的收听体验。同时,从心情状态匹配的歌曲中筛选歌词音节特征也匹配的目标歌曲,以提高目标歌曲的伴奏与当前待播放歌曲的匹配度,以使通过目标歌曲的伴奏生成的曲调与当前待播放歌曲更加匹配,从而进一步提升用户的收听体验。

57.进一步地,基于上述第一实施例,提出本技术曲调生成方法第二实施例。

58.参照图3,图3为本技术曲调生成方法第二实施例的流程示意图。

59.在本实施例中,上述步骤s10中,获取用户当前的心情标签,包括:

60.步骤s11,获取用户当前所处的环境属性信息和/或用户当前的体表特征;

61.在本实施例中,步骤s11包括以下三种方式:

62.方式一:获取用户当前所处的环境属性信息。

63.在方式一中,具体的,获取用户当前的位置信息,根据该位置信息通过第三方服务器获取环境属性信息。其中,环境属性信息包括以下至少一种:温度、体感温度、光照照度、湿度、气压、风力、空气质量、pm2.5、天气(阴天、晴天、大雨、小雨、雪、大风等)、紫外线强度等。该环境属性信息可以以向量形式表示,向量的长度可以与环境属性信息的参数数量一一对应,该向量中每个参数对应的数值可以根据特定规则进行处理得到,例如环境属性信息包括温度25摄氏度、湿度68%、气压1002hpa(百帕)、体感温度24摄氏度,则该环境属性信息对应向量为(25,68,1002,24)。

64.需要说明的是,若本技术曲调生成方法应用于音乐播放终端,由于用户收听歌曲时需要靠近该音乐播放终端,因此,可以通过音乐播放终端本身部署的导航定位系统确定用户当前的位置信息;若本技术曲调生成方法应用于音乐播放终端对应的服务器端,则通

过音乐播放终端本身部署的导航定位系统确定用户当前的位置信息,并基于音乐播放终端与服务器端的通信连接,将该位置信息发送至服务器端;若本技术曲调生成方法应用于音乐播放终端和对应的服务器端组成的曲调生成系统(从属于曲调生成设备),则通过音乐播放终端本身部署的导航定位系统确定用户当前的位置信息,并基于音乐播放终端与曲调生成系统的通信连接,将该位置信息发送至曲调生成系统。

65.此外,还需要说明的是,第三方服务器可以为网络气象网站和各种气象插件等。具体的,基于用户当前的位置信息,从第三方服务器查询对应位置的环境属性信息,以使第三方服务器返回环境属性信息至本技术曲调生成方法的执行端。进一步地,还获取当前时间,并将当前时间与用户当前的位置信息一同发送至第三方服务器,以供第三方服务器返回更加准确的环境属性信息。

66.方式二:获取用户当前的体表特征。

67.在方式二中,采集用户当前的体表特征。其中,体表特征包括以下至少一种:体温、心率、血压、压力、血氧饱和度、血糖、生理周期等。该体表特征可以以向量形式表示,向量的长度可以与体表特征的参数数量一一对应,该向量中每个参数对应的数值可以根据特定规则进行处理得到,例如体表特征包括体温37摄氏度、心率70次/分钟、压力55,则该体表特征对应向量为(37,70,55)。

68.需要说明的是,若本技术曲调生成方法应用于音乐播放终端,则采集用户当前的体表特征的采集设备可以部署于该音乐播放终端,例如可播放音乐的运动手环,可采集用户当前的体表特征,也可播放音乐;该采集设备还可以为独立于本技术曲调生成方法的执行端的设备,该采集设备例如智能运动手表、运动手环、智能眼镜以及各种智能可穿戴设备等等,此时,可建立本技术执行端与采集设备的通信连接,以使采集设备采集的体表特征传输至本技术执行端。

69.方式三:获取用户当前所处的环境属性信息和用户当前的体表特征。

70.在方式三中,获取用户当前所处的环境属性信息与上述方式一的执行过程基本相同,获取用户当前的体表特征与上述方式二的执行过程基本相同,此处不再一一赘述。

71.步骤s12,基于所述环境属性信息和/或所述体表特征,确定用户当前的心情状态;

72.在本实施例中,基于环境属性信息和/或体表特征,确定用户当前的心情状态。具体的,上述步骤s12包括:

73.步骤a121,将所述环境属性信息和/或所述体表特征,输入训练后的心情预测模型,进行心情类别预测,得到心情类别预测结果;

74.步骤a122,基于所述心情类别预测结果,确定用户当前的心情状态。

75.本实施例的具体执行过程,可参照下述三种方式,此处不再一一赘述。

76.在本实施例中,基于上述步骤s11的三种方式,步骤s12也包括以下三种方式:

77.方式一:基于所述环境属性信息,确定用户当前的心情状态。

78.在一种实施方式中,所述基于所述环境属性信息,确定用户当前的心情状态的步骤包括:

79.基于训练后的心情预测模型、所述环境属性信息,进行心情类别预测,得到心情类别预测结果;基于所述心情类别预测结果,确定用户当前的心情状态。具体的,基于训练后的心情预测模型中的特征提取器,提取所述环境属性信息中的环境属性特征信息,进而依

据所述环境属性特征信息以及所述心情预测模型中的分类器,对所述环境属性特征信息进行心情状态分类,获得分类概率向量;然后,确定所述分类概率向量中最大的分类概率值对应的心情类别标签,并将所述心情类别标签对应的心情类别作为心情类别预测结果;最后,基于心情类别预测结果和预设映射关系(心情类别预测结果和心情状态的映射关系),确定用户当前的心情状态。其中,心情类别包括雀跃类别、振奋类别、发怒类别、不满类别、开心类别、悲伤类别等。

80.为训练所述心情预测模型,在所述基于所述环境属性信息,确定用户当前的心情状态的步骤之前,所述曲调生成方法还包括:

81.获取环境属性训练数据,并对所述环境属性训练数据进行针对于心情状态特征的标签标注,获得心情状态标签数据。具体的,提取所述环境属性训练数据中的各个环境参数表示值,其中,所述环境参数表示值为表示环境状况特征值,例如,温度、体感温度、光照照度、湿度、气压、风力、空气质量、pm2.5、天气(阴天、晴天、大雨、小雨、雪、大风等)、紫外线强度等,进而基于各个环境参数表示值,为所述环境属性训练数据匹配对应的心情状态标签,进而获得心情状态标签数据。

82.其中,所述环境属性训练数据至少包括一训练环境属性数据,所述心情状态标签数据至少包括一心情状态标签。

83.进一步地,所述获取环境属性训练数据,并对所述环境属性训练数据进行针对于心情状态特征的标签标注,获得心情状态标签数据的步骤包括:

84.对所述环境属性训练数据中各个环境参数进行聚合,获得聚合特征数据;匹配所述聚合特征数据对应的心情状态标签,获得心情状态标签数据。具体的,基于预设聚合规则,对所述环境属性训练数据中各个环境参数进行聚合,获得聚合特征数据。其中,所述预设聚合规则包括加权求和以及加权平均等,例如,假设温度特征数据对应的特征值为25,湿度特征数据对应的特征值为0.6,气压特征数据对应的特征值为1000,预设聚合规则为加权求和,则所述聚合特征数据对应的特征值为25*0.02+0.6+1000*0.0005=1.6,可以理解,基于该预设聚合规则也可以实现对各个特征数据的归一化处理。最后,以所述聚合特征数据中的聚合特征值作为索引,查询所述心情状态标签,以获得心情状态标签数据。

85.在一实施例中,心情预测模型为卷积神经网络模型,所述心情预测模型包括特征提取器和分类器,所述基于训练后的心情预测模型、所述环境属性信息,进行心情类别预测,得到心情类别预测结果的步骤包括:

86.基于所述特征提取器,对所述环境属性信息进行特征提取,获得环境属性特征信息;依据所述环境属性特征信息和所述分类器,预测所述环境属性特征信息的心情类别,获得心情类别预测结果。

87.需要说明的是,该特征提取器由预设数量的卷积层和池化层交替排列构成,其中,该卷积层用于进行卷积操作,该池化层用于进行池化操作。该分类器由全连接层组成,用于将环境特征表示向量映射为一维向量。

88.具体的,将所述环境属性信息对应的环境表示向量输入所述特征提取器,对所述环境表示向量进行预设次数的卷积和池化交替处理,以将所述环境表示向量映射为环境特征表示向量,并将所述环境特征表示向量作为环境属性特征信息。其中,环境表示向量为表示所述环境属性信息的编码向量,用于通过数值向量表示所述环境属性信息,例如所述环

境表示向量可以为1

×

n的矩阵,所述1

×

n的矩阵由所述环境属性信息的各参数值组成。之后,将所述环境特征表示向量输入所述分类器,对所述环境特征表示向量进行全连接,以将所述环境特征表示向量映射为一维向量,获得分类概率向量,并将所述分类概率向量作为心情类别预测结果。其中,分类概率向量为环境属性信息属于不同的心情类别的概率组成的向量,例如,假设所述分类概率向量为(a,b,c),则a为环境属性信息属于心情类别a的概率,b为环境属性信息属于心情类别b的概率,c为环境属性信息属于心情类别c的概率。

89.在另一种实施方式中,所述基于所述环境属性信息,确定用户当前的心情状态的步骤包括:

90.基于所述环境属性信息和预设映射关系,确定用户当前的心情状态。其中,预设映射关系为环境属性信息与心情状态的映射关系,该预设映射关系可以存储于数据库、映射表等等。其中,环境属性信息包括以下至少一种:温度、体感温度、光照照度、湿度、气压、风力、空气质量、pm2.5、天气(阴天、晴天、大雨、小雨、雪、大风等)、紫外线强度等。

91.进一步地,所述基于所述环境属性信息和预设映射关系,确定用户当前的心情状态的步骤包括:

92.对所述环境属性信息中各个环境参数进行聚合,获得聚合数据;基于所述聚合数据和预设映射关系,确定用户当前的心情状态。具体的,基于预设聚合规则,对所述环境属性信息中各个环境参数进行聚合,获得聚合数据。其中,所述预设聚合规则包括加权求和以及加权平均等,例如,假设温度数据对应的特征值为25,湿度数据对应的特征值为0.6,气压数据对应的特征值为1000,预设聚合规则为加权求和,则所述聚合数据对应的特征值为25*0.02+0.6+1000*0.0005=1.6,可以理解,基于该预设聚合规则也可以实现对各个参数数据的归一化处理。最后,以所述聚合数据中的聚合值作为索引,从预设映射关系中查询所述聚合值对应的心情状态。

93.在方式一中,通过用户当前所处的环境属性信息确定用户当前的心情状态,可确定受环境影响的心情状态,从而提高心情状态监测的准确性。

94.方式二:基于所述体表特征,确定用户当前的心情状态。

95.在一种实施方式中,所述基于所述体表特征,确定用户当前的心情状态的步骤包括:

96.基于训练后的心情预测模型、所述体表特征,进行心情类别预测,得到心情类别预测结果;基于所述心情类别预测结果,确定用户当前的心情状态。具体的,基于训练后的心情预测模型中的特征提取器,提取所述体表特征中的体表特征信息,进而依据所述体表特征信息以及所述心情预测模型中的分类器,对所述体表特征信息进行心情状态分类,获得分类概率向量;然后,确定所述分类概率向量中最大的分类概率值对应的心情类别标签,并将所述心情类别标签对应的心情类别作为心情类别预测结果;最后,基于心情类别预测结果和预设映射关系(心情类别预测结果和心情状态的映射关系),确定用户当前的心情状态。其中,心情类别包括雀跃类别、振奋类别、发怒类别、不满类别、开心类别、悲伤类别等。

97.为训练所述心情预测模型,在所述基于所述体表特征,确定用户当前的心情状态的步骤之前,所述曲调生成方法还包括:

98.获取体表训练数据,并对所述体表训练数据进行针对于心情状态特征的标签标注,获得心情状态标签数据。具体的,提取所述体表训练数据中的各个体表参数表示值,其

中,所述体表参数表示值为表示体表状况特征值,例如,体温、心率、血压、压力、血氧饱和度、血糖、生理周期等,进而基于各个体表参数表示值,为所述体表训练数据匹配对应的心情状态标签,进而获得心情状态标签数据。

99.其中,所述体表训练数据至少包括一训练体表数据,所述心情状态标签数据至少包括一心情状态标签。

100.进一步地,所述获取体表训练数据,并对所述体表训练数据进行针对于心情状态特征的标签标注,获得心情状态标签数据的步骤包括:

101.对所述体表训练数据中各个体表参数进行聚合,获得聚合特征数据;匹配所述聚合特征数据对应的心情状态标签,获得心情状态标签数据。具体的执行流程与上述方式一相同,此处不再一一赘述。

102.在一实施例中,心情预测模型为卷积神经网络模型,所述心情预测模型包括特征提取器和分类器,所述基于训练后的心情预测模型、所述体表特征,进行心情类别预测,得到心情类别预测结果的步骤包括:

103.基于所述特征提取器,对所述体表特征进行特征提取,获得体表特征信息;依据所述体表特征信息和所述分类器,预测所述体表特征信息的心情类别,获得心情类别预测结果。

104.需要说明的是,该特征提取器由预设数量的卷积层和池化层交替排列构成,其中,该卷积层用于进行卷积操作,该池化层用于进行池化操作。该分类器由全连接层组成,用于将体表特征表示向量映射为一维向量。具体的执行流程与上述方式一相同,此处不再一一赘述

105.在另一种实施方式中,所述基于所述体表特征,确定用户当前的心情状态的步骤包括:

106.基于所述体表特征和预设映射关系,确定用户当前的心情状态。其中,预设映射关系为体表特征与心情状态的映射关系,该预设映射关系可以存储于数据库、映射表等等。其中,体表特征包括以下至少一种:体温、心率、血压、压力、血氧饱和度、血糖、生理周期等。

107.进一步地,所述基于所述体表特征和预设映射关系,确定用户当前的心情状态的步骤包括:

108.对所述体表特征中各个体表参数进行聚合,获得聚合数据;基于所述聚合数据和预设映射关系,确定用户当前的心情状态。具体的,基于预设聚合规则,对所述体表特征中各个环境参数进行聚合,获得聚合数据。其中,所述预设聚合规则包括加权求和以及加权平均等,例如,假设体温数据对应的特征值为37,心率数据对应的特征值为70,压力数据对应的特征值为50,预设聚合规则为加权求和,则所述聚合数据对应的特征值为37*0.01+70*0.01+50*0.01=1.57,可以理解,基于该预设聚合规则也可以实现对各个参数数据的归一化处理。最后,以所述聚合数据中的聚合值作为索引,从预设映射关系中查询所述聚合值对应的心情状态。

109.在方式二中,通过用户当前的体表特征确定用户当前的心情状态,可准确监测用户的心情状态。

110.方式三:基于所述环境属性信息和所述体表特征,确定用户当前的心情状态。

111.在一种实施方式中,所述基于所述环境属性信息和所述体表特征,确定用户当前

的心情状态的步骤包括:

112.基于训练后的心情预测模型、所述环境属性信息和所述体表特征,进行心情类别预测,得到心情类别预测结果;基于所述心情类别预测结果,确定用户当前的心情状态。

113.具体的,基于训练后的心情预测模型中的特征提取器,提取所述环境属性信息中的环境属性特征信息和所述体表特征中的体表特征信息,进而依据所述环境属性特征信息和所述体表特征信息以及所述心情预测模型中的分类器,对所述环境属性特征信息和所述体表特征信息进行心情状态分类,获得分类概率向量;然后,确定所述分类概率向量中最大的分类概率值对应的心情类别标签,并将所述心情类别标签对应的心情类别作为心情类别预测结果;最后,基于心情类别预测结果和预设映射关系(心情类别预测结果和心情状态的映射关系),确定用户当前的心情状态。其中,心情类别包括雀跃类别、振奋类别、发怒类别、不满类别、开心类别、悲伤类别等。

114.为训练所述心情预测模型,在所述基于所述环境属性信息和所述体表特征,确定用户当前的心情状态的步骤之前,所述曲调生成方法还包括:

115.获取环境属性训练数据和体表训练数据,并对所述环境属性训练数据和所述体表训练数据进行针对于心情状态特征的标签标注,获得心情状态标签数据。具体的,提取所述环境属性训练数据中的各个环境参数表示值和所述体表训练数据中的各个体表参数表示值,其中,所述环境参数表示值为表示环境状况特征值,例如,温度、体感温度、光照照度、湿度、气压、风力、空气质量、pm2.5、天气(阴天、晴天、大雨、小雨、雪、大风等)、紫外线强度等,所述体表参数表示值为表示体表状况特征值,例如,体温、心率、血压、压力、血氧饱和度、血糖、生理周期等,进而基于各个环境参数表示值和各个体表参数表示值,为所述环境属性训练数据和所述体表训练数据匹配对应的心情状态标签,进而获得心情状态标签数据。

116.其中,所述环境属性训练数据至少包括一训练环境属性数据,所述体表训练数据至少包括一训练体表数据,所述心情状态标签数据至少包括一心情状态标签。

117.需要说明的是,在心情预测模型的一次训练过程中,环境属性训练数据和体表训练数据对应相同心情状态。具体的,在将环境属性训练数据和体表训练数据输入至心情预测模型前,基于所述环境属性信息和第一预设映射关系,确定对应的第一心情状态,基于所述体表特征和第二预设映射关系,确定对应的第二心情状态。其中,第一预设映射关系为环境属性信息与心情状态的映射关系,该第一预设映射关系可以存储于数据库、映射表等等;第二预设映射关系为体表特征与心情状态的映射关系,该第二预设映射关系可以存储于数据库、映射表等等。然后,基于确定的第一心情状态和第二心情状态,将相同心情状态的环境属性训练数据和体表训练数据输入心情预测模型。

118.进一步地,所述获取环境属性训练数据和体表训练数据,并对所述环境属性训练数据和所述体表训练数据进行针对于心情状态特征的标签标注,获得心情状态标签数据的步骤包括:

119.对所述环境属性训练数据中各个环境参数进行聚合,获得第一聚合特征数据;匹配所述第一聚合特征数据对应的心情状态标签,获得心情状态标签数据。具体的,基于预设聚合规则,对所述环境属性训练数据中各个环境参数进行聚合,获得第一聚合特征数据。其中,所述预设聚合规则包括加权求和以及加权平均等,例如,假设温度特征数据对应的特征值为25,湿度特征数据对应的特征值为0.6,气压特征数据对应的特征值为1000,预设聚合

规则为加权求和,则所述第一聚合特征数据对应的特征值为25*0.02+0.6+1000*0.0005=1.6,可以理解,基于该预设聚合规则也可以实现对各个特征数据的归一化处理。相应的,对所述体表训练数据中各个体表参数进行聚合,获得第二聚合特征数据,具体的执行流程与上述对所述环境属性训练数据中各个环境参数进行聚合,获得第一聚合特征数据基本相同,此处不再赘述。最后,将第一聚合特征数据和第二聚合特征数据再进行合并,得到合并聚合特征数据,以所述合并聚合特征数据中的聚合特征值作为索引,查询所述心情状态标签,以获得心情状态标签数据。

120.进一步地,所述心情预测模型包括第一特征提取器、第二特征提取器和分类器,上述步骤a121包括:

121.基于所述第一特征提取器,对所述环境属性信息进行特征提取,获得环境属性特征信息;基于所述第二特征提取器,对所述体表特征进行特征提取,获得体表特征信息;通过所述分类器,对所述环境属性特征信息和所述体表特征信息进行聚合,并基于聚合结果预测心情类别,得到心情类别预测结果。

122.在本实施例中,基于第一特征提取器,对环境属性信息进行特征提取,获得环境属性特征信息,并且,基于第二特征提取器,对体表特征进行特征提取,获得体表特征信息,然后,通过分类器,对环境属性特征信息和体表特征信息进行聚合,并基于聚合结果预测心情类别,得到心情类别预测结果。

123.需要说明的是,该第一特征提取器和第二特征提取器由预设数量的卷积层和池化层交替排列构成,其中,该卷积层用于进行卷积操作,该池化层用于进行池化操作。该分类器由全连接层组成,用于将环境表示向量和体表特征表示向量进行合并得到合并表示向量,还用于将合并表示向量映射为一维向量。

124.具体的,将所述环境属性信息对应的环境表示向量输入所述第一特征提取器,对所述环境表示向量进行预设次数的卷积和池化交替处理,以将所述环境表示向量映射为环境特征表示向量,并将所述环境特征表示向量作为环境属性特征信息,同时,将所述体表特征对应的体表表示向量输入所述第二特征提取器,对所述体表表示向量进行预设次数的卷积和池化交替处理,以将所述体表表示向量映射为体表特征表示向量,并将所述体表特征表示向量作为体表特征信息。其中,环境表示向量为表示所述环境属性信息的编码向量,用于通过数值向量表示所述环境属性信息,例如所述环境表示向量可以为1

×

n的矩阵,所述1

×

n的矩阵由所述环境属性信息的各参数值组成;体表表示向量为表示所述体表特征的编码向量,用于通过数值向量表示所述体表特征,例如所述体表表示向量可以为1

×

n的矩阵,所述1

×

n的矩阵由所述体表特征的各参数值组成。之后,将所述环境特征表示向量和所述体表特征表示向量输入所述分类器,对所述环境特征表示向量和所述体表特征表示向量进行全连接,以将所述环境特征表示向量和所述体表特征表示向量进行合并,并映射为一维向量,获得分类概率向量,并将所述分类概率向量作为心情类别预测结果。其中,分类概率向量为体表特征属于不同的心情类别的概率组成的向量,例如,假设所述分类概率向量为(a,b,c),则a为体表特征属于心情类别a的概率,b为体表特征属于心情类别b的概率,c为体表特征属于心情类别c的概率。

125.在一实施例中,心情预测模型为卷积神经网络模型,所述第一特征提取器和第二特征提取器包括2个卷积层和2个池化层,所述分类器包括一个全连接层,所述心情预测模

型还包括2个输入通道,1个输出层。其中,2个输入通道分别输入环境表示向量和体表表示向量。需要说明的是,若环境表示向量的长度比体表表示向量的长度大,则对体表表示向量进行补零处理,以使体表表示向量与环境表示向量长度相同,以便于心情预测模型的处理。相应的,若体表表示向量的长度比环境表示向量的长度大,则对环境表示向量进行补零处理,以使环境表示向量与体表表示向量长度相同,以便于心情预测模型的处理。其中,卷积核的大小可以根据实际需要进行设定,例如卷积核为1

×

3的矩阵。

126.在另一种实施方式中,所述基于所述环境属性信息和所述体表特征,确定用户当前的心情状态的步骤包括:

127.基于所述环境属性信息、所述体表特征和预设映射关系,确定用户当前的心情状态。其中,预设映射关系为环境属性信息、体表特征与心情状态的映射关系,该预设映射关系可以存储于数据库、映射表等等。其中,环境属性信息包括以下至少一种:温度、体感温度、光照照度、湿度、气压、风力、空气质量、pm2.5、天气(阴天、晴天、大雨、小雨、雪、大风等)、紫外线强度等;体表特征包括以下至少一种:体温、心率、血压、压力、血氧饱和度、血糖、生理周期等。

128.进一步地,所述基于所述环境属性信息、所述体表特征和预设映射关系,确定用户当前的心情状态的步骤包括:

129.对所述环境属性信息中各个环境参数进行聚合,获得第一聚合数据;对所述体表特征中各个体表参数进行聚合,获得第二聚合数据;对所述第一聚合数据和所述第二聚合数据进行聚合,获得第三聚合数据;基于所述第三聚合数据和预设映射关系,确定用户当前的心情状态。具体的,基于预设聚合规则,对所述环境属性信息中各个环境参数进行聚合,获得聚合数据。其中,所述预设聚合规则包括加权求和以及加权平均等,例如,假设温度数据对应的特征值为25,湿度数据对应的特征值为0.6,气压数据对应的特征值为1000,预设聚合规则为加权求和,则所述聚合数据对应的特征值为25*0.02+0.6+1000*0.0005=1.6,可以理解,基于该预设聚合规则也可以实现对各个参数数据的归一化处理。相应的,对所述体表特征中各个体表参数进行聚合,获得第二聚合数据的执行流程以及对所述第一聚合数据和所述第二聚合数据进行聚合,获得第三聚合数据,与上述对所述环境属性训练数据中各个环境参数进行聚合,获得第一聚合特征数据基本相同,此处不再赘述。最后,以所述第三聚合数据中的聚合值作为索引,从预设映射关系中查询所述聚合值对应的心情状态。

130.在方式三中,通过用户当前所处的环境属性信息确定用户当前的心情状态,可确定受环境影响的心情状态,从而提高心情状态监测的准确性。通过用户当前的体表特征确定用户当前的心情状态,可准确监测用户的心情状态。将用户当前所处的环境属性信息和用户当前的体表特征进行合并,并基于合并后的信息确定用户当前的心情状态,可进一步提高心情状态监测的准确性。

131.步骤s13,基于所述心情状态,确定用户当前的心情标签。

132.在本实施例中,基于心情状态,确定用户当前的心情标签,以使后续基于该心情标签获取对应的曲调,以对当前待播放歌曲进行谱曲。具体的,基于心情状态和预设映射关系,确定用户当前的心情标签,其中,预设映射关系为心情状态与心情标签的映射关系。

133.本实施例中,可以通过用户当前所处的环境属性信息确定用户当前的心情状态,

可确定受环境影响的心情状态,从而提高心情状态监测的准确性。也可以通过用户当前的体表特征确定用户当前的心情状态,可准确监测用户的心情状态。还可以将用户当前所处的环境属性信息和用户当前的体表特征进行合并,并基于合并后的信息确定用户当前的心情状态,可进一步提高心情状态监测的准确性。

134.进一步地,基于上述第一实施例,提出本技术曲调生成方法第三实施例。

135.在本实施例中,上述步骤s20包括:

136.步骤a21,基于所述心情标签从预设曲库中筛选得到目标曲库;

137.在本实施例中,基于该用户当前的心情标签从预设曲库中筛选得到目标曲库。具体的,从预设曲库的所有歌曲中获取设定有该心情标签的歌曲,即获取预设区库中心情标签与该用户当前的心情标签一致的歌曲,然后,将设定有该心情标签的歌曲组成目标曲库,以供后续基于目标曲库进一步筛选得到目标歌曲。

138.其中,预设曲库可以根据实际需要进行设定,例如,音乐播放终端对应的服务器端存储的曲库、该曲库生成方法执行终端的本地曲库、用户当前喜欢列表中的曲库等。

139.步骤a22,基于所述当前待播放歌曲的歌词音节特征,从所述目标曲库中筛选得到与所述当前待播放歌曲相似的目标歌曲。

140.在本实施例中,基于当前待播放歌曲的歌词音节特征,从目标曲库中筛选得到与当前待播放歌曲相似的目标歌曲。其中,歌词音节特征为歌曲文字对应的语调特征,而歌曲文字的文本特征包括语调特征和语义特征。其中,目标歌曲通常为与当前待播放歌曲的歌词音节特征最相似的歌曲。

141.需要说明的是,音节是歌词中音位组合构成的最小语音结构单位。歌词音节特征的具体内容可以根据歌曲的语言类型进行确定,例如,对于中文歌来说,歌词音节特征包括声母特征、韵母特征和声调特征;对于英文歌来说,歌词音节特征包括元音特征和辅音特征;对于日文歌来说,歌词音节特征包括五十音的清音特征、浊音特征、半浊音特征、促音特征、拨音特征和长音特征。此外,对于其它语言的歌曲此处不再一一赘述。

142.具体的,上述步骤a22包括:

143.步骤a221,获取所述当前待播放歌曲的第一歌词音节特征,并获取所述目标曲库中各个歌曲的第二歌词音节特征,其中,所述第一歌词音节特征包括第一声母特征、第一韵母特征和第一声调特征,所述第二歌词音节特征包括第二声母特征、第二韵母特征和第二声调特征;

144.步骤a222,将所述第一声母特征分别与各个所述第二声母特征进行相似度计算,得到第一相似度序列;

145.步骤a223,将所述第一韵母特征分别与各个所述第二韵母特征进行相似度计算,得到第二相似度序列;

146.步骤a224,将所述第一声调特征分别与各个所述第二声调特征进行相似度计算,得到第三相似度序列;

147.在本实施例中,将第一声母特征分别与各个第二声母特征进行相似度计算,得到第一相似度序列,并且,将第一韵母特征分别与各个第二韵母特征进行相似度计算,得到第二相似度序列,并且,将第一声调特征分别与各个第二声调特征进行相似度计算,得到第三相似度序列。

148.需要说明的是,对于中文歌曲来说,当前待播放歌曲中一个歌词的音节包括声母、韵母和声调。也就是说,当前待播放歌曲中包括多个第一声母特征、多个第一韵母特征和多个第一声调特征。相应的,目标曲库中各个歌曲中也包括多个第二声母特征、多个第二韵母特征和多个第二声调特征。

149.具体的,基于当前待播放歌曲的句子数、每个句子的字数以及每个字的声母,和目标曲库中一歌曲的句子数、每个句子的字数以及每个字的声母,分别对对应位置的歌词的声母进行相似度计算,以得到多个相似度值,然后对多个相似度值进行聚合处理,得到当前待播放歌曲与目标曲库中一歌曲的相似度值,然后,基于上述相同的处理,得到当前待播放歌曲与目标曲库中所有歌曲的相似度值,以得到第一相似度序列。其中,相似度计算的计算方法可以根据需要进行设定,例如余弦相似度计算方法。聚合处理可以为求和处理、平均处理、加权处理或加权平均处理等。相应的,韵母的相似度计算与声调的相似度计算与上述声母的相似度计算过程基本相同,此处不再一一赘述。

150.在另一实施方式中,所述第一声母特征为第一声母特征矩阵,所述第一韵母特征为第一韵母特征矩阵,所述第一声调特征为第一声调特征矩阵,所述第二声母特征为第二声母特征矩阵,所述第二韵母特征为第二韵母特征矩阵,所述第二声调特征为第二声调特征矩阵。上述步骤a222包括:将所述第一声母特征矩阵分别与各个所述第二声母特征矩阵进行相似度计算,得到第一相似度序列。上述步骤a223包括:将所述第一韵母特征矩阵分别与各个所述第二韵母特征矩阵进行相似度计算,得到第二相似度序列。上述步骤a224包括:将所述第一声调特征矩阵分别与各个所述第二声调特征矩阵进行相似度计算,得到第三相似度序列。

151.需要说明的是,基于当前待播放歌曲的句子数n、当前待播放歌曲中各个句子的字数m

n

及当前待播放歌曲中每个歌词的声母s、韵母y、声调t,分别构建第一声母特征矩阵s0、第一韵母特征矩阵y0和第一声调特征矩阵t0。其中,各个矩阵的行数为句子数n;列数为max(m1,m2,...,m

n

),即列数为当前待播放歌曲中各个句子的最大字数,若各个矩阵中某一行达不到列数,即有些句子的字数比最大字数少,在空缺的位置补零,以分别构建行数为n列数为max(m1,m2,...,m

n

)的第一声母特征矩阵s0、第一韵母特征矩阵y0和第一声调特征矩阵t0。当然,各个矩阵的行数也可以为max(m1,m2,...,m

n

),即列数为当前待播放歌曲中各个句子的最大字数,列数为句子数n。

152.其中,第一声母特征矩阵s0如下所述:

[0153][0154]

s

nm

表示第n行第m列的声母,用于显示声母的排序。

[0155]

其中,第一韵母特征矩阵y0如下所述:

[0156][0157]

y

nm

表示第n行第m列的韵母,用于显示韵母的排序。

[0158]

其中,第一声调特征矩阵t0如下所述:

[0159][0160]

t

nm

表示第n行第m列的声调,用于显示声调的排序。

[0161]

此外,还需要说明的是,基于目标曲库的所有歌曲,构建各个所述第二声母特征矩阵、各个所述第二韵母特征矩阵和各个所述第二声调特征矩阵,与上述基于当前待播放歌曲构建矩阵的执行流程基本相同,此处不再一一赘述。为便于说明,将各个第二声母特征矩阵设定为s1‑

s

n

,将各个第二韵母特征矩阵设定为y1‑

y

n

,将各个第二声调特征矩阵设定为t1‑

t

n

。

[0162]

具体的,通过预设相似度计算公式,将第一声母特征矩阵s0分别与各个第二声母特征矩阵s1‑

s

n

进行相似度计算,得到第一相似度序列进行相似度计算,得到第一相似度序列通过预设相似度计算公式,将第一韵母特征矩阵y0分别与各个第二韵母特征矩阵y1‑

y

n

进行相似度计算,得到第二相似度序列算,得到第二相似度序列通过预设相似度计算公式,将第一声调特征矩阵t0分别与各个第二声母特征矩阵t1‑

t

n

进行相似度计算,得到第三相似度序列进行相似度计算,得到第三相似度序列

[0163]

在一实施例中,声母的预设相似度计算公式如下所述:

[0164][0165]

韵母的预设相似度计算公式如下所述:

[0166]

[0167]

声调的预设相似度计算公式如下所述:

[0168][0169]

其中,k为目标曲库中歌曲对应的次序。声母的预设相似度计算公式表示第一声母特征矩阵s0的每一行与目标曲库中第k个歌曲的第二声母矩阵s

k

的每一行进行余弦相似度计算,以计算得到每一行对应的相似度值,若第一声母特征矩阵s0和第二声母矩阵s

k

的行数不相同,则多出的行对应的相似度值为0,然后,将每一行对应的相似度值进行求和计算得到第一声母特征矩阵s0和第二声母矩阵s

k

的相似度最后,基于此,得到第一声母特征矩阵s0和目标曲库中各个歌曲的各个第二声母矩阵s

k

的各个相似度从而获得第一相似度序列相应的,韵母和声调的相似度计算过程与上述声母的计算过程基本相同,此处不再赘述。

[0170]

可以理解,将歌曲的声母、韵母和声调分别通过矩阵进行表示,以使歌曲的所有歌词的声母融合在一个矩阵中进行处理,歌曲的所有歌词的韵母融合在一个矩阵中进行处理,歌曲的所有歌词的声调融合在一个矩阵中进行处理,从而提高相似度计算的效率,进而提高曲调生成的效率。

[0171]

进一步地,所述第一声母特征为第一声母特征矩阵,所述第一韵母特征为第一韵母特征矩阵,所述第一声调特征为第一声调特征矩阵,所述第二声母特征为第二声母特征矩阵,所述第二韵母特征为第二韵母特征矩阵,所述第二声调特征为第二声调特征矩阵,在上述步骤a221之前,该曲调生成方法还包括:

[0172]

基于所述当前待播放歌曲的句子数、所述当前待播放歌曲中各个句子的最大字数及所述当前待播放歌曲中每个字的声母、韵母、声调,分别构建所述第一声母特征矩阵、所述第一韵母特征矩阵和所述第一声调特征矩阵;基于所述目标曲库中各个歌曲的句子数、所述各个歌曲中各个句子的最大字数及所述各个歌曲中每个字的声母、韵母、声调,分别构建各个所述第二声母特征矩阵、各个所述第二韵母特征矩阵和各个所述第二声调特征矩阵。

[0173]

在本实施例中,基于当前待播放歌曲的句子数n、当前待播放歌曲中各个句子的最大字数max(m1,m2,...,m

n

)及当前待播放歌曲中每个歌词的声母s、韵母y、声调t,分别构建第一声母特征矩阵s0、第一韵母特征矩阵y0和第一声调特征矩阵t0。其中,各个矩阵的行数为句子数n;列数为max(m1,m2,...,m

n

),m

n

表示第n行的字数,若各个矩阵中某一行达不到列数,即有些句子的字数比最大字数少,在空缺的位置补零,以分别构建行数为n列数为max(m1,m2,...,m

n

)的第一声母特征矩阵s0、第一韵母特征矩阵y0和第一声调特征矩阵t0。当然,各个矩阵的行数也可以为max(m1,m2,...,m

n

),即列数为当前待播放歌曲中各个句子的最大字数,列数为句子数n,此处的执行流程类似,不再赘述。

[0174]

在本实施例中,基于目标曲库中各个歌曲的句子数n、各个歌曲中各个句子的最大字数max(m1,m2,...,m

n

)及各个歌曲中每个字的声母s、韵母y、声调t,分别构建各个第二声母特征矩阵s1‑

s

n

、各个第二韵母特征矩阵y1‑

y

n

和各个第二声调特征矩阵t1‑

t

n

。其中,各个

矩阵的行数为句子数n;列数为max(m1,m2,...,m

n

),m

n

表示第n行的字数,若各个矩阵中某一行达不到列数,即有些句子的字数比最大字数少,在空缺的位置补零,以分别构建行数为n列数为max(m1,m2,...,m

n

)的各个第二声母特征矩阵s1‑

s

n

、各个第二韵母特征矩阵y1‑

y

n

和各个第二声调特征矩阵t1‑

t

n

。当然,各个矩阵的行数也可以为max(m1,m2,...,m

n

),即列数为各个歌曲中各个句子的最大字数,列数为句子数n,此处的执行流程类似,不再赘述。

[0175]

步骤a225,基于所述第一相似度序列、所述第二相似度序列和所述第三相似度序列,从所述目标曲库中筛选得到与所述当前待播放歌曲相似的目标歌曲。

[0176]

在本实施例中,基于声母的第一相似度序列、韵母的第二相似度序列和声调的第三相似度序列,从目标曲库中筛选得到与当前待播放歌曲相似的目标歌曲。具体的,将第一相似度序列、第二相似度序列和第三相似度序列进行融合处理,然后,基于融合处理的相似度序列,从目标曲库中筛选得到与当前待播放歌曲相似的目标歌曲。其中,相似的目标歌曲可以为最相似的目标歌曲,即从目标曲库中筛选相似度值最大的目标歌曲。

[0177]

具体的,上述步骤a225包括:

[0178]

步骤a2251,分别对所述第一相似度序列、所述第二相似度序列和所述第三相似度序列进行归一化处理;

[0179]

在本实施例中,分别对第一相似度序列、第二相似度序列和第三相似度序列进行归一化处理,以便后续更好地将各个相似度序列进行融合处理。

[0180]

在一实施例中,归一化处理的公式如下所述:

[0181][0182]

其中,t用于区分声母、韵母和声调的相似度序列,t=1对应声母,t=2对应韵母,t=3对应声调。其中,max(d

t

)为d

t

中的最大值,例如,max(d1)为第一相似度序列中的最大值基于此,d

t

中所有相似度值均变成归一化后的值。

[0183]

步骤a2252,分别对归一化处理后的第一相似度序列、归一化处理后的第二相似度序列和归一化处理后的第三相似度序列进行数据提取;

[0184]

步骤a2253,基于各个数据提取结果构建各个相似度向量,其中,所述相似度向量的个数为所述目标曲库的歌曲数;

[0185]

在本实施例中,分别对归一化处理后的第一相似度序列、归一化处理后的第二相似度序列和归一化处理后的第三相似度序列进行数据提取,以提取得到当前待播放歌曲与目标曲库中各个歌曲的相似度值。然后,基于各个数据提取结果构建各个相似度向量,其中,相似度向量的个数为所述目标曲库的歌曲数。

[0186]

具体的,提取归一化处理后的第一相似度序列的各个相似度值提取归一化处理后的第二相似度序列提取归一化处理后的第二相似度序列的各个相似度值提取归一化处理后的第三相似度序列提取归一化处理后的第三相似度序列的各个相似度值然后,将归一化处理后的第一相似度序列归一化处理后的第二相似度序列和归一化处理后的第三相似度序列中目标曲库中同一歌曲对应的相似度值构

成一个相似度向量,基于此,得到目标曲库中所有歌曲对应的各个相似度向量。

[0187]

例如,目标曲库中第t个歌曲对应的相似度向量为其中,为归一化处理后的第一相似度序列的第t个归一化相似度值,为归一化处理后的第二相似度序列的第t个归一化相似度值,为归一化处理后的第三相似度序列的第t个归一化相似度值。

[0188]

步骤a2254,基于各个所述相似度向量,从所述目标曲库中筛选得到与所述当前待播放歌曲相似的目标歌曲。

[0189]

在本实施例中,基于各个相似度向量,从目标曲库中筛选得到与当前待播放歌曲相似的目标歌曲。具体的,基于各个相似度向量,从中挑选相似度较大的相似度向量,进而基于该较大的相似度向量,从目标曲库中筛选得到与当前待播放歌曲相似的目标歌曲。

[0190]

在一实施例中,上述步骤a2254包括:

[0191]

步骤a22541,将各个所述相似度向量和预设最大向量进行相似度计算,得到音节相似度序列;

[0192]

在本实施例中,将各个相似度向量和预设最大向量进行相似度计算,得到音节相似度序列。具体的,通过预设相似度计算公式,将各个相似度向量q

t

和预设最大向量m=(1,1,1)进行相似度计算,得到音节相似度r

t

,然后,基于所有的音节相似度r

t

得到音节相似度序列r={r1,r2,...,r

n

}。

[0193]

在一些实施例中,预设相似度计算公式如下所述:

[0194]

r

t

=|m|

‑

|q

t

‑

m|

[0195]

需要说明的是,r

t

越大则表示目标曲库中第t首歌曲与当前待播放歌曲更相似。

[0196]

步骤a22542,基于所述音节相似度序列,从所述目标曲库中筛选得到与所述当前待播放歌曲相似的目标歌曲。

[0197]

在本实施例中,基于音节相似度序列,从目标曲库中筛选得到与当前待播放歌曲相似的目标歌曲。具体的,提取音节相似度序列r={r1,r2,...,r

n

}中相似度值最大的r

t

,然后,根据t的值确定最相似的目标歌曲,以从目标曲库中筛选得到与所述当前待播放歌曲最相似的目标歌曲。

[0198]

本实施例中,通过声母、韵母和声调三个歌词音节特征,从心情状态匹配的目标曲库中筛选歌词音节特征也匹配的目标歌曲,以提高目标歌曲的伴奏与当前待播放歌曲的匹配度,以使通过目标歌曲的伴奏生成的曲调与当前待播放歌曲更加匹配,从而进一步提升用户的收听体验。并且,同时基于声母、韵母和声调三个歌词音节特征可进一步提高目标歌曲与当前待播放歌曲的匹配度,从而进一步提高目标歌曲的伴奏与当前待播放歌曲的匹配度。

[0199]

本技术还提供一种曲调生成装置。

[0200]

参照图4,图4为本技术曲调生成装置第一实施例的功能模块示意图。

[0201]

在本实施例中,所述曲调生成装置包括:

[0202]

获取模块10,用于在获取到当前待播放歌曲时,获取用户当前的心情标签,其中,所述当前的心情标签用于表征所述用户的心情状态;

[0203]

确定模块20,用于基于所述心情标签和所述当前待播放歌曲的歌词音节特征,确

定与所述当前待播放歌曲相似的目标歌曲,所述目标歌曲与所述心情标签匹配;

[0204]

谱曲模块30,用于获取所述目标歌曲的伴奏,并基于所述伴奏对所述当前待播放歌曲进行谱曲。

[0205]

进一步地,所述获取模块10包括:

[0206]

信息获取单元,用于获取用户当前所处的环境属性信息和/或用户当前的体表特征;

[0207]

心情确定单元,用于基于所述环境属性信息和/或所述体表特征,确定用户当前的心情状态;

[0208]

标签确定单元,用于基于所述心情状态,确定用户当前的心情标签。

[0209]

进一步地,所述心情确定单元包括:

[0210]

心情预测子单元,用于基于训练后的心情预测模型、所述环境属性信息和所述体表特征,进行心情类别预测,得到心情类别预测结果;

[0211]

心情确定子单元,用于基于所述心情类别预测结果,确定用户当前的心情状态。

[0212]

进一步地,所述确定模块20包括:

[0213]

第一筛选单元,用于基于所述心情标签从预设曲库中筛选得到目标曲库;

[0214]

第二筛选单元,用于基于所述当前待播放歌曲的歌词音节特征,从所述目标曲库中筛选得到与所述当前待播放歌曲相似的目标歌曲。

[0215]

进一步地,所述第二筛选单元包括:

[0216]

特征获取子单元,用于获取所述当前待播放歌曲的第一歌词音节特征,并获取所述目标曲库中各个歌曲的第二歌词音节特征,其中,所述第一歌词音节特征包括第一声母特征、第一韵母特征和第一声调特征,所述第二歌词音节特征包括第二声母特征、第二韵母特征和第二声调特征;

[0217]

相似度计算子单元,用于将所述第一声母特征分别与各个所述第二声母特征进行相似度计算,得到第一相似度序列;

[0218]

相似度计算子单元,还用于将所述第一韵母特征分别与各个所述第二韵母特征进行相似度计算,得到第二相似度序列;

[0219]

相似度计算子单元,还用于将所述第一声调特征分别与各个所述第二声调特征进行相似度计算,得到第三相似度序列;

[0220]

歌曲筛选子单元,用于基于所述第一相似度序列、所述第二相似度序列和所述第三相似度序列,从所述目标曲库中筛选得到与所述当前待播放歌曲相似的目标歌曲。

[0221]

进一步地,所述歌曲筛选子单元还用于分别对所述第一相似度序列、所述第二相似度序列和所述第三相似度序列进行归一化处理;分别对归一化处理后的第一相似度序列、归一化处理后的第二相似度序列和归一化处理后的第三相似度序列进行数据提取;基于各个数据提取结果构建各个相似度向量,其中,所述相似度向量的个数为所述目标曲库的歌曲数;基于各个所述相似度向量,从所述目标曲库中筛选得到与所述当前待播放歌曲相似的目标歌曲。

[0222]

进一步地,所述歌曲筛选子单元还用于将各个所述相似度向量和预设最大向量进行相似度计算,得到音节相似度序列;基于所述音节相似度序列,从所述目标曲库中筛选得到与所述当前待播放歌曲相似的目标歌曲。

[0223]

其中,上述曲调生成装置中各个模块的功能实现与上述曲调生成方法实施例中各步骤相对应,其功能和实现过程在此处不再一一赘述。

[0224]

本技术还提供一种计算机可读存储介质,该计算机可读存储介质上存储有曲调生成程序,所述曲调生成程序被处理器执行时实现如以上任一项实施例所述的曲调生成方法的步骤。

[0225]

本技术计算机可读存储介质的具体实施例与上述曲调生成方法各实施例基本相同,在此不作赘述。

[0226]

本技术还提供一种计算机程序产品,所述计算机程序产品包括计算机程序,所述计算机程序产品被处理器执行时实现如以上任一项实施例所述的曲调生成方法的步骤。

[0227]

本技术计算机程序产品的具体实施例与上述曲调生成方法各实施例基本相同,在此不作赘述。

[0228]

需要说明的是,在本文中,术语“包括”、“包含”或者其任何其他变体意在涵盖非排他性的包含,从而使得包括一系列要素的过程、方法、物品或者系统不仅包括那些要素,而且还包括没有明确列出的其他要素,或者是还包括为这种过程、方法、物品或者系统所固有的要素。在没有更多限制的情况下,由语句“包括一个

……”

限定的要素,并不排除在包括该要素的过程、方法、物品或者系统中还存在另外的相同要素。

[0229]

上述本技术实施例序号仅仅为了描述,不代表实施例的优劣。

[0230]

以上仅为本技术的优选实施例,并非因此限制本技术的专利范围,凡是利用本技术说明书及附图内容所作的等效结构或等效流程变换,或直接或间接运用在其他相关的技术领域,均同理包括在本技术的专利保护范围内。