1.本发明属于人机交互技术领域,具体提供一种语音识别方法、语音识别系统和电器设备。

背景技术:

2.电器设备可以分为家用电器和商用电器,其中,家用电器主要包括洗衣机、冰箱和空调等,随着电器设备的日益普及,各种电器设备的功能也开始变得越来越强大,人们对电器设备的要求也越来越高。

3.以洗衣机为例,为了提升用户的使用体验,有的洗衣机增加了语音识别功能,用户可以直接对洗衣机进行语音控制,既方便又快捷。然而,在实际应用中我们发现,洗衣机的语音识别功能常常出现错误,导致洗衣机无法准确地获取用户的真实意图,影响了用户的使用体验。

4.公开号为cn111045639a的专利申请文件中公开了一种语音输入方法,所述方法包括:在接收到语音输入指令时,接收麦克风采集的语音信号;从所述语音信号中获取环境噪声;当所述环境噪声的声音强度大于预设强度阈值时,获取唇部图像;对所述唇部图像进行唇语识别,获取唇语识别结果;对所述语音信号进行语音识别,获取语音输入结果;在所述唇语识别结果和所述语音输入结果匹配时,将所述语音输入结果作为所述唇部图像对应的用户输入信息;显示所述用户输入信息对应的内容。也就是说,上述专利中获取唇语识别结果后,只是用唇语识别结果来判断语音输入识别结构的准确性,如果唇语识别结果和语音输入结果匹配,则可以采用语音输入结果,但是,如果不匹配呢?该专利中并没有说明唇语识别结果和语音输入结果不匹配时如何处理。

5.公开号为cn108319912a的专利申请文件共开了一种唇语识别方法,所述方法包括:利用摄像头获取唇语信息,所述唇语信息包括口型、口部肌肉变动信息,唇色、口边肤色信息和面部表情信息三类;将所述口型、口部肌肉变动信息与存储器中的口型模型信息进行对比分析,得到第一唇语信息;根据所述唇色、口边肤色信息检测唇色和口边肤色的色素分布,运用存储器中的智能算法进行口部运动特征判断,并与存储器中的口型模型信息进行对比分析,得到第二唇语信息;利用图像处理技术对所述面部表情信息进行表情识别,并与存储器中的表情模型信息进行对比分析,得到第三唇语信息;对所述第一唇语信息、所述第二唇语信息和所述第三唇语信息进行归一处理,将归一处理后的唇语信息转化为语音信息。也就是说,该专利中仅是通过唇语信息来获取用户的真实意图,并没有采集语音信息。但是,仅通过唇语信息来获取用户的真实意图也容易出现错误。

6.因此,本领域需要一种语音识别方法、语音识别系统和电器设备来解决上述问题。

技术实现要素:

7.为了解决现有技术中的上述问题,即为了解决现有的语音识别方法易发生无法准确获取用户的真实意图的问题,本发明提供了一种语音识别方法,所述语音识别方法包括:

获取语音信息和唇语信息,根据所述语音信息生成第一语句;根据所述唇语信息生成第二语句;根据所述第一语句和所述第二语句生成最终语句。

8.在上述语音识别方法的优选技术方案中,“根据所述第一语句和所述第二语句生成最终语句”的步骤具体包括:将所述第一语句拆解以获得多个不同类别的第一意图词;将所述第二语句拆解以获得多个不同类别的第二意图词;分别判断同一类别中的所述第一意图词和所述第二意图词的语义相似度是否达到要求;根据判断结果,选择性地保留所述第一意图词或所述第二意图词;根据最终保留的所述第一意图词和所述第二意图词生成最终语句。

9.在上述语音识别方法的优选技术方案中,“根据判断结果,选择性地保留所述第一意图词或所述第二意图词”的步骤具体包括:如果所述第一意图词和所述第二意图词的语义相似度未达到要求,则根据环境噪音的大小,选择性地保留所述第一意图词或所述第二意图词。

10.在上述语音识别方法的优选技术方案中,“根据环境噪音的大小,选择性地保留所述第一意图词或所述第二意图词”的步骤具体包括:如果所述环境噪音位于低噪音区,则保留所述第一意图词;如果所述环境噪音位于中度噪音区且所述第一意图词和所述第二意图词属于高稳定性类别,则保留所述第一意图词;如果所述环境噪音位于中度噪音区且所述第一意图词和所述第二意图词属于低稳定性类别,则保留所述第二意图词;如果所述环境噪音位于高噪音区,则保留所述第二意图词,其中,所述高稳定类别的词语受环境噪音的影响程度小于所述低稳定性类别的词语受环境噪音的影响程度。

11.在上述语音识别方法的优选技术方案中,“根据判断结果,选择性地保留所述第一意图词或所述第二意图词”的步骤还包括:如果所述第一意图词和所述第二意图词的语义相似度达到要求,则保留所述第一意图词,或者,保留所述第二意图词,或者,随机地保留所述第一意图词或所述第二意图词中的一个。

12.另一方面,本发明还提供了一种语音识别系统,所述语音识别系统包括:声音获取装置,其配置成能够采集语音信息;图像获取装置,其配置成能够采集唇语信息;信息处理装置,其配置成能够分别根据所述声音获取装置采集的语音信息和所述图像获取装置采集的唇语信息生成第一语句和第二语句以及根据所述第一语句和所述第二语句生成最终语句。

13.在上述语音识别系统的优选技术方案中,所述信息处理装置包括:声音信息处理模块,其配置成能够根据所述语音信息生成所述第一语句;图像信息处理模块,其配置成能够根据所述唇语信息生成所述第二语句;语句分析处理模块,其配置成能够分别将所述第一语句和所述第二语句拆解以获得多个不同类别的第一意图词和多个不同类别的第二意图词,以及能够分别判断同一类别中的所述第一意图词和所述第二意图词的语义相似度是否达到要求,并根据判断结果,选择性地保留所述第一意图词或所述第二意图词,最后能够根据最终保留的所述第一意图词和所述第二意图词生成最终语句。

14.在上述语音识别系统的优选技术方案中,所述语句分析处理模块还其配置成:当所述第一意图词和所述第二意图词的语义相似度达到要求时,留所述第一意图词,或者,保留所述第二意图词,或者,随机地保留所述第一意图词或所述第二意图词中的一个;当所述第一意图词和所述第二意图词的语义相似度未达到要求时,根据所述声音获取装置采集的

环境噪音的大小,选择性地保留所述第一意图词或所述第二意图词。

15.在上述语音识别系统的优选技术方案中,所述语句分析处理模块还其配置成:在所述第一意图词和所述第二意图词的语义相似度未达到要求的情形下,当所述环境噪音位于低噪音区时,保留所述第一意图词;当所述环境噪音位于中度噪音区且所述第一意图词和所述第二意图词属于高稳定性类别时,保留所述第一意图词;当所述环境噪音位于中度噪音区且所述第一意图词和所述第二意图词属于低稳定性类别时,保留所述第二意图词;当所述环境噪音位于高噪音区时,保留所述第二意图词,其中,所述高稳定类别的词语受环境噪音的影响程度小于所述低稳定性类别的词语受环境噪音的影响程度。

16.在另一方面,本发明还提供了一种电器设备,所述电机设备包括上述的语音识别系统。

17.本领域技术人员能够理解的是,在本发明的优选技术方案中,通过同时获取语音信息和唇语信息,并分别根据获取的语音信息和唇语信息生成第一语句和第二语句,然后根据第一语句和第二语句生成最终语句,将该最终语句所表达的意思视为用户的真实意图。与公开号为cn111045639a的专利相比,该专利中在获取唇语识别结果后,只是用唇语识别结果来判断语音输入识别结构是否准确,然而,本发明是分别根据语音信息和唇语信息各生成一个语句,然后对这两个语句进行分析和比较,合成一个新的语句,即最终语句,将该最终语句所表达的意思视为用户的真实意图,即通过语音信息和唇语信息来共同判断用户的真实意图,通过语音信息与唇语信息之间相互印证和比较,能够显著提高判断的准确性,从而能够更准确地获取用户的真实意图,提升用户的使用体验。此外,与现有技术中仅通过语音信息来获取用户的真实意图以及公开号为cn108319912a的专利中仅通过唇语信息来获取用户的真实意图相比,本发明通过语音信息和唇语信息来共同判断用户的真实意图,能够显著提高判断的准确性。

18.进一步地,如果第一意图词和第二意图词的语义相似度未达到要求,则根据环境噪音的大小,选择性地保留第一意图词或第二意图词。通过这样的设置,即通过环境噪音的大小来选择性地保留第一意图词或者第二意图词,能够有效地排除环境噪音的干扰,进一步提高判断的准确性。

19.进一步地,“根据环境噪音的大小,选择性地保留第一意图词或第二意图词”的步骤具体包括:如果环境噪音位于低噪音区,则保留第一意图词;如果环境噪音位于中度噪音区且第一意图词和第二意图词属于高稳定性类别,则保留第一意图词;如果环境噪音位于中度噪音区且第一意图词和第二意图词属于低稳定性类别,则保留第二意图词;如果环境噪音位于高噪音区,则保留第二意图词,其中,高稳定类别的词语受环境噪音的影响程度小于低稳定性类别的词语受环境噪音的影响程度。通过这样的设置,即在环境噪音位于中度噪音区时,根据第一意图词和第二意图词的类别来进行选择,能够进一步提高判断的准确性。

附图说明

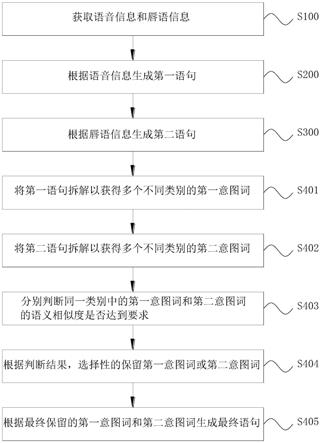

20.图1是本发明的语音识别方法的流程图;

21.图2是本发明的语音识别方法的实施例的流程图;

22.图3是本发明的语音识别系统的结构示意图。

具体实施方式

23.下面参照附图来描述本发明的优选实施方式。本领域技术人员应当理解的是,这些实施方式仅仅用于解释本发明的技术原理,并非旨在限制本发明的保护范围。例如,虽然下述实施方式是结合洗衣机来解释说明的,但是,这并不是限制性的,本发明的技术方案同样适用于其他电器设备,例如,冰箱和空调等家用电器以及商用电器等,这种应用对象的改变并不偏离本发明的原理和范围,均应限定在本发明的保护范围之内。

24.基于背景技术指出的现有的语音识别方法易发生无法准确获取用户的真实意图的问题。本发明提供了一种语音识别方法、语音识别装置和电器设备,旨在同时根据语音信息和唇语信息获取用户的真实意图。

25.本发明的洗衣机包括语音识别系统,洗衣机通过该语音识别系统能够准确地获取用户的真实意图。

26.首先参照图3,图3是本发明的语音识别系统的结构示意图。如图3所示,本发明的语音识别系统包括声音获取装置、图像获取装置以及信息处理装置,声音获取装置和图像获取装置均能够与信息处理装置进行通信。其中,声音获取装置是接收麦克风等可以接收声音信息的装置,图像获取装置是摄像头等可以采集图像信息的装置,信息处理装置是一种处理器。

27.当用户对洗衣机进行操控时,声音获取装置能够接收用户说的话,即采集语音信息,并将采集到的语音信息传输给信息处理装置,信息处理装置在接收到语音信息后,开始对语音信息进行分析处理,将语音信息转化成语句,可以记为第一语句;在声音获取装置采集语音信息的同时,图像获取装置能够采集用户的面部图像,即采集唇语信息,并将采集到的唇语信息传输给信息处理装置,信息处理装置在接收到唇语信息后,开始对唇语信息进行分析处理,将唇语信息也转化成语句,可以记为第二语句,最后,信息处理装置根据前面分析得到的第一语句和第二语句生成最终语句,该最终语句即为用户真实意思的表达。

28.本发明通过同时获取语音信息和唇语信息,并分别根据获取的语音信息和唇语信息生成第一语句和第二语句,然后根据第一语句和第二语句生成最终语句,将该最终语句所表达的意思视为用户的真实意图。

29.与公开号为cn111045639a的专利相比,该专利中在获取唇语识别结果后,只是用唇语识别结果来判断语音输入识别结构是否准确,然而,本发明是分别根据语音信息和唇语信息各生成一个语句,然后对这两个语句进行分析和比较,合成一个新的语句,即最终语句,将该最终语句所表达的意思视为用户的真实意图,即通过语音信息和唇语信息来共同判断用户的真实意图,通过语音信息与唇语信息之间相互印证和比较,能够显著提高判断的准确性,从而能够更准确地获取用户的真实意图,提升用户的使用体验。

30.此外,与现有技术中仅通过语音信息来获取用户的真实意图以及公开号为cn108319912a的专利中仅通过唇语信息来获取用户的真实意图相比,本发明通过语音信息和唇语信息来共同判断用户的真实意图,能够显著提高判断的准确性。

31.继续参阅图3,本发明的信息处理装置包括声音信息处理模块、图像信息处理模块以及语句分析处理模块。

32.信息处理装置在接收到语音信息后,声音信息处理模块开始对语音信息进行分析处理,从而生成第一语句,然后,通过语句分析处理模块对第一语句进行拆解,将第一语句

拆解成多个不同类别的词语,每个词语都能表示不同的意图,可以记为第一意图词。

33.类似地,信息处理装置在接收到唇语信息后,图像信息处理模块开始对唇语信息进行分析处理,从而生成第二语句,然后,通过语句分析处理模块对第二语句进行拆解,将第二语句也拆解成多个不同类别的词语,每个词语都能表示不同的意图,可以记为第二意图词。

34.语句分析处理模块分别将第一语句和第二语句拆解成多个不同类别的第一意图词和多个不同类别的第二意图词后,开始对同一类别中的第一意图词和第二意图词进行分析对比,判断第一意图词和第二意图词的语义相似度是否达到要求,然后根据判断结果,选择性地保留其中一个,最终每个类别中仅保留了一个词语,该词语可能是第一意图词,也可能是第二意图词,最后将保留下来的这些第一意图词和第二意图词组合成一个完整的语句,即为最终语句。

35.示例性地,第一语句被拆解成3个不同意图的词语,即,得到3个第一意图词,分别划归为第一类、第二类和第三类,同样地,第二语句也被拆解为3个不同意图的词语,即,得到3个第二意图词,也分别划归为第一类、第二类和第三类,每个类别中就包含了两个词语,一个是第一意图词,另一个是第二意图词,然后,将第一类中的两个词语进行分析比较,判断两个词语的语义相似度是否达到要求,最终只保留其中一个词语,该词语可能是第一意图词,也可能是第二意图词,同样地,也将第二类中的两个词语以及第三类中的两个词语进行分析比较,也都只保留其中一个词语,最终,每个类别中都只保留了一个词语,共得到三个词语,然后将这三个词语组合成一个完整的语句,即为最终语句。

36.语句分析处理模块在对同一类别中的第一意图词和第二意图词进行分析对比时,会出现以下两种情形:

37.第一种情形,第一意图词和第二意图词的语义相似度达到要求,说明第一意图词和第二意图词所要表达的意图是基本一致的,在这种情形,可以直接保留第一意图词,或者,也可以直接保留第二意图词,再或者,还可以随机地保留第一意图词或者第二意图词中的一个。

38.第二中情形,第一意图词和第二意图词的语义相似度未达到要求,说明第一意图词和第二意图词所要表达的意图相差较大,在这种情形,就不能随意地选择其中一个了,优选根据环境噪音的大小,来选择性地保留第一意图词或者第二意图词,具体方法如下:

39.当环境噪音位于低噪音区时,保留第一意图词;

40.当环境噪音位于中度噪音区且第一意图词和第二意图词属于高稳定性类别时,保留第一意图词;

41.当环境噪音位于中度噪音区且第一意图词和第二意图词属于低稳定性类别时,保留第二意图词;

42.当环境噪音位于高噪音区时,保留第二意图词,

43.其中,高稳定类别的词语受环境噪音的影响程度小于低稳定性类别的词语受环境噪音的影响程度。

44.即,当环境噪音位于低噪音区时,环境噪音对语音信息判断的影响较小,因此以第一意图词为准;反之,当环境噪音位于高噪音区时,环境噪音对语音信息判断影响较大,因此以第二意图词为准。

45.然而,当环境噪音位于中度噪音区时,需要考虑第一意图词和第二意图词的具体类别,发明人经过大量的试验研究发现,有些类别的词语受环境噪音的影响较小,将这些类别记为高稳定性类别,还有一些类别的词语受环境噪音的影响较大,将这些类别记为低稳定性类别,因此,当环境噪音位于中度噪音区且第一意图词和第二意图词属于高稳定类别时,保留第一意图词,反之,当环境噪音位于中度噪音区且第一意图词和第二意图词属于低稳定类别时,保留第二意图词。

46.需要说明的是,环境噪音也可以通过声音获取装置进行采集。

47.在另一方面,本发明还提供了一种语音识别方法,如图1所示,本发明的语音识别方法包括以下步骤:

48.s100:获取语音信息和唇语信息;

49.s200:根据语音信息生成第一语句;

50.s300:根据唇语信息生成第二语句;

51.s400:根据第一语句和第二语句生成最终语句。

52.本发明通过同时获取语音信息和唇语信息,并分别根据获取的语音信息和唇语信息生成第一语句和第二语句,然后根据第一语句和第二语句生成最终语句,将该最终语句所表达的意思视为用户的真实意图,相比于现有技术中仅根据语音信息来判断用户的真实意图。

53.与公开号为cn111045639a的专利相比,该专利中在获取唇语识别结果后,只是用唇语识别结果来判断语音输入识别结构是否准确,然而,本发明是分别根据语音信息和唇语信息各生成一个语句,然后对这两个语句进行分析和比较,合成一个新的语句,即最终语句,将该最终语句所表达的意思视为用户的真实意图,即通过语音信息和唇语信息来共同判断用户的真实意图,通过语音信息与唇语信息之间相互印证和比较,能够显著提高判断的准确性,从而能够更准确地获取用户的真实意图,提升用户的使用体验。

54.此外,与现有技术中仅通过语音信息来获取用户的真实意图以及公开号为cn108319912a的专利中仅通过唇语信息来获取用户的真实意图相比,本发明通过语音信息和唇语信息来共同判断用户的真实意图,能够显著提高判断的准确性。

55.需要说明的是,步骤s200和步骤s300可以同步执行,也可以按照任意顺序先后执行,这种灵活地调整和改变并不偏离本发明的原理和范围,均应限定在本发明的保护范围之内。

56.优选地,如图2所示,步骤s400(根据第一语句和第二语句生成最终语句)具体包括以下步骤:

57.s401:将第一语句拆解以获得多个不同类别的第一意图词;

58.s402:将第二语句拆解以获得多个不同类别的第二意图词;

59.s403:分别判断同一类别中的第一意图词和第二意图词的语义相似度是否达到要求;

60.s404:根据判断结果,选择性地保留第一意图词或第二意图词;

61.s405:根据最终保留的第一意图词和第二意图词生成最终语句。

62.将第一语句拆解成多个不同类别的词语,每个词语都能表示不同的意图,可以记为第一意图词;将第二语句也拆解成多个不同类别的词语,每个词语都能表示不同的意图,

可以记为第二意图词;然后,对同一类别中的第一意图词和第二意图词进行分析对比,判断第一意图词和第二意图词的语义相似度是否达到要求,然后根据判断结果,选择性地保留其中一个,最终每个类别中仅保留了一个词语,该词语可能是第一意图词,也可能是第二意图词,最后将保留下来的这些第一意图词和第二意图词组合成一个完整的语句,即为最终语句。

63.示例性地,第一语句被拆解成3个不同意图的词语,即,得到3个第一意图词,分别划归为第一类、第二类和第三类,同样地,第二语句也被拆解为3个不同意图的词语,即,得到3个第二意图词,也分别划归为第一类、第二类和第三类,每个类别中就包含了两个词语,一个是第一意图词,另一个是第二意图词,然后,将第一类中的两个词语进行分析比较,判断两个词语的语义相似度是否达到要求,最终只保留其中一个词语,该词语可能是第一意图词,也可能是第二意图词,同样地,也将第二类中的两个词语以及第三类中的两个词语进行分析比较,也都只保留其中一个词语,最终,每个类别中都只保留了一个词语,共得到三个词语,然后将这三个词语组合成一个完整的语句,即为最终语句。

64.需要说明的是,步骤s401和步骤s402可以同步执行,也可以按照任意顺序先后执行,这种灵活地调整和改变并不偏离本发明的原理和范围,均应限定在本发明的保护范围之内。

65.优选地,步骤s404(根据判断结果,选择性地保留第一意图词或第二意图词)的步骤具体包括:

66.如果第一意图词和第二意图词的语义相似度达到要求,则保留第一意图词,或者,保留第二意图词,或者,随机地保留第一意图词或第二意图词中的一个;

67.如果第一意图词和第二意图词的语义相似度未达到要求,则根据环境噪音的大小,选择性地保留第一意图词或第二意图词。

68.即,在对同一类别中的第一意图词和第二意图词进行分析对比时,会出现以下两种情形:

69.第一种情形,第一意图词和第二意图词的语义相似度达到要求,说明第一意图词和第二意图词所要表达的意图是基本一致的,在这种情形,可以直接保留第一意图词,或者,也可以直接保留第二意图词,再或者,还可以随机地保留第一意图词或者第二意图词中的一个。

70.第二中情形,第一意图词和第二意图词的语义相似度未达到要求,说明第一意图词和第二意图词所要表达的意图相差较大,在这种情形,就不能随意地选择其中一个了,优选根据环境噪音的大小,来选择性地保留第一意图词或者第二意图词。

71.优选地,“根据环境噪音的大小,选择性地保留第一意图词或第二意图词”的步骤具体包括:

72.如果环境噪音位于低噪音区,则保留第一意图词;

73.如果环境噪音位于中度噪音区且第一意图词和所述第二意图词属于高稳定性类别,则保留第一意图词;

74.如果环境噪音位于中度噪音区且第一意图词和第二意图词属于低稳定性类别,则保留第二意图词;

75.如果环境噪音位于高噪音区,则保留第二意图词,

76.其中,高稳定类别的词语受环境噪音的影响程度小于低稳定性类别的词语受环境噪音的影响程度。

77.即,当环境噪音位于低噪音区时,对语音信息判断的影响较小,因此以第一意图词为准;反之,当环境噪音位于高噪音区时,对语音信息判断影响较大,因此以第二意图词为准。

78.然而,当环境噪音位于中度噪音区时,需要考虑第一意图词和第二意图词的具体类别,发明人经过大量的试验研究发现,有些类别的词语受环境噪音的影响较小,将这些类别记为高稳定性类别,还有一些类别的词语受环境噪音的影响较大,将这些类别记为低稳定性类别,因此,当环境噪音位于中度噪音区且第一意图词和第二意图词属于高稳定类别时,保留第一意图词,反之,当环境噪音位于中度噪音区且第一意图词和第二意图词属于低稳定类别时,保留第二意图词。

79.下面结合一个具体的实施例来详细地介绍本发明的技术方案。

80.针对洗衣机,我们会将意图分成主功能意图和辅助功能意图两大类。其中,主要功能意图可以包括程序类型意图、衣物类型意图等,辅助功能意图主要涉及各个洗涤参数,例如洗涤时间、漂洗次数等。

81.需要说明的是,主功能意图的词语均属于高稳定性类别,辅助功能意图的词语均属于低稳定性类别。

82.用户在对洗衣机进行操控时,根据获取到的语音信息生成的第一语句是“洗涤羊毛衫,时间30分钟,漂洗2次”,根据获取到的唇语信息生成的第二语句是“洗羽绒服,洗涤时间40分钟,漂洗3次”。

83.然后,分别对第一语句和第二语句进行拆解,从而得到多个不同类别的第一意图词和多个不同类别的第二意图词,为了更清楚的表示,采用表格方式进行对比,表格如下:意图类别第一意图词第二意图词程序类型洗涤洗衣物类型羊毛衫羽绒服洗涤时间30分钟40分钟漂洗次数2次2次

84.经过分析比较可知:

85.针对程序类型,“洗涤”和“洗”的意思相近,即第一意图词和第二意图词的语义相似度达到要求,在这种情形下,可以保留第一意图词,也可以保留第二意图词,以保留第一意图词为例,即,程序类型为“洗涤”;

86.针对衣物类型,“羊毛衫”和“羽绒服”的意思明显不同,即第一意图词和第二意图词的语义相似度未达到要求,在这种情形下,需要根据环境噪音的大小,来选择性地保留第一意图词或第二意图词,具体如下:

87.当环境噪音属于低噪音区(例如,小于70分贝为低噪音区)时,保留第一意图词,即,衣物类型为“羊毛衫”;

88.当环境噪音属于中度噪音区(例如,70-90分贝为中度噪音区)时,因为衣物类型属于高稳定性类别,因此保留第一意图词,即,衣物类型为“羊毛衫”;

89.当环境噪音属于高噪音区(例如,大于90分贝为高噪音区)时,则保留第二意图词,

即衣物类型为“羽绒服”;

90.针对洗涤时间,“30分钟”和“40分钟”的意思明显不同,即第一意图词和第二意图词的语义相似度未达到要求,在这种情形下,需要根据环境噪音的大小,来选择性地保留第一意图词或第二意图词,具体如下:

91.当环境噪音属于低噪音区时,保留第一意图词,即,洗涤时间为“30分钟”;

92.当环境噪音属于中度噪音区时,因为洗涤时间属于低稳定性类别,因此保留第二意图词,即,洗涤时间为“40分钟”;

93.当环境噪音属于高噪音区时,则保留第二意图词,即洗涤时间为“40分钟”;

94.针对漂洗次数,“2次”和“2次”的意思相同,即第一意图词和第二意图词的语义相似度达到要求,在这种情形下,可以保留第一意图词,也可以保留第二意图词,以保留第一意图词为例,即,漂洗次数为“2次”;

95.假设环境噪音为80分贝,属于中度噪音区,最终获得的语句是“洗涤羊毛衫,洗涤时间40分钟,漂洗2次”。

96.最后,需要说明的是,可以通过隐马尔可夫(hmm)、时间延迟神经网络(tdnn)或卷积神经网络(cnn)等通用算法模型对语音信息进行分析并转化成语句。

97.此外,还需要说明的是,唇语识别是指通过观察说话者的口型变化,识别出其所要说的内容。在噪音环境下,我们可以通过观察说话者嘴部运动的特征来“猜测”其所说的内容,从而弥补听觉信号的不足,视觉信号对噪音敏感的音素可以提供更多可以区分的信息,例如,在语音信号通道难以区分的部分发音,在视觉上是容易区分的。

98.实现一个完整的唇语识别系统,需要完成从说话人视频信息采集,经历唇检测、特征提取、识别等多个复杂的工作环节,根据实现功能的不同,可以把唇语识别系统划分为以下三个主要环节:

99.第一步,唇的检测,就是从给定的图像或视频中找到唇的大致位置,这是进行唇语识别的前提条件,主要可以通过以下几种方法来确定唇的大致范围:方法一,根据人脸的生理结构确定,由于眼睛瞳孔与周围面部相比较灰度较低,相对容易定位,因此通常先定位瞳孔,然后根据人眼的位置以及眼睛和嘴的位置关系确定出唇的大致位置;方法二,根据唇的灰度信息或者颜色信息确定唇的位置;方法三,根据运动信息监测唇。

100.第二步,唇动定位与特征提取,在唇语识别系统中能够自动实时地定位和跟踪唇动,提取唇动特征是进一步识别的先决条件,定位与特征提取的质量直接影响到唇语识别的结果,可以通过可变模板和snake方法、主成分分析或者光流分析法等方法来实现。

101.第三,唇语识别,对提取的特征量进行唇语识别,唇语识别和语音识别同属于动态序列特征识别的范畴,也可以通过隐马尔可夫(hmm)、时间延迟神经网络(tdnn)或卷积神经网络(cnn)等通用算法模型对唇语信息进行分析并转化成语句。

102.此外,还需要说明的是,可以采用循环神经网络或者lstm(long short term mermory network)神经网络模型等语句进行分析处理。

103.至此,已经结合附图所示的优选实施方式描述了本发明的技术方案,但是,本领域技术人员容易理解的是,本发明的保护范围显然不局限于这些具体实施方式。在不偏离本发明的原理的前提下,本领域技术人员可以对相关技术特征作出等同的更改或替换,这些更改或替换之后的技术方案都将落入本发明的保护范围之内。