1.本技术涉及计算机技术领域,具体涉及一种用户意图识别方法、用户意图识别装置和计算机可读存储介质。

背景技术:

2.音频自动应答系统能够对用户的语音进行识别和语义分析,获取用户意图,而相关技术中的视频自动应答系统(interactive voice and video response,ivvr)也仅是在音频自动应答系统的基础上增加了视频交互来应答用户的诉求的方式,在用户侧收集的视频数据闲置,并没有将收集到的视频数据参与到用户数据分析和应答逻辑上去,并没有实质性地对音频自动应答系统进行提升,用户的交互体验也没有得到改善,如何利用视频资源和计算机技术为视频自动应答系统赋予优于音频自动应答系统的业务价值和用户体验亟需解决的问题。

技术实现要素:

3.本技术提供一种用户意图识别方法、用户意图识别装置和计算机可读存储介质,能够多维度地准确识别出用户意图,提升意图识别的准确性。

4.为解决上述技术问题,本技术采用的技术方案是:提供一种用户意图识别方法,该用户意图识别方法包括:对获取到的音视频数据进行处理,生成识别结果,识别结果包括多个子识别结果;从多个子识别结果中确定出第一子识别结果与第二子识别结果;利用第二子识别结果对第一子识别结果进行修正,生成修正识别结果;基于修正识别结果,获取用户意图信息。

5.为解决上述技术问题,本技术采用的另一技术方案是:提供一种用户意图识别装置,该用户意图识别装置包括互相连接的存储器和处理器,其中,存储器用于存储计算机程序,计算机程序在被处理器执行时,用于实现上述技术方案中的用户意图识别方法。

6.为解决上述技术问题,本技术采用的另一技术方案是:提供一种计算机可读存储介质,该计算机可读存储介质用于存储计算机程序,计算机程序在被处理器执行时,用于实现上述技术方案中的用户意图识别方法。

7.通过上述方案,本技术的有益效果是:先获取音视频数据,然后对该音视频数据进行识别处理,生成包括多个子识别结果的识别结果;然后从多个子识别结果中确定出第一子识别结果与第二子识别结果,第一子识别结果为需要修正的子识别结果,第二子识别结果为用来对第一子识别结果进行修正的子识别结果;再利用第二子识别结果对第一子识别结果进行修正,生成修正识别结果;然后利用修正识别结果便可获知用户的意图;由于利用视频数据以及音频数据对用户意图进行多方面地识别且在识别后进行修正,实现基于修正识别结果获取更精准的用户意图信息,能够提升意图识别的准确性,以便向用户提供更加符合自身需求的服务。

附图说明

8.为了更清楚地说明本技术实施例中的技术方案,下面将对实施例描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本技术的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。其中:

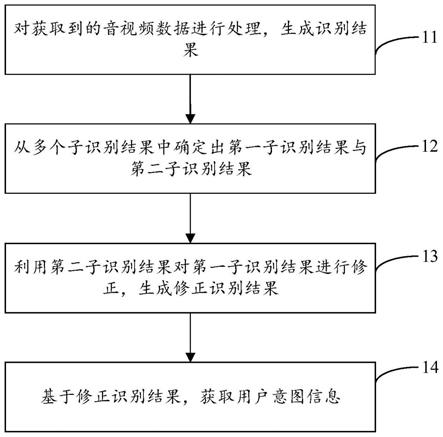

9.图1是本技术提供的用户意图识别方法一实施例的流程示意图;

10.图2是本技术提供的用户意图识别方法另一实施例的流程示意图;

11.图3是本技术提供的修正方法一实施例的流程示意图;

12.图4是本技术提供的修正方法另一实施例的流程示意图;

13.图5是本技术提供的用户意图识别装置一实施例的结构示意图;

14.图6是本技术提供的计算机可读存储介质一实施例的结构示意图。

具体实施方式

15.下面结合附图和实施例,对本技术作进一步的详细描述。特别指出的是,以下实施例仅用于说明本技术,但不对本技术的范围进行限定。同样的,以下实施例仅为本技术的部分实施例而非全部实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其它实施例,都属于本技术保护的范围。

16.在本技术中提及“实施例”意味着,结合实施例描述的特定特征、结构或特性可以包含在本技术的至少一个实施例中。在说明书中的各个位置出现该短语并不一定均是指相同的实施例,也不是与其它实施例互斥的独立的或备选的实施例。本领域技术人员显式地和隐式地理解的是,本文所描述的实施例可以与其它实施例相结合。

17.需要说明的是,本技术中的术语“第一”、“第二”、“第三”仅用于描述目的,而不能理解为指示或暗示相对重要性或者隐含指明所指示的技术特征的数量。由此,限定有“第一”、“第二”、“第三”的特征可以明示或者隐含地包括至少一个该特征。本技术的描述中,“多个”的含义是至少两个,例如两个,三个等,除非另有明确具体的限定。此外,术语“包括”和“具有”以及它们任何变形,意图在于覆盖不排他的包含。例如包含了一系列步骤或单元的过程、方法、系统、产品或设备没有限定于已列出的步骤或单元,而是可选地还包括没有列出的步骤或单元,或可选地还包括对于这些过程、方法、产品或设备固有的其它步骤或单元。

18.请参阅图1,图1是本技术提供的用户意图识别方法一实施例的流程示意图,该方法包括:

19.步骤11:对获取到的音视频数据进行处理,生成识别结果。

20.音视频数据可包括视频数据与音频数据,可利用摄像头对当前监控场景中的目标进行拍摄,得到视频数据,例如,用户的人脸或动作图像等;利用音频采集设备进行声音采集,得到音频数据,例如,用户的交互语音;然后对获取到视频数据以及音频数据进行处理,生成识别结果。

21.进一步地,识别结果包括多个子识别结果,多个子识别结果可包括视频识别结果以及音频识别结果;可对视频数据进行识别处理,得到视频识别结果,例如:对采集到的用户的动作信息进行识别,得到对应的动作识别结果,此时动作识别结果便为一个子识别结

果;对音频数据进行识别处理,得到音频识别结果,例如:对采集到的用户的语音信息进行识别,得到对应的语音识别结果,此时语音识别结果也为一个子识别结果。可以理解地,上述仅以动作信息为例进行说明,在其他实施例中,还可根据视频数据对用户的面部信息或者手势信息等进行识别。

22.步骤12:从多个子识别结果中确定出第一子识别结果与第二子识别结果。

23.可按照预设规则确定第一子识别结果以及相应的第二子识别结果,预设规则可与用户选择的交互模式有关,交互模式可由用户自主选择,预设规则可根据实际情况进行设置;例如:假设用户选择语音交互模式,则此时便可选择识别出的语音识别结果为第一子识别结果,用除了语音识别结果外的其他子识别结果作为第二子识别结果,比如:将动作识别结果作为第二子识别结果,从而利用语音识别结果以及动作识别结果分析出用户意图,以使得分析出的用户意图更加准确。

24.在一具体的实施例中,用户可通过输入交互选择指令来选择所需的交互模式,从而在选择的交互模式下通过相应的方式来表达需求;具体地,交互选择指令可包括语音交互指令以及动作交互指令,交互模式相应地可包括语音交互模式以及动作交互模式,可通过播放引导音频/引导视频来引导用户输入交互选择指令从而选择交互模式,然后在用户选择出相应的交互模式后,引导用户根据规范输入相应的语音或者执行相应的动作,其中,语音交互模式为用户通过输入语音来进行交互的模式,动作交互模式为用户通过执行手势/动作来进行交互的模式;可以理解地,用户在选择交互模式时也可根据引导音频/引导视频的内容以语音/手势/动作等多种交互方式来进行选择,从而能够全方位地增加与用户的交互维度,同时也为语言障碍人士提供了全面地服务通道。

25.进一步地,在用户选择语音交互模式时,可引导用户根据引导词格式来输入相应语音,例如:搜索地点的引导词可为“我要去xx”,用户可依照该引导词格式说出自己的需求,比如:用户可说“我要去停车场”来查找附近停车场的位置信息;在用户选择动作交互模式时,可引导用户在肢体动作方面的规范,引导用户做出相应的手势、动作或者通过手语等来表达需求。本实施例主要以语音交互模式以及动作交互模式进行说明,交互模式并不仅限制在上述两种交互模式,例如:还可包含同时通过输入语音以及执行手势/动作来实现交互的混合交互模式,具体可根据实际情况进行设置。

26.步骤13:利用第二子识别结果对第一子识别结果进行修正,生成修正识别结果。

27.利用第二子识别结果对第一子识别结果进行修正,可生成较为准确的修正识别结果,能够提升识别结果的准确性;例如,选择第一子识别结果为语音识别结果,第二子识别结果为动作识别结果,此时可利用动作识别结果对语音识别结果进行修正,在语音识别结果不准确时,可通过动作识别结果的修正得到更为准确的修正识别结果。

28.可以理解地,在其他具体的实施例中,还可选择两个或两个以上的第二子识别结果来对第一子结果进行修正,例如:采用口型识别结果与手势识别结果等对语音识别结果进行修正。

29.步骤14:基于修正识别结果,获取用户意图信息。

30.从获取到的修正识别结果中获取用户意图信息,例如:基于语音识别结果以及动作识别结果得到的修正识别结果为“我要去停车场”,实现基于该修正识别结果获取到用户的意图信息,得知用户是想要获得附近停车场的位置信息。

31.在本实施例中,先获取音视频数据,然后对音视频数据进行识别处理,生成包含音频识别结果以及视频识别结果的多个子识别结果;然后从多个子识别结果中确定出第一子识别结果以及第二子识别结果,第一子识别结果为需要修正的子识别结果,第二子识别结果为用来对第一子识别结果进行修正的子识别结果;再利用第二子识别结果对第一子识别结果进行修正,生成修正识别结果;然后利用修正识别结果便可获知用户的意图;由于利用视频数据以及音频数据进行多方面地识别且在识别后进行修正,实现基于修正识别结果获取更精确的用户意图信息,能够提升意图识别的准确性,以便向用户提供更加符合自身需求的服务。

32.请参阅图2,图2是本技术提供的用户意图识别方法另一实施例的流程示意图,该方法包括:

33.步骤21:对获取到的音视频数据进行处理,生成识别结果。

34.音视频数据可包含视频数据与音频数据,识别结果包括多个子识别结果,具体地,多个子识别结果包括口型识别结果、语音识别结果或动作识别结果,可对语音数据中的语音信息进行识别处理,得到语音识别结果,可对视频数据中的动作信息进行识别处理,得到动作识别结果;和/或,对口型信息进行识别处理,得到口型识别结果。

35.步骤22:判断是否接收到交互选择指令。

36.在识别出多个子识别结果后,需要从多个子识别结果中确定出第一子识别结果与第二子识别结果,然后利用第二子识别结果对第一子识别结果进行修正,以生成修正识别结果;具体地,可先判断是否接收到用户输入的交互选择指令,从而依据交互选择指令来选择相应的第一子识别结果与第二子识别结果。

37.在一具体的实施例中,对接收到的交互选择指令进行解析,生成选择信息;基于选择信息,确定第一子识别结果,第一子识别结果为与交互选择指令对应的子识别结果;按照预设规则确定第二子识别结果,第二子识别结果为多个子识别结果中除第一子识别结果以外的子识别结果;例如,在接收到用户输入的语音交互指令时,对语音交互指令进行解析,生成对应的选择信息,判断用户选择了语音交互模式,则此时依据语音交互模式的选择结果,将第一子识别结果确定为语音识别结果,第二子识别结果便为除了语音识别结果以外的其他子识别结果,此时可根据预设规则来确定出第二子识别结果,然后利用第二子识别结果对第一子识别结果进行修正,生成修正识别结果;进一步地,预设规则以及修正方式与用户选择的交互模式有关,下述步骤23~步骤24为动作交互模式/语音交互模式/无交互模式下所采用的修正方法。

38.进一步地,若接收到交互选择指令,则第一子识别结果为动作识别结果/语音识别结果,第二子识别结果为口型识别结果;或者第一子识别结果为语音识别结果,第二子识别结果为动作识别结果;或者第一子识别结果为动作识别结果,第二子识别结果为语音识别结果。具体地,可通过对交互选择指令进行分析,来确定第一子识别结果与第二子识别结果的具体信息;例如,可在用户交互界面上设置四个操作按键:第一识别按键、第二识别按键、第三识别按键以及第四识别按键,语音交互模式与第一识别按键以及第二识别按键相关,当第一识别按键被触发时,表明用户想要通过“语音为主+口型为辅”的方式来实现意图识别,此时第一子识别结果为语音识别结果,第二子识别结果为口型识别结果;当第二识别按键被触发时,表明用户想要通过“语音为主+动作为辅”的方式来实现意图识别,此时第一子

识别结果为语音识别结果,第二子识别结果为动作识别结果;动作交互模式与第三识别按键以及第四识别按键相关,当第三识别按键被触发时,表明用户想要通过“动作为主+口型为辅”的方式来实现意图识别,此时第一子识别结果为动作识别结果,第二子识别结果为口型识别结果;当第四识别按键被触发时,表明用户想要通过“动作为主+语音为辅”的方式来实现意图识别,此时第一子识别结果为动作识别结果,第二子识别结果为语音识别结果。

39.步骤23:在接收到交互选择指令时,基于口型识别结果,对动作识别结果/语音识别结果进行修正,得到修正识别结果。

40.在用户选择动作交互模式/语音交互模式时,第一子识别结果为动作识别结果/语音识别结果,第二子识别结果为口型识别结果,此时基于口型识别结果对动作识别结果/语音识别结果进行修正,如图3所示,其具体步骤如下述步骤231a~步骤234a所示:

41.步骤231a:将口型识别结果与预设知识库进行匹配,得到匹配度。

42.口型识别结果可为有序的词集合,通过对视频数据中的面部口型的识别,能够识别出人物或地点等词语,例如:用户说“我要去篮球馆”,则此时可根据口型数据识别出相应的关键词“篮球馆”;语音识别结果以及动作识别结果都为句结果,即其能识别出完整的语句,例如:“我要去篮球馆”。

43.进一步地,将口型识别结果与预设知识库进行匹配,预设知识库可为包含社会热点词汇、人名或专业术语等的知识库,可将口型识别结果的词语与预设知识库中的词语进行相似度匹配,根据相关技术中的匹配算法得到口型识别结果的词语对应的匹配度,例如,口型识别结果为“钟国”,则可在预设知识库中匹配到人名“金钟国”,计算得到二者的余弦相似度以作为匹配度。

44.步骤232a:用口型识别结果替换语音识别结果/动作识别结果中的相应词语,得到新的识别结果,并计算新的识别结果的拟合度。

45.可根据口型识别结果中的词语的语法属性将口型识别结果的词语替换到语音识别结果/动作识别结果的完整语句中对应的词语位置中,例如,口型识别结果为“可乐”,其为名词,而语音识别结果/动作识别结果出的语句为“我要喝奶茶”,故此时可相应地将“可乐”替换语句中的名字“奶茶”位置,得到新的识别结果“我要喝可乐”,然后可采用相关技术中的拟合度算法来对新的识别结果进行拟合度计算。可以理解地,本实施例仅以根据词语的语法属性进行替换为例进行说明,在其他实施例中,还可综合分析口型识别结果中词语的顺序或者语义等属性来执行替换操作。

46.步骤233a:判断匹配度与拟合度的乘积是否大于预设阈值。

47.在获取到口型识别结果的匹配度以及新的识别结果的拟合度后,将匹配度和拟合度相乘,然后将其与预设阈值进行比较,具体地,预设阈值为预先设置的值,其可为根据经验设置的值或者通过深度学习模型调试出的最优值,可通过将匹配度和拟合度的乘积与进行比较,判断新的识别结果是否准确。

48.步骤234a:若匹配度与拟合度的乘积大于预设阈值,则将新的识别结果作为修正识别结果。

49.以预设阈值设置为0.7为例,在匹配度和拟合度的乘积大于0.7时,则说明采用口型识别结果进行修正得到的新的识别结果较为准确,则此时可将其作为修正识别结果。在匹配度和拟合度的乘积小于或等于0.7时,则说明新的识别结果不准确,此时不对原有的语

音识别结果/动作识别结果进行修正,仍以语音识别结果/动作识别结果为最终的识别结果。

50.在其他具体的实施例中,修正方法还可为:在第一子识别结果为语音识别结果且第二子识别结果为动作识别结果时,基于动作识别结果,对语音识别结果进行修正;或者在第一子识别结果为动作识别结果且第二子识别结果为语音识别结果时,基于语音识别结果,对动作识别结果进行修正,此时可直接将语音识别结果与动作识别结果两者进行比较,选择较准确的一方作为修正识别结果,具体如图4中的步骤231b~步骤234b所示:

51.步骤231b:分别对动作识别结果与语音识别结果进行评分,得到第一评分值与第二评分值。

52.可利用评分模型对动作识别结果/语音识别结果进行评分,将动作识别结果/语音识别结果的完整语句输入至评分模型中,从而得到动作识别结果对应的第一评分值以及语音识别结果对应的第二评分值。具体地,评分模型可对完整语句中的地点、人物、行为或交易等分别进行加权运算,得到各自的评分值,然后将每个评分值相加,从而得到该语句的最终评分值。

53.步骤232b:判断第一评分值是否大于第二评分值。

54.比较第一评分值与第二评分值的大小,来判断动作识别结果与语音识别结果两者之间哪个更加准确。

55.步骤233b:若第一评分值大于第二评分值,则修正识别结果为动作识别结果。

56.在第一评分值大于第二评分值时,说明第一评分值对应的动作识别结果比第二评分值对应的语音识别结果更加准确,则此时将修正识别结果确定为动作识别结果。例如,语音识别结果为“我要去荷兰”,动作识别结果为“我要去河南”,且动作识别结果的评分值较高,则此时可将动作识别结果作为修正识别结果输出为“我要去河南”。

57.步骤234b:若第一评分值小于或等于第二评分值,则修正识别结果为语音识别结果。

58.在第一评分值小于或等于第二评分值时,说明第二评分值对应的语音识别结果比第一评分值对应的动作识别结果更加准确,则此时将修正识别结果确定为语音识别结果。例如,动作识别结果为“我要去河南”,语音识别结果为“我要去荷兰”,且语音识别结果评分值较高,则此时可将语音识别结果作为修正识别结果输出为“我要去荷兰”。

59.步骤24:若没有接收到交互选择指令,则基于口型识别结果与语音识别结果,对动作识别结果进行修正,得到修正识别结果。

60.在判断出没有接收到交互选择指令,即用户没有选择交互模式,由于动作识别结果是基于用户的动作/手势/手语来识别出来的,其准确度一般比语音识别结果/口型识别结果高,此时第一子识别结果为动作识别结果,第二子识别结果为口型识别结果与语音识别结果,利用口型识别结果以及语音识别结果对动作识别结果进行修正,以得到修正识别结果;可以理解地,在其他实施例中,也可基于口型识别结果与动作识别结果对语音识别结果进行修正,在此不作限定。

61.具体地,利用语音识别结果对动作识别结果进行修正,得到中间修正结果,其中,利用语音识别结果对动作识别结果进行修正的方法与上述基于语音识别结果对动作识别结果进行修正的方法相同,在此不再赘述,中间修正结果便为动作识别结果以及语音识别

结果之间评分值较高的一方;然后利用口型识别结果对中间修正结果进行修正,得到修正识别结果,其中,利用口型识别结果对中间修正结果(即语音识别结果/动作识别结果)进行修正的方法与上述基于口型识别结果对动作识别结果/语音识别结果进行修正的方法相同,在此不再赘述。

62.根据上述修正方法得到的修正识别结果均为一个完整的语句,可知其仅包含语句结构所表达的字面意思,并不涉及语义表达,则此时可再根据获取到的视频数据对用户的情绪进行识别,然后对情绪识别结果以及修正识别结果进行语义分析,从而最终分析得到用户意图,由于在不结合语义表达仅根据语句结构来分析用户的意图可能会有偏差,无法得到用户的真实意图,通过情绪参与语义分析的方法能够使得用户意图分析的准确性更高。

63.步骤25:对视频数据进行情绪识别处理,得到情绪识别结果。

64.根据获取到的视频数据进行情绪识别处理,得到情绪识别结果。具体地,可根据用户的面部/语调进行情绪识别,识别出用户的如愤怒、平静或喜悦等情绪。

65.步骤26:将修正识别结果与情绪识别结果输入语义分析引擎,得到用户意图信息。

66.在获取到情绪识别结果后,再将修正识别结果与情绪识别结果一同输入至语义分析引擎中,从而分析得到用户意图信息,例如,修正识别结果为“我要喝饮料”,该语句结构单纯表达为用户想要喝饮料,即查询饮品相关信息,但是对用户情绪进行识别后发现用户处于愤怒的情绪中,则说明此时用户的真实意图也许并非要查询饮品相关信息,通过将修正识别结果与情绪识别结果一起利用语义分析引擎对用户意图信息进行分析,最终分析得到用户其实是想要投诉,从而通过这种情绪识别结果的参与意图分析的方式来修正用户真实的意图与修正识别结果之间的偏差。具体地,语义分析引擎可将修正识别结果作为输入,增加情绪识别结果的向量并且为其配置权重,然后再将添加了情绪识别结果向量的修正识别结果与原有的词语模型进行相似度匹配,从而求取出用户意图信息。

67.步骤27:基于用户意图信息,对预设数据库进行查询得到查询数据;或者基于用户意图信息,生成应答信息,并播放和/或显示应答信息。

68.预设数据库可为包含生活、社会或影视等信息的数据库,在用户存在查询需求时,即用户意图信息为查询数据类型时,例如:查询酒店或餐厅等,可在预设数据库中对用户意图信息进行查询得到相应的查询数据;例如,在用户查询某部电影时,可在预设数据库中查询到对应的影片信息,同时将该电影通过显示界面播放给用户,在用户查询某首歌时,可在预设数据库中查询到对应的歌曲信息,并将该歌曲通过显示界面播放给用户,在用户查询酒店时,可在预设数据库中查询到对应的酒店信息,将附近的酒店信息通过显示界面显示给用户。

69.上述用户意图识别方法可应用于智能机器人、视频客服或者直播等场景中,在一具体的实施例中,用户除了查询数据的意图之外,还存在闲聊的需求,此时可基于该闲聊意图为用户提供闲聊服务,可通过内置知识库根据上下文语境或语义等选择适合的应答信息,例如,例如用户说“你好,今天天气很好”,则此时可生成相应的应答信息“你好,今天是个适合出行的好天气呢”,并将其播放和/或显示出来;可以理解地,在其他实施例中,还可在识别出用户处于负面情绪下时(例如:生气或伤心等),也可根据用户情绪生成相应的安抚性的应答信息,以安抚用户的情绪。

70.在本实施例中,在接收到交互选择指令时,基于口型识别结果对动作识别结果/语音识别结果进行修正;若没有接收到交互选择指令,则基于口型识别结果与语音识别结果对动作识别结果进行修正,从而得到修正识别结果;然后利用修正识别结果与用户的情绪识别结果,获取用户意图信息,从而对用户意图信息进行响应,以满足用户的需求。通过对音频数据以及视频数据进行多维度分析,极大程度上地提高了对用户视频资源的利用,突破了仅仅通过语言和声学的分析识别用户意图的准确度上限,增加了用户的交互维度,同时增加的动作交互方式也为语言障碍人士提供了服务通道,方便这些用户使用,且增加了用户意图分析在视觉维度上的参考源,同时还通过用户表情和语调产生的情绪内容来辅助用户意图识别,提高了意图分析的准确度,能够为用户提供更优质的服务。

71.请参阅图5,图5是本技术提供的用户意图识别装置一实施例的结构示意图,用户意图识别装置50包括互相连接的存储器51和处理器52,存储器51用于存储计算机程序,计算机程序在被处理器52执行时,用于实现上述实施例中的用户意图识别方法。

72.请参阅图6,图6是本技术提供的计算机可读存储介质一实施例的结构示意图,计算机可读存储介质60用于存储计算机程序61,计算机程序61在被处理器执行时,用于实现上述实施例中的用户意图识别方法。

73.计算机可读存储介质60可以是服务端、u盘、移动硬盘、只读存储器(rom,read-only memory)、随机存取存储器(ram,random access memory)、磁碟或者光盘等各种可以存储程序代码的介质。

74.在本技术所提供的几个实施方式中,应该理解到,所揭露的方法以及设备,可以通过其它的方式实现。例如,以上所描述的设备实施方式仅仅是示意性的,例如,模块或单元的划分,仅仅为一种逻辑功能划分,实际实现时可以有另外的划分方式,例如多个单元或组件可以结合或者可以集成到另一个系统,或一些特征可以忽略,或不执行。

75.作为分离部件说明的单元可以是或者也可以不是物理上分开的,作为单元显示的部件可以是或者也可以不是物理单元,即可以位于一个地方,或者也可以分布到多个网络单元上。可以根据实际的需要选择其中的部分或者全部单元来实现本实施方式方案的目的。

76.另外,在本技术各个实施方式中的各功能单元可以集成在一个处理单元中,也可以是各个单元单独物理存在,也可以两个或两个以上单元集成在一个单元中。上述集成的单元既可以采用硬件的形式实现,也可以采用软件功能单元的形式实现。

77.以上所述仅为本技术的实施例,并非因此限制本技术的专利范围,凡是利用本技术说明书及附图内容所作的等效结构或等效流程变换,或直接或间接运用在其他相关的技术领域,均同理包括在本技术的专利保护范围内。