1.本技术涉及人工智能领域,尤其涉及一种音频数据增强方法及相关设备。

背景技术:

2.人工智能(artificial intelligence,ai)是利用数字计算机或者数字计算机控制的机器模拟、延伸和扩展人的智能,感知环境、获取知识并使用知识获得最佳结果的理论、方法、技术及应用系统。换句话说,人工智能是计算机科学的一个分支,它企图了解智能的实质,并生产出一种新的能以人类智能相似的方式作出反应的智能机器。人工智能也就是研究各种智能机器的设计原理与实现方法,使机器具有感知、推理与决策的功能。

3.音频增强技术是指在复杂的声音环境下,从包含噪声的音频数据中,提取有用的语音信号,抑制并降低噪声干扰的技术。即从含噪语音中提取尽可能纯净的原始语音。

4.在现有的音频增强方案中,将大量用户的语音数据作为训练数据来训练一个普适性的语音增强模型,在推理过程中,通过上述普适性的语音增强模型,对音频数据进行音频增强。然而,由于不同人的发声习惯不同,不同人发出声音的音色、韵律特点都不相同,由于训练数据有限,并不能使得模型具备识别全部特点类型的人声的能力,因此音频增强的效果较差。

技术实现要素:

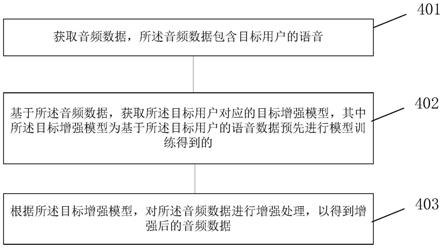

5.第一方面,本技术提供了一种音频数据增强方法,所述方法包括:获取音频数据,所述音频数据包含目标用户的语音;基于所述音频数据,获取所述目标用户对应的目标增强模型,其中所述目标增强模型为基于所述目标用户的语音数据预先进行模型训练得到的;根据所述目标增强模型,对所述音频数据进行增强处理,以得到增强后的音频数据。

6.其中,基于目标用户的语音数据单独训练了一个针对于目标用户的语音增强模型(也就是本实施例中的目标增强模型),在对包含目标用户的语音的音频数据进行音频增强时,该模型具备很高的音频增强性能,在网上会议等终端的即时语音场景中,由于终端的使用者有限,因此,可以针对于有限的用户分别训练得到适配于各个用户的语音增强模型(例如本技术实施例中的目标增强模型),各个语音增强模型针对于特定用户的语音的音频增强性能较好,进而解决了基于普适性的语音增强模型进行音频增强时存在的音频增强效果较差的问题。

7.在一种可能的实现中,所述音频数据包含目标用户的语音,包括:所述音频数据包含用户的语音,且所述用户仅包含所述目标用户;或者,所述音频数据包含用户的语音,所述用户包含所述目标用户和第一用户,且所述目标用户的语音在所述音频数据中的能量占比高于所述第一用户的语音在所述音频数据中的能量占比。

8.在一种场景中,音频数据中可以包含用户的语音,且所述用户仅包含所述目标用户,也就是在音频数据中仅包含一个正在发声的用户(目标用户)的语音,则可以确定音频数据包含目标用户的语音。

9.在一种场景中,音频数据中可以包括多个用户的语音,例如音频数据中可以包括用户a和用户b的语音,本实施例中可以确定多个用户的语音中能量占比最高的用户为目标用户,其中所谓能量占比可以理解为音量大小、声波复幅值大小等,该能量占比可以是实时确定的各个时刻的能量占比,或者是一段时间内的能量占比,例如,用户b只是咳嗽了一声,而用户a则是在进行正常的发声,则a用户的语音在音频数据中的能量占比大于b用户的语音在音频数据中的能量占比,进而可以确定用户a为目标用户。

10.通过上述方式,可以准确地识别出哪个用户需要进行音频增强,进而在准确的识别出目标用户的基础上,也可以准确获取到目标增强模型,提升了音频增强的效果。

11.在一种可能的实现中,所述获取音频数据,包括:获取视频数据,所述视频数据包括图像数据以及所述音频数据;其中,所述图像数据中的用户仅包括所述目标用户;或者,所述图像数据中的用户包含所述目标用户和第二用户,且所述目标用户在所述图像数据中的像素占比高于所述第二用户在所述图像数据中的像素占比。

12.在一种可能的实现中,终端设备在采集音频数据时,还可以同步采集音频数据所处的环境中的图像,例如在网上会议的场景中,终端设备可以采集到视频数据,该视频数据可以包括图像数据和音频数据,进而可以根据图像识别来确定音频数据包含哪些用户的语音,且,当用户在图像中的面积占比(也就是像素占比)越大,则可以表示该用户为主要发声者,或者是距离麦克风阵列最近的用户,对该用户进行音频增强的必要性最大,因此可以将在图像中像素占比最大的用户作为音频增强的对象,从多个增强模型中,获取该目标用户对应的目标增强模型。通过上述方式,可以准确地识别出哪个用户需要进行音频增强,进而在准确的识别出目标用户的基础上,也可以准确获取到目标增强模型,提升了音频增强的效果。

13.在一种可能的实现中,所述从多个增强模型中获取所述目标用户对应的目标增强模型之前,所述方法还包括:使能针对于所述目标用户的选择。

14.在一种可能的实现中,所述获取所述目标用户对应的目标增强模型之前,所述方法还包括:提供至少一个第一选项,其中每个第一选项用于指示一个用户;获取针对于第一目标选项的选择操作,所述第一目标选项为所述至少一个第一选项中的一个,所述第一目标选项用于指示所述目标用户。通过上述方式,可以使能针对于目标用户的选择,进而可以从多个训练好的模型中获取目标用户所对应的模型,应理解,每个训练后的模型可以对应于一个用户,例如可以基于一个指示用户身份的标识来标记对应的模型,在使能针对于目标用户的选择之后,可以从各个模型标记的标识中确定目标用户的标识,并获取标记有目标用户的标识的模型(也就是目标增强模型)。

15.在一种可能的实现中,所述提供至少一个第一选项,包括:基于所述音频数据包含至少一个用户的语音,提供所述至少一个用户中每个用户对应的第一选项;或者,获取视频数据,所述视频数据包括图像数据以及所述音频数据;基于所述图像数据包含至少一个用户,提供所述至少一个用户中每个用户对应的第一选项。

16.在一种可能的实现中,目标增强模型的音频增强性能除了和用户有关,还和环境场景的类型有关,环境场景例如可以包括居家场景、咖啡店场景等,在现有的音频增强方案中,将大量用户在各个环境场景中的语音数据作为训练数据来训练一个普适性的语音增强模型,在推理过程中,通过上述普适性的语音增强模型,对音频数据进行音频增强。训练后

的语音增强模型需要具备能够区分人声以及环境噪音的能力,然而,由于不同环境场景中背景噪声的特征不同,由于训练数据有限,并不能使得模型具备识别全部特点类型的背景噪声的能力,因此音频增强的效果较差。

17.本技术实施例中,在网上会议等终端的即时语音场景中,由于环境场景有限,因此,可以针对于有限的环境场景分别训练得到适配于各个环境场景的语音增强模型(例如本技术实施例中的目标增强模型),各个语音增强模型针对于特定环境场景的语音的音频增强性能较好,进而解决了基于普适性的语音增强模型进行音频增强时存在的音频增强效果较差的问题。

18.其中,上述所述噪声数据可以为目标环境中的噪声数据,所述目标环境为音频采集设备在采集所述音频数据时所处的环境。

19.在一种可能的实现中,所述方法还包括:获取环境信息,所述环境信息用于指示音频采集设备在采集所述音频数据时所处的目标场景;所述获取所述目标用户对应的目标增强模型,其中所述目标增强模型为基于所述语音数据预先进行模型训练得到的,包括:获取所述目标用户以及所述目标场景对应的目标增强模型,其中所述目标增强模型为基于所述目标用户在所述目标场景中的语音数据预先进行模型训练得到的。

20.在一种可能的实现中,所述获取环境信息,包括:获取位置信息,所述位置信息用于指示所述音频采集设备在采集所述音频数据时所处的位置,所述位置信息用于指示所述目标场景;或者,提供至少一个第二选项,其中每个第二选项用于指示一个目标场景;获取针对于第二目标选项的选择操作,所述第二目标选项为所述至少一个第二选项中的一个,所述第二目标选项用于指示所述目标场景。

21.在一种可能的实现中,还可以对音频数据进行分析,来确定采集音频数据时所处的目标场景,例如可以对音频数据进行人声和环境声的分离处理,并基于环境声确定采集音频数据时所处的目标场景,例如可以基于一个预训练的模型来进行上述目标场景的识别,或者是基于环境的音频信息特征分析来进行上述目标场景的识别。

22.在一种可能的实现中,所述目标增强模型包括第一增强模型分支和第二增强模型分支,所述第一增强模型分支针对于相同音频数据的处理时间低于所述第二增强模型分支,且所述第一增强模型分支的音频增强效果低于所述第二增强分支的音频增强效果,所述根据所述目标增强模型,对所述音频数据进行增强处理,包括:获取所述音频数据的应用场景;在所述应用场景为实时语音通话场景的情况下,通过所述第一增强模型分支,对所述音频数据进行增强处理;或者在所述应用场景为语音后期处理场景的情况下,通过所述第二增强模型分支,对所述音频数据进行增强处理。

23.其中,目标增强模型可以实现多个应用场景的功能,例如正在进行网上会议的时候,当应用场景为即时语音时,需要保证目标增强模型的时延低(也就是处理数据所需的时间少),因此目标增强模型可以支持在线流式处理的算法(本技术实施例中也可以称之为在线增强模式)。在网上会议结束后,在对录音进行离线处理时(例如进行会议分析时),需要保证目标增强模型的处理精度高(也就是音频增强效果好),而不需要保证低时延,且时延和音频增强效果在技术上是一对相互矛盾的实现,因此目标增强模型可以支持离线流式处理的算法(本技术实施例中也可以称之为离线增强模式),进而基于增强后的音频数据可以提供一个清晰准确的会议语音或文本记录。

24.由上可知,可以将目标增强模型的网络结构设计为同时容许在线增强模式和离线增强模式,可基于实际的应用场景选择适合的模式。其中在线增强模式可提供即时短时延的语音增强,离线增强模式则可提供增强效果较好但时延长的增强。

25.在一种可能的实现中,所述目标增强模型包括多个串行的网络层,所述多个串行的网络层包括第一网络层和第二网络层,所述第二网络层距离所述目标增强模型的输出网络层的距离小于所述第一网络层距离所述目标增强模型的输出网络层的距离,所述根据所述目标增强模型,对所述音频数据进行增强处理,以得到增强后的音频数据,包括:根据所述目标增强模型,对所述音频数据进行增强处理,并将所述第一网络层的输出作为所述增强后的音频数据,所述增强后的音频数据用于文本识别;或者,根据所述目标增强模型,对所述音频数据进行增强处理,并将所述第二网络层的输出作为所述增强后的音频数据,向目标终端传递所述增强后的音频数据,或者在本地保存所述增强后的音频数据。

26.也就是说,针对于即时语音的场景,可以将距离输出网络层较近的网络层的输出作为后续进行语音传输的数据,例如可以直接将输出网络层的输出作为后续进行语音传输的数据,针对于需要进行语音的文本识别的场景,可以将距离输出网络层较远的网络层的输出作为后续进行语音传输的数据。

27.通过上述方式,在终端侧的数据存储量有限的情况下,只需要训练一个模型,就可以适配于多种任务场景的实现,而不需要训练多个模型,每个模型来适配一种任务场景,降低了终端侧的数据存储量,且以渐进式学习的方式来提供多个增强程度输出,减低了目标语音频谱损伤对下游任务的性能影响。

28.在一种可能的实现中,所述音频数据增强方法应用于终端设备,和/或,所述目标增强模型为所述终端设备训练得到的。

29.在一种可能的实现中,可以基于m个用户(包括目标用户)的语音数据进行模型训练得到目标增强模型,以使得该目标增强模型针对于m个用户的语音可以具有较高的音频增强能力,为了保证模型的音频增强较高,m的数量可以设置的较小,m可以设置为小于3,例如m可以为1或者2。

30.在一种可能的实现中,所述m设置为1,也就是仅根据目标用户的语音数据来训练目标增强模型,可以最大化目标增强模型针对于目标用户的音频增强能力。

31.在一种可能的实现中,所述目标增强模型为基于所述语音数据预先进行模型训练得到的,包括:所述目标增强模型为基于目标损失预先进行模型训练得到的,所述目标损失与第一训练数据和第二训练数据之间的差异有关,所述第一训练数据为包含所述目标用户的语音数据和噪声数据的训练数据,所述第二训练数据为所述目标用户的语音数据。

32.在一种可能的实现中,所述方法还包括:获取第一训练数据和第二训练数据,所述第一训练数据为包含所述目标用户的语音数据和噪声数据的训练数据,所述第二训练数据为所述目标用户的语音数据;其中,目标用户的语音数据为目标用户的干净语音,该语音数据中不包含背景噪声或者包含较少的背景噪声,也就是该语音数据作为前景语音的信噪比较低。根据所述第一训练数据和所述第二训练数据,获取目标损失,所述目标损失与第一训练数据和第二训练数据之间的差异有关;获取第一增强模型,并根据所述目标损失对所述第一增强模型进行训练,以得到所述目标增强模型。

33.在一种可能的实现中,所述音频数据增强方法应用于终端设备,所述目标增强模

型为所述终端设备训练得到的,随着端侧设备的容量和算力不断提升,已可应付深度学习模型训练和自适应。端侧收集和存储个人数据于设备,数据不用上传至服务器就可以进行目标增强模型的训练,有效保障用户隐私,且给每个用户可以拥有个人化专属模型,提供个人化的语音增强服务。

34.在一种可能的实现中,可以通过如下方式构建目标用户在特定环境场景中的语音数据:获取所述第二训练数据,采集环境音频,对所述环境音频进行语音分离处理,以得到所述噪声数据,并将所述所述噪声数据与所述第二训练数据进行融合,以得到所述第一训练数据。也就是说,可以将采集的环境音频进行人声分离,进而可以得到该环境场景中的噪声数据,并通过将分离得到的噪声数据和目标用户的语音进行混合来得到目标用户在特定环境场景中的语音数据。在一种可能的实现中,所述融合包括叠加处理或者混响处理。

35.通过上述方式,在采集的音频数据有限的情况下,可以生成更丰富的训练数据,进而提升模型的性能。

36.第二方面,本技术提供了一种音频数据增强装置,所述装置包括:

37.获取单元,用于获取音频数据,所述音频数据包含目标用户的语音数据;基于所述音频数据,从多个增强模型中获取所述目标用户对应的目标增强模型,其中每个增强模型对应一个用户,所述每个增强模型为基于对应的用户的语音数据进行模型训练得到的;

38.音频增强单元,用于根据所述目标增强模型,对所述音频数据进行增强处理,以得到增强后的音频数据。

39.在一种可能的实现中,所述音频数据包含目标用户的语音,包括:

40.所述音频数据包含用户的语音,且所述用户仅包含所述目标用户;或者,

41.所述音频数据包含用户的语音,所述用户包含所述目标用户和第一用户,且所述目标用户的语音在所述音频数据中的能量占比高于所述第一用户的语音在所述音频数据中的能量占比。

42.在一种可能的实现中,所述获取单元,具体用于:

43.获取视频数据,所述视频数据包括图像数据以及所述音频数据;

44.其中,所述图像数据中的用户仅包括所述目标用户;或者,

45.所述图像数据中的用户包含所述目标用户和第二用户,且所述目标用户在所述图像数据中的像素占比高于所述第二用户在所述图像数据中的像素占比。

46.在一种可能的实现中,所述装置还包括:

47.选项提供单元,用于在所述获取所述目标用户对应的目标增强模型之前,提供至少一个第一选项,其中每个第一选项用于指示一个用户;

48.所述获取单元,还用于获取针对于第一目标选项的选择操作,所述第一目标选项为所述至少一个第一选项中的一个,所述第一目标选项用于指示所述目标用户。

49.在一种可能的实现中,所述选项提供单元,具体用于:

50.基于所述音频数据包含至少一个用户的语音,提供所述至少一个用户中每个用户对应的第一选项;或者,

51.获取视频数据,所述视频数据包括图像数据以及所述音频数据;

52.基于所述图像数据包含至少一个用户,提供所述至少一个用户中每个用户对应的第一选项。

53.在一种可能的实现中,所述获取单元,还用于:

54.获取环境信息,所述环境信息用于指示音频采集设备在采集所述音频数据时所处的目标场景;

55.所述获取单元,具体用于:

56.获取所述目标用户以及所述目标场景对应的目标增强模型,其中所述目标增强模型为基于所述目标用户在所述目标场景中的语音数据预先进行模型训练得到的。

57.在一种可能的实现中,所述获取单元,具体用于:

58.获取位置信息,所述位置信息用于指示所述音频采集设备在采集所述音频数据时所处的位置,所述位置信息用于指示所述目标场景;或者,

59.提供至少一个第二选项,其中每个第二选项用于指示一个目标场景;

60.获取针对于第二目标选项的选择操作,所述第二目标选项为所述至少一个第二选项中的一个,所述第二目标选项用于指示所述目标场景。

61.在一种可能的实现中,所述目标增强模型包括第一增强模型分支和第二增强模型分支,所述第一增强模型分支针对于相同音频数据的处理时间低于所述第二增强模型分支,且所述第一增强模型分支的音频增强效果低于所述第二增强分支的音频增强效果,所述音频增强单元,具体用于:

62.获取所述音频数据的应用场景;

63.在所述应用场景为实时语音通话场景的情况下,通过所述第一增强模型分支,对所述音频数据进行增强处理;或者,

64.在所述应用场景为语音后期处理场景的情况下,通过所述第二增强模型分支,对所述音频数据进行增强处理。

65.在一种可能的实现中,所述目标增强模型包括多个串行的网络层,所述多个串行的网络层包括第一网络层和第二网络层,所述第二网络层距离所述目标增强模型的输出网络层的距离小于所述第一网络层距离所述目标增强模型的输出网络层的距离,所述音频增强单元,具体用于:

66.根据所述目标增强模型,对所述音频数据进行增强处理,并将所述第一网络层的输出作为所述增强后的音频数据,所述增强后的音频数据用于文本识别;或者,

67.根据所述目标增强模型,对所述音频数据进行增强处理,并将所述第二网络层的输出作为所述增强后的音频数据,向目标终端传递所述增强后的音频数据,或者在本地保存所述增强后的音频数据。

68.在一种可能的实现中,所述音频数据增强装置应用于终端设备,和/或,所述目标增强模型为所述终端设备训练得到的。

69.在一种可能的实现中,所述目标增强模型为基于所述语音数据进行模型训练得到的,包括:

70.所述目标增强模型为基于m个用户的语音数据预先进行模型训练得到的,所述m个用户包括所述目标用户,且所述m等于1或者所述m等于2。

71.在一种可能的实现中,所述m为1。

72.在一种可能的实现中,所述目标增强模型为基于所述语音数据预先进行模型训练得到的,包括:

73.所述目标增强模型为基于目标损失预先进行模型训练得到的,所述目标损失与第一训练数据和第二训练数据之间的差异有关,所述第一训练数据为包含所述目标用户的语音数据和噪声数据的训练数据,所述第二训练数据为所述目标用户的语音数据。

74.在一种可能的实现中,所述获取单元,还用于:

75.获取第一训练数据和第二训练数据,所述第一训练数据为包含所述目标用户的语音数据和噪声数据的训练数据,所述第二训练数据为所述目标用户的语音数据;

76.根据所述第一训练数据和所述第二训练数据,获取目标损失,所述目标损失与第一训练数据和第二训练数据之间的差异有关;

77.获取第一增强模型,并根据所述目标损失对所述第一增强模型进行训练,以得到所述目标增强模型。

78.在一种可能的实现中,所述噪声数据为目标场景中的噪声数据,所述目标场景为音频采集设备在采集所述音频数据时所处的环境场景。

79.在一种可能的实现中,所述获取单元,具体用于:

80.获取所述第二训练数据;

81.采集环境音频;

82.对所述环境音频进行语音分离处理,以得到所述噪声数据;

83.将所述所述噪声数据与所述第二训练数据进行融合,以得到所述第一训练数据。

84.在一种可能的实现中,所述融合包括叠加处理或者混响处理。

85.第三方面,本技术提供了一种音频数据增强方法,所述方法包括:

86.获取音频数据;

87.基于音频采集设备在采集所述音频数据时所处的目标场景,获取所述目标场景对应的目标增强模型,其中所述目标增强模型为基于用户在所述目标场景中的语音数据预先训练得到的;

88.根据所述目标增强模型,对所述音频数据进行增强处理,以得到增强后的音频数据。

89.在一种可能的实现中,目标增强模型的音频增强性能除了和用户有关,还和环境场景的类型有关,环境场景例如可以包括居家场景、咖啡店场景等,在现有的音频增强方案中,将大量用户在各个环境场景中的语音数据作为训练数据来训练一个普适性的语音增强模型,在推理过程中,通过上述普适性的语音增强模型,对音频数据进行音频增强。训练后的语音增强模型需要具备能够区分人声以及环境噪音的能力,然而,由于不同环境场景中背景噪声的特征不同,由于训练数据有限,并不能使得模型具备识别全部特点类型的背景噪声的能力,因此音频增强的效果较差。

90.本技术实施例中,在网上会议等终端的即时应用场景中,由于环境场景有限,因此,可以针对于有限的环境场景分别训练得到适配于各个环境场景的语音增强模型(例如本技术实施例中的目标增强模型),各个语音增强模型针对于特定环境场景的语音的音频增强性能较好,进而解决了基于普适性的语音增强模型进行音频增强时存在的音频增强效果较差的问题。

91.在一种可能的实现中,所述方法还包括:

92.获取环境信息,所述环境信息用于指示音频采集设备在采集所述音频数据时所处

的目标场景。

93.在一种可能的实现中,所述获取环境信息,包括:

94.获取位置信息,所述位置信息用于指示所述音频采集设备在采集所述音频数据时所处的位置,所述位置信息用于指示所述目标场景;或者,

95.提供至少一个第二选项,其中每个第二选项用于指示一个目标场景;

96.获取针对于第二目标选项的选择操作,所述第二目标选项为所述至少一个第二选项中的一个,所述第二目标选项用于指示所述目标场景。

97.在一种可能的实现中,所述目标增强模型包括第一增强模型分支和第二增强模型分支,所述第一增强模型分支针对于相同音频数据的处理时间低于所述第二增强模型分支,且所述第一增强模型分支的音频增强效果低于所述第二增强分支的音频增强效果,所述根据所述目标增强模型,对所述音频数据进行增强处理,包括:

98.获取所述音频数据的应用场景;

99.在所述应用场景为实时语音通话场景的情况下,通过所述第一增强模型分支,对所述音频数据进行增强处理;或者,

100.在所述应用场景为语音后期处理场景的情况下,通过所述第二增强模型分支,对所述音频数据进行增强处理。

101.在一种可能的实现中,所述目标增强模型包括多个串行的网络层,所述多个串行的网络层包括第一网络层和第二网络层,所述第二网络层距离所述目标增强模型的输出网络层的距离小于所述第一网络层距离所述目标增强模型的输出网络层的距离,所述根据所述目标增强模型,对所述音频数据进行增强处理,以得到增强后的音频数据,包括:

102.根据所述目标增强模型,对所述音频数据进行增强处理,并将所述第一网络层的输出作为所述增强后的音频数据,所述增强后的音频数据用于文本识别;或者,

103.根据所述目标增强模型,对所述音频数据进行增强处理,并将所述第二网络层的输出作为所述增强后的音频数据,向目标终端传递所述增强后的音频数据,或者在本地保存所述增强后的音频数据。

104.在一种可能的实现中,所述音频数据增强方法应用于终端设备,和/或,所述目标增强模型为所述终端设备训练得到的。

105.在一种可能的实现中,所述目标增强模型为基于所述语音数据进行模型训练得到的,包括:

106.所述目标增强模型为基于m个用户的语音数据进行模型训练得到的,所述m个用户包括所述目标用户,且所述m等于1或者所述m等于2。

107.在一种可能的实现中,所述m为1。

108.在一种可能的实现中,所述目标增强模型为基于所述语音数据进行模型训练得到的,包括:

109.所述目标增强模型为基于目标损失预先进行模型训练得到的,所述目标损失与第一训练数据和第二训练数据之间的差异有关,所述第一训练数据为包含所述目标用户的语音数据和噪声数据的训练数据,所述第二训练数据为所述目标用户的语音数据。

110.在一种可能的实现中,所述方法还包括:

111.获取第一训练数据和第二训练数据;

112.根据所述第一训练数据和所述第二训练数据,获取目标损失,所述目标损失与第一训练数据和第二训练数据之间的差异有关;

113.获取第一增强模型,并根据所述目标损失对所述第一增强模型进行训练,以得到所述目标增强模型。

114.在一种可能的实现中,所述获取第一训练数据和第二训练数据,包括:

115.获取所述第二训练数据;

116.采集环境音频;

117.对所述环境音频进行语音分离处理,以得到所述噪声数据;

118.将所述所述噪声数据与所述第二训练数据进行融合,以得到所述第一训练数据。

119.在一种可能的实现中,所述融合包括叠加处理或者混响处理。

120.第四方面,本技术提供了一种音频数据增强装置,所述装置包括:

121.获取单元,用于获取音频数据,以及基于音频采集设备在采集所述音频数据时所处的目标场景,获取所述目标场景对应的目标增强模型,其中所述目标增强模型为基于用户在所述目标场景中的语音数据预先训练得到的;

122.音频增强单元,用于根据所述获取单元获取的所述目标增强模型,对所述音频数据进行增强处理,以得到增强后的音频数据。

123.在一种可能的实现中,目标增强模型的音频增强性能除了和用户有关,还和环境场景的类型有关,环境场景例如可以包括居家场景、咖啡店场景等,在现有的音频增强方案中,将大量用户在各个环境场景中的语音数据作为训练数据来训练一个普适性的语音增强模型,在推理过程中,通过上述普适性的语音增强模型,对音频数据进行音频增强。训练后的语音增强模型需要具备能够区分人声以及环境噪音的能力,然而,由于不同环境场景中背景噪声的特征不同,由于训练数据有限,并不能使得模型具备识别全部特点类型的背景噪声的能力,因此音频增强的效果较差。本技术实施例中,在网上会议等终端的即时应用场景中,由于环境场景有限,因此,可以针对于有限的环境场景分别训练得到适配于各个环境场景的语音增强模型(例如本技术实施例中的目标增强模型),各个语音增强模型针对于特定环境场景的语音的音频增强性能较好,进而解决了基于普适性的语音增强模型进行音频增强时存在的音频增强效果较差的问题。

124.在一种可能的实现中,所述获取单元,还用于:

125.获取环境信息,所述环境信息用于指示音频采集设备在采集所述音频数据时所处的目标场景。

126.在一种可能的实现中,所述获取单元,具体用于:

127.获取位置信息,所述位置信息用于指示所述音频采集设备在采集所述音频数据时所处的位置,所述位置信息用于指示所述目标场景;或者,

128.提供至少一个第二选项,其中每个第二选项用于指示一个目标场景;

129.获取针对于第二目标选项的选择操作,所述第二目标选项为所述至少一个第二选项中的一个,所述第二目标选项用于指示所述目标场景。

130.在一种可能的实现中,所述目标增强模型包括第一增强模型分支和第二增强模型分支,所述第一增强模型分支针对于相同音频数据的处理时间低于所述第二增强模型分支,且所述第一增强模型分支的音频增强效果低于所述第二增强分支的音频增强效果,所

述音频增强单元,具体用于:

131.获取所述音频数据的应用场景;

132.在所述应用场景为实时语音通话场景的情况下,通过所述第一增强模型分支,对所述音频数据进行增强处理;或者,

133.在所述应用场景为语音后期处理场景的情况下,通过所述第二增强模型分支,对所述音频数据进行增强处理。

134.在一种可能的实现中,所述目标增强模型包括多个串行的网络层,所述多个串行的网络层包括第一网络层和第二网络层,所述第二网络层距离所述目标增强模型的输出网络层的距离小于所述第一网络层距离所述目标增强模型的输出网络层的距离,所述音频增强单元,具体用于:

135.根据所述目标增强模型,对所述音频数据进行增强处理,并将所述第一网络层的输出作为所述增强后的音频数据,所述增强后的音频数据用于文本识别;或者,

136.根据所述目标增强模型,对所述音频数据进行增强处理,并将所述第二网络层的输出作为所述增强后的音频数据,向目标终端传递所述增强后的音频数据,或者在本地保存所述增强后的音频数据。

137.在一种可能的实现中,所述音频数据增强方法应用于终端设备,和/或,所述目标增强模型为所述终端设备训练得到的。

138.在一种可能的实现中,所述目标增强模型为基于所述语音数据进行模型训练得到的,包括:

139.所述目标增强模型为基于m个用户的语音数据进行模型训练得到的,所述m个用户包括所述目标用户,且所述m等于1或者所述m等于2。

140.在一种可能的实现中,所述m为1。

141.在一种可能的实现中,所述目标增强模型为基于所述语音数据进行模型训练得到的,包括:

142.所述目标增强模型为基于目标损失预先进行模型训练得到的,所述目标损失与第一训练数据和第二训练数据之间的差异有关,所述第一训练数据为包含所述目标用户的语音数据和噪声数据的训练数据,所述第二训练数据为所述目标用户的语音数据。

143.在一种可能的实现中,所述获取单元,还用于:

144.获取第一训练数据和第二训练数据;

145.根据所述第一训练数据和所述第二训练数据,获取目标损失,所述目标损失与第一训练数据和第二训练数据之间的差异有关;

146.获取第一增强模型,并根据所述目标损失对所述第一增强模型进行训练,以得到所述目标增强模型。

147.在一种可能的实现中,所述获取单元,具体用于:

148.获取所述第二训练数据;

149.采集环境音频;

150.对所述环境音频进行语音分离处理,以得到所述噪声数据;

151.将所述所述噪声数据与所述第二训练数据进行融合,以得到所述第一训练数据。

152.在一种可能的实现中,所述融合包括叠加处理或者混响处理。

153.第五方面,本技术实施例提供了一种音频增强装置,可以包括存储器、处理器以及总线系统,其中,存储器用于存储程序,处理器用于执行存储器中的程序,以执行如上述第一方面及其任一可选的方法、以及第三方面及其任一可选的方法。

154.第六方面,本技术实施例提供了一种计算机可读存储介质,所述计算机可读存储介质中存储有计算机程序,当其在计算机上运行时,使得计算机执行上述第一方面及其任一可选的方法、以及第三方面及其任一可选的方法。

155.第七方面,本技术实施例提供了一种计算机程序,当其在计算机上运行时,使得计算机执行上述第一方面及其任一可选的方法、以及第三方面及其任一可选的方法。

156.第八方面,本技术提供了一种芯片系统,该芯片系统包括处理器,用于支持执行设备或训练设备实现上述方面中所涉及的功能,例如,发送或处理上述方法中所涉及的数据;或,信息。在一种可能的设计中,所述芯片系统还包括存储器,所述存储器,用于保存执行设备或训练设备必要的程序指令和数据。该芯片系统,可以由芯片构成,也可以包括芯片和其他分立器件。

157.本技术实施例提供了一种音频数据增强方法,所述方法包括:获取音频数据,所述音频数据包含目标用户的语音;基于所述音频数据,获取所述目标用户对应的目标增强模型,其中所述目标增强模型为基于所述目标用户的语音数据预先进行模型训练得到的;根据所述目标增强模型,对所述音频数据进行增强处理,以得到增强后的音频数据。通过上述方式,基于目标用户的语音数据单独训练了一个针对于目标用户的语音增强模型(也就是本实施例中的目标增强模型),在对包含目标用户的语音的音频数据进行音频增强时,该模型具备很高的音频增强性能,在网上会议等终端的即时应用场景中,由于终端的使用者有限,因此,可以针对于有限的用户分别训练得到适配于各个用户的语音增强模型(例如本技术实施例中的目标增强模型),各个语音增强模型针对于特定用户的语音的音频增强性能较好,进而解决了基于普适性的语音增强模型进行音频增强时存在的音频增强效果较差的问题。

附图说明

158.图1为人工智能主体框架的一种结构示意图;

159.图2a为一种应用架构示意图;

160.图2b为一种应用架构示意图;

161.图2c为一种应用架构示意图;

162.图2d为一种应用架构示意图;

163.图3a为一种产品示意图;

164.图3b为一种系统架构的示意图;

165.图4a为本技术实施例提供的一种音频数据增强方法的流程示意图;

166.图4b为本技术实施例提供的一种网络的结构示意图;

167.图4c为本技术实施例提供的一种前景语音提取的示意图;

168.图4d为本技术实施例提供的一种音频数据增强方法的流程示意图;

169.图4e为本技术实施例提供的一种语音混合的示意图;

170.图4f为本技术实施例提供的一种音频数据增强方法的流程示意图;

171.图4g为本技术实施例提供的一种音频数据增强方法的流程示意图;

172.图4h为本技术实施例提供的一种音频数据增强方法的流程示意图;

173.图5为本技术实施例提供的一种应用界面的示意图;

174.图6为本技术实施例提供的一种应用界面的示意图;

175.图7为本技术实施例提供的一种应用界面的示意图;

176.图8为本技术实施例提供的一种应用界面的示意图;

177.图9为本技术实施例提供的一种应用界面的示意图;

178.图10为本技术实施例提供的一种应用界面的示意图;

179.图11为本技术实施例提供的一种应用界面的示意图;

180.图12为本技术实施例提供的一种应用界面的示意图;

181.图13为本技术实施例提供的一种应用界面的示意图;

182.图14为本技术实施例提供的一种应用界面的示意图;

183.图15为本技术实施例提供的一种应用界面的示意图;

184.图16为本技术实施例提供的一种音频数据增强方法的流程示意图;

185.图17为本技术实施例提供的一种应用界面的示意图;

186.图18为本技术实施例提供的一种应用界面的示意图;

187.图19为本技术实施例提供的一种音频数据增强方法的流程示意图;

188.图20为本技术实施例提供的一种应用界面的示意图;

189.图21为本技术实施例提供的一种应用界面的示意图;

190.图22为本技术实施例提供的一种应用界面的示意图;

191.图23为本技术实施例提供的一种音频数据增强方法的流程示意图;

192.图24为本技术实施例提供的一种音频数据增强装置的结构示意图;

193.图25为本技术实施例提供的一种音频数据增强装置的结构示意图;

194.图26为本技术实施例提供的执行设备的一种结构示意图;

195.图27为本技术实施例提供的训练设备一种结构示意图;

196.图28为本技术实施例提供的芯片的一种结构示意图。

具体实施方式

197.下面结合本发明实施例中的附图对本发明实施例进行描述。本发明的实施方式部分使用的术语仅用于对本发明的具体实施例进行解释,而非旨在限定本发明。

198.下面结合附图,对本技术的实施例进行描述。本领域普通技术人员可知,随着技术的发展和新场景的出现,本技术实施例提供的技术方案对于类似的技术问题,同样适用。

199.本技术的说明书和权利要求书及上述附图中的术语“第一”、“第二”等是用于区别类似的对象,而不必用于描述特定的顺序或先后次序。应该理解这样使用的术语在适当情况下可以互换,这仅仅是描述本技术的实施例中对相同属性的对象在描述时所采用的区分方式。此外,术语“包括”和“具有”以及他们的任何变形,意图在于覆盖不排他的包含,以便包含一系列单元的过程、方法、系统、产品或设备不必限于那些单元,而是可包括没有清楚地列出的或对于这些过程、方法、产品或设备固有的其它单元。

200.首先对人工智能系统总体工作流程进行描述,请参见图1,图1示出的为人工智能

主体框架的一种结构示意图,下面从“智能信息链”(水平轴)和“it价值链”(垂直轴)两个维度对上述人工智能主题框架进行阐述。其中,“智能信息链”反映从数据的获取到处理的一列过程。举例来说,可以是智能信息感知、智能信息表示与形成、智能推理、智能决策、智能执行与输出的一般过程。在这个过程中,数据经历了“数据—信息—知识—智慧”的凝练过程。“it价值链”从人智能的底层基础设施、信息(提供和处理技术实现)到系统的产业生态过程,反映人工智能为信息技术产业带来的价值。

201.(1)基础设施

202.基础设施为人工智能系统提供计算能力支持,实现与外部世界的沟通,并通过基础平台实现支撑。通过传感器与外部沟通;计算能力由智能芯片(cpu、npu、gpu、asic、fpga等硬件加速芯片)提供;基础平台包括分布式计算框架及网络等相关的平台保障和支持,可以包括云存储和计算、互联互通网络等。举例来说,传感器和外部沟通获取数据,这些数据提供给基础平台提供的分布式计算系统中的智能芯片进行计算。

203.(2)数据

204.基础设施的上一层的数据用于表示人工智能领域的数据来源。数据涉及到图形、图像、语音、文本,还涉及到传统设备的物联网数据,包括已有系统的业务数据以及力、位移、液位、温度、湿度等感知数据。

205.(3)数据处理

206.数据处理通常包括数据训练,机器学习,深度学习,搜索,推理,决策等方式。

207.其中,机器学习和深度学习可以对数据进行符号化和形式化的智能信息建模、抽取、预处理、训练等。

208.推理是指在计算机或智能系统中,模拟人类的智能推理方式,依据推理控制策略,利用形式化的信息进行机器思维和求解问题的过程,典型的功能是搜索与匹配。

209.决策是指智能信息经过推理后进行决策的过程,通常提供分类、排序、预测等功能。

210.(4)通用能力

211.对数据经过上面提到的数据处理后,进一步基于数据处理的结果可以形成一些通用的能力,比如可以是算法或者一个通用系统,例如,翻译,文本的分析,计算机视觉的处理,语音识别,图像的识别等等。

212.(5)智能产品及行业应用

213.智能产品及行业应用指人工智能系统在各领域的产品和应用,是对人工智能整体解决方案的封装,将智能信息决策产品化、实现落地应用,其应用领域主要包括:智能终端、智能交通、智能医疗、自动驾驶、智慧城市等。

214.本技术可以应用于人工智能领域的音频处理领域中,具体可以应用在即时语音以及语音录制等音频数据领域中。

215.下面以即时语音的应用场景为例进行介绍:

216.本技术可以用于在即时语音的场景中,其中,即时语音也可以称之为即时通话、即时通讯、即时通信等等,其中即时语音可以允许两人或多人使用网络通过实时传递的语音或者携带有语音的视频来进行交流,即时语音的业务要求为时延低且传输的语音质量高。

217.在一种实现中,即时语音可以在实时通信系统中实现。

218.接下来描述本技术实施例中的即时通信系统:

219.参照图2a,图2a为一种即时通信系统的一个架构示意,如图2a所示,该通信系统中可包括n(n为大于1的整数)个电子设备。这n个电子设备之间可通过通信网络互联。

220.接下来介绍通信网络的类型:

221.示例性的,上述通信网络可以是有线网络,也可以是无线网络。例如,上述通信网络可以是局域网(local area networks,lan),也可以是广域网(wide area networks,wan),例如互联网。上述通信网络可使用任何已知的网络通信协议来实现,上述网络通信协议可以是各种有线或无线通信协议,诸如以太网、通用串行总线(universal serial bus,usb)、火线(firewire)、全球移动通讯系统(global system for mobile communications,gsm)、通用分组无线服务(general packet radio service,gprs)、码分多址接入(code division multiple access,cdma)、宽带码分多址(wideband code division multiple access,wcdma),时分码分多址(time

‑

division code division multiple access,tdscdma),长期演进(long term evolution,lte)、蓝牙、无线保真(wireless fidelity,wifi)、nfc、基于互联网协议的语音通话(voice over internet protocol,voip)、支持网络切片架构的通信协议或任何其他合适的通信协议。

222.示例性地,在一些实施例中,通信系统中的各个电子设备登陆各自的账号(例如华为账号)后可通过一个或多个服务器互联,以上服务器也可以通过云端实现。在另一些实施例中,通信系统中的各个电子设备之间可通过wi

‑

fi协议建立wi

‑

fi连接。

223.在一种实现中,电子设备上可以安装有即时通信应用,电子设备之间可以通过即时通信应用实现即时通话。

224.其中,即时通信应用既可以是设备出厂前预先安装的应用,例如华为的畅连应用,也可以是用户购买设备后下载或安装的第三方应用,例如微信。

225.在一种可能的实现中,即时通信应用可以为网上会议相关的应用,随着有线及无线网络速度不断提高,网上会议应用已经变得非常普及。进行会议的场景也已经由办公室内会议室场景扩展至一般的室内家居场景。

226.在室内场景中,常常存在背景噪音,例如办公室内会议室场景内常见的背景讨论对话声、键盘声、打印机噪声等背景噪音,以及室内家居场景中的儿童玩耍、电视机广播人声、家庭电器操作声等背景噪音,为了提高进行网上会议时的语音通话质量,终端设备(也就是上述描述的电子设备)在采集到周围环境中的音频信号之后,需要对音频信号进行音频增强处理,以去除会议中出现的背景噪声。

227.参照图2b,图2b为一种网上会议相关的架构示意,终端设备之间可以通过网上会议应用实现即时通信(例如基于音频信号以及图像数据的传输来实现即时通信)。

228.参照图2c,图2c为一种网上会议相关的架构示意,如图2c所示,在通过网上会议应用实现即时通信时,终端设备可以对音频信号进行音频增强处理,来去除会议中出现的背景噪声,并将增强后的音频信号传递至其他终端设备。

229.应理解,在语音录制的场景中,终端设备可以对采集的音频信号进行音频增强,并在本地保存增强后的音频信号。

230.以上结合通信系统来描述了即时通信的产品架构,接下来描述终端设备(也就是上述电子设备,本技术也可以简称为终端)的硬件架构:

231.应理解,不论是即时语音还是语音录制,以下终端设备的描述都可以适用。

232.本技术实施例中的终端设备可以为手机、平板电脑、可穿戴设备、车载设备、增强现实(augmented reality,ar)/虚拟现实(virtual reality,vr)设备、笔记本电脑、超级移动个人计算机(ultra

‑

mobile personal computer,umpc)、上网本、个人数字助理(personal digital assistant,pda)等,本技术实施例对此不作任何限制。

233.图2d示出了终端100的一种可选的硬件结构示意图。

234.参考图2d所示,终端100可以包括射频单元110、存储器120、输入单元130、显示单元140、摄像头150、音频电路160、扬声器161、麦克风162、处理器170、外部接口180、电源190等部件。本领域技术人员可以理解,图2d仅仅是智能终端或多功能设备的举例,并不构成对智能终端或多功能设备的限定,可以包括比图示更多或更少的部件,或者组合某些部件,或者不同的部件。

235.摄像头150用于采集图像或视频,可以通过应用程序指令触发开启,实现拍照或者摄像功能。摄像头可以包括成像镜头,滤光片,图像传感器等部件。物体发出或反射的光线进入成像镜头,通过滤光片,最终汇聚在图像传感器上。成像镜头主要是用于对拍照视角中的所有物体(也可称为待拍摄场景、待拍摄对象、目标场景或目标对象,也可以理解为用户期待拍摄的场景图像)发出或反射的光汇聚成像;滤光片主要是用于将光线中的多余光波(例如除可见光外的光波,如红外)滤去;图像传感器主要是用于对接收到的光信号进行光电转换,转换成电信号,并输入到处理器170进行后续处理。其中,摄像头可以位于终端设备的前面,也可以位于终端设备的背面,摄像头具体个数以及排布方式可以根据设计者或厂商策略的需求灵活确定,本技术不做限定。

236.其中,在网上会议等即时通信的场景中,摄像头可以采集用户的视频数据(例如视频帧),并将视频数据传递至其他终端设备,应理解,该视频数据中还可以包括音频采集设备采集的音频信号。

237.输入单元130可用于接收输入的数字或字符信息,以及产生与所述便携式多功能装置的用户设置以及功能控制有关的键信号输入。具体地,输入单元130可包括触摸屏131和/或其他输入设备132。所述触摸屏131可收集用户在其上或附近的触摸操作(比如用户使用手指、关节、触笔等任何适合的物体在触摸屏上或在触摸屏附近的操作),并根据预先设定的程序驱动相应的连接装置。触摸屏可以检测用户对触摸屏的触摸动作,将所述触摸动作转换为触摸信号发送给所述处理器170,并能接收所述处理器170发来的命令并加以执行;所述触摸信号至少包括触点坐标信息。所述触摸屏131可以提供所述终端100和用户之间的输入界面和输出界面。此外,可以采用电阻式、电容式、红外线以及表面声波等多种类型实现触摸屏。除了触摸屏131,输入单元130还可以包括其他输入设备。具体地,其他输入设备132可以包括但不限于物理键盘、功能键(比如音量控制按键132、开关按键133等)、轨迹球、鼠标、操作杆等中的一种或多种。

238.所述显示单元140可用于显示由用户输入的信息或提供给用户的信息、终端100的各种菜单、交互界面、文件显示和/或任意一种多媒体文件的播放。在本发明实施例中,显示单元还用于显示设备利用摄像头150获取到的图像/视频,可以包括某些拍摄模式下的预览图像/视频、拍摄的初始图像/视频以及拍摄后经过一定算法处理后的图像/视频。

239.进一步的,触摸屏131可覆盖显示面板,当触摸屏131检测到在其上或附近的触摸

操作后,传送给处理器170以确定触摸事件的类型,随后处理器170根据触摸事件的类型在显示面板上提供相应的视觉输出。在本实施例中,触摸屏与显示单元可以集成为一个部件而实现终端100的输入、输出、显示功能;为便于描述,本发明实施例以触摸显示屏代表触摸屏和显示单元的功能集合;在某些实施例中,触摸屏与显示单元也可以作为两个独立的部件。

240.其中,本技术实施例中,显示单元140可以显示至少一个第一选项,其中每个第一选项用于指示一个用户;输入单元130可以接收针对于所述至少一个第一选项中第一目标选项的选择操作;显示单元140可以显示至少一个第二选项,其中每个第二选项用于指示一个目标场景;输入单元130可以接收针对于所述至少一个第二选项中第二目标选项的选择操作。

241.所述存储器120可用于存储指令和数据,存储器120可主要包括存储指令区和存储数据区,存储数据区可存储各种数据,如多媒体文件、文本等;存储指令区可存储操作系统、应用、至少一个功能所需的指令等软件单元,或者他们的子集、扩展集。还可以包括非易失性随机存储器;向处理器170提供包括管理计算处理设备中的硬件、软件以及数据资源,支持控制软件和应用。还用于多媒体文件的存储,以及运行程序和应用的存储。

242.处理器170是终端100的控制中心,利用各种接口和线路连接整个手机的各个部分,通过运行或执行存储在存储器120内的指令以及调用存储在存储器120内的数据,执行终端100的各种功能和处理数据,从而对手机进行整体控制。可选的,处理器170可包括一个或多个处理单元;优选的,处理器170可集成应用处理器和调制解调处理器,其中,应用处理器主要处理操作系统、用户界面和应用程序等,调制解调处理器主要处理无线通信。可以理解的是,上述调制解调处理器也可以不集成到处理器170中。在一些实施例中,处理器、存储器、可以在单一芯片上实现,在一些实施例中,他们也可以在独立的芯片上分别实现。处理器170还可以用于产生相应的操作控制信号,发给计算处理设备相应的部件,读取以及处理软件中的数据,尤其是读取和处理存储器120中的数据和程序,以使其中的各个功能模块执行相应的功能,从而控制相应的部件按指令的要求进行动作。

243.其中,处理器170可以执行本技术实施例中与数据处理相关的步骤,也可以调度其他传感器或者模块以实现相应的功能。

244.所述射频单元110可用于收发信息或通话过程中信号的接收和发送,例如,将基站的下行信息接收后,给处理器170处理;另外,将设计上行的数据发送给基站。通常,rf电路包括但不限于天线、至少一个放大器、收发信机、耦合器、低噪声放大器(low noise amplifier,lna)、双工器等。此外,射频单元110还可以通过无线通信与网络设备和其他设备通信。所述无线通信可以使用任一通信标准或协议,包括但不限于全球移动通讯系统(global system of mobile communication,gsm)、通用分组无线服务(general packet radio service,gprs)、码分多址(code division multiple access,cdma)、宽带码分多址(wideband code division multiple access,wcdma)、长期演进(long term evolution,lte)、电子邮件、短消息服务(short messaging service,sms)等。

245.其中,音频电路160、扬声器161、麦克风162可提供用户与终端100之间的音频接口。音频电路160可将接收到的音频数据转换为电信号,传输到扬声器161,由扬声器161转换为音频数据输出;另一方面,麦克风162用于收集音频数据,还可以将收集的音频数据转

换为电信号,由音频电路160接收后转换为音频数据,再将音频数据输出处理器170处理后(例如本技术实施例中与音频增强相关的处理),经射频单元110以发送给比如另一终端,或者将音频数据输出至存储器120以便进一步处理,音频电路也可以包括耳机插孔163,用于提供音频电路和耳机之间的连接接口。

246.终端100还包括给各个部件供电的电源190(比如电池),优选的,电源可以通过电源管理系统与处理器170逻辑相连,从而通过电源管理系统实现管理充电、放电、以及功耗管理等功能。

247.终端100还包括外部接口180,所述外部接口可以是标准的micro usb接口,也可以使多针连接器,可以用于连接终端100与其他装置进行通信,也可以用于连接充电器为终端100充电。

248.尽管未示出,终端100还可以包括闪光灯、无线保真(wireless fidelity,wifi)模块、蓝牙模块、不同功能的传感器等,在此不再赘述。下文中描述的部分或全部方法均可以应用在如图2d所示的终端中。

249.本技术实施例可应用于具有录音功能的移动终端设备,落地产品形态可以是智能终端(手机、平板、dv、摄像机、照相机、便携电脑等)或家庭摄像头(智能摄像头/可视机顶盒/智能音箱),具体的可以是其中的应用程序或软件,本技术实施例可以部署在终端设备上,通过软件安装或升级,通过硬件的调用配合,来提供声音处理功能。

250.可选地,一种硬件构成实施可以如下,一个智能终端,具有至少2只模拟或数字麦克风,可实现正常的麦克风拾音功能。可通过处理器或操作系统获取到麦克风采集到的数据,并保存在内存空间上,由处理器做进一步的处理和运算。有至少一个摄像头,可正常录制画面。本技术实施例可应用于音频数据的增强,前提是终端设置有麦克风。

251.麦克风在终端上的具体布局的一种实现可以如下图3a所示,在智能终端的6个表面上均有可能设置有麦克风,如图3a中的

①‑⑨

;在一种实现中,终端可以至少包含顶部麦克风

①

(前面顶端)、

②

(背面顶端)、

③

(顶面)中的一个,以及底部麦克风

⑥

(底面左部)、

⑦

(底面右部)、

⑧

(前面底端)、

⑨

(背面底端)中的一个。

252.一种典型的应用场景是智能终端至少包含如图3a所示的麦克风

③

和麦克风

⑥

,此外,还可以包含前置摄像头(单摄或双摄)和/或后置摄像头(单摄、双摄或三摄),非平面终端还可以只有一个单摄像头。以上结构可以作为本技术实施例中完成音频增强处理的基础。

253.本技术实施例的应用场景为用户在进行语音通话或者语音录制的过程中,如果获取到的音频数据中包含人物发声(本技术实施例中也称之为目标用户的语音),则希望能够对音频数据进行增强,进而对周围环境的噪声进行降噪;其中,降噪最低可以降到0,但是可能会失去人声的真实性,因此也可对噪声进行部分抑制。

254.在现有的音频增强方案中,将大量用户的语音数据作为训练数据来训练一个普适性的语音增强模型,在推理过程中,通过上述普适性的语音增强模型,对音频数据进行音频增强。训练后的语音增强模型需要具备能够区分人声以及环境噪音的能力,然而,由于不同人的发声习惯不同,不同人发出声音的音色、韵律特点都不相同,由于训练数据有限,并不能使得模型具备识别全部特点类型的人声的能力,因此音频增强的效果较差。

255.本技术实施例中,在网上会议等终端的即时应用场景中,由于终端的使用者有限,

因此,可以针对于有限的用户分别训练得到适配于各个用户的语音增强模型(例如本技术实施例中的目标增强模型),各个语音增强模型针对于特定用户的语音的音频增强性能较好,进而解决了基于普适性的语音增强模型进行音频增强时存在的音频增强效果较差的问题。

256.本技术实施例中的音频增强功能可以基于音频增强模型来实现,音频增强模型可以为神经网络模型,接下来从音频增强模型的训练以及推理的角度对本技术实施例提供的系统架构进行详细的介绍。

257.下面结合图3b对本技术实施例提供的系统架构进行详细的介绍。图3b为本技术一实施例提供的系统架构示意图。如图3b所示,系统架构500包括执行设备510、训练设备520、数据库530、客户设备540、数据存储系统550以及数据采集系统560。

258.执行设备510包括计算模块511、i/o接口512、预处理模块513和预处理模块514。计算模块511中可以包括目标模型/规则501,预处理模块513和预处理模块514是可选的。

259.数据采集设备560用于采集训练数据。其中,在音频增强的任务中,训练数据可以为用户的语音数据(例如本技术实施例中的第二训练数据),该语音数据可以为干净的人声,也就是基本上不包含背景噪音的人声,以及包含背景噪音以及用户的语音数据的混合音频(例如本技术实施例中的第一训练数据)。在采集到训练数据之后,数据采集设备560将这些训练数据存入数据库530,训练设备520基于数据库530中维护的训练数据训练得到目标模型/规则501。

260.以目标模型/规则501用于实现音频增强任务为例,上述目标模型/规则501(例如本技术实施例中的目标增强模型)能够用于实现音频增强任务,即,将音频数据输入该目标模型/规则501,即可得到去噪声后的音频数据(例如本技术实施例中的增强后的音频数据)。

261.需要说明的是,在实际应用中,数据库530中维护的训练数据不一定都来自于数据采集设备560的采集,也有可能是从其他设备接收得到的。另外需要说明的是,训练设备520也不一定完全基于数据库530维护的训练数据进行目标模型/规则501的训练,也有可能从云端或其他地方获取训练数据进行模型训练,上述描述不应该作为对本技术实施例的限定。

262.根据训练设备520训练得到的目标模型/规则501可以应用于不同的系统或设备中,如应用于图3b所示的执行设备510,所述执行设备510可以是终端,如手机终端,平板电脑,笔记本电脑,增强现实(augmented reality,ar)/虚拟现实(virtual reality,vr)设备,车载终端等,还可以是服务器或者云端等。在图3b中,执行设备510配置输入/输出(input/output,i/o)接口512,用于与外部设备进行数据交互,用户可以通过客户设备540向i/o接口512输入数据(例如本技术实施例中的音频数据)。

263.预处理模块513和预处理模块514用于根据i/o接口512接收到的输入数据进行预处理。应理解,可以没有预处理模块513和预处理模块514或者只有的一个预处理模块。当不存在预处理模块513和预处理模块514时,可以直接采用计算模块511对输入数据进行处理。

264.在执行设备510对输入数据进行预处理,或者在执行设备510的计算模块511执行计算等相关的处理过程中,执行设备510可以调用数据存储系统550中的数据、代码等以用于相应的处理,也可以将相应处理得到的数据、指令等存入数据存储系统550中。

265.最后,i/o接口512将处理结果(例如本技术实施例中的增强后的音频数据)呈现给客户设备540,从而提供给用户。

266.在图3b所示情况下,用户可以手动给定输入数据,该“手动给定输入数据”可以通过i/o接口512提供的界面进行操作。另一种情况下,客户设备540可以自动地向i/o接口512发送输入数据,如果要求客户设备540自动发送输入数据需要获得用户的授权,则用户可以在客户设备540中设置相应权限。用户可以在客户设备540查看执行设备510输出的结果,具体的呈现形式可以是显示、声音、动作等具体方式。客户设备540也可以作为数据采集端,采集如图所示输入i/o接口512的输入数据及输出i/o接口512的输出结果作为新的样本数据,并存入数据库530。当然,也可以不经过客户设备540进行采集,而是由i/o接口512直接将如图所示输入i/o接口512的输入数据及输出i/o接口512的输出结果,作为新的样本数据存入数据库530。

267.值得注意的是,图3b仅是本技术实施例提供的一种系统架构的示意图,图中所示设备、器件、模块等之间的位置关系不构成任何限制,例如,在图3b中,数据存储系统550相对执行设备510是外部存储器,在其它情况下,也可以将数据存储系统550置于执行设备510中。

268.应理解,上述执行设备510也可以部署于客户设备540中。

269.从模型推理的角度,本技术实施例中,上述数据存储系统550中可以存储有用于实现本技术实施例中的音频增强方法相关的代码,计算模块511可以从数据存储系统550中获取到上述用于实现本技术实施例中的音频增强方法相关的代码,以执行本技术实施例中的音频增强方法。

270.本技术实施例中,计算模块511可以包括硬件电路(如专用集成电路(application specific integrated circuit,asic)、现场可编程门阵列(field

‑

programmable gate array,fpga)、通用处理器、数字信号处理器(digital signal processing,dsp)、微处理器或微控制器等等)、或这些硬件电路的组合,例如,计算模块511可以为具有执行指令功能的硬件系统,如cpu、dsp等,或者为不具有执行指令功能的硬件系统,如asic、fpga等,或者为上述不具有执行指令功能的硬件系统以及具有执行指令功能的硬件系统的组合。

271.具体的,计算模块511可以为具有执行指令功能的硬件系统,本技术实施例提供的数据处理方法可以为存储在数据存储系统550中的软件代码,计算模块511可以从数据存储系统550中获取到软件代码,并执行获取到的软件代码来实现本技术实施例提供的音频数据增强方法。

272.应理解,计算模块511可以为不具有执行指令功能的硬件系统以及具有执行指令功能的硬件系统的组合,本技术实施例提供的音频增强方法的部分步骤还可以通过计算模块511中不具有执行指令功能的硬件系统或者预处理模块513、预处理模块514来实现,这里并不限定。

273.在一种可能的实现中,上述训练设备520可以为云侧的服务器,执行设备510可以为终端设备。

274.在一种可能的实现中,上述训练设备520和执行设备510都可以为终端设备,也就是说,语音增强模型的训练和推理都是由终端设备来做的(应理解,这里的终端设备的形态可以为独立的一个终端设备或者是分布式的终端设备,也就是由多个终端设备共同配合来

进行模型的训练)。

275.由于本技术实施例中的语音增强模型是基于特定的用户训练的,在训练过程中需要收集用户的语音及所在的环境噪声数据,在过去,受到端侧设备算力和存储所限,收集后的用户数据需要送到云端服务器进行训练,这会引起隐私问题,由于终端的计算能力不断增强,因此可以在终端侧实现模型的训练过程。

276.由于本技术实施例涉及大量神经网络的应用,为了便于理解,下面先对本技术实施例涉及的相关术语及神经网络等相关概念进行介绍。

277.(1)神经网络

278.神经网络可以是由神经单元组成的,神经单元可以是指以xs(即输入数据)和截距1为输入的运算单元,该运算单元的输出可以为:

[0279][0280]

其中,s=1、2、

……

n,n为大于1的自然数,ws为xs的权重,b为神经单元的偏置。f为神经单元的激活函数(activation functions),用于将非线性特性引入神经网络中,来将神经单元中的输入信号转换为输出信号。该激活函数的输出信号可以作为下一层卷积层的输入,激活函数可以是sigmoid函数。神经网络是将多个上述单一的神经单元联结在一起形成的网络,即一个神经单元的输出可以是另一个神经单元的输入。每个神经单元的输入可以与前一层的局部接受域相连,来提取局部接受域的特征,局部接受域可以是由若干个神经单元组成的区域。

[0281]

(2)深度神经网络

[0282]

深度神经网络(deep neural network,dnn),也称多层神经网络,可以理解为具有很多层隐含层的神经网络,这里的“很多”并没有特别的度量标准。从dnn按不同层的位置划分,dnn内部的神经网络可以分为三类:输入层,隐含层,输出网络层。一般来说第一网络层是输入层,最后一层是输出网络层,中间的层数都是隐含层。层与层之间是全连接的,也就是说,第i层的任意一个神经元一定与第i+1层的任意一个神经元相连。虽然dnn看起来很复杂,但是就每一层的工作来说,其实并不复杂,简单来说就是如下线性关系表达式:其中,是输入向量,是输出向量,是偏移向量,w是权重矩阵(也称系数),α()是激活函数。每一层仅仅是对输入向量经过如此简单的操作得到输出向量由于dnn层数多,则系数w和偏移向量的数量也就很多了。这些参数在dnn中的定义如下所述:以系数w为例:假设在一个三层的dnn中,第二网络层的第4个神经元到第三层的第2个神经元的线性系数定义为上标3代表系数w所在的层数,而下标对应的是输出的第三层索引2和输入的第二网络层索引4。总结就是:第l

‑

1层的第k个神经元到第l层的第j个神经元的系数定义为需要注意的是,输入层是没有w参数的。在深度神经网络中,更多的隐含层让网络更能够刻画现实世界中的复杂情形。理论上而言,参数越多的模型复杂度越高,“容量”也就越大,也就意味着它能完成更复杂的学习任务。训练深度神经网络的也就是学习权重矩阵的过程,其最终目的是得到训练好的深度神经网络的所有层的权重矩阵(由很多层的向量w形成的权重矩阵)。

[0283]

(3)损失函数

[0284]

在训练深度神经网络的过程中,因为希望深度神经网络的输出尽可能的接近真正想要预测的值,所以可以通过比较当前网络的预测值和真正想要的目标值,再根据两者之间的差异情况来更新每一层神经网络的权重向量(当然,在第一次更新之前通常会有初始化的过程,即为深度神经网络中的各层预先配置参数),比如,如果网络的预测值高了,就调整权重向量让它预测低一些,不断的调整,直到深度神经网络能够预测出真正想要的目标值或与真正想要的目标值非常接近的值。因此,就需要预先定义“如何比较预测值和目标值之间的差异”,这便是损失函数(loss function)或目标函数(objective function),它们是用于衡量预测值和目标值的差异的重要方程。其中,以损失函数举例,损失函数的输出值(loss)越高表示差异越大,那么深度神经网络的训练就变成了尽可能缩小这个loss的过程。

[0285]

(4)反向传播算法

[0286]

可以采用误差反向传播(back propagation,bp)算法在训练过程中修正初始模型中参数的大小,使得模型的误差损失越来越小。具体地,前向传递输入信号直至输出会产生误差损失,通过反向传播误差损失信息来更新初始模型中的参数,从而使误差损失收敛。反向传播算法是以误差损失为主导的反向传播运动,旨在得到最优的模型参数,例如权重矩阵。

[0287]

(5)声纹

[0288]

是由波长、频率以及强度等百余种特征维度组成的生物特征。人类语言的产生是人体语言中枢与发音器官之间一个复杂的生理物理过程,由于不同人的发声器官在大小、形态和功能上都存在差异,所以任意两个人的声纹图谱都会有差异。声纹既具有特定性、相对稳定性、又有变异性的特点。声纹的特定性是指不同人的声纹不同,即使讲话者是故意模仿他人声音和语气,还是耳语轻声讲话,即使模仿得惟妙惟肖,其声纹却始终不相同。声纹的相对稳定性是指成年以后,人的声纹可以保持长期相对稳定不变。声纹的变异性可能来自生理、病理、心理、模拟、伪装,也与环境干扰等因素有关。由于每个人的发音器官都不完全相同,基于声纹特定性和相对稳定性的特点,可以通过声纹对不同人的声音进行区分。

[0289]

(6)声纹识别

[0290]

是生物识别技术的一种,可以从说话人发出的语音信号中提取声纹特征进行身份辨识。即声纹识别也可称为说话人识别,包括说话人辨认和说话人确认两种。其中,说话人辨认是用于判断某段语音是多个人中的哪个人所说;而说话人确认是用于确认某段语音是否是指定的某个人所说的。可选的,可以采用深度学习算法提取说话人的声纹特征。例如,采用经典的深度神经网络的说话人识别系统以及基于端到端深度神经网络的说话人特征提取系统,提取说话人的声纹特征。

[0291]

示例性的,电子设备在进行声纹识别前,可以先进行声纹注册。声纹注册即,用户通过电子设备的拾音设备(比如,麦克风)录入一段语音,比如,可以称为注册语音;设备提取该注册语音的声纹特征;并建立和保存该声纹特征与录入语音的用户的对应关系。本技术实施例中,进行了声纹注册的用户可以称为已注册用户。可以理解的,上述声纹注册可以是进行与用户录入语音的内容无关的声纹注册,即电子设备可以从用户录入的语音中提取声纹特征进行注册。本技术实施例对于从音频数据中提取声纹特征的具体方法并不进行限

定。

[0292]

示例性的,电子设备可以支持多个用户的声纹注册。比如,多个用户分别通过电子设备的拾音设备录入一段语音。示例性的,用户1录入语音1,用户2录入语音2,用户3录入语音3。电子设备分别提取各段语音(语音1、语音2和语音3)的声纹特征。进一步的,电子设备建立和保存语音1的声纹特征与用户1的对应关系,建立和保存语音2的声纹特征与用户2的对应关系,建立和保存语音3的声纹特征与用户3的对应关系。这样,电子设备保存了多个用户与该用户的注册语音提取的声纹特征的对应关系,这些用户即为该电子设备上的已注册用户。

[0293]

示例性的,电子设备采集到音频数据后,可以进行声纹识别。比如,电子设备接收到音频数据后,可以提取该音频数据中的声纹特征;电子设备还可以获取各个注册用户的注册语音的声纹特征;电子设备将接收到的用户语音的声纹特征分别与各个注册用户的注册语音的声纹特征进行比较,获取接收到的用户语音的声纹特征分别与各个注册用户的注册语音的声纹特征是否匹配。

[0294]

可选的,已注册声纹的多个用户的权限可以不同。例如,根据用户注册声纹的方式的不同,其使用权限可以不同。如果已注册的声纹为用户主动注册的,那么该用户的权限较高。如果已注册的声纹为通过自适应学习注册的,那么该用户的权限较低,不能使用该保密性的功能。该已注册声纹的用户权限也可以是用户预先设置的,本技术实施例对此并不进行限定。

[0295]

(7)音频增强

[0296]

也可以称之为语音增强,音频增强技术是指在复杂的声音环境下,从包含噪声的音频数据中,提取有用的语音信号,抑制并降低噪声干扰的技术。即从含噪语音中提取尽可能纯净的原始语音。

[0297]

参照图4a,图4a为本技术实施例提供的一种音频数据增强方法的实施例示意,本技术实施例提供的一种音频数据增强方法可以应用在上述描述的终端设备或者服务器中,具体的,音频数据增强方法可以应用在手机、平板、笔记本电脑、智能穿戴设备等终端设备上,或者应用在云侧的服务器上,如图4a示出的那样,本技术实施例提供的音频数据增强方法,包括:

[0298]

401、获取音频数据,所述音频数据包含目标用户的语音数据。

[0299]

步骤401的执行主体可以为终端设备,终端设备可以部署有麦克风等音频采集设备,进而音频采集设备可以采集到周围环境中的音频数据,并将采集到的音频数据传输到终端设备的处理器。

[0300]

步骤401的执行主体可以为云侧的服务器,终端设备可以部署有麦克风等音频采集设备,音频采集设备可以采集到周围环境中的音频数据,终端设备可以将音频数据传输至云侧的服务器,进而服务器可以获取到音频数据。

[0301]

其中,音频数据可以为上述描述的场景中即时应用场景中实时采集的音频数据,或者是对录音进行语音后期处理时的音频处理对象。

[0302]

402、基于所述音频数据,获取所述目标用户对应的目标增强模型,其中所述目标增强模型为基于所述目标用户的语音数据预先进行模型训练得到的;

[0303]

步骤402的执行主体可以为终端设备,终端设备的处理器可以基于所述音频数据

包含目标用户的语音,获取所述目标用户对应的目标增强模型,在一种实现中,终端设备将音频数据传递至服务器,服务器可以确定所述音频数据包含目标用户的语音,并将所述音频数据包含目标用户的语音的指示信息和音频数据传递至终端设备,进而终端设备可以基于所述音频数据包含目标用户的语音,获取所述目标用户对应的目标增强模型。

[0304]

步骤402的执行主体也可以为云侧的服务器,服务器可以基于所述音频数据包含目标用户的语音,获取所述目标用户对应的目标增强模型,在一种实现中,终端设备可以确定所述音频数据包含目标用户的语音,并将所述音频数据包含目标用户的语音的指示信息和音频数据传递至服务器,进而服务器可以基于所述音频数据包含目标用户的语音,获取所述目标用户对应的目标增强模型。

[0305]

应理解,目标用户可以为任一用户,本技术并不限定目标用户的具体用户身份。

[0306]

在一种可能的实现中,可以基于目标用户的语音数据单独训练了一个针对于目标用户的语音增强模型(也就是本实施例中的目标增强模型),在对包含目标用户的语音的音频数据进行音频增强时,该模型具备很高的音频增强性能。

[0307]

接下来描述目标增强模型的网络结构以及目标增强模型的训练方式,也就是如何获取和构建训练样本,以及如何基于构建的训练样本对初始化模型(例如本技术实施例描述的第一增强网络)进行训练,以使得训练后的模型(例如本技术实施例中的目标增强网络)具备上述性能:

[0308]

首先介绍目标增强模型的网络结构:

[0309]

在一种可能的实现中,目标增强模型可以为包含长短期记忆神经网络(long short

‑

term memory,lstm),transformer、dnn、cnn或任何非线性一层或多层的神经网络中的在至少一种的混合网络。

[0310]

目标增强模型可以实现多个应用场景的功能,例如正在进行网上会议的时候,当应用场景为即时语音时,需要保证目标增强模型的时延低(也就是处理数据所需的时间少),因此目标增强模型可以支持在线流式处理的算法(本技术实施例中也可以称之为在线增强模式)。在网上会议结束后,在对录音进行离线处理时(例如进行会议分析时),需要保证目标增强模型的处理精度高(也就是音频增强效果好),而不需要保证低时延,且时延和音频增强效果在技术上是一对相互矛盾的实现,因此目标增强模型可以支持离线流式处理的算法(本技术实施例中也可以称之为离线增强模式),进而基于增强后的音频数据可以提供一个清晰准确的会议语音或文本记录。

[0311]

由上可知,可以将目标增强模型的网络结构设计为同时容许在线增强模式和离线增强模式,可基于实际的应用场景选择适合的模式。其中在线增强模式可提供即时短时延的语音增强,离线增强模式则可提供增强效果较好但时延长的增强。

[0312]

具体的,所述目标增强模型可以包括第一增强模型分支和第二增强模型分支,所述第一增强模型分支针对于相同音频数据的处理时间低于所述第二增强模型分支,且所述第一增强模型分支的音频增强效果低于所述第二增强分支的音频增强效果,在进行模型推理时,可以获取当前的应用场景,并基于所述应用场景包括实时语音通话(或者其他要求低时延的应用场景),可以通过所述第一增强模型分支,对所述音频数据进行增强处理,基于所述应用场景包括语音后期处理(或者其他不要求低时延,而要求音频增强效果好的应用场景),可以通过所述第二增强模型分支,对所述音频数据进行增强处理。

[0313]

例如,参照图4b,图4b为一种目标增强网络的结构示意,如图4b所示,左侧的支路可以为上述第二增强模型分支,右侧的支路可以为上述第一增强模型分支,且第一增强模型分支和第二增强模型分支之间可以存在数据的交错传递。此外,不同的语音任务对增强需求的不同,例如如果下游任务目标是提高聆听清晰度,则需要尽量去除背景噪声,但过度去除背景噪声,则会导致目标语音频谱损伤(over

‑

suppression),导致语音的文字识别、说话人标记或自动会议分析等下游任务性能下降。

[0314]

应理解,图4b中示出的目标增强网络包括多个渐进频谱比例遮罩(progressive ratio mask,prm),prm可以用于屏蔽非目标说话人语音的频谱。

[0315]

在一种可能的实现中,所述目标增强模型可以包括多个串行的网络层,所述多个串行的网络层包括第一网络层和第二网络层,所述第二网络层距离所述目标增强模型的输出网络层的距离小于所述第一网络层距离所述目标增强模型的输出网络层的距离,在进行模型的推理时,可以根据所述目标增强模型,对所述音频数据进行增强处理,并将所述第一网络层的网络输出作为所述增强后的音频数据,根据所述增强后的音频数据进行语音的文本识别;或者,根据所述目标增强模型,对所述音频数据进行增强处理,并将所述第二网络层的网络输出作为所述增强后的音频数据,向目标终端传递所述增强后的音频数据,或者在本地保存所述增强后的音频数据。

[0316]

也就是说,针对于即时语音的场景,可以将距离输出网络层较近的网络层的输出作为后续进行语音传输的数据,例如可以直接将输出网络层的输出作为后续进行语音传输的数据,针对于需要进行语音的文本识别的场景,可以将距离输出网络层较远的网络层的输出作为后续进行语音传输的数据。

[0317]

通过上述方式,在终端侧的数据存储量有限的情况下,只需要训练一个模型,就可以适配于多种任务场景的实现,且在同一网络内大部分计算量可以共享,而不需要训练多个模型,每个模型来适配一种任务场景,降低了终端侧的数据存储量。

[0318]

例如,参照图4b,图4b为一种目标增强网络的结构示意,如图4b所示,针对于即时语音的场景,可以将距离输出网络层较近的网络层(例如在线网络层3)的输出作为后续进行语音传输的数据,例如可以直接将输出网络层的输出作为后续进行语音传输的数据,针对于需要进行语音的文本识别的场景,可以将距离输出网络层较远的网络层(例如在线网络层2)的输出作为后续进行语音传输的数据.

[0319]

通过上述方式,以渐进式学习(progressive learning)的方式来提供多个增强程度输出,减低了目标语音频谱损伤(over

‑

suppression)对下游任务的性能影响。

[0320]

以上介绍了目标增强模型的结构,接下来结合训练样本描述针对于目标增强模型的训练方式:

[0321]

为了能够使得目标语音模型针对特定用户的语音可以具有较高的音频增强能力,需要使用特定用户的语音数据来训练语音增强模型,且针对于不同的用户可以分别训练不同的语音增强模型,例如针对于目标用户,可以基于目标用户的语音数据单独训练一个语音增强模型(即本技术实施例中的目标增强模型)。

[0322]

应理解,可以基于m个用户(包括目标用户)的语音数据进行模型训练得到目标增强模型,以使得该目标增强模型针对于m个用户的语音可以具有较高的音频增强能力,为了保证模型的音频增强较高,m的数量可以设置的较小,m可以设置为小于3,例如m可以为1或

者2。

[0323]

在一种可能的实现中,所述m设置为1,也就是仅根据目标用户的语音数据来训练目标增强模型,可以最大化目标增强模型针对于目标用户的音频增强能力。

[0324]

在一种可能的实现中,针对于目标增强模型的训练数据可以包括第一训练数据和第二训练数据,其中,所述第一训练数据为包含所述目标用户的语音数据和噪声数据的训练数据,所述第二训练数据为所述目标用户的语音数据,上述目标用户的语音数据可以为目标用户的干净前景语音,其中,所谓干净前景语音可以理解为语音的信噪比较低。

[0325]

在一种可能的实现中,可以根据所述第一训练数据和所述第二训练数据,获取目标损失,所述目标损失与第一训练数据和第二训练数据之间的差异有关,获取第一增强模型(初始化的目标增强模型),并根据所述目标损失对所述第一增强模型进行训练,以得到所述目标增强模型。

[0326]

在一种可能的实现中,目标增强模型的音频增强性能除了和用户有关,还和环境场景的类型有关,环境场景例如可以包括居家场景、咖啡店场景等,在现有的音频增强方案中,将大量用户在各个环境场景中的语音数据作为训练数据来训练一个普适性的语音增强模型,在推理过程中,通过上述普适性的语音增强模型,对音频数据进行音频增强。训练后的语音增强模型需要具备能够区分人声以及环境噪音的能力,然而,由于不同环境场景中背景噪声的特征不同,由于训练数据有限,并不能使得模型具备识别全部特点类型的背景噪声的能力,因此音频增强的效果较差。

[0327]

本技术实施例中,在网上会议等终端的即时应用场景中,由于环境场景有限,因此,可以针对于有限的环境场景分别训练得到适配于各个环境场景的语音增强模型(例如本技术实施例中的目标增强模型),各个语音增强模型针对于特定环境场景的语音的音频增强性能较好,进而解决了基于普适性的语音增强模型进行音频增强时存在的音频增强效果较差的问题。

[0328]

其中,上述所述噪声数据可以为目标场景中的噪声数据,所述目标场景为音频采集设备在采集所述音频数据时所处的环境场景。

[0329]

在一种可能的实现中,可以通过如下方式构建目标用户在特定环境场景中的语音数据:获取所述第二训练数据,采集环境音频,对所述环境音频进行语音分离处理,以得到所述噪声数据,并将所述所述噪声数据与所述第二训练数据进行融合,以得到所述第一训练数据。也就是说,可以将采集的环境音频进行人声分离,进而可以得到该环境场景中的噪声数据,并通过将分离得到的噪声数据和目标用户的语音进行混合来得到目标用户在特定环境场景中的语音数据。在一种可能的实现中,所述融合包括叠加处理或者混响处理。

[0330]

通过上述方式,在采集的音频数据有限的情况下,可以生成更丰富的训练数据,进而提升模型的性能。

[0331]

在一种可能的实现中,所述音频数据增强方法应用于终端设备,所述目标增强模型为所述终端设备训练得到的,随着端侧设备的容量和算力不断提升,已可应付深度学习模型训练和自适应。端侧收集和存储个人数据于设备,数据不用上传至服务器就可以进行目标增强模型的训练,有效保障用户隐私,且给每个用户可以拥有个人化专属模型,提供个人化的语音增强服务。

[0332]

接下来结合终端设备与用户的交互,描述上述训练数据的采集过程:

[0333]

在一种可能的实现中,在用户授权的前提下,终端设备上的音频采集设备可以采集目标用户的语音数据和背景噪声,可选的,在终端设备的计算资源闲置时,训练语料生成模组可以将收集的录音进行混合,生成训练数据。

[0334]

以网上会议为例,在用户使用终端设备上的网上会议应用来进行即时语音时,终端设备上的音频采集设备处于启动状态,在用户授权网上会议应用可以进行录音的前提下,即使网上会议应用的发言静音生效,仍然随着会议进行录音(也就是采集音频数据),但不会将录音向网络传送,只会进行本机端侧的处理及存储。在发言静音下,通常用户处于不发言的状态,这个时候音频采集设备采集的音频可以标记为背景的噪音数据,而在发言静音关掉时,音频采集设备采集的音频可以标记为包含用户的干净语音(或者称之为前景语音)和背景噪声的数据。可以调用声音状态检测来判断采集的音频是否含有用户的前景语音,并基于识别结果进行语音的混合(混合在本技术实施例中也可以称之为仿真),混合过程例如可以如图4c所示。

[0335]

在用户的授权下,可以自动录取背景噪音和前景说话人语音。系统可以对前景说话人语音进行增强,再提取用户语音特征,并以增强后的用户语音和背景噪声生成模型自适应所需的训练数据,并将生成的训练数据储存在终端设备中,如图4d所示,可以把经过增强的前景语音段落,和背景噪声跟据不同信噪比(signal

‑

to

‑

noise ratio,snr)进行混合,生成训练数据。可选的,混合操作可以包括迭加或者混响,例如可以如图4e所示。

[0336]

在针对于特定用户的增强模型的训练过程中,可以从生成的训练语料中,提取用户语音特征,并基于现有模型,进行自适应训练,生成用户相关的语音增强模型,如图4f所示。在目标函数的构建方式上,可以使用包含用户语音的目标函数,例如使用kld正则化(regularization)函数来限制加权用户无关模型和用户相关模型的误差,对模型中的全部或部份参数进行迭代,例如可以如图4g所示。

[0337]

在针对于特定环境场景的增强模型的训练过程中,终端设备可以询问用户是否授权获得当前地点的定位。例如可以通过网络位址、无线网络名称等位置信息,可以获得当前地点的定位,若用户授权获得当前地点的定位,则可以载入对应当前环境位置的增强模型进行增强,如果没有当前环境位置对应的模型,则可以载入与环境场景无关的个人化增强模型。如果没有环境场景无关的个人化增强模型,则可以载入与用户身份无关的增强模型,若用户不授权获得当前地点的定位,则可以对与环境位置无关的个人化增强模型进行优化,当计算资源许可时,例如但不限于设备充电中或设备闲置时,可以生成训练数据,语音增强模组启动,以离线增强模式增强所收集的用户前景语音数据,并跟据数据收集位置存储数据。而当计算资源许可时,例如但不限于设备充电中或设备闲置时,执行模型训练模组,对各个位置增强模型利用对应的数据进行自适应训练,同时自适应训练一个与环境位置无关的个人化增强模型。

[0338]

通过上述方式,可以训练得到目标增强模型。

[0339]

接下来描述目标增强模型的推理过程:

[0340]

参照图4h,图4h为一种目标增强模型的推理过程示意,其中,终端设备可以存储有个人化模型(例如针对于特定用户训练的目标增强模型)以及说话人无关模型(例如普适性的语音增强模型),在即时应用场景中,可以使用目标增强模型中的在线流式解码模式(也就是上述实施例中描述的第一增强分支)进行语音增强,而在非即时应用场景中,可以使用

目标增强模型中的离线流式解码模式(也就是上述实施例中描述的第二增强分支)进行语音增强,针对于说话人无关模型的执行流程可以参照现有技术中关于普适性的语音增强模型的描述,这里不再赘述。

[0341]

在一种可能的实现中,针对于特定用户训练的目标增强模型,在获取到音频数据之后,需要识别出获取到的音频数据包含哪些用户的语音,进而基于识别出的用户来获取该用户所对应的语音增强模型,在一种实现中,可以识别出音频数据包含目标用户的语音,并获取所述目标用户对应的目标增强模山型。

[0342]

接下来描述如何确定音频数据包含目标用户的语音:

[0343]

方式1、声纹识别

[0344]

在一种可能的实现中,可以通过声纹识别来确定音频数据包含哪些用户的语音,具体的,可以通过声纹识别确定所述音频数据包含目标用户的语音,关于声纹识别的具体实现方式可以参照上述实施例中的描述,这里不再赘述。

[0345]

在一种场景中,音频数据中可以包含用户的语音,且所述用户仅包含所述目标用户,也就是在音频数据中仅包含一个正在发声的用户(目标用户)的语音,则可以确定音频数据包含目标用户的语音。

[0346]

在一种场景中,音频数据中可以包括多个用户的语音,例如音频数据中可以包括用户a和用户b的语音,本实施例中可以确定多个用户的语音中能量占比最高的用户为目标用户,其中所谓能量占比可以理解为音量大小、声波复幅值大小等,例如,用户b只是咳嗽了一声,而用户a则是在进行正常的发声,则可以确定用户a为目标用户,进而可以确定音频数据包含目标用户的语音。

[0347]

通过上述方式,可以准确地识别出哪个用户需要进行音频增强,进而在准确的识别出目标用户的基础上,也可以准确获取到目标增强模型,提升了音频增强的效果。

[0348]

方式2、图像识别

[0349]

在一种可能的实现中,终端设备在采集音频数据时,还可以同步采集音频数据所处的环境中的图像,例如在网上会议的场景中,终端设备可以采集到视频数据,该视频数据可以包括图像数据和音频数据,进而可以根据图像识别来确定音频数据包含哪些用户的语音,具体的,可以通过图像识别确定所述音频数据包含目标用户的语音,关于图像识别的具体实现方式可以参照现有技术中的实现,这里不再赘述。

[0350]

在一种场景中,图像数据中可以包含用户,且所述用户仅包含所述目标用户,也就是在图像数据中仅包含一个正在发声的用户(目标用户),则可以确定音频数据包含目标用户的语音,例如可以参照图5,在图5示出的网上会议场景中,图像数据中仅包括左下角示出的唯一一个用户。

[0351]

在一种场景中,图像数据中可以包括多个用户,例如图像数据中可以包括用户a和用户b的语音,本实施例中可以确定图像数据中的像素占比最高的用户为目标用户,例如可以参照图6,在图6示出的网上会议场景中,图像数据中包括左下角示出的两个用户,其中的男士在图像数据中的像素占比高于女士的像素占比,进而可以确定该男士为目标用户。

[0352]

通过上述方式,可以准确地识别出哪个用户需要进行音频增强,进而在准确的识别出目标用户的基础上,也可以准确获取到目标增强模型,提升了音频增强的效果。

[0353]

方式3、基于和用户的操作交互

[0354]

在一种可能的实现中,可以提供至少一个第一选项(例如通过在显示屏上显示的方式向用户提供至少一个第一选项),其中每个第一选项用于指示一个用户,进而可以获取针对于所述至少一个第一选项中第一目标选项的选择操作,所述第一目标选项用于指示所述目标用户。

[0355]

以网上会议为例,参照图7,图7为一种终端界面的示意,其中,图5示出了一种网上会议的界面,在该界面中可以包括设置控件,用户可以通过点击设置控件来触发如图6所示的针对于音频增强功能的配置控件的显示,用户可以通过点击去噪控件来触发音频增强功能的模式选择,例如可以参照图9,图9显示有针对性去噪以及自动去噪两个功能,若用户选择自动去噪,则可以但不限于触发上述普适性的语音增强模型来进行语音增强,若用户选择针对性去噪,则可以显示如图10中示出的关于用户或者场景的选项显示,若用户选择针对于用户,则可以触发显示如图11所示的针对于用户身份的选择选项(例如图11中示出的用户1的选项以及用户2的选项),用户可以选择当前说话的用户。

[0356]

在一种可能的实现中,可以通过识别出所述音频数据包含至少一个用户的语音,来提供所述至少一个用户中每个用户对应的第一选项;或者,通过识别出所述图像数据包含至少一个用户,来提供所述至少一个用户中每个用户对应的第一选项。

[0357]

通过上述方式,可以使能针对于目标用户的选择,进而可以从多个训练好的模型中获取目标用户所对应的模型,应理解,每个训练后的模型可以对应于一个用户,例如可以基于一个指示用户身份的标识来标记对应的模型,在使能针对于目标用户的选择之后,可以从各个模型标记的标识中确定目标用户的标识,并获取标记有目标用户的标识的模型(也就是目标增强模型)。

[0358]

在一种可能的实现中,针对于特定环境场景训练的目标增强模型,在获取到音频数据之后,需要识别出获取到的音频数据为用户在哪个环境场景中发出的语音,进而基于识别出的环境场景来获取该环境场景所对应的语音增强模型,在一种实现中,可以识别出音频采集设备在采集所述音频数据时所处的目标场景,并获取获取所述目标用户以及所述目标场景对应的目标增强模型。

[0359]

接下来描述如何确定所述目标场景:

[0360]

在一种可能的实现中,可以基于终端自身集成的位置传感器或者定位系统来获取位置信息,所述位置信息用于指示所述音频采集设备在采集所述音频数据时所处的位置,所述位置信息用于指示所述目标场景;或者,可以通过和用户的交互来确定目标场景,例如可以显示至少一个第二选项,其中每个第二选项用于指示一个目标场景,进而可以接收到用户针对于所述至少一个第二选项中第二目标选项的选择操作,所述第二目标选项用于指示所述目标场景。

[0361]

以网上会议为例,参照图13,图13为一种终端界面的示意,若用户选择针对性去噪,则可以显示如图13中示出的关于用户或者场景的选项显示,若用户选择针对于场景,则可以触发显示如图13所示的针对于环境场景的选择选项(例如图13中示出的咖啡店的选项以及家里的选项),用户可以选择当前所处的环境场景(也就是上述目标场景)。

[0362]

在一种可能的实现中,还可以对音频数据进行分析,来确定采集音频数据时所处的目标场景,例如可以对音频数据进行人声和环境声的分离处理,并基于环境声确定采集音频数据时所处的目标场景,例如可以基于一个预训练的模型来进行上述目标场景的识

别,或者是基于环境的音频信息特征分析来进行上述目标场景的识别。

[0363]

在一种可能的实现中,可以确定出目标用户,进而可以获取该目标用户对应的目标增强模型。

[0364]

在一种可能的实现中,可以确定出目标场景,进而可以获取该目标场景对应的目标增强模型。

[0365]

在一种可能的实现中,可以确定出目标用户和目标场景,进而可以获取该目标用户和目标场景对应的目标增强模型。

[0366]

应理解,以上是以网上会议的应用场景为例进行的说明,本技术实施例还可以应用在其他即时通话等应用场景中,例如可以应用在支持即时通话的社交应用中(参照图14和图15所示),可以将上述实施例中网上会议相关的界面控件布置类似的嵌入到支持即时通话的社交应用的界面中,相似之处这里不再赘述。

[0367]

通过上述方式,可以使能针对于目标场景的选择,进而可以从多个训练好的模型中获取目标场景所对应的模型,应理解,每个训练后的模型可以对应于一个目标场景,例如可以基于一个指示目标场景的标识来标记对应的模型,在使能针对于目标用户的选择之后,可以从各个模型标记的标识中确定目标场景的标识,并获取标记有目标场景的标识的模型(也就是目标增强模型)。

[0368]

由上可知,不同的语音任务对增强需求的不同,例如如果下游任务目标是提高聆听清晰度,则需要尽量去除背景噪声,但过度去除背景噪声,则会导致目标语音频谱损伤,导致语音的文字识别、说话人标记或自动会议分析等下游任务性能下降,在线字幕以及离线的语音转文本等任务场景中,并不需要很优的语音增强效果,例如可以参照上述实施例中关于目标增强网络中第一网络层和第二网络层相关的实现。

[0369]

以网上会议为例,参照图16,在一种可能的实现中,用户可以在终端启动网上会议系统,若基于当前的任务场景为通话录音(例如即时通话),则可以使用目标增强模型中的在线流式模式来对音频数据进行增强(可以使用语音质素优化设定,也就是增强效果优先的增强模式,例如可以使用上述实施例中的第二网络层的输出作为增强后的音频数据),并将增强后的音频数据传输至网络,而当用户需要启动自动生成字幕的任务时(例如可以通过图17所示的方式开启字幕的任务模式,以得到图18所示的界面,图18示出的界面中,自动字幕的功能处于开启状态),则可以目标增强模型中的在线流式模式来对音频数据进行增强(可以使用语音识别优化设定,也就是不需要很优的增强效果的增强模式,例如可以使用上述实施例中的第一网络层的输出作为增强后的音频数据),并将增强后的音频数据传输至语音识别系统,以得到字幕并显示。

[0370]

由上可知,可以将目标增强模型的网络结构设计为同时容许在线增强模式和离线增强模式,可基于实际的应用场景选择适合的模式。其中在线增强模式可提供即时短时延的语音增强,离线增强模式则可提供增强效果较好但时延长的增强,例如可以参照上述实施例中关于目标增强网络中第一增强模型分支和第二增强模型分支相关的实现。

[0371]

以网上会议为例,参照图19,在一种可能的实现中,用户可以在终端启动网上会议系统,并启动保留会议原始录音的功能(例如可以参照图20),在会议完结后,用户可以触发进行会议录音处理的功能(例如增强功能),系统可以跟据各与会者分别建立音轨,并保存用户不经增强的语音,以及接收和保存其他与会者语音,并跟据当时系统可提供的模型,选

择个人化增强模型或说话人无关增强模型,若用户可选在线增强模式,则预设以优化语音识别为增强目标(例如可以参照图21,用户可以选择生成会议分析的功能),使增强后的语音适合自动会议分析使用,会议分析的结果可以显示在如图22所示的界面中,此外,可选的,若系统对当前用户语音进行增强,也会查检其他与会者语音标记,是否标注已经经过增强,如果其他与会者的语音没有经过增强,则便用说话人无关模型向其他与会者语音进行增强。

[0372]

403、根据所述目标增强模型,对所述音频数据进行增强处理,以得到增强后的音频数据。

[0373]

在获取到目标目标增强模型之后,可以通过目标增强模型,对所述音频数据进行增强处理,以得到增强后的音频数据。

[0374]

在一种实现中,可以将音频数据作为目标增强模型的输入,进而目标增强模型可以输出增强后的音频数据,其中,输入至目标增强模型的数据可以为音频数据本身,或者是对音频数据通过一定数据处理后得到的处理后的音频数据,该数据处理可以为数据预处理,数据预处理可以不改变特征信息的实质内容,例如去冗余、归一化等预处理,该数据处理还可以为特征提取处理,也就是说可以对音频数据进行特征提取,得到处理后的处理后的音频数据(特征向量),进而将特征向量输入至目标增强模型。

[0375]

本技术实施例提供了一种音频数据增强方法,所述方法包括:获取音频数据,所述音频数据包含目标用户的语音;基于所述音频数据,获取所述目标用户对应的目标增强模型,其中所述目标增强模型为基于所述目标用户的语音数据预先进行模型训练得到的;根据所述目标增强模型,对所述音频数据进行增强处理,以得到增强后的音频数据。通过上述方式,基于目标用户的语音数据单独训练了一个针对于目标用户的语音增强模型(也就是本实施例中的目标增强模型),在对包含目标用户的语音的音频数据进行音频增强时,该模型具备很高的音频增强性能,在网上会议等终端的即时应用场景中,由于终端的使用者有限,因此,可以针对于有限的用户分别训练得到适配于各个用户的语音增强模型(例如本技术实施例中的目标增强模型),各个语音增强模型针对于特定用户的语音的音频增强性能较好,进而解决了基于普适性的语音增强模型进行音频增强时存在的音频增强效果较差的问题。

[0376]

参照图23,图23为本技术实施例提供的一种音频数据增强方法的实施例示意,本技术实施例提供的一种音频数据增强方法可以应用在上述描述的终端设备或者服务器中,具体的,音频数据增强方法可以应用在手机、平板、笔记本电脑、智能穿戴设备等终端设备上,或者应用在云侧的服务器上,如图23示出的那样,本技术实施例提供的音频数据增强方法,包括:

[0377]

2301、获取音频数据。

[0378]

步骤2301的执行主体可以为终端设备,终端设备可以部署有麦克风等音频采集设备,进而音频采集设备可以采集到周围环境中的音频数据,并将采集到的音频数据传输到终端设备的处理器。

[0379]

步骤2301的执行主体可以为云侧的服务器,终端设备可以部署有麦克风等音频采集设备,音频采集设备可以采集到周围环境中的音频数据,终端设备可以将音频数据传输至云侧的服务器,进而服务器可以获取到音频数据。

[0380]

其中,音频数据可以为上述描述的场景中即时应用场景中实时采集的音频数据,或者是对录音进行语音后期处理时的音频处理对象。

[0381]

2302、基于音频采集设备在采集所述音频数据时所处的目标场景,获取所述目标场景对应的目标增强模型,其中所述目标增强模型为基于用户在所述目标场景中的语音数据预先训练得到的。

[0382]

在一种可能的实现中,目标增强模型的音频增强性能除了和用户有关,还和环境场景的类型有关,环境场景例如可以包括居家场景、咖啡店场景等,在现有的音频增强方案中,将大量用户在各个环境场景中的语音数据作为训练数据来训练一个普适性的语音增强模型,在推理过程中,通过上述普适性的语音增强模型,对音频数据进行音频增强。训练后的语音增强模型需要具备能够区分人声以及环境噪音的能力,然而,由于不同环境场景中背景噪声的特征不同,由于训练数据有限,并不能使得模型具备识别全部特点类型的背景噪声的能力,因此音频增强的效果较差。

[0383]

本技术实施例中,在网上会议等终端的即时应用场景中,由于环境场景有限,因此,可以针对于有限的环境场景分别训练得到适配于各个环境场景的语音增强模型(例如本技术实施例中的目标增强模型),各个语音增强模型针对于特定环境场景的语音的音频增强性能较好,进而解决了基于普适性的语音增强模型进行音频增强时存在的音频增强效果较差的问题。

[0384]

其中,上述所述噪声数据可以为目标场景中的噪声数据,所述目标场景为音频采集设备在采集所述音频数据时所处的环境场景。

[0385]

接下来描述如何确定所述目标场景:

[0386]

在一种可能的实现中,可以基于终端自身集成的位置传感器或者定位系统来获取位置信息,所述位置信息用于指示所述音频采集设备在采集所述音频数据时所处的位置,所述位置信息用于指示所述目标场景;或者,可以通过和用户的交互来确定目标场景,例如可以显示至少一个第二选项,其中每个第二选项用于指示一个目标场景,进而可以接收到用户针对于所述至少一个第二选项中第二目标选项的选择操作,所述第二目标选项用于指示所述目标场景。

[0387]

以网上会议为例,参照图13,图13为一种终端界面的示意,若用户选择针对性去噪,则可以显示如图13中示出的关于用户或者场景的选项显示,若用户选择针对于场景,则可以触发显示如图13所示的针对于环境场景的选择选项(例如图13中示出的咖啡店的选项以及家里的选项),用户可以选择当前所处的环境场景(也就是上述目标场景)。

[0388]

在一种可能的实现中,还可以对音频数据进行分析,来确定采集音频数据时所处的目标场景,例如可以对音频数据进行人声和环境声的分离处理,并基于环境声确定采集音频数据时所处的目标场景,例如可以基于一个预训练的模型来进行上述目标场景的识别,或者是基于环境的音频信息特征分析来进行上述目标场景的识别。

[0389]

在一种可能的实现中,可以确定出目标用户,进而可以获取该目标用户对应的目标增强模型。

[0390]

在一种可能的实现中,可以确定出目标场景,进而可以获取该目标场景对应的目标增强模型。

[0391]

在一种可能的实现中,可以确定出目标用户和目标场景,进而可以获取该目标用

户和目标场景对应的目标增强模型。

[0392]

应理解,以上是以网上会议的应用场景为例进行的说明,本技术实施例还可以应用在其他即时通话等应用场景中,例如可以应用在支持即时通话的社交应用中(参照图14和图15所示),可以将上述实施例中网上会议相关的界面控件布置类似的嵌入到支持即时通话的社交应用的界面中,相似之处这里不再赘述。

[0393]

通过上述方式,可以使能针对于目标场景的选择,进而可以从多个训练好的模型中获取目标场景所对应的模型,应理解,每个训练后的模型可以对应于一个目标场景,例如可以基于一个指示目标场景的标识来标记对应的模型,在使能针对于目标用户的选择之后,可以从各个模型标记的标识中确定目标场景的标识,并获取标记有目标场景的标识的模型(也就是目标增强模型)。

[0394]

在一种可能的实现中,可以通过如下方式构建目标用户在特定环境场景中的语音数据:获取所述第二训练数据,采集环境音频,对所述环境音频进行语音分离处理,以得到所述噪声数据,并将所述所述噪声数据与所述第二训练数据进行融合,以得到所述第一训练数据。也就是说,可以将采集的环境音频进行人声分离,进而可以得到该环境场景中的噪声数据,并通过将分离得到的噪声数据和目标用户的语音进行混合来得到目标用户在特定环境场景中的语音数据。在一种可能的实现中,所述融合包括叠加处理或者混响处理。

[0395]

通过上述方式,在采集的音频数据有限的情况下,可以生成更丰富的训练数据,进而提升模型的性能。

[0396]

在一种可能的实现中,所述音频数据增强方法应用于终端设备,所述目标增强模型为所述终端设备训练得到的,随着端侧设备的容量和算力不断提升,已可应付深度学习模型训练和自适应。端侧收集和存储个人数据于设备,数据不用上传至服务器就可以进行目标增强模型的训练,有效保障用户隐私,且给每个用户可以拥有个人化专属模型,提供个人化的语音增强服务。

[0397]

2303、根据所述目标增强模型,对所述音频数据进行增强处理,以得到增强后的音频数据。

[0398]

步骤2303的具体描述可以参照上述实施例中步骤403的描述,这里不再赘述。

[0399]

在一种可能的实现中,目标增强模型的音频增强性能除了和用户有关,还和环境场景的类型有关,环境场景例如可以包括居家场景、咖啡店场景等,在现有的音频增强方案中,将大量用户在各个环境场景中的语音数据作为训练数据来训练一个普适性的语音增强模型,在推理过程中,通过上述普适性的语音增强模型,对音频数据进行音频增强。训练后的语音增强模型需要具备能够区分人声以及环境噪音的能力,然而,由于不同环境场景中背景噪声的特征不同,由于训练数据有限,并不能使得模型具备识别全部特点类型的背景噪声的能力,因此音频增强的效果较差。

[0400]

本技术实施例中,在网上会议等终端的即时应用场景中,由于环境场景有限,因此,可以针对于有限的环境场景分别训练得到适配于各个环境场景的语音增强模型(例如本技术实施例中的目标增强模型),各个语音增强模型针对于特定环境场景的语音的音频增强性能较好,进而解决了基于普适性的语音增强模型进行音频增强时存在的音频增强效果较差的问题。

[0401]

在一种可能的实现中,所述方法还包括:

[0402]

获取环境信息,所述环境信息用于指示音频采集设备在采集所述音频数据时所处的目标场景。

[0403]

在一种可能的实现中,所述获取环境信息,包括:

[0404]

获取位置信息,所述位置信息用于指示所述音频采集设备在采集所述音频数据时所处的位置,所述位置信息用于指示所述目标场景;或者,

[0405]

提供至少一个第二选项,其中每个第二选项用于指示一个目标场景;

[0406]

获取针对于第二目标选项的选择操作,所述第二目标选项为所述至少一个第二选项中的一个,所述第二目标选项用于指示所述目标场景。

[0407]

在一种可能的实现中,所述目标增强模型包括第一增强模型分支和第二增强模型分支,所述第一增强模型分支针对于相同音频数据的处理时间低于所述第二增强模型分支,且所述第一增强模型分支的音频增强效果低于所述第二增强分支的音频增强效果,所述根据所述目标增强模型,对所述音频数据进行增强处理,包括:

[0408]

获取所述音频数据的应用场景;

[0409]

在所述应用场景为实时语音通话场景的情况下,通过所述第一增强模型分支,对所述音频数据进行增强处理;或者,

[0410]

在所述应用场景为语音后期处理场景的情况下,通过所述第二增强模型分支,对所述音频数据进行增强处理。

[0411]

在一种可能的实现中,所述目标增强模型包括多个串行的网络层,所述多个串行的网络层包括第一网络层和第二网络层,所述第二网络层距离所述目标增强模型的输出网络层的距离小于所述第一网络层距离所述目标增强模型的输出网络层的距离,所述根据所述目标增强模型,对所述音频数据进行增强处理,以得到增强后的音频数据,包括:

[0412]

根据所述目标增强模型,对所述音频数据进行增强处理,并将所述第一网络层的输出作为所述增强后的音频数据,所述增强后的音频数据用于文本识别;或者,

[0413]

根据所述目标增强模型,对所述音频数据进行增强处理,并将所述第二网络层的输出作为所述增强后的音频数据,向目标终端传递所述增强后的音频数据,或者在本地保存所述增强后的音频数据。

[0414]

在一种可能的实现中,所述音频数据增强方法应用于终端设备,和/或,所述目标增强模型为所述终端设备训练得到的。

[0415]

在一种可能的实现中,所述目标增强模型为基于所述语音数据进行模型训练得到的,包括:

[0416]

所述目标增强模型为基于m个用户的语音数据进行模型训练得到的,所述m个用户包括所述目标用户,且所述m等于1或者所述m等于2。

[0417]

在一种可能的实现中,所述m为1。

[0418]

在一种可能的实现中,所述目标增强模型为基于所述语音数据进行模型训练得到的,包括:

[0419]

所述目标增强模型为基于目标损失预先进行模型训练得到的,所述目标损失与第一训练数据和第二训练数据之间的差异有关,所述第一训练数据为包含所述目标用户的语音数据和噪声数据的训练数据,所述第二训练数据为所述目标用户的语音数据。

[0420]

在一种可能的实现中,所述方法还包括:

[0421]

获取第一训练数据和第二训练数据;

[0422]

根据所述第一训练数据和所述第二训练数据,获取目标损失,所述目标损失与第一训练数据和第二训练数据之间的差异有关;

[0423]

获取第一增强模型,并根据所述目标损失对所述第一增强模型进行训练,以得到所述目标增强模型。

[0424]

在一种可能的实现中,所述获取第一训练数据和第二训练数据,包括:

[0425]

获取所述第二训练数据;

[0426]

采集环境音频;

[0427]

对所述环境音频进行语音分离处理,以得到所述噪声数据;

[0428]

将所述所述噪声数据与所述第二训练数据进行融合,以得到所述第一训练数据。

[0429]

在一种可能的实现中,所述融合包括叠加处理或者混响处理。

[0430]

在图1至图23所对应的实施例的基础上,为了更好的实施本技术实施例的上述方案,下面还提供用于实施上述方案的相关设备。具体参阅图24,图24为本技术实施例提供的音频数据增强装置2400的一种结构示意图,音频数据增强装置2400可以是终端设备或服务器,音频数据增强装置2400可以包括:

[0431]

获取单元2401,用于获取音频数据,所述音频数据包含目标用户的语音数据;基于所述音频数据,从多个增强模型中获取所述目标用户对应的目标增强模型,其中每个增强模型对应一个用户,所述每个增强模型为基于对应的用户的语音数据进行模型训练得到的;

[0432]

关于获取单元2401的具体描述可以参照上述实施例中步骤401和步骤402的描述,这里不再赘述。

[0433]

音频增强单元2402,用于根据所述获取单元获取的所述目标增强模型,对所述音频数据进行增强处理,以得到增强后的音频数据。

[0434]

关于音频增强单元2402的具体描述可以参照上述实施例中步骤403的描述,这里不再赘述。

[0435]

本技术实施例提供了一种音频数据增强装置,包括获取单元2401,用于获取音频数据,所述音频数据包含目标用户的语音数据;基于所述音频数据,从多个增强模型中获取所述目标用户对应的目标增强模型,其中每个增强模型对应一个用户,所述每个增强模型为基于对应的用户的语音数据进行模型训练得到的;音频增强单元2402,用于根据所述获取单元获取的所述目标增强模型,对所述音频数据进行增强处理,以得到增强后的音频数据。其中,基于目标用户的语音数据单独训练了一个针对于目标用户的语音增强模型(也就是本实施例中的目标增强模型),在对包含目标用户的语音的音频数据进行音频增强时,该模型具备很高的音频增强性能,在网上会议等终端的即时语音场景中,由于终端的使用者有限,因此,可以针对于有限的用户分别训练得到适配于各个用户的语音增强模型(例如本技术实施例中的目标增强模型),各个语音增强模型针对于特定用户的语音的音频增强性能较好,进而解决了基于普适性的语音增强模型进行音频增强时存在的音频增强效果较差的问题。

[0436]

在一种可能的实现中,所述音频数据包含目标用户的语音,包括:

[0437]

所述音频数据包含用户的语音,且所述用户仅包含所述目标用户;或者,

[0438]

所述音频数据包含用户的语音,所述用户包含所述目标用户和第一用户,且所述目标用户的语音在所述音频数据中的能量占比高于所述第一用户的语音在所述音频数据中的能量占比。

[0439]

在一种场景中,音频数据中可以包含用户的语音,且所述用户仅包含所述目标用户,也就是在音频数据中仅包含一个正在发声的用户(目标用户)的语音,则可以确定音频数据包含目标用户的语音。

[0440]

在一种场景中,音频数据中可以包括多个用户的语音,例如音频数据中可以包括用户a和用户b的语音,本实施例中可以确定多个用户的语音中能量占比最高的用户为目标用户,其中所谓能量占比可以理解为音量大小、声波复幅值大小等,该能量占比可以是实时确定的各个时刻的能量占比,或者是一段时间内的能量占比,例如,用户b只是咳嗽了一声,而用户a则是在进行正常的发声,则a用户的语音在音频数据中的能量占比大于b用户的语音在音频数据中的能量占比,进而可以确定用户a为目标用户。

[0441]

通过上述方式,可以准确地识别出哪个用户需要进行音频增强,进而在准确的识别出目标用户的基础上,也可以准确获取到目标增强模型,提升了音频增强的效果。

[0442]

在一种可能的实现中,所述获取单元2401,具体用于:

[0443]

获取视频数据,所述视频数据包括图像数据以及所述音频数据;

[0444]

其中,所述图像数据中的用户仅包括所述目标用户;或者,

[0445]

所述图像数据中的用户包含所述目标用户和第二用户,且所述目标用户在所述图像数据中的像素占比高于所述第二用户在所述图像数据中的像素占比。

[0446]

在一种可能的实现中,终端设备在采集音频数据时,还可以同步采集音频数据所处的环境中的图像,例如在网上会议的场景中,终端设备可以采集到视频数据,该视频数据可以包括图像数据和音频数据,进而可以根据图像识别来确定音频数据包含哪些用户的语音,且,当用户在图像中的面积占比(也就是像素占比)越大,则可以表示该用户为主要发声者,或者是距离麦克风阵列最近的用户,对该用户进行音频增强的必要性最大,因此可以将在图像中像素占比最大的用户作为音频增强的对象,从多个增强模型中,获取该目标用户对应的目标增强模型。通过上述方式,可以准确地识别出哪个用户需要进行音频增强,进而在准确的识别出目标用户的基础上,也可以准确获取到目标增强模型,提升了音频增强的效果。

[0447]

在一种可能的实现中,所述装置还包括:

[0448]

选项提供单元2403,用于在所述获取所述目标用户对应的目标增强模型之前,提供至少一个第一选项,其中每个第一选项用于指示一个用户;

[0449]

所述获取单元2401,还用于获取针对于第一目标选项的选择操作,所述第一目标选项为所述至少一个第一选项中的一个,所述第一目标选项用于指示所述目标用户。

[0450]

在一种可能的实现中,所述选项提供单元2403,具体用于:

[0451]

基于所述音频数据包含至少一个用户的语音,提供所述至少一个用户中每个用户对应的第一选项;或者,

[0452]

获取视频数据,所述视频数据包括图像数据以及所述音频数据;

[0453]

基于所述图像数据包含至少一个用户,提供所述至少一个用户中每个用户对应的第一选项。

[0454]

在一种可能的实现中,所述获取单元2401,还用于:

[0455]

获取环境信息,所述环境信息用于指示音频采集设备在采集所述音频数据时所处的目标场景;

[0456]

所述获取单元2401,具体用于:

[0457]

获取所述目标用户以及所述目标场景对应的目标增强模型,其中所述目标增强模型为基于所述目标用户在所述目标场景中的语音数据预先进行模型训练得到的。

[0458]

在一种可能的实现中,所述获取单元2401,具体用于:

[0459]

获取位置信息,所述位置信息用于指示所述音频采集设备在采集所述音频数据时所处的位置,所述位置信息用于指示所述目标场景;或者,

[0460]

提供至少一个第二选项,其中每个第二选项用于指示一个目标场景;

[0461]

获取针对于第二目标选项的选择操作,所述第二目标选项为所述至少一个第二选项中的一个,所述第二目标选项用于指示所述目标场景。

[0462]

在一种可能的实现中,所述目标增强模型包括第一增强模型分支和第二增强模型分支,所述第一增强模型分支针对于相同音频数据的处理时间低于所述第二增强模型分支,且所述第一增强模型分支的音频增强效果低于所述第二增强分支的音频增强效果,所述音频增强单元2402,具体用于:

[0463]

获取所述音频数据的应用场景;

[0464]

在所述应用场景为实时语音通话场景的情况下,通过所述第一增强模型分支,对所述音频数据进行增强处理;或者,

[0465]

在所述应用场景为语音后期处理场景的情况下,通过所述第二增强模型分支,对所述音频数据进行增强处理。

[0466]

在一种可能的实现中,所述目标增强模型包括多个串行的网络层,所述多个串行的网络层包括第一网络层和第二网络层,所述第二网络层距离所述目标增强模型的输出网络层的距离小于所述第一网络层距离所述目标增强模型的输出网络层的距离,所述音频增强单元2402,具体用于:

[0467]

根据所述目标增强模型,对所述音频数据进行增强处理,并将所述第一网络层的输出作为所述增强后的音频数据,所述增强后的音频数据用于文本识别;或者,

[0468]

根据所述目标增强模型,对所述音频数据进行增强处理,并将所述第二网络层的输出作为所述增强后的音频数据,向目标终端传递所述增强后的音频数据,或者在本地保存所述增强后的音频数据。

[0469]

在一种可能的实现中,所述音频数据增强装置应用于终端设备,和/或,所述目标增强模型为所述终端设备训练得到的。

[0470]

在一种可能的实现中,所述目标增强模型为基于所述语音数据进行模型训练得到的,包括:

[0471]

所述目标增强模型为基于m个用户的语音数据预先进行模型训练得到的,所述m个用户包括所述目标用户,且所述m等于1或者所述m等于2。

[0472]

在一种可能的实现中,所述m为1。

[0473]

在一种可能的实现中,所述目标增强模型为基于所述语音数据预先进行模型训练得到的,包括:

[0474]

所述目标增强模型为基于目标损失预先进行模型训练得到的,所述目标损失与第一训练数据和第二训练数据之间的差异有关,所述第一训练数据为包含所述目标用户的语音数据和噪声数据的训练数据,所述第二训练数据为所述目标用户的语音数据。

[0475]

在一种可能的实现中,所述获取单元2401,还用于:

[0476]

获取第一训练数据和第二训练数据,所述第一训练数据为包含所述目标用户的语音数据和噪声数据的训练数据,所述第二训练数据为所述目标用户的语音数据;

[0477]

根据所述第一训练数据和所述第二训练数据,获取目标损失,所述目标损失与第一训练数据和第二训练数据之间的差异有关;

[0478]

获取第一增强模型,并根据所述目标损失对所述第一增强模型进行训练,以得到所述目标增强模型。

[0479]

在一种可能的实现中,所述噪声数据为目标场景中的噪声数据,所述目标场景为音频采集设备在采集所述音频数据时所处的环境场景。

[0480]

在一种可能的实现中,所述获取单元2401,具体用于:

[0481]

获取所述第二训练数据;

[0482]

采集环境音频;

[0483]

对所述环境音频进行语音分离处理,以得到所述噪声数据;

[0484]

将所述所述噪声数据与所述第二训练数据进行融合,以得到所述第一训练数据。

[0485]

在一种可能的实现中,所述融合包括叠加处理或者混响处理。

[0486]

参阅图25,图25为本技术实施例提供的音频数据增强装置2500的一种结构示意图,音频数据增强装置2500可以是终端设备或服务器,音频数据增强装置2500可以包括:

[0487]

获取单元2501,用于获取音频数据,以及基于音频采集设备在采集所述音频数据时所处的目标场景,获取所述目标场景对应的目标增强模型,其中所述目标增强模型为基于用户在所述目标场景中的语音数据预先训练得到的;

[0488]

关于获取单元2501的具体描述可以参照上述实施例中步骤2301和步骤2302的描述,这里不再赘述。

[0489]

音频增强单元2502,用于根据所述获取单元获取的所述目标增强模型,对所述音频数据进行增强处理,以得到增强后的音频数据。

[0490]

关于音频增强单元2502的具体描述可以参照上述实施例中步骤2303的描述,这里不再赘述。

[0491]

本技术实施例提供了一种音频数据增强装置的结构示意,包括获取单元2501,用于获取音频数据,以及基于音频采集设备在采集所述音频数据时所处的目标场景,获取所述目标场景对应的目标增强模型,其中所述目标增强模型为基于用户在所述目标场景中的语音数据预先训练得到的;音频增强单元2502,用于根据所述获取单元获取的所述目标增强模型,对所述音频数据进行增强处理,以得到增强后的音频数据。在一种可能的实现中,目标增强模型的音频增强性能除了和用户有关,还和环境场景的类型有关,环境场景例如可以包括居家场景、咖啡店场景等,在现有的音频增强方案中,将大量用户在各个环境场景中的语音数据作为训练数据来训练一个普适性的语音增强模型,在推理过程中,通过上述普适性的语音增强模型,对音频数据进行音频增强。训练后的语音增强模型需要具备能够区分人声以及环境噪音的能力,然而,由于不同环境场景中背景噪声的特征不同,由于训练

数据有限,并不能使得模型具备识别全部特点类型的背景噪声的能力,因此音频增强的效果较差。

[0492]

本技术实施例中,在网上会议等终端的即时应用场景中,由于环境场景有限,因此,可以针对于有限的环境场景分别训练得到适配于各个环境场景的语音增强模型(例如本技术实施例中的目标增强模型),各个语音增强模型针对于特定环境场景的语音的音频增强性能较好,进而解决了基于普适性的语音增强模型进行音频增强时存在的音频增强效果较差的问题。

[0493]

在一种可能的实现中,所述获取单元2501,还用于:

[0494]

获取环境信息,所述环境信息用于指示音频采集设备在采集所述音频数据时所处的目标场景。

[0495]

在一种可能的实现中,所述获取单元2501,具体用于:

[0496]

获取位置信息,所述位置信息用于指示所述音频采集设备在采集所述音频数据时所处的位置,所述位置信息用于指示所述目标场景;或者,

[0497]

提供至少一个第二选项,其中每个第二选项用于指示一个目标场景;

[0498]

获取针对于第二目标选项的选择操作,所述第二目标选项为所述至少一个第二选项中的一个,所述第二目标选项用于指示所述目标场景。

[0499]

在一种可能的实现中,所述目标增强模型包括第一增强模型分支和第二增强模型分支,所述第一增强模型分支针对于相同音频数据的处理时间低于所述第二增强模型分支,且所述第一增强模型分支的音频增强效果低于所述第二增强分支的音频增强效果,所述音频增强单元2502,具体用于:

[0500]

获取所述音频数据的应用场景;

[0501]

在所述应用场景为实时语音通话场景的情况下,通过所述第一增强模型分支,对所述音频数据进行增强处理;或者,

[0502]

在所述应用场景为语音后期处理场景的情况下,通过所述第二增强模型分支,对所述音频数据进行增强处理。

[0503]

在一种可能的实现中,所述目标增强模型包括多个串行的网络层,所述多个串行的网络层包括第一网络层和第二网络层,所述第二网络层距离所述目标增强模型的输出网络层的距离小于所述第一网络层距离所述目标增强模型的输出网络层的距离,所述音频增强单元2502,具体用于:

[0504]

根据所述目标增强模型,对所述音频数据进行增强处理,并将所述第一网络层的输出作为所述增强后的音频数据,所述增强后的音频数据用于文本识别;或者,

[0505]

根据所述目标增强模型,对所述音频数据进行增强处理,并将所述第二网络层的输出作为所述增强后的音频数据,向目标终端传递所述增强后的音频数据,或者在本地保存所述增强后的音频数据。

[0506]

在一种可能的实现中,所述音频数据增强装置应用于终端设备,和/或,所述目标增强模型为所述终端设备训练得到的。

[0507]

在一种可能的实现中,所述目标增强模型为基于所述语音数据进行模型训练得到的,包括:

[0508]

所述目标增强模型为基于m个用户的语音数据进行模型训练得到的,所述m个用户

circuit,asic)、现场可编程门阵列(field

‑

programmable gate array,fpga)或者其他可编程逻辑器件、分立门或者晶体管逻辑器件、分立硬件组件。该处理器2603可以实现或者执行本技术实施例中的公开的各方法、步骤及逻辑框图。通用处理器可以是微处理器或者该处理器也可以是任何常规的处理器等。结合本技术实施例所公开的方法的步骤可以直接体现为硬件译码处理器执行完成,或者用译码处理器中的硬件及软件模块组合执行完成。软件模块可以位于随机存储器,闪存、只读存储器,可编程只读存储器或者电可擦写可编程存储器、寄存器等本领域成熟的存储介质中。该存储介质位于存储器2604,处理器2603读取存储器2604中的信息,结合其硬件完成上述方法的步骤。

[0526]

接收器2601可用于接收输入的数字或字符信息,以及产生与执行设备的相关设置以及功能控制有关的信号输入。发射器2602可用于通过第一接口输出数字或字符信息;发射器2602还可用于通过第一接口向磁盘组发送指令,以修改磁盘组中的数据;发射器2602还可以包括显示屏等显示设备。

[0527]

本技术实施例中,在一种情况下,处理器2603,用于执行图4a、图23对应实施例描述的音频数据增强方法。

[0528]

本技术实施例还提供了一种训练设备,请参阅图27,图27是本技术实施例提供的训练设备一种结构示意图,具体的,训练设备2700由一个或多个服务器实现,训练设备2700可因配置或性能不同而产生比较大的差异,可以包括一个或一个以上中央处理器(central processing units,cpu)2727(例如,一个或一个以上处理器)和存储器2732,一个或一个以上存储应用程序2742或数据2744的存储介质2730(例如一个或一个以上海量存储设备)。其中,存储器2732和存储介质2730可以是短暂存储或持久存储。存储在存储介质2730的程序可以包括一个或一个以上模块(图示没标出),每个模块可以包括对训练设备中的一系列指令操作。更进一步地,中央处理器2727可以设置为与存储介质2730通信,在训练设备2700上执行存储介质2730中的一系列指令操作。

[0529]

训练设备2700还可以包括一个或一个以上电源2726,一个或一个以上有线或无线网络接口2750,一个或一个以上输入输出接口2758;或,一个或一个以上操作系统2741,例如windows servertm,mac os xtm,unixtm,linuxtm,freebsdtm等等。

[0530]

本技术实施例中,中央处理器2727,用于执行上述实施例中与目标增强模型的训练相关的步骤。

[0531]

本技术实施例中还提供一种包括计算机程序产品,当其在计算机上运行时,使得计算机执行如前述执行设备所执行的步骤,或者,使得计算机执行如前述训练设备所执行的步骤。

[0532]

本技术实施例中还提供一种计算机可读存储介质,该计算机可读存储介质中存储有用于进行信号处理的程序,当其在计算机上运行时,使得计算机执行如前述执行设备所执行的步骤,或者,使得计算机执行如前述训练设备所执行的步骤。

[0533]

本技术实施例提供的执行设备、训练设备或终端设备具体可以为芯片,芯片包括:处理单元和通信单元,所述处理单元例如可以是处理器,所述通信单元例如可以是输入/输出接口、管脚或电路等。该处理单元可执行存储单元存储的计算机执行指令,以使执行设备内的芯片执行上述实施例描述的数据处理方法,或者,以使训练设备内的芯片执行上述实施例描述的数据处理方法。可选地,所述存储单元为所述芯片内的存储单元,如寄存器、缓

存等,所述存储单元还可以是所述无线接入设备端内的位于所述芯片外部的存储单元,如只读存储器(read

‑

only memory,rom)或可存储静态信息和指令的其他类型的静态存储设备,随机存取存储器(random access memory,ram)等。

[0534]

具体的,请参阅图28,图28为本技术实施例提供的芯片的一种结构示意图,上述图4a、图23对应的实施例中描述的音频数据增强方法可以在图28所示的芯片中实现。具体的,所述芯片可以表现为神经网络处理器npu 2800,npu 2800作为协处理器挂载到主cpu(host cpu)上,由host cpu分配任务。npu的核心部分为运算电路2803,控制器2804控制运算电路2803提取存储器(权重存储器或输入存储器)中的数据并进行运算。

[0535]

上述图6、图14和图17对应的实施例中描述的数据处理方法可以由图28所示的芯片中的主cpu和npu共同配合完成。

[0536]

在一些实现中,运算电路2803内部包括多个处理单元(process engine,pe)。在一些实现中,运算电路2803是二维脉动阵列。运算电路2803还可以是一维脉动阵列或者能够执行例如乘法和加法这样的数学运算的其它电子线路。在一些实现中,运算电路2803是通用的矩阵处理器。

[0537]

举例来说,假设有输入矩阵a,权重矩阵b,输出矩阵c。运算电路从权重存储器2802中取矩阵b相应的数据,并缓存在运算电路中每一个pe上。运算电路从输入存储器2801中取矩阵a数据与矩阵b进行矩阵运算,得到的矩阵的部分结果或最终结果,保存在累加器(accumulator)2808中。

[0538]

统一存储器2806用于存放输入数据以及输出数据。权重数据直接通过存储单元访问控制器(direct memory access controller,dmac)2805,dmac被搬运到权重存储器2802中。输入数据也通过dmac被搬运到统一存储器2806中。

[0539]

biu为bus interface unit即,总线接口单元2810,用于axi总线与dmac和取指存储器(instruction fetch buffer,ifb)2809的交互。

[0540]

总线接口单元2810(bus interface unit,简称biu),用于取指存储器2809从外部存储器获取指令,还用于存储单元访问控制器2805从外部存储器获取输入矩阵a或者权重矩阵b的原数据。

[0541]

dmac主要用于将外部存储器ddr中的输入数据搬运到统一存储器2806或将权重数据搬运到权重存储器2802中或将输入数据数据搬运到输入存储器2801中。

[0542]

向量计算单元2807包括多个运算处理单元,在需要的情况下,对运算电路的输出做进一步处理,如向量乘,向量加,指数运算,对数运算,大小比较等等。主要用于神经网络中非卷积/全连接层网络计算,如batch normalization(批归一化),像素级求和,对特征平面进行上采样等。

[0543]

在一些实现中,向量计算单元2807能将经处理的输出的向量存储到统一存储器2806。例如,向量计算单元2807可以将线性函数;或,非线性函数应用到运算电路2803的输出,例如对卷积层提取的特征平面进行线性插值,再例如累加值的向量,用以生成激活值。在一些实现中,向量计算单元2807生成归一化的值、像素级求和的值,或二者均有。在一些实现中,处理过的输出的向量能够用作到运算电路2803的激活输入,例如用于在神经网络中的后续层中的使用。

[0544]

控制器2804连接的取指存储器(instruction fetch buffer)2809,用于存储控制

器2804使用的指令;

[0545]

统一存储器2806,输入存储器2801,权重存储器2802以及取指存储器2809均为on

‑

chip存储器。外部存储器私有于该npu硬件架构。

[0546]

其中,上述任一处提到的处理器,可以是一个通用中央处理器,微处理器,asic,或一个或多个用于控制上述程序执行的集成电路。

[0547]

另外需说明的是,以上所描述的装置实施例仅仅是示意性的,其中所述作为分离部件说明的单元可以是或者也可以不是物理上分开的,作为单元显示的部件可以是或者也可以不是物理单元,即可以位于一个地方,或者也可以分布到多个网络单元上。可以根据实际的需要选择其中的部分或者全部模块来实现本实施例方案的目的。另外,本技术提供的装置实施例附图中,模块之间的连接关系表示它们之间具有通信连接,具体可以实现为一条或多条通信总线或信号线。

[0548]

通过以上的实施方式的描述,所属领域的技术人员可以清楚地了解到本技术可借助软件加必需的通用硬件的方式来实现,当然也可以通过专用硬件包括专用集成电路、专用cpu、专用存储器、专用元器件等来实现。一般情况下,凡由计算机程序完成的功能都可以很容易地用相应的硬件来实现,而且,用来实现同一功能的具体硬件结构也可以是多种多样的,例如模拟电路、数字电路或专用电路等。但是,对本技术而言更多情况下软件程序实现是更佳的实施方式。基于这样的理解,本技术的技术方案本质上或者说对现有技术做出贡献的部分可以以软件产品的形式体现出来,该计算机软件产品存储在可读取的存储介质中,如计算机的软盘、u盘、移动硬盘、rom、ram、磁碟或者光盘等,包括若干指令用以使得一台计算机设备(可以是个人计算机,训练设备,或者网络设备等)执行本技术各个实施例所述的方法。

[0549]

在上述实施例中,可以全部或部分地通过软件、硬件、固件或者其任意组合来实现。当使用软件实现时,可以全部或部分地以计算机程序产品的形式实现。

[0550]

所述计算机程序产品包括一个或多个计算机指令。在计算机上加载和执行所述计算机程序指令时,全部或部分地产生按照本技术实施例所述的流程或功能。所述计算机可以是通用计算机、专用计算机、计算机网络、或者其他可编程装置。所述计算机指令可以存储在计算机可读存储介质中,或者从一个计算机可读存储介质向另一计算机可读存储介质传输,例如,所述计算机指令可以从一个网站站点、计算机、训练设备或数据中心通过有线(例如同轴电缆、光纤、数字用户线(dsl))或无线(例如红外、无线、微波等)方式向另一个网站站点、计算机、训练设备或数据中心进行传输。所述计算机可读存储介质可以是计算机能够存储的任何可用介质或者是包含一个或多个可用介质集成的训练设备、数据中心等数据存储设备。所述可用介质可以是磁性介质,(例如,软盘、硬盘、磁带)、光介质(例如,dvd)、或者半导体介质(例如固态硬盘(solid state disk,ssd))等。