1.本发明涉及人工智能领域,尤其涉及一种多智能体自适应采样策略生成方法。

背景技术:

2.强化学习(reinforcement learning,rl),又称再励学习、评价学习或增强学习,是机器学习的范式和方法论之一,用于描述和解决智能体(agent)在与环境的交互过程中通过学习策略以达成回报最大化或实现特定目标的问题。

3.强化学习中很多场景涉及多个智能体的交互,比如多个机器人的控制,语言的交流,多玩家的游戏等等。

4.maddpg为基于深度确定性策略梯度算法的多智能体强化学习框架,可用于多智能体协作策略的自动生成。

5.在多智能体系统中,每个智能体通过与环境进行交互获取奖励值(reward)来学习改善自己的策略,从而获得该环境下最优策略的过程就多智能体强化学习。

6.在单智能体强化学习中,智能体所在的环境是稳定不变的,但是在多智能体强化学习中,环境是复杂的、动态的,因此给学习过程带来很大的困难。

7.维度爆炸:在单体强化学习中,需要存储状态值函数或动作-状态值函数。在多体强化学习中,状态空间变大,联结动作空间(联结动作是指每个智能体当前动作组合而成的多智能体系统当前时刻的动作)随智能体数量指数增长,因此多智能体系统维度非常大,计算复杂。

8.目标奖励确定困难:多智能体系统中每个智能体的任务可能不同,但是彼此之间又相互耦合影响。奖励设计的优劣直接影响学习到的策略的好坏。

9.不稳定性:在多智能体系统中,多个智能体是同时学习的。当同伴的策略改变时,每个智能体自身的最优策略也可能会变化,这将对算法的收敛性带来影响。

10.探索-利用:探索不光要考虑自身对环境的探索,也要对同伴的策略变化进行探索,可能打破同伴策略的平衡状态。每个智能体的探索都可能对同伴智能体的策略产生影响,这将使算法很难稳定,学习速度慢。

技术实现要素:

11.有鉴于现有技术的上述缺陷或不足,本发明的目的是提供一种多智能体自适应采样策略生成方法,能加速maddpg模型的收敛,大大提升智能体学习效率,降低智能体探索时间,提高多智能体协作策略的自动生成效率。

12.为实现上述目的,本发明提供了一种多智能体自适应采样策略生成方法,包括以下步骤:

13.步骤s1:构建智能体的神经网络模型,并初始化多智能体协作的策略网络π、目标策略网络π'、评估网络q、目标评估网络q',及各自的网络参数θ

π

、θ

π'

、θq、θ

q'

;初始化智能体的经验缓存池和动作探索噪声;

14.步骤s2:执行设定次数的回合,每个回合包括以下步骤:

15.步骤s21:初始化环境和所有智能体状态集合;

16.步骤s22:对回合中的每一步,各智能体学习经验,并将各智能体学习的经验保存到各自的经验缓存池中;

17.步骤s23:每执行m步,m为不小于2的整数,对每个智能体,训练各自的神经网络,执行:

18.步骤s23-1:计算当前智能体近m步经验的策略损失loss;

19.步骤s23-2:根据近m步经验的策略损失loss计算当前m步经验的优先级pr(i);

20.步骤s23-3:判断当前m步经验的优先级pr(i)的概率是否满足阈值,满足则抽取minibatch大小的经验;

21.步骤s23-4:根据抽取的minibatch大小的经验,学习策略网络和评估网络;

22.步骤s24:循环执行步骤s22、s23,直至遍历所有经验,输出多智能体协作策略评估结果。

23.进一步的,所述步骤s22具体包括:

24.1)根据当前智能体agenti的观察状态策略网络πi和探索噪声ra选择当前动作

25.2)智能体agenti执行当前动作得到下一个状态和奖励并将经验集合存入经验缓存池ri。

26.进一步的,所述当前动作的公式表示为:

[0027][0028]

其中,表示智能体agenti的策略网络。

[0029]

进一步的,所述步骤s23-1计算当前智能体近m步经验的策略损失loss,包括以下公式:

[0030]

y=r+γq

π'

(s',a1',a'2^a'n)|

ai'=πi'(oi)

[0031]

loss=(y-q

π

(s,a1,a2^an))2[0032]

其中,y表示当前经验中当前动作的期望回报;γ表示奖励折扣系数;r表示目标评估网络的奖励值。

[0033]

进一步的,所述步骤s23-2中:根据近m步经验的策略损失loss计算当前m步经验的优先级pr(i),包括以下公式:

[0034]

p(i)=rank(rank(loss(i))+rank

reverse

(t))

[0035][0036]

其中:p(i)表示当前经验发生的概率,β表示自适应采样的超参数,取值范围为0到1之间,α用于调节优先程度;rank表示对其传入元素进行排序的排位方法;rank

reverse

表示对其传入元素进行排序的倒排位方法;t是对应时间差分误差;loss表示损失函数返回的

值。

[0037]

进一步的,所述步骤s23-4具体包括:

[0038]

(1)计算每个经验动作的期望回报yj:yj=rj+γq'(s

j+1

,a1',a'2^a'n,θ

q'

),其中γ表示奖励折扣系数;rj表示目标评估网络的奖励值;

[0039]

(2)计算最小化损失以更新评估网络参数:其中l表示最小化损失,k表示智能体的数量;

[0040]

(3)通过梯度公式计算策略网络参数的总奖励,更新当前智能体的策略网络参数:其中表示梯度;j表示总奖励;k表示智能体的数量;

[0041]

(4)每执行n步,通过加权因子τ更新所有智能体的目标策略网络和目标评估网络参数:θ

q'

=τθq+(1-τ)θ

q'

,θ

π'

=τθ

π

+(1-τ)θ

π'

。

[0042]

进一步的,所述多智能体自适应采样策略生成方法用于多交通信号机的协作控制,其中,智能体表示为交通信号机;确定性行为策略为交通灯控制策略;策略网络表示为交通信号机每次对交通灯的控制策略,评估网络表示为交通信号机对交通灯的控制策略的评估,所述经验中,当前状态的观测值表示交通信号机观察到的交通环境的实时信息;下一个状态表示交通信号机对交通环境的预测值;动作表示交通信号机的交通控制的动作;奖励表示节省车辆的延误时间。

[0043]

本发明实现了如下技术效果:

[0044]

1.本发明提出的多智能体自适应采样策略生成方法,根据应用环境定义智能体及其策略网络、评估网络和经验,实现多智能体协作策略的自动生成,其采用的et-maddpg算法在maddpg算法的基础上利用经验优先级对经验池经验进行按照优先级概率抽取,加速模型的收敛,大大提升智能体学习效率,降低智能体探索时间,提高多智能体协作的效果评估效率。

[0045]

2.利用经验优先级对经验抽取优势,可获取到对于智能体可以更快学到获取最大奖励的策略,还能通过设定优先级概率阈值限制智能体探索空间,有效避免陷入局部最优。

附图说明

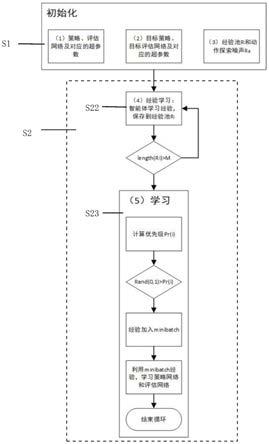

[0046]

图1为本发明实施例给出的算法流程图。

[0047]

图2为采用maddpg算法的实验结果;

[0048]

图3为采用et-maddpg算法的实验结果。

具体实施方式

[0049]

为进一步说明各实施例,本发明提供有附图。这些附图为本发明揭露内容的一部分,其主要用以说明实施例,并可配合说明书的相关描述来解释实施例的运作原理。配合参考这些内容,本领域普通技术人员应能理解其他可能的实施方式以及本发明的优点。

[0050]

现结合附图和具体实施方式对本发明进一步说明。

[0051]

实施例1

[0052]

本发明公开了一种多智能体自适应采样策略生成方法,涉及一种多智能体协作策略自动生成算法,以下简称et-maddpg算法,et-maddpg算法在传统的maddpg算法上进行了优化,包括:首先初始化系统模型,初始化每个智能体的策略网络πi以及目标策略网络π'i和评估网络qi以及目标评估网络qi'以及其网络参数θ

πi

、θ

πi

'、θ

qi

、θ

πi'

,初始化每个智能体的经验缓存池ri和动作探索噪声ra。之后对每个动作回合,初始化所有智能体状态集合s,对回合中每一步(step),对环境中的每个智能体agenti,执行以下步骤:根据当前智能体agenti的观察状态策略网络πi和动作探索噪声ra选择当前动作之后将当前动作作为下一步的状态以及奖励将经验存入经验缓存池ri;每进行m步,对每个智能体agenti,计算当前智能体agenti近m步经验的策略损失,并计算当前经验的优先级pr,并以优先级pr为概率抽取minibatch大小的经验,并通过目标评估网络计算期望回报yj最小化损失更新评估网络参数和策略网络参数;每执行一定步数,更新所有智能体的目标策略和评估网络参数。如图1所示。

[0053]

首先定义系统所需要的输入输出字符的缩写,以便之后叙述:智能体的策略网络πi,目标策略网络πi',评估网络qi,目标评估网络qi',参数θ

πi

和θ

qi

,经验缓存池ri和动作探索噪声ra,所有智能体的状态集合s,经验缓存池ri,经验优先级pr,经验取样次数t,t为经验被取样后进行训练的次数。在本示例中,多智能体自适应采样策略生成方法具体包括:

[0054]

步骤s1:构建智能体的神经网络模型;初始化每个智能体的策略网络πi(o,θ

πi

)和评估网络qi(s,a1,a2^an,θ

qi

)以及策略网络和评估网络的网络参数θ

πi

和θ

qi

;初始化每个智能体的目标策略网络πi'(o,θ

πi'

)和目标评估网络qi'(s,a1,a2^an,θ

qi'

)以及对应的目标策略网络和目标评估网络的网络参数θ

πi'

和θ

qi'

。策略网络和目标策略网络即为maddpg算法中的actor网络和targetactor网络;评估网络和目标评估网络即为maddpg算法中的critic网络和targetcritic网络;初始化每个智能体agenti的经验缓存池ri和动作探索噪声ra。

[0055]

步骤s2:执行设定次数的回合,对每个回合(episode),通过神经网络模型构建和模拟,存储所有智能体的经验,并各智能体的经验添加到各自的经验缓存池中。该算法具体步骤如下:

[0056]

对每一回合(episode),循环操作以下步骤:

[0057]

步骤s21:初始化环境和所有智能体状态集合s;

[0058]

步骤s22:对回合中的每一步(step),对环境中的每个智能体agenti,执行以下步骤:

[0059]

1)根据当前智能体的观察状态策略网络πi和探索噪声ra选择当前动作

[0060]

2)智能体agenti执行当前动作得到下一个状态和奖励并将由当前智能体的观察状态当前动作下一个状态和奖励组成的经验存入经验缓存池ri。

[0061]

步骤s23:每执行m步(即经验池ri已存储近m步的经验),对每个智能体,训练各自

的神经网络:计算当前智能体的近m步经验的策略损失和当前经验优先级,并根据当前经验优先级抽取设定的样本数量(minibatch批大小)的经验作为最终选择的高质量经验;利用抽取的minibatch批大小的高质量经验,通过目标评估网络计算每个经验动作的期望回报,并更新评估网络参数和策略网络参数。在本示例中,步骤s23具体包括:

[0062]

步骤s23-1:每执行m步,对每个智能体,执行以下步骤:

[0063]

根据公式loss=(y-q

π

(s,a1,a2^an))2和y=r+γq

π'

(s',a1',a'2^a'n)|

ai'=πi'(oi)

计算当前智能体近m步经验的策略损失loss,其中y表示期望回报;γ表示奖励折扣系数;rj表示目标评估网络的奖励值。

[0064]

步骤s23-2:根据公式计算当前m步经验的优先级。其中:p(i)表示当前经验发生的概率,β表示自适应采样的超参数,取值范围为0到1之间,α用于调节优先程度;p(i)的计算公式为:p(i)=rank(rank(loss(i))+rank

reverse

(t)),其中rank表示对其传入元素进行排序的排位方法;rank

reverse

表示对其传入元素进行排序的倒排位方法;t是对应时间差分误差;loss表示损失函数返回的值。

[0065]

步骤s23-3:判断当前经验的优先级pr(i)的概率是否满足阈值,满足则抽取设定的样本数量(即minibatch批大小)的经验。该阈值在训练时可通过随机函数rand(0,1)产生,并根据训练评估效果进行调整。参见图1中所示的判断式rand(0,1)>pr(i)。

[0066]

步骤s23-4:利用minibatch经验,学习策略网络和评估网络。

[0067]

在本示例中,步骤s23-4步骤具体包括:

[0068]

(1)计算每个经验动作的期望回报yj:yj=rj+γq'(s

j+1

,a1',a'2^a'n,θ

q'

),其中γ表示奖励折扣系数;rj表示目标评估网络的奖励值;

[0069]

(2)计算最小化损失以更新评估网络参数:其中l表示最小化损失,k表示智能体的数量;

[0070]

(3)通过梯度公式计算策略网络参数的总奖励,更新当前智能体的策略网络参数:其中表示梯度;j表示总奖励;k表示智能体的数量;

[0071]

(4)每执行n步,通过加权因子τ更新所有智能体的目标策略网络和目标评估网络参数:θ

q'

=τθq+(1-τ)θ

q'

,θ

π'

=τθ

π

+(1-τ)θ

π'

。n为正整数,可根据环境变化的快慢更改n值,以调节加权因子τ的更新频率。

[0072]

循环执行步骤s22、s23直至遍历所有智能体的经验,结束循环,然后输出多智能体协作策略协作策略和/或评估结果。

[0073]

实施例2

[0074]

本发明的多智能自适应采样策略生成方法,可适用于智能机器人、交通控制、柔性制造、制造系统的调度等多个领域。

[0075]

在本实施例中,所述多智能体自适应采样策略生成方法用于多交通信号机的协作控制,其中,智能体表示为交通信号机;确定性行为策略为交通灯控制策略;策略网络表示

maddpg算法在maddpg算法的基础上利用经验优先级对经验池经验进行按照优先级概率抽取,加速模型的收敛,大大提升智能体学习效率,降低智能体探索时间。同时,利用经验优先级对经验抽取优势,可获取到对于智能体可以更快学到获取最大奖励的策略,还能通过设定优先级概率阈值限制智能体探索空间,有效避免陷入局部最优。

[0094]

尽管结合优选实施方案具体展示和介绍了本发明,但所属领域的技术人员应该明白,在不脱离所附权利要求书所限定的本发明的精神和范围内,在形式上和细节上可以对本发明做出各种变化,均为本发明的保护范围。