1.本发明涉及语音合成方法,更具体地说是指声码器语音合成方法、装置、计算机设备及存储介质。

背景技术:

2.现在,随着人工智能技术的高速发展,人机交互的对话需求与日俱增,随着神经网络技术的进步,语音合成技术也得到极大的提升,目前,语音合成技术被广泛的应用于智能家居、有声小说、虚拟客服、智能汽车等领域。

3.基于神经网络的语音合成能够实时合成类似人类自然发音的音频,目前,大多数端到端的语音合成包含两个阶段;一是从文本预测音频的中间表示,如mel频谱、线性谱、语音特征等。二是从音频的中间表示推理合成语音音频。第二阶段是将声学模型转换成语音波形的过程,这类模型通常被成为声码器。近年来,神经声码器技术快速发展,声码器限制了最终合成语音的音质,也是整个语音合成模型的计算瓶颈。提升声码器的性能,合成高度自然语音音频仍然是一项极具挑战的任务。但是目前的声码器语音合成方法存在合成音频出现噪声,合成音频的音质较低的问题。

4.因此,有必要设计一种新的方法,实现快速且有效地提高整个生成波形的最终表现,提升语音合成音频的音质。

技术实现要素:

5.本发明的目的在于克服现有技术的缺陷,提供声码器语音合成方法、装置、计算机设备及存储介质。

6.为实现上述目的,本发明采用以下技术方案:声码器语音合成方法,包括:

7.获取待合成文本文件;

8.将所述待合成文本文件输入至声谱预测网络内进行提取声学特征,以得到梅尔频谱;

9.将所述梅尔频谱输入至改进的多尺度hifi

‑

gan声码器模型内进行语音合成,以得到语音音频。

10.其进一步技术方案为:所述声谱预测网络是通过对文本样本数据以及对应的音频样本数据进行预处理后训练深度学习网络得到的。

11.其进一步技术方案为:改进的多尺度hifi

‑

gan声码器模型是通过训练音频数据获取网络模型的参数,形成的语音合成声码器模型;且改进的多尺度hifi

‑

gan声码器模型内的特征匹配损失替换为多尺度短时傅里叶变换。

12.其进一步技术方案为:所述将所述梅尔频谱输入至改进的多尺度hifi

‑

gan声码器模型内进行语音合成,以得到语音音频,包括:

13.改进的多尺度hifi

‑

gan声码器模型采用多频带处理方法,以梅尔频谱作为输入,产生子频带信号,将子频带信号相加作为全频带信号输入到鉴别器中,以进行语音合成。

14.其进一步技术方案为:所述声谱预测网络是通过对文本样本数据以及对应的音频样本数据进行预处理后训练深度学习网络得到的,包括:

15.获取文本样本数据以及对应的音频样本数据;

16.对所述文本样本数据进行剪辑,去除特殊符号,并将阿拉伯数字转为对应的文本单词,将所述文本样本数据内的中文文本数据转成拼音格式或者音素格式,以得到标准格式文本;

17.对所述音频样本数据进行去噪和降噪处理,以得到处理后的音频数据;

18.将标准格式文本以及处理后的音频数据对齐,以得到待训练数据;

19.构建深度学习网络;

20.利用待训练数据对所述深度学习网络进行训练,以确定声谱预测网络。

21.其进一步技术方案为:改进的多尺度hifi

‑

gan声码器模型包括生成器以及鉴别器,并通过多尺度短时傅里叶变换损失、梅尔频谱损失、gan网络损失进行网络的优化。

22.本发明还提供了声码器语音合成装置,包括:

23.文件获取单元,用于获取待合成文本文件;

24.声学特征提取单元,用于将所述待合成文本文件输入至声谱预测网络内进行提取声学特征,以得到梅尔频谱;

25.语音合成单元,用于将所述梅尔频谱输入至改进的多尺度hifi

‑

gan声码器模型内进行语音合成,以得到语音音频。

26.其进一步技术方案为:还包括:

27.预测网络生成单元,用于通过对文本样本数据以及对应的音频样本数据进行预处理后训练深度学习网络得到,以得到声谱预测网络。

28.本发明还提供了一种计算机设备,所述计算机设备包括存储器及处理器,所述存储器上存储有计算机程序,所述处理器执行所述计算机程序时实现上述的方法。

29.本发明还提供了一种存储介质,所述存储介质存储有计算机程序,所述计算机程序被处理器执行时可实现上述的方法。

30.本发明与现有技术相比的有益效果是:本发明通过获取待合成文本文件,借助声谱预测网络提取声学特征,并将提取的内容输入至改进的多尺度hifi

‑

gan声码器模型内进行语音合成,多尺度短时傅里叶变换能够能更有效的测量真实音频和生成音频之间的差异,实现快速且有效地提高整个生成波形的最终表现,提升语音合成音频的音质。

31.下面结合附图和具体实施例对本发明作进一步描述。

附图说明

32.为了更清楚地说明本发明实施例技术方案,下面将对实施例描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

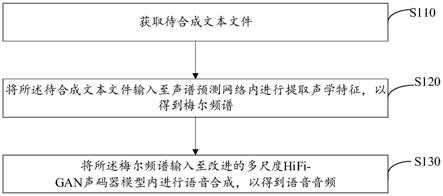

33.图1为本发明实施例提供的声码器语音合成方法的应用场景示意图;

34.图2为本发明实施例提供的声码器语音合成方法的流程示意图;

35.图3为本发明实施例提供的声码器语音合成方法的子流程示意图;

36.图4为本发明实施例提供的声码器语音合成装置的示意性框图;

37.图5为本发明实施例提供的计算机设备的示意性框图。

具体实施方式

38.下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

39.应当理解,当在本说明书和所附权利要求书中使用时,术语“包括”和“包含”指示所描述特征、整体、步骤、操作、元素和/或组件的存在,但并不排除一个或多个其它特征、整体、步骤、操作、元素、组件和/或其集合的存在或添加。

40.还应当理解,在此本发明说明书中所使用的术语仅仅是出于描述特定实施例的目的而并不意在限制本发明。如在本发明说明书和所附权利要求书中所使用的那样,除非上下文清楚地指明其它情况,否则单数形式的“一”、“一个”及“该”意在包括复数形式。

41.还应当进一步理解,在本发明说明书和所附权利要求书中使用的术语“和/或”是指相关联列出的项中的一个或多个的任何组合以及所有可能组合,并且包括这些组合。

42.请参阅图1和图2,图1为本发明实施例提供的声码器语音合成方法的应用场景示意图。图2为本发明实施例提供的声码器语音合成方法的示意性流程图。该声码器语音合成方法应用于服务器中。通过服务器从终端获取待合成文本文件,对待合成文本文件输入至声谱预测网络进行梅尔频谱提取,并将提取的梅尔频谱输入至改进的多尺度hifi

‑

gan声码器模型内进行语音合成,以得到语音音频。

43.图2是本发明实施例提供的声码器语音合成方法的流程示意图。如图2所示,该方法包括以下步骤s110至s130。

44.s110、获取待合成文本文件。

45.在本实施例中,待合成文本文件是指待合成的文本字符。

46.s120、将所述待合成文本文件输入至声谱预测网络内进行提取声学特征,以得到梅尔频谱。

47.在本实施例中,梅尔频谱是指待合成文本文件对应的声学特征。

48.具体地,所述声谱预测网络是通过对文本样本数据以及对应的音频样本数据进行预处理后训练深度学习网络得到的。

49.在一实施例中,请参阅图3,上述的步骤s120可包括步骤s121~s126。

50.s121、获取文本样本数据以及对应的音频样本数据。

51.在本实施例中,文本样本数据是指带有文本格式的数据,音频样本数据是指音频内容。

52.s122、对所述文本样本数据进行剪辑,去除特殊符号,并将阿拉伯数字转为对应的文本单词,将所述文本样本数据内的中文文本数据转成拼音格式或者音素格式,以得到标准格式文本。

53.在本实施例中,标准格式文本是指格式符合要求的文本内容。

54.对于中文文本数据,转为拼音或者音素格式;将音频样本数据进行去重、降噪和剪辑,获取纯净的音频数据用于语音合成模型的训练;对于文本样本数据进行剪辑,去除特殊

符号,并将阿拉伯数字转为对应的文本单词,对于中文文本数据,转成拼音格式或者音素格式。

55.s123、对所述音频样本数据进行去噪和降噪处理,以得到处理后的音频数据。

56.在本实施例中,对音频样本数据进行去噪和降噪处理,去除无意义的音频;获得高音质、低噪声、清晰的音频数据用于声谱预测网络的训练。

57.s124、将标准格式文本以及处理后的音频数据对齐,以得到待训练数据。

58.在本实施例中,待训练数据是指标准格式文本以及处理后的音频数据对齐后形成的数据。

59.s125、构建深度学习网络;

60.s126、利用待训练数据对所述深度学习网络进行训练,以确定声谱预测网络。

61.具体地,将标准格式文本以及处理后的音频数据进行对齐,输入语音合成的声谱预测网络中,生成音频对应的梅尔频谱;将标准格式文本以及处理后的音频数据进行一一对应,每条音频对应唯一一条相应的文本。音频和文本数据输入到语音合成的声谱预测网络中,提取音频的声学特征,对文本进行编码,训练声谱预测网络,得到模型的权重参数,输出对应的声学特征,即梅尔频谱。

62.s130、将所述梅尔频谱输入至改进的多尺度hifi

‑

gan声码器模型内进行语音合成,以得到语音音频。

63.在本实施例中,语音音频是指由待合成文本文件形成的语音内容。

64.具体地,改进的多尺度hifi

‑

gan声码器模型是通过训练音频数据获取网络模型的参数,形成的语音合成声码器模型;且改进的多尺度hifi

‑

gan声码器模型内的特征匹配损失替换为多尺度短时傅里叶变换。

65.在一实施例中,上述的步骤s130可包括以下具体步骤:

66.改进的多尺度hifi

‑

gan声码器模型采用多频带处理方法,以梅尔频谱作为输入,产生子频带信号,将子频带信号相加作为全频带信号输入到鉴别器中,以进行语音合成。

67.其中,改进的多尺度hifi

‑

gan声码器模型包括生成器以及鉴别器,并通过多尺度短时傅里叶变换损失、梅尔频谱损失、gan网络损失进行网络的优化。

68.具体地,训练改进的多尺度hifi

‑

gan声码器模型,获取模型参数,以用于语音合成过程中利用梅尔频谱推理生成语音音频。

69.hifi

‑

gan声码器是一种深度神经网络模型,采用端到端的前向网络结构,训练多尺度的鉴别器,能够实现高效的、高质量的语音合成。hifigan声码器的判别器有两个,分别是多尺度和多周期判别器,从两个不同角度分别鉴定语音;hifi

‑

gan声码器将特征匹配损失作为训练生成器的额外损失,通过提取鉴别器每个中间特征,计算每个特征空间中真实样本和生成样本之间的距离l1。虽然特征匹配损失有助于稳定gan(生成式对抗网络,generative adversarial networks),但是难以测量真假语音潜在特征之间的差异,导致网络收敛过程缓慢。为了解决此问题,将parallel wavegan中的多尺度短时傅里叶变换损失替换hifi

‑

gan声码器中特征匹配损失,实验证明多尺度短时傅里叶变换能更有效的测量真实音频和假音频之间的差异。同时采用multi

‑

band melgan中多频带处理方法,以梅尔频谱作为输入,产生子频带信号,将子频带信号相加作为全频带信号输入到鉴别器中。

70.普通短时傅里叶变换的窗宽是固定的,所以无法满足非稳态信号变化的频带需

求。多尺度短时傅里叶变换,使用不同的分析参数,如fft_size、window_size、帧移等,计算多个参数下stft的损失。

71.单个stft损失定义:其中,x表示目标波形,表示生成器预测的音频,表示谱收敛损失,表示对数短时傅里叶变换幅度损失。

72.谱收敛损失定义:对数短时傅里叶变换幅度损失定义:其中,‖.‖

f

表示范数,‖.‖1表示l1范数。

73.假设有m个多尺度短时傅里叶变换,则多尺度短时傅里叶变换的辅助损失定义为:

74.hifigan有两种类型的鉴别器,mpd(多周期判别器,multi

‑

period discriminator)和msd(多尺度判别器,multi

‑

sclae discriminator),gna损失定义为:l

adv

(d,g)=e

(x,s)

[(d(x)

‑

1)2+(d(g(s)))2];l

adv

(d,g)=e

(x,s)

[(d(g(s))

‑

1)2];x表示真实音频,s表示真实音频的梅尔频谱。

[0075]

增加梅尔频谱损失以提高生成器的训练效率和生成音频的保真度。通过计算真实音频的mel频谱和生成器生成波形的梅尔频谱之间的距离l1,获得梅尔频谱损失,定义为:音频的mel频谱和生成器生成波形的梅尔频谱之间的距离l1,获得梅尔频谱损失,定义为:表示将波形转换成梅尔频谱的函数。

[0076]

由于鉴别器mpd和msd是由一系列的子鉴别器组成,最终多尺度hifi

‑

gan生成器损失函数定义为:失函数定义为:鉴别器损失定义为:d

k

表示mpd和msd中的第k个子鉴别器。

[0077]

基于傅里叶变换的时域信号,无法获取信号的时域信息,普通短时傅里叶变换的窗宽是固定的,所以无法满足非稳态信号变化的频带需求,语音信号是非稳态、时变的信号,为了适用语音信号的特征,提出了多尺度短时傅里叶变换辅助损失,通过结合不同分析参数下的多个短时傅立叶变换损失,可以帮助hifi

‑

gan的生成器学习语音的时频域特性。此外,其也防止生成器对固定窗宽的短时傅立叶变换的表示过拟合,能够有效地提高整个生成波形的最终表现。在不降低语音合成音频音质的前提下,更加高效快速的生成音频波形。

[0078]

整理文本样本数据以及对应的音频样本数据,首先对音频数据进行去重、降噪,然后将音频剪辑成每条大约8秒左右的音频。将文本样本数据进行并整理和拆分,校对音频对应的文本,去除文本中特殊符号,并将阿拉伯数字转为对应的文本单词。对于中文文本数据,要转换成带音调的拼音格式,将对齐后音频和文本数据输入到语音合成的声谱预测网络中进行训练,生成音频对应的声学特征,即梅尔频谱。

[0079]

将剪辑后纯净的音频样本数据,输入到改进的多尺度hifi

‑

gan声码器模型进行训练。获取改进的声码器模型参数,以用于语音合成过程中利用梅尔频谱推理生成音频,增加

梅尔频谱损失以提高生成器的训练效率和生成音频的保真度。

[0080]

用多尺度短时傅里叶变换损失替换hifi

‑

gan中特征匹配损失,普通短时傅里叶变换的窗宽是固定的,而语音信号是非稳态、时变的信号,所以固定窗宽的短时傅里叶变换无法满足非稳态信号变化的频带需求。多尺度stft,使用不同的分析参数,如fft_size、window_size、帧移等,计算多个参数下stft的损失,能更有效的测量真实音频和生成音频之间的差异。同时采用multi

‑

band melgan中多频带处理方法,以梅尔频谱作为输入,产生子频带信号,将子频带信号相加作为全频带信号输入到鉴别器中。

[0081]

上述的声码器语音合成方法,通过获取待合成文本文件,借助声谱预测网络提取声学特征,并将提取的内容输入至改进的多尺度hifi

‑

gan声码器模型内进行语音合成,多尺度短时傅里叶变换能够能更有效的测量真实音频和生成音频之间的差异,实现快速且有效地提高整个生成波形的最终表现,提升语音合成音频的音质。

[0082]

图4是本发明实施例提供的一种声码器语音合成装置300的示意性框图。如图4所示,对应于以上声码器语音合成方法,本发明还提供一种声码器语音合成装置300。该声码器语音合成装置300包括用于执行上述声码器语音合成方法的单元,该装置可以被配置于服务器中。具体地,请参阅图4,该声码器语音合成装置300包括文件获取单元301、声学特征提取单元302以及语音合成单元303。

[0083]

文件获取单元301,用于获取待合成文本文件;声学特征提取单元302,用于将所述待合成文本文件输入至声谱预测网络内进行提取声学特征,以得到梅尔频谱;语音合成单元303,用于将所述梅尔频谱输入至改进的多尺度hifi

‑

gan声码器模型内进行语音合成,以得到语音音频。

[0084]

在一实施例中,所述语音合成装置还包括:预测网络生成单元,用于通过对文本样本数据以及对应的音频样本数据进行预处理后训练深度学习网络得到,以得到声谱预测网络。

[0085]

在一实施例中,所述语音合成装置还包括声码器生成单元,用于通过带有梅尔频谱的音频样本数据训练所述hifi

‑

gan声码器所得,以得到改进的多尺度hifi

‑

gan声码器模型,且所述hifi

‑

gan声码器内的特征匹配损失替换为多尺度短时傅里叶变换。

[0086]

在一实施例中,所述语音合成单元303,用于改进的多尺度hifi

‑

gan声码器模型采用多频带处理方法,以梅尔频谱作为输入,产生子频带信号,将子频带信号相加作为全频带信号输入到鉴别器中,以进行语音合成。

[0087]

在一实施例中,所述预测网络生成单元包括数据获取子单元、文本处理子单元、降噪子单元、对齐子单元、构建子单元以及训练子单元。

[0088]

数据获取子单元,用于获取文本样本数据以及对应的音频样本数据;文本处理子单元,用于对所述文本样本数据进行剪辑,去除特殊符号,并将阿拉伯数字转为对应的文本单词,将所述文本样本数据内的中文文本数据转成拼音格式或者音素格式,以得到标准格式文本;降噪子单元,用于对所述音频样本数据进行去噪和降噪处理,以得到处理后的音频数据;对齐子单元,用于将标准格式文本以及处理后的音频数据对齐,以得到待训练数据;构建子单元,用于构建深度学习网络;训练子单元,用于利用待训练数据对所述深度学习网络进行训练,以确定声谱预测网络。

[0089]

需要说明的是,所属领域的技术人员可以清楚地了解到,上述声码器语音合成装

置300和各单元的具体实现过程,可以参考前述方法实施例中的相应描述,为了描述的方便和简洁,在此不再赘述。

[0090]

上述声码器语音合成装置300可以实现为一种计算机程序的形式,该计算机程序可以在如图5所示的计算机设备上运行。

[0091]

请参阅图5,图5是本技术实施例提供的一种计算机设备的示意性框图。该计算机设备500可以是服务器,其中,服务器可以是独立的服务器,也可以是多个服务器组成的服务器集群。

[0092]

参阅图5,该计算机设备500包括通过系统总线501连接的处理器502、存储器和网络接口505,其中,存储器可以包括非易失性存储介质503和内存储器504。

[0093]

该非易失性存储介质503可存储操作系统5031和计算机程序5032。该计算机程序5032包括程序指令,该程序指令被执行时,可使得处理器502执行一种声码器语音合成方法。

[0094]

该处理器502用于提供计算和控制能力,以支撑整个计算机设备500的运行。

[0095]

该内存储器504为非易失性存储介质503中的计算机程序5032的运行提供环境,该计算机程序5032被处理器502执行时,可使得处理器502执行一种声码器语音合成方法。

[0096]

该网络接口505用于与其它设备进行网络通信。本领域技术人员可以理解,图5中示出的结构,仅仅是与本技术方案相关的部分结构的框图,并不构成对本技术方案所应用于其上的计算机设备500的限定,具体的计算机设备500可以包括比图中所示更多或更少的部件,或者组合某些部件,或者具有不同的部件布置。

[0097]

其中,所述处理器502用于运行存储在存储器中的计算机程序5032,以实现如下步骤:

[0098]

获取待合成文本文件;将所述待合成文本文件输入至声谱预测网络内进行提取声学特征,以得到梅尔频谱;将所述梅尔频谱输入至改进的多尺度hifi

‑

gan声码器模型内进行语音合成,以得到语音音频。

[0099]

其中,所述声谱预测网络是通过对文本样本数据以及对应的音频样本数据进行预处理后训练深度学习网络得到的。

[0100]

改进的多尺度hifi

‑

gan声码器模型是通过训练音频数据获取网络模型的参数,形成的语音合成声码器模型;且改进的多尺度hifi

‑

gan声码器模型内的特征匹配损失替换为多尺度短时傅里叶变换。

[0101]

改进的多尺度hifi

‑

gan声码器模型包括生成器以及鉴别器,并通过多尺度短时傅里叶变换损失、梅尔频谱损失、gan网络损失进行网络的优化。

[0102]

在一实施例中,处理器502在实现所述将所述梅尔频谱输入至改进的多尺度hifi

‑

gan声码器模型内进行语音合成,以得到语音音频步骤时,具体实现如下步骤:

[0103]

改进的多尺度hifi

‑

gan声码器模型采用多频带处理方法,以梅尔频谱作为输入,产生子频带信号,将子频带信号相加作为全频带信号输入到鉴别器中,以进行语音合成。

[0104]

在一实施例中,处理器502在实现所述声谱预测网络是通过对文本样本数据以及对应的音频样本数据进行预处理后训练深度学习网络得到的步骤时,具体实现如下步骤:

[0105]

获取文本样本数据以及对应的音频样本数据;对所述文本样本数据进行剪辑,去除特殊符号,并将阿拉伯数字转为对应的文本单词,将所述文本样本数据内的中文文本数

据转成拼音格式或者音素格式,以得到标准格式文本;对所述音频样本数据进行去噪和降噪处理,以得到处理后的音频数据;将标准格式文本以及处理后的音频数据对齐,以得到待训练数据;构建深度学习网络;利用待训练数据对所述深度学习网络进行训练,以确定声谱预测网络。

[0106]

应当理解,在本技术实施例中,处理器502可以是中央处理单元(central processing unit,cpu),该处理器502还可以是其他通用处理器、数字信号处理器(digital signal processor,dsp)、专用集成电路(application specific integrated circuit,asic)、现成可编程门阵列(field

‑

programmable gate array,fpga)或者其他可编程逻辑器件、分立门或者晶体管逻辑器件、分立硬件组件等。其中,通用处理器可以是微处理器或者该处理器也可以是任何常规的处理器等。

[0107]

本领域普通技术人员可以理解的是实现上述实施例的方法中的全部或部分流程,是可以通过计算机程序来指令相关的硬件来完成。该计算机程序包括程序指令,计算机程序可存储于一存储介质中,该存储介质为计算机可读存储介质。该程序指令被该计算机系统中的至少一个处理器执行,以实现上述方法的实施例的流程步骤。

[0108]

因此,本发明还提供一种存储介质。该存储介质可以为计算机可读存储介质。该存储介质存储有计算机程序,其中该计算机程序被处理器执行时使处理器执行如下步骤:

[0109]

获取待合成文本文件;将所述待合成文本文件输入至声谱预测网络内进行提取声学特征,以得到梅尔频谱;将所述梅尔频谱输入至改进的多尺度hifi

‑

gan声码器模型内进行语音合成,以得到语音音频。

[0110]

其中,所述声谱预测网络是通过对文本样本数据以及对应的音频样本数据进行预处理后训练深度学习网络得到的。

[0111]

改进的多尺度hifi

‑

gan声码器模型是通过训练音频数据获取网络模型的参数,形成的语音合成声码器模型;且改进的多尺度hifi

‑

gan声码器模型内的特征匹配损失替换为多尺度短时傅里叶变换。改进的多尺度hifi

‑

gan声码器模型包括生成器以及鉴别器,并通过多尺度短时傅里叶变换损失、梅尔频谱损失、gan网络损失进行网络的优化。在一实施例中,所述处理器在执行所述计算机程序而实现所述将所述梅尔频谱输入至改进的多尺度hifi

‑

gan声码器模型内进行语音合成,以得到语音音频步骤时,具体实现如下步骤:

[0112]

改进的多尺度hifi

‑

gan声码器模型采用多频带处理方法,以梅尔频谱作为输入,产生子频带信号,将子频带信号相加作为全频带信号输入到鉴别器中,以进行语音合成。

[0113]

在一实施例中,所述处理器在执行所述计算机程序而实现所述声谱预测网络是通过对文本样本数据以及对应的音频样本数据进行预处理后训练深度学习网络得到的步骤时,具体实现如下步骤:

[0114]

获取文本样本数据以及对应的音频样本数据;对所述文本样本数据进行剪辑,去除特殊符号,并将阿拉伯数字转为对应的文本单词,将所述文本样本数据内的中文文本数据转成拼音格式或者音素格式,以得到标准格式文本;对所述音频样本数据进行去噪和降噪处理,以得到处理后的音频数据;将标准格式文本以及处理后的音频数据对齐,以得到待训练数据;构建深度学习网络;利用待训练数据对所述深度学习网络进行训练,以确定声谱预测网络。

[0115]

所述存储介质可以是u盘、移动硬盘、只读存储器(read

‑

only memory,rom)、磁碟

或者光盘等各种可以存储程序代码的计算机可读存储介质。

[0116]

本领域普通技术人员可以意识到,结合本文中所公开的实施例描述的各示例的单元及算法步骤,能够以电子硬件、计算机软件或者二者的结合来实现,为了清楚地说明硬件和软件的可互换性,在上述说明中已经按照功能一般性地描述了各示例的组成及步骤。这些功能究竟以硬件还是软件方式来执行,取决于技术方案的特定应用和设计约束条件。专业技术人员可以对每个特定的应用来使用不同方法来实现所描述的功能,但是这种实现不应认为超出本发明的范围。

[0117]

在本发明所提供的几个实施例中,应该理解到,所揭露的装置和方法,可以通过其它的方式实现。例如,以上所描述的装置实施例仅仅是示意性的。例如,各个单元的划分,仅仅为一种逻辑功能划分,实际实现时可以有另外的划分方式。例如多个单元或组件可以结合或者可以集成到另一个系统,或一些特征可以忽略,或不执行。

[0118]

本发明实施例方法中的步骤可以根据实际需要进行顺序调整、合并和删减。本发明实施例装置中的单元可以根据实际需要进行合并、划分和删减。另外,在本发明各个实施例中的各功能单元可以集成在一个处理单元中,也可以是各个单元单独物理存在,也可以是两个或两个以上单元集成在一个单元中。

[0119]

该集成的单元如果以软件功能单元的形式实现并作为独立的产品销售或使用时,可以存储在一个存储介质中。基于这样的理解,本发明的技术方案本质上或者说对现有技术做出贡献的部分,或者该技术方案的全部或部分可以以软件产品的形式体现出来,该计算机软件产品存储在一个存储介质中,包括若干指令用以使得一台计算机设备(可以是个人计算机,终端,或者网络设备等)执行本发明各个实施例所述方法的全部或部分步骤。

[0120]

以上所述,仅为本发明的具体实施方式,但本发明的保护范围并不局限于此,任何熟悉本技术领域的技术人员在本发明揭露的技术范围内,可轻易想到各种等效的修改或替换,这些修改或替换都应涵盖在本发明的保护范围之内。因此,本发明的保护范围应以权利要求的保护范围为准。